HerrRossi

Urgestein

- Mitglied seit

- Jul 25, 2018

- Beiträge

- 6.780

- Bewertungspunkte

- 2.243

- Punkte

- 113

Einen schönen Sonntag wünsche ich euch!

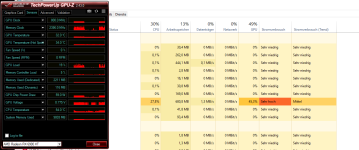

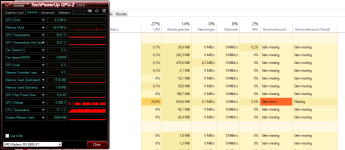

Hat hier jemand Erfahrung mit den diversen Topaz AI Apps? Ich wollte damit alte Fotos und Videos verbessern und frage mich jetzt, welche Grafikkarte dafür wohl am besten geeignet ist.

Da ich bereits eine 2080ti besitze und damit auch schon etwas rumgespielt habe, stellt sich mir jetzt die Frage, ob ich mit einer 3080(oder ti, die 3090 ist mir immer noch zu teuer) bzw. einer 6900/6800XT signifikant schneller wäre.

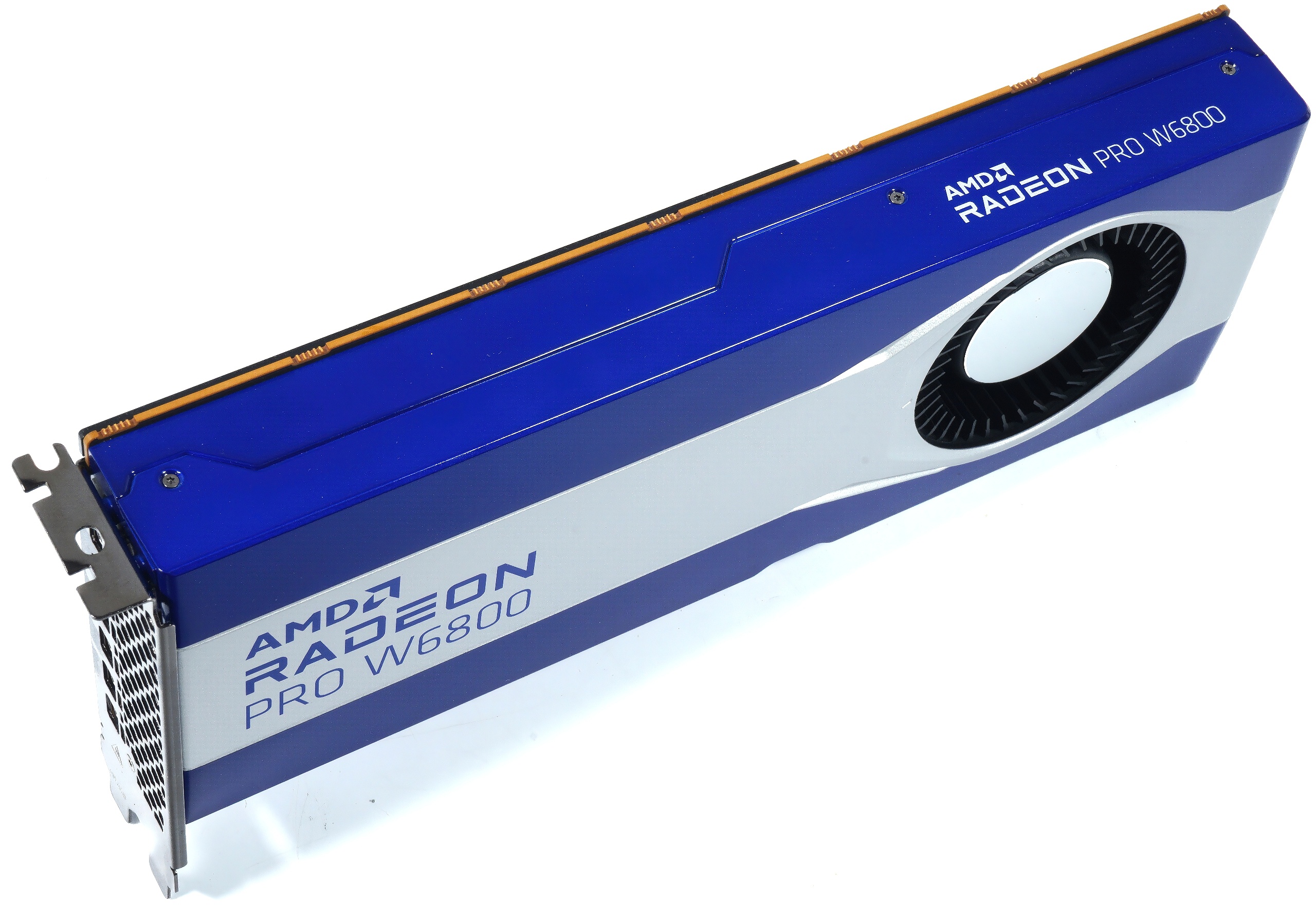

@Igor Wallossek hat die Software mit Profi GPUs getestet:

www.igorslab.de

www.igorslab.de

www.igorslab.de

www.igorslab.de

Das ist für mich aber nur schwer vergleichbar und kommt kostenmässig auch nicht in Frage. Kennt jemand Benchmarks mit Consumer GPUs? Im Topazforum findet sich kein wirklicher Vergleich, aber Tenor scheint zu sein, dass die 6900XT wegen DirectML die schnellste Karte ist. Die würde ich dann tatsächlich in Erwägung ziehen, wenngleich ich auch bis zur nächsten Generation warten könnte, wobei mir da der möglicherweise exorbitante Stromverbrauch Sorgen macht und ob sich das dann in Zeitersparnis rechnet.

Über Input würde ich mich freuen. Vielen Dank schonmal!

Hat hier jemand Erfahrung mit den diversen Topaz AI Apps? Ich wollte damit alte Fotos und Videos verbessern und frage mich jetzt, welche Grafikkarte dafür wohl am besten geeignet ist.

Da ich bereits eine 2080ti besitze und damit auch schon etwas rumgespielt habe, stellt sich mir jetzt die Frage, ob ich mit einer 3080(oder ti, die 3090 ist mir immer noch zu teuer) bzw. einer 6900/6800XT signifikant schneller wäre.

@Igor Wallossek hat die Software mit Profi GPUs getestet:

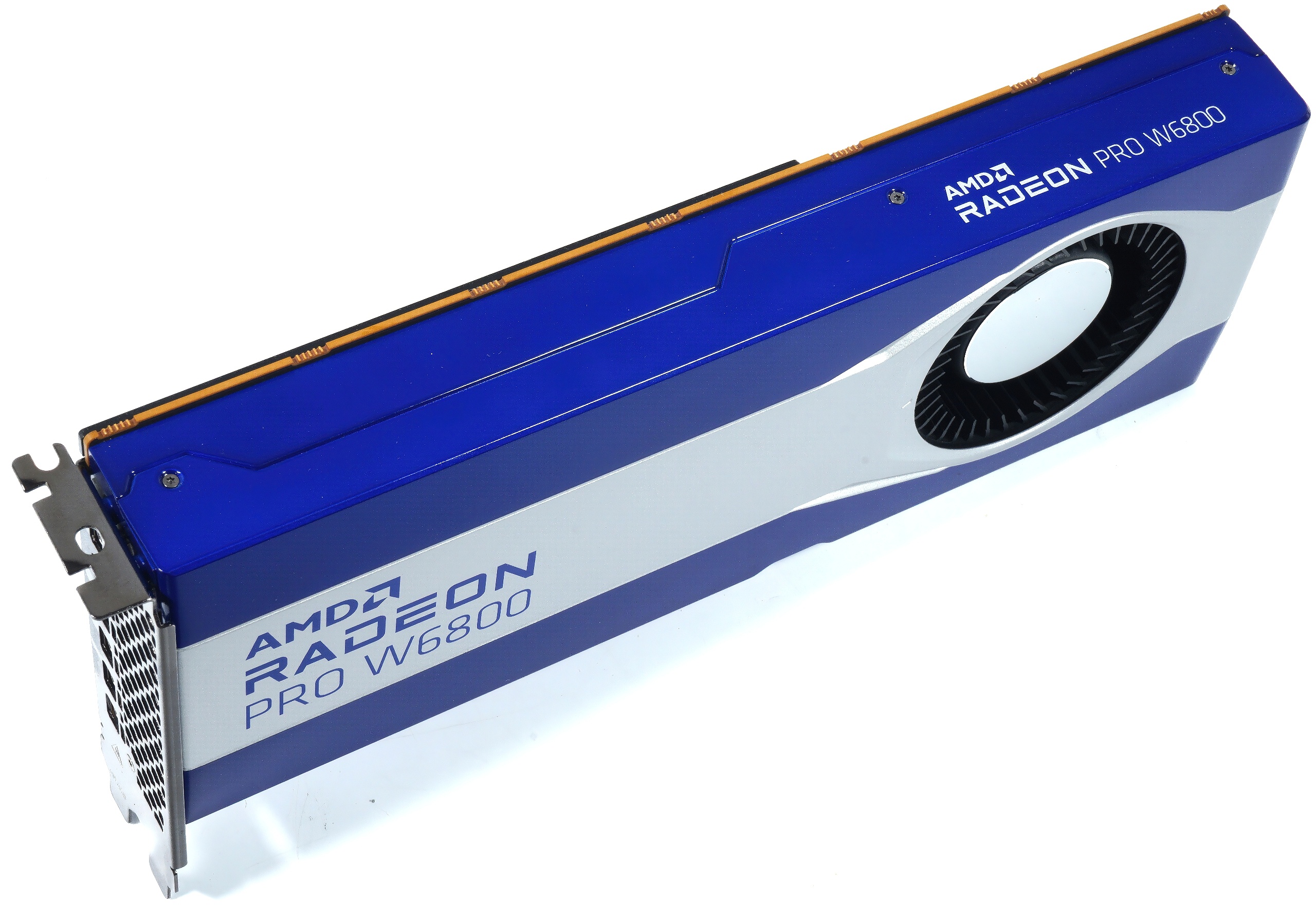

AMD Radeon Pro W6800 32 GB im Test - Schlägt die neue Workstation-Karte eine NVIDIA Quadro RTX 5000? | Seite 10 | igor´sLAB

Bis auf eine unlängst erfolgte Ankündigung und einen ersten Launch war es ja längere Zeit sehr ruhig um AMDs Radeon Pro Portfolio an professionellen Workstation, die zudem auch auf zertifizierte…

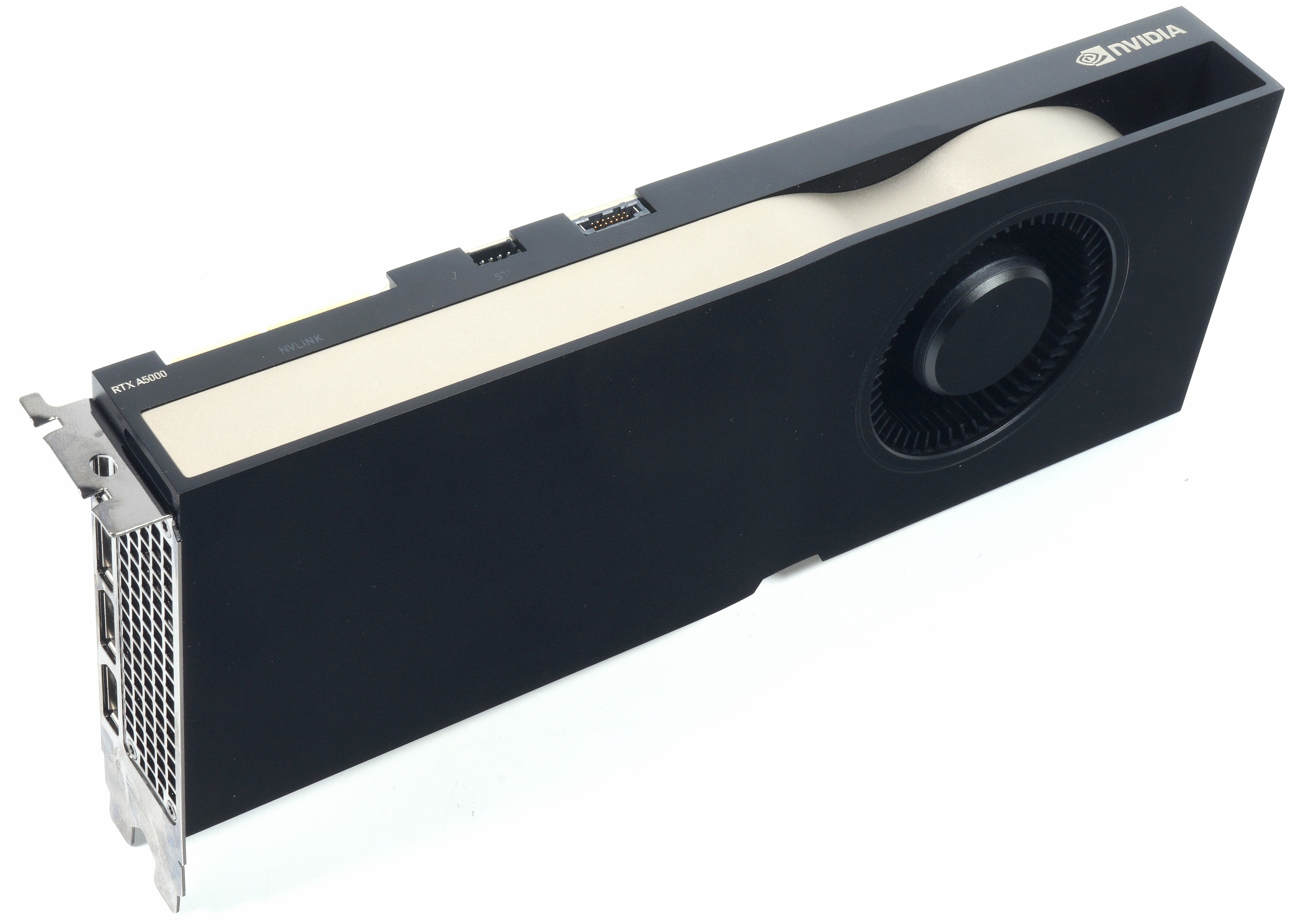

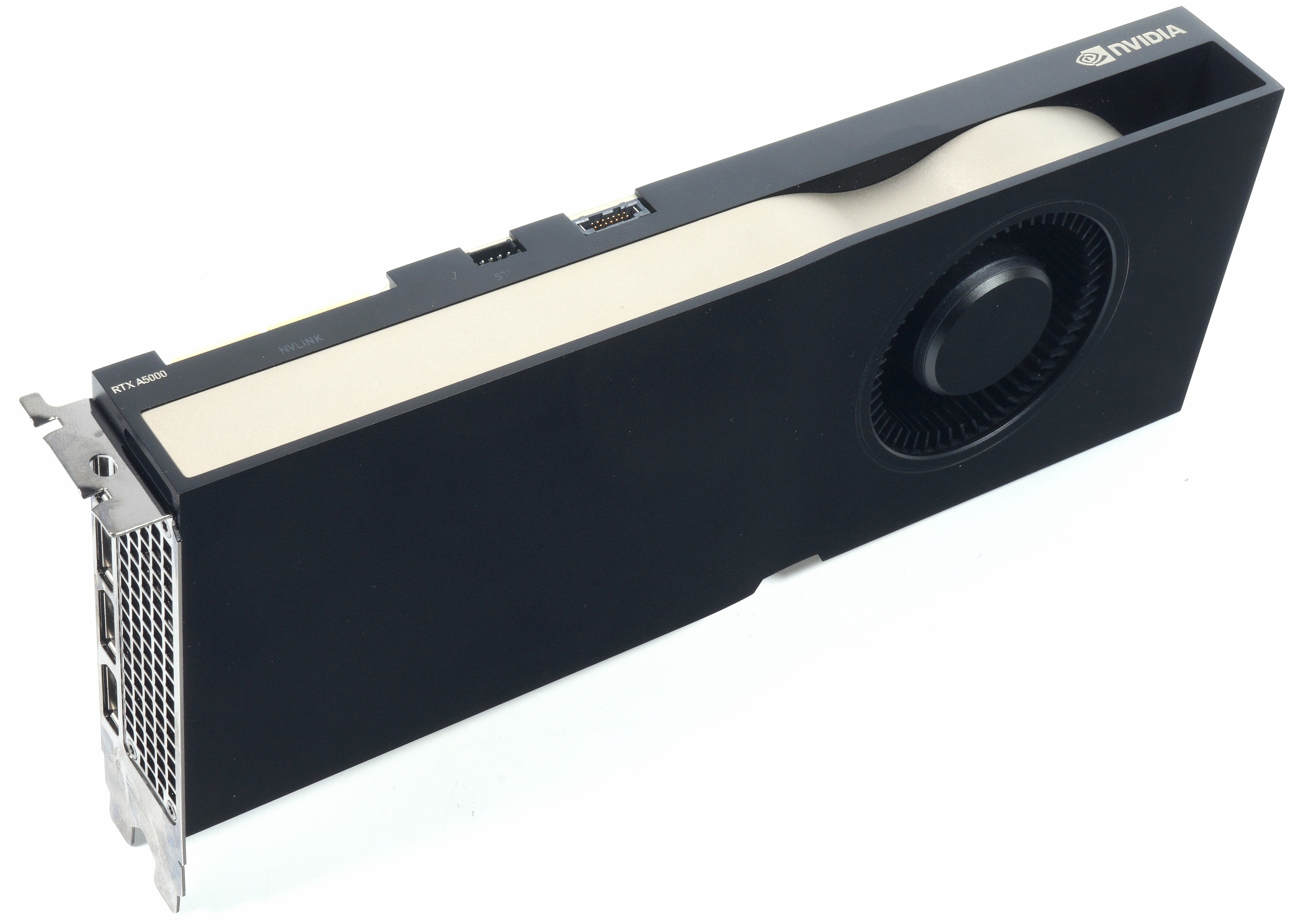

NVIDIA RTX A5000 im Test - Wie gut ist die Nachfolgerin der Quadro RTX 5000? | Seite 11 | igor´sLAB

Mit der NVIDIA RTX A5000 habe ich heute eine Workstation-Grafikkarte im Test, die nicht nur die Vorgängerin RTX 5000 locker ersetzen soll, sondern die in manchen Bereichen sogar die RTX 6000 noch…

Das ist für mich aber nur schwer vergleichbar und kommt kostenmässig auch nicht in Frage. Kennt jemand Benchmarks mit Consumer GPUs? Im Topazforum findet sich kein wirklicher Vergleich, aber Tenor scheint zu sein, dass die 6900XT wegen DirectML die schnellste Karte ist. Die würde ich dann tatsächlich in Erwägung ziehen, wenngleich ich auch bis zur nächsten Generation warten könnte, wobei mir da der möglicherweise exorbitante Stromverbrauch Sorgen macht und ob sich das dann in Zeitersparnis rechnet.

Über Input würde ich mich freuen. Vielen Dank schonmal!