- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.295

- Bewertungspunkte

- 19.080

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

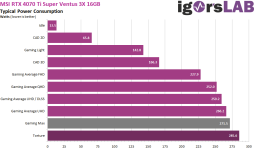

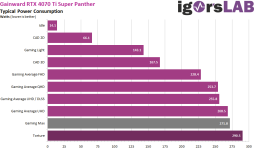

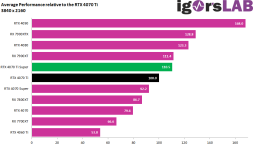

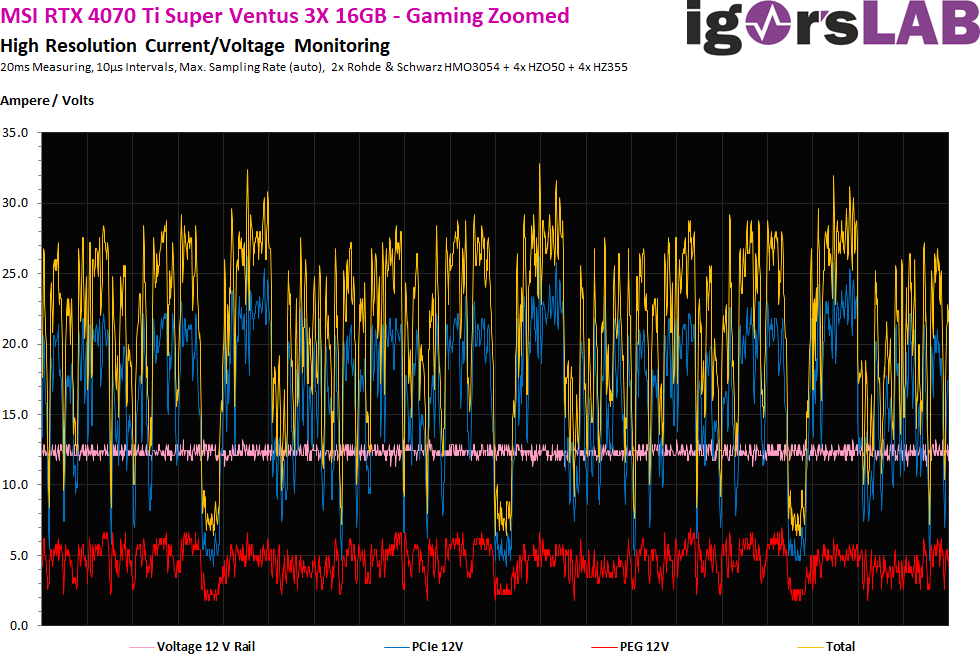

Steht doch alles gleich zweiten Absatz... Nur kann ich nichts nachtesten, wo es (für mich) nichts zu testen gibt.Das hast Du jetzt wo genau gelesen? Geschrieben, geschweige denn gemeint, habe ich das jedenfalls nicht.

Aber nicht wenige Posts hier verlinken auf irgendwelche Videos oder Seiten, die suggerieren, dass ich den Test so wohl besser nicht veröffentlicht hätte. Das wiederum ist Käse. Denn da lese ich nicht, dass es nicht alle betrifft.

Du musst Dich auch nicht gleich bei Raff ausheulen

Da ich "nachgetestet" habe und keinen Unterschied finde, muss ich das ja vielleicht auch nicht machen. Ich habe mittlerweile 3 BIOS-Versionen auf Plausibilität getestet. Das sollte eigentlich reichen.Jedenfalls hält er einen Nachtest bei sich nicht für notwendig. Und auch sonst reagiert er "bekannt" auf meine Nachfragen ("Mir jetzt Schlampigkeit zu unterstellen, ist schon arg strange.", Zitat Igor).