RX480

Urgestein

- Mitglied seit

- Feb 13, 2020

- Beiträge

- 1.877

- Bewertungspunkte

- 870

- Punkte

- 114

Mit schwacher CPU würde ich bei ner NV-Graka immer mal rBar testen.

(Das kann dann schon helfen, gegen den DX12-Overhead oder zumindestens etwas entlasten)

weiss jetzt gar net, wie es mal mit der UE5-engine so wird:

Wenn manche Studios mit Schärfe voll aufgedreht als default ausliefern , finde ich Das auch sehr störend.

TPU z.Bsp. stellt bei Bildvgl. dann immer was Sinnvolles ein.

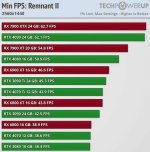

www.techpowerup.com

www.techpowerup.com

(Das kann dann schon helfen, gegen den DX12-Overhead oder zumindestens etwas entlasten)

weiss jetzt gar net, wie es mal mit der UE5-engine so wird:

Wenn manche Studios mit Schärfe voll aufgedreht als default ausliefern , finde ich Das auch sehr störend.

TPU z.Bsp. stellt bei Bildvgl. dann immer was Sinnvolles ein.

By default each upscaling and anti-aliasing solution is using the highest sharpening value of 10, which can look very oversharpened even at high resolutions, such as 4K, and during this round of testing, we used a balanced value of 5 for the TAA, DLSS, DLAA, XeSS and FSR sharpening filters. The inclusion of a separate sharpening filter for each upscaling and temporal anti-aliasing solution is a great option to have, especially when the sharpening itself is well implemented without causing any negative side effects or artifacts during gameplay.

Ratchet & Clank Rift Apart: DLSS vs FSR vs XeSS Comparison Review

Ratchet & Clank Rift Apart is out now on PC, with support for NVIDIA DLSS Super Resolution, Frame Generation and DLAA. Also supported is Intel's Xe Super Sampling and AMD's FidelityFX Super Resolution. In this mini-review we compare the image quality and performance gains offered by these...

Zuletzt bearbeitet

: