Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Internetseiten nicht korrekt angezeigt werden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Intel Arc A380 im Nachtest: Neue Treiber und die Draw-Calls – Wo liegt eigentlich der API-Overhead?

- Themenstarter Redaktion

- Beginndatum

Rückzug auf Raten

Ich hatte ja schon vor ÜBER einem Jahr geschrieben, dass Intel das komplette Treiber Team entlassen hat (was bin ich dafür angefeindet worden) und weiter nur auf den iGP-Stack mit anderem GUI setzt. Die Info hatte ich vom damaligen PR-Lautsprecher Chris abends mal beim Chatten bekommen, nachdem der sich rechtzeitig abgesetzt hatte.

Notiz - Xe HPG: Intels Gaming-Grafikkarte läuft im Labor

Die dedizierte DG1 Karte offiziell noch gar nicht. Wenn ein Tester nichtmal die Treiberversion verraten kann, legt er darauf keinen wert und dann ist das ganze ziemlich wertlos. Seh-Hilfe: Mit etwas Pech wird es gar keine neuen dedizierten Karten mehr geben, die über das Notebook-Zeug...www.computerbase.de

Du hattest die falschen Schlüsse daraus gezogen. Wie wir jetzt mittlerweile wissen war Intel zu naiv und hat geglaubt, ihr iGPU software stack wäre gut genug für die dGPUs. Das hat sich als großer Fehler rausgestellt. Deine Rückschlüsse daraus waren andere, du hattest nämlich das Alchemist bzw. gamer Projekt komplett infrage gestellt, dachtest Intel würde das dGPU Projekt abbrechen und wir würden Alchemist in dGPU Form gar nicht sehen, weil bestimmte Marketing Leute gegangen sind und das Treiber Team entlassen wurde. So entstehen falsche Gerüchte. Das kann jetzt bei den neuen Gerüchten auch wieder das Problem sein. Bestimmte Leute bekommen was zugesteckt und deuten es nur falsch.

Klar ist auf jeden Fall das Intel viele Fehler gemacht hat. Die Treiber sind derzeit nicht konkurrenzfähig, die Werbekampagne ist viel zu früh gestartet und bei der Architektur ist zumindest einmal der Speichercontroller fragwürdig, die Abhängigkeit von rBAR ist viel zu groß.

Das wird bei den großen Karten mit größerem Speicherinterface noch interessant, wie sich das verhält mit rBAR. Immerhin kommen die Karten, wenn auch spät.

- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.199

- Bewertungspunkte

- 18.817

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

Ich habe Pat damals schlicht überschätzt, weil er eigentlich bekannt dafür war, dass er unrentable Sparten grillt. Konsequenterweise hätte man das Projekt auf dem damaligen Stand eigentlich beenden müssen.

So, wie es aussieht, hat man die dGPU einfach weiterlaufen lassen und gehofft, dass man sich so durchwursteln könne, weil man eben Intel ist und der Markt wie ein Schwamm alles aufsaugt, das mit Pixeln um sich wirft. Und dann kommen drei freche deutsche Redaktionen und legen mal den Finger drauf und testen nicht das, was Intel gern hätte, sondern echte Spiele. Ich schrieb auch schon vor Monaten, dass Intel die AIBs dazu angehalten habe, die Teile nur in SI- und OEM-PCs zu verstecken und ja kein Retail zu versuchen.

Ich habe mich letztendlich darauf verlassen, dass ein Unternehmen vom Format Intels einfach erkennt, wann es besser ist, keine Ressourcen mehr zu verschwenden. Die Baustellen sind ja in der vollen Breite leider nicht weniger geworden. Das man jetzt hektisch mit dem Geldköfferchen willige YouTuber abklappert, macht in meinen Augen auch noch den letzten Rest der Reputation zunichte, weil man immer noch nichts daraus gelernt hat.

Man kann sich immer irren, wenn man zu sehr an die Logik und Vernunft glaubt. Hier lief das nun mal nicht so und die Quartalszahlen sind am Ende schon Strafe genug für alle unterlassenen Korrekturen. Wenn Intel jetzt noch wegen fehlender Gewinnwarnungen Klagen von Investoren an den Hals bekommt, wirds lustig...

Ja, da habe (nicht nur) ich mich geirrt, obwohl das mit den iGPUs durchaus richtig war. Meine Annahme basierte auf den Äußerungen ehemaliger Mitarbeiter, die 2021 noch von broken silicon schrieben, was man nicht in den Griff bekommen habe und man deshalb erst einmal weiter die iGPU forciere. So ganz Unrecht hatten sie ja nicht, denn es sind eben nicht nur die Treiber. Aber DG2 kommt, so wie es sich jetzt darstellt, auch nicht als echte Retail-Karte auf breiter Front. Bissl Amazon und Newegg vielleicht, falls überhaupt.Niemand hat behauptet, die DG2 kommt nicht. Sie kommt, Kenntnisstand jetzt, erst Ende 2021/ Anfang 2022 aber nur als dedizierter Chip für Notebooks. So zumindest planen es die großen OEM.

So, wie es aussieht, hat man die dGPU einfach weiterlaufen lassen und gehofft, dass man sich so durchwursteln könne, weil man eben Intel ist und der Markt wie ein Schwamm alles aufsaugt, das mit Pixeln um sich wirft. Und dann kommen drei freche deutsche Redaktionen und legen mal den Finger drauf und testen nicht das, was Intel gern hätte, sondern echte Spiele. Ich schrieb auch schon vor Monaten, dass Intel die AIBs dazu angehalten habe, die Teile nur in SI- und OEM-PCs zu verstecken und ja kein Retail zu versuchen.

Ich habe mich letztendlich darauf verlassen, dass ein Unternehmen vom Format Intels einfach erkennt, wann es besser ist, keine Ressourcen mehr zu verschwenden. Die Baustellen sind ja in der vollen Breite leider nicht weniger geworden. Das man jetzt hektisch mit dem Geldköfferchen willige YouTuber abklappert, macht in meinen Augen auch noch den letzten Rest der Reputation zunichte, weil man immer noch nichts daraus gelernt hat.

Man kann sich immer irren, wenn man zu sehr an die Logik und Vernunft glaubt. Hier lief das nun mal nicht so und die Quartalszahlen sind am Ende schon Strafe genug für alle unterlassenen Korrekturen. Wenn Intel jetzt noch wegen fehlender Gewinnwarnungen Klagen von Investoren an den Hals bekommt, wirds lustig...

ipat66

Urgestein

- Mitglied seit

- Sep 16, 2019

- Beiträge

- 1.358

- Bewertungspunkte

- 1.355

- Punkte

- 115

Wer Lust hat herzlich zu lachen,sollte diesen Artikel mal ueberfliegen :

www.techspot.com

www.techspot.com

Asus and MSI start offering desktops with Intel Arc A380 and A310 GPUs

Asus has updated its US website with the option to configure a few of its desktop systems with the Arc Alchemist A380 GPU. It markets one of...

www.techspot.com

www.techspot.com

- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.199

- Bewertungspunkte

- 18.817

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

Genau das hatte ich doch schon vor Monaten so geschrieben. SI und OEM, das wars.

Ich hoffe nur, dass nicht einer der Intel-Insider im Juli noch Aktien verschleudert hat. Das könnte sich jetzt fies rächen

Wenn sie Raja einen Teil in Aktienpaketen gezahlt haben, was ja nicht unüblich ist, nenne ich es mal Instant Karma.

Ich hoffe nur, dass nicht einer der Intel-Insider im Juli noch Aktien verschleudert hat. Das könnte sich jetzt fies rächen

Wenn sie Raja einen Teil in Aktienpaketen gezahlt haben, was ja nicht unüblich ist, nenne ich es mal Instant Karma.

Chismon

Veteran

- Mitglied seit

- Dez 27, 2020

- Beiträge

- 131

- Bewertungspunkte

- 93

- Punkte

- 28

Ein Testvideo eines nicht "von Intel per Geldköfferchen bezahlten YouTubers", über welches ich gerade eben gestolpert bin und siehe an, m.M.n. doch sehr professionell gehalten und mit der bisher fairsten Bewertung der neuen A380 Gunnir:

Dabei hat Intel mit Recht das Fett weg bekommen und die A380 wurde natürlich nicht empfohlen, aber man sieht auch gut, was für eine ebenso peinliche Nummer AMD/RTG sich mit der schrottigen RX 6400 (insbesondere unter PCIe3.0, ähnlich wie A380 ohne ReBar) sich geleistet hat, aber ist das ähnlich durch die Medien gegangen und aufgebläht worden, natürlich nicht .

.

Das lag mit Sicherheit auch am Marketing, aber gut, wenn ich in dem Bereich 120 bis 170 Euro eine neue Grafikkarte kaufen müsste (eine gebrauchte wäre aktuell natürlich die weitaus sinnvollere Wahl), dann würde ich wohl eher zu einer A380 als zu einer deutlich teureren und ähnlich schlechten RX 6400 greifen.

Ich bin nur froh, dass ich nicht solche Budgetzwängen unterliege, wobei der Ausblick auf eine RTX 4070Ti (12GB) mit 400W auch alles andere erfreulich/verheißend ist (aus meiner Sicht leider disqualifizierend, Thermi/Fermi lässt grüßen); ich hoffe nur, dass AMD/RTG das deutlich besser als nVidia unterwegs sein wird mit der RX 7700XT und RX 7800, was die Effizienz und Abwärme angeht (nur bis die einmal in die Pötte kommen und das Produkt auf dem Markt gelangt (Sommer 2023 vielleicht?)).

Dabei hat Intel mit Recht das Fett weg bekommen und die A380 wurde natürlich nicht empfohlen, aber man sieht auch gut, was für eine ebenso peinliche Nummer AMD/RTG sich mit der schrottigen RX 6400 (insbesondere unter PCIe3.0, ähnlich wie A380 ohne ReBar) sich geleistet hat, aber ist das ähnlich durch die Medien gegangen und aufgebläht worden, natürlich nicht

Das lag mit Sicherheit auch am Marketing, aber gut, wenn ich in dem Bereich 120 bis 170 Euro eine neue Grafikkarte kaufen müsste (eine gebrauchte wäre aktuell natürlich die weitaus sinnvollere Wahl), dann würde ich wohl eher zu einer A380 als zu einer deutlich teureren und ähnlich schlechten RX 6400 greifen.

Ich bin nur froh, dass ich nicht solche Budgetzwängen unterliege, wobei der Ausblick auf eine RTX 4070Ti (12GB) mit 400W auch alles andere erfreulich/verheißend ist (aus meiner Sicht leider disqualifizierend, Thermi/Fermi lässt grüßen); ich hoffe nur, dass AMD/RTG das deutlich besser als nVidia unterwegs sein wird mit der RX 7700XT und RX 7800, was die Effizienz und Abwärme angeht (nur bis die einmal in die Pötte kommen und das Produkt auf dem Markt gelangt (Sommer 2023 vielleicht?)).

Zuletzt bearbeitet

:

LeovonBastler

Mitglied

- Mitglied seit

- Jan 13, 2021

- Beiträge

- 42

- Bewertungspunkte

- 13

- Punkte

- 7

Die Kommunikation zwischen Prozessor und Grafikkarte ist nicht zu unterschätzen.Naja, bei der 6400 sind diverse Ausreißer nach unten die eher mit VRAM-Mangel als nur PCIe3 zu erklären sind aber darauf ging er nicht ein.

Und ich würde dir auch teilweise Recht geben, da die 4GB an Arbeitsspeicher schon knapp sind für heutige Titel.

Allerdings haben die Polariskarten mit 4 Gigabyte diese Probleme nicht.

Das Problem liegt aber auch nicht wirklich hauptsächlich an der PCIe-Version alleine.

Die meisten Grafikkarten kommunizieren über eine PCIe x16 Schnittstelle mit der CPU. Die Bandbreite ist selbst in den höchsten Preisklassen mehr als ausreichend, da Leistungseinbussen mit PCIe 3.0 meist minimal sind (wir reden hier von vielleicht 1%).

Die RX 6600 XT wurde bereits leicht kritisiert dafür dass die Schnittstelle keine 16, sondern nur noch 8 Lanes der Schnittstelle nutzt. Die Leistungseinbussen waren dabei zwar nicht viel höher (jetzt sind's eher 2%), allerdings hat es eine hohe Aufmerksamkeit da es unüblich war für eine Grafikkarte, welche 330€ als UVP hat.

Die 6500 XT hatte dann starke Kritik eingefahren, aufgrund des Arbeitsspeichers und aufgrund der Nutzung von nur 4 PCIe Lanes.

Die Leistung "ging" noch in PCIe 4.0, wurde aber gerade in den Minimun FPS desaströs, wo sich die FPS dort teilweise halbierten oder sogar mehr als das, wenn man PCIe 3.0 nutzte (12% im durchschnitt, TechPowerUp erhob aber keine Mimimum FPS).

Der Arbeitsspeicher hilft zwar der Situation überhaupt nicht, allerdings ist es ein Problem welches so oder so aufgetreten wäre.

Der geringe Speicher verschlimmert die Situation halt noch zusätzlich.

Quellen der Statistik:

RTX 3080 PCIe Skalierung (Beispiel für die High-end Karten): https://www.techpowerup.com/review/nvidia-geforce-rtx-3080-pci-express-scaling/27.html

RX 6600 XT PCIe Skalierung: https://www.techpowerup.com/review/amd-radeon-rx-6600-xt-pci-express-scaling/26.html

RX 6500 XT PCIe Skalierung: https://www.techpowerup.com/review/amd-radeon-rx-6500-xt-pci-express-scaling/29.html

Sorry für den Roman von einem Kommentar... :/

Also im Idealfall wenn bei Intel alles so skalieren würde wie bei AMD/Nvidia und es keine Probleme mit dem Treiber Overhead gäbe könnte man folgende Rausregel anwenden:

2 Xe Cores (Arc) = 3 SMs (Ampere/Pascal) = 3 CUs (AMD)

Also:

A380 (8 Xe Cores) = RX6400 = etwas schneller als GTX 1060

A580 (16 Xe Cores) = zwischen 6500XT und 6600, eher an der 6600 = zwischen 3050 und 3060

A750 (28 Xe Cores) = 6700 XT = etwas über 3060 Ti

A770 (32 Xe Cores) = etwas über 6700 XT = 3070 Ti

In der Praxis haben wir jedoch gesehen, dass Intel hier massive Skalierungsprobleme hat.

2 Xe Cores (Arc) = 3 SMs (Ampere/Pascal) = 3 CUs (AMD)

Also:

A380 (8 Xe Cores) = RX6400 = etwas schneller als GTX 1060

A580 (16 Xe Cores) = zwischen 6500XT und 6600, eher an der 6600 = zwischen 3050 und 3060

A750 (28 Xe Cores) = 6700 XT = etwas über 3060 Ti

A770 (32 Xe Cores) = etwas über 6700 XT = 3070 Ti

In der Praxis haben wir jedoch gesehen, dass Intel hier massive Skalierungsprobleme hat.

naja..

leute, die diese karte gekauft haben, dürfte das freuen...

so oder so.

atm denke ich auch darüber nach, mir eine zuzulegen..

sofern sich die 7900xtx am ende auch als völlig überteuert (dank scalpern)

herrausstellen sollte..

vorbestellungen in China haben bereits preise von 1500€

leute, die diese karte gekauft haben, dürfte das freuen...

so oder so.

atm denke ich auch darüber nach, mir eine zuzulegen..

sofern sich die 7900xtx am ende auch als völlig überteuert (dank scalpern)

herrausstellen sollte..

vorbestellungen in China haben bereits preise von 1500€

ipat66

Urgestein

- Mitglied seit

- Sep 16, 2019

- Beiträge

- 1.358

- Bewertungspunkte

- 1.355

- Punkte

- 115

(dank scalpern)

Lasst die Scalper doch einfach verhungern!

Kommt es denn wirklich auf ein paar Monate hin oder her an (außer die bisherige Karte ist abgeraucht)?

Wenn die Massen aber weithin Geld an diese Knallerbsen schicken,braucht man sich nicht wundern...

Ich denke auch,dass die Preise nochmal leicht nachgeben werden.

Sobald die AMD Karten dann endlich das Licht erblicken,wird dann wohl schnell

eine weniger kastrierte Nvidea um die Ecke schielen....

Dazu gesellen sich verbesserte Intel GPU's....

Schnäppchen sind es trotzdem nicht.

4K oder Multi-Monitor Setup ist eben noch sehr kostenintensiv.

Intel und die Folien, leider erst glaubwürdig wenn das ein unabhängiger Tester bestätigen kann.

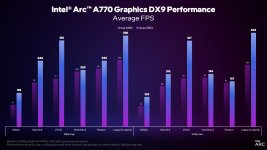

Die Folie ist kein Witz, der Treiber verbessert die DX9 Leistung massiv, insbesondere im CPU Limit. Ich messe teilweise eine 2x Verbesserung bei den average fps. Bei DX11 Titeln hat sich auch ein klein wenig was getan, so im Bereich 3-6%.

Pokerclock

Veteran

- Mitglied seit

- Aug 5, 2021

- Beiträge

- 434

- Bewertungspunkte

- 369

- Punkte

- 62

Es gibt mittlerweile echt ausgefallene Boardpartner-Karten der Arc's. Hier eines von Acer (!) mit ich habe keine Ahnung was das sein soll Lüfter-Kombi:

Ich bin gewillt mal eine zu bestellen. Ich suche dann nur jemanden, der das Ding auseinandernehmen und mir erklären möchte.

detected

www.notebooksbilliger.de

Ich bin gewillt mal eine zu bestellen. Ich suche dann nur jemanden, der das Ding auseinandernehmen und mir erklären möchte.

Pokerclock

Veteran

- Mitglied seit

- Aug 5, 2021

- Beiträge

- 434

- Bewertungspunkte

- 369

- Punkte

- 62

Ja, kann man. Man muss nur schauen wie das vom Platz her passt (geügend Abstand zur 3080 lassen) und die Lanes evtl. aufgeteilt werden.

Hier hat es einer vorgemacht:

Es lohnt auch gar nicht mehr als die A380 zu nehmen, da die Encoder-Leistung bis hin zur A770 gleich ist.

Aber wie allen Arc direkt der Hinweis. Man muss wissen was man da macht und sich auf Treiberproblemchen einstellen.

Hier hat es einer vorgemacht:

Es lohnt auch gar nicht mehr als die A380 zu nehmen, da die Encoder-Leistung bis hin zur A770 gleich ist.

Aber wie allen Arc direkt der Hinweis. Man muss wissen was man da macht und sich auf Treiberproblemchen einstellen.