- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.198

- Bewertungspunkte

- 18.815

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

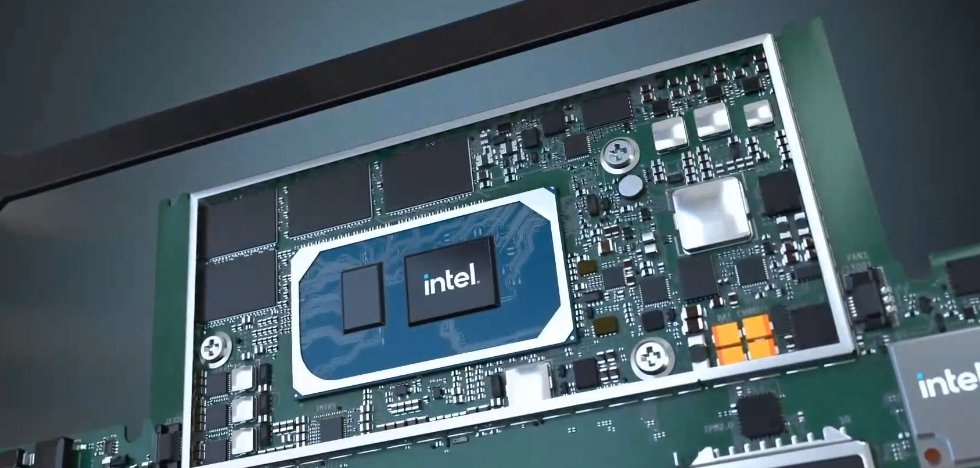

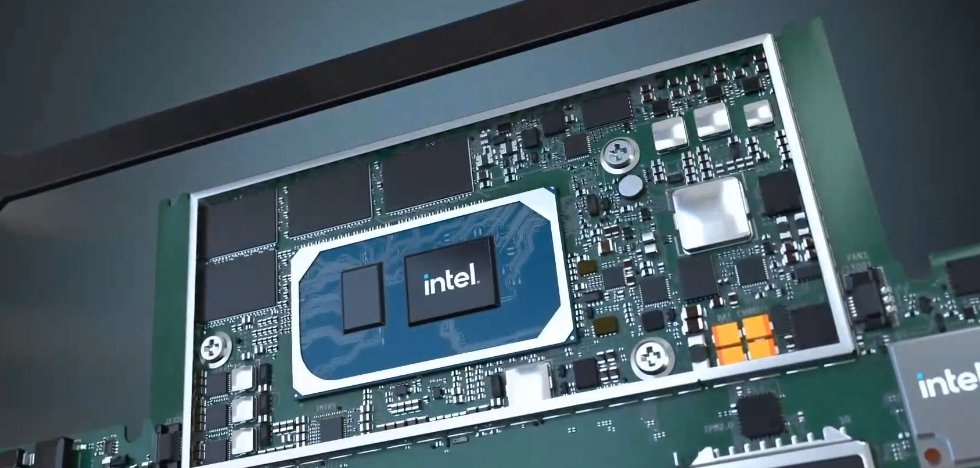

Gestern launchte Intel offiziell seine neuen Tiger Lake-Prozessoren der 11. Generation mit einer brandneuen CPU- und GPU-Architektur. Die neuen Intel Tiger Lake CPUs basieren auf dem aktuellen 10nm++ Node des Unternehmens, der eine verbesserte Leistungseffizienz gegenüber den Ice Lake Prozessoren bietet. Die Intel Tiger Lake-CPUs werden unter dem Branding der 11. Generation der Core-Familie geführt. Die Intel Tiger Lake-CPUs der 11. Generation orientieren sich vor allem auf den Mobilitätsbereich und erhalten außerdem ein völlig neues Erscheinungsbild. Und ganz nebenbei hat Intel auch gleich noch das Logo komplett runderneuert.

>>> Hier den gesamten Artikel lesen <<<

>>> Hier den gesamten Artikel lesen <<<