Alkbert

Urgestein

- Mitglied seit

- Okt 14, 2018

- Beiträge

- 931

- Bewertungspunkte

- 707

- Punkte

- 94

- Alter

- 52

- Standort

- Kempten / Allgäu

Ich möchte hier mal kurz das Thema zusätzliche NVME (kein SATA! nur PCIe) aus meiner Erfahrung skizzieren, vielleicht hat ja jemand Anderes ähnliche Herausforderungen bis zum (potentiellen) Erfolg.

Kurz gesagt geht es darum, dass ich nur 2 NVME SSD´s (hier PCIe 3.0) in meinem System mangels Steckplätzen verbauen konnte. Das war zum einen die

Systemplatte, die ich ansonsten peinlich sauber halte und zum anderen eine der Datenplatten. Ansonsten massig SATA Anschlüsse, aber das kenn man ja,

da ist bei ca. 550 MB/sec. finito.

Das hier verwendete System will ich nur kurz anreißen - ganz trivial ist das nämlich im Zusammenhang nicht.

Was man unter dem Strich benötigt ist eine PCIe (vom Funktionieren her egal ob 3.0 oder 4.0) mit pro SSD jeweils 4 PCIe Lanes.

D.h. für 1 SSD 4, für 2 SSD´s 8, für 3 SSD´s 12 und für 4 SSD´s letztlich 16 Lanes.

Ich will hier nochmals auf das System zurückkommen, denn da ist oft schon ein Knackpunkt. Die üblichen Desktop Systeme haben je nach Board und Prozessor

i.d.R. irgendwas zwischen 20 und 28 Lanes. Davon gehen dann schon mal 16 Lanes für die Graphikkarte weg. Und pro NVME Port (PCIe) dann nochmals je 4 Lanes - entweder vom Prozessor oder vom Chipsatz, wenn ich das korrekt sehe.

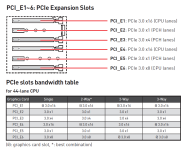

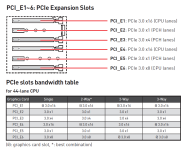

Ausgangsbasis für meine Konfiguration war daher ein System mit ausreichend PCIe Lanes - und zwar schon prozessorseitig, das sieht dann wie Folgt aus:

Mainboard: MSI x299 Tomahawk, CPU: 10980Xe (48 Lanes (Die 44 Lanes beziehen sich auf die Skylake Generation, da die Cascade Lake CPU´s zur Drucklegung des Handbuchs noch nicht existiert haben))

"Verbrauch": 16 Lanes: Graphikkarte, 4 Lanes: Asus 10 GBIT Netzwerkkarte, 4 Lanes: SATA Controller (extern), 2x PCIe NVME auf dem Mainboard (da weiß ich allerdings nicht, ob eine davon über den Chipsatz läuft)

Letztlich bleiben unter dem Strich übrig: 20-24 Lanes

Rein auf die PCIe Steckplätze bezogen (das Board ist "groß")

(c) MSI Handbuch zum Mainboard

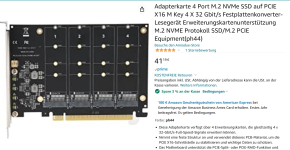

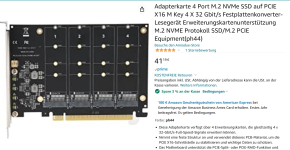

Die Karte ist ein Billigteil von Amazon um 40 Euro:

das sieht dann so aus (eine SSD fehlt noch, wird erst morgen geliefert), zur Graphikkarte

sind gut 2 cm "Luft" und die Karte ist kurz:

Im BIOS mus PCIe Split/Bifurcation oder VROC für den betreffenden Slot aktivierbar sein,

sonst wird genau eine einzige SSD erkannt, und zwar die ganz Links (Nr. 1)

Wenn man danach Windows hoch fährt, passiert genau nichts. Man sieht aber im Gerätemanager

einen nicht erkannten Raid Controller. Hier muss jetzt für das Mainboard oder zumindest

den Chipsatz das passende RST Treibermodul von Intel für die entspr. Windows Version installiert werden.

Danach Reboot und danach sieht man in der Windows Datenträgerverwaltung Folgendes:

Die Plattennamen sind natürlich jetzt willkürlich, alle Platten GPT und als Basispartition.

Wie gesagt, eine Platte fehlt noch.

Performance Tests hänge ich noch an, sobald ich dazukomme.

Physikalisch sind das dann am Ende 2x Kingston NV2 und 2x Fanxiang s500 pro (TLC !!)

Kurz gesagt geht es darum, dass ich nur 2 NVME SSD´s (hier PCIe 3.0) in meinem System mangels Steckplätzen verbauen konnte. Das war zum einen die

Systemplatte, die ich ansonsten peinlich sauber halte und zum anderen eine der Datenplatten. Ansonsten massig SATA Anschlüsse, aber das kenn man ja,

da ist bei ca. 550 MB/sec. finito.

Das hier verwendete System will ich nur kurz anreißen - ganz trivial ist das nämlich im Zusammenhang nicht.

Was man unter dem Strich benötigt ist eine PCIe (vom Funktionieren her egal ob 3.0 oder 4.0) mit pro SSD jeweils 4 PCIe Lanes.

D.h. für 1 SSD 4, für 2 SSD´s 8, für 3 SSD´s 12 und für 4 SSD´s letztlich 16 Lanes.

Ich will hier nochmals auf das System zurückkommen, denn da ist oft schon ein Knackpunkt. Die üblichen Desktop Systeme haben je nach Board und Prozessor

i.d.R. irgendwas zwischen 20 und 28 Lanes. Davon gehen dann schon mal 16 Lanes für die Graphikkarte weg. Und pro NVME Port (PCIe) dann nochmals je 4 Lanes - entweder vom Prozessor oder vom Chipsatz, wenn ich das korrekt sehe.

Ausgangsbasis für meine Konfiguration war daher ein System mit ausreichend PCIe Lanes - und zwar schon prozessorseitig, das sieht dann wie Folgt aus:

Mainboard: MSI x299 Tomahawk, CPU: 10980Xe (48 Lanes (Die 44 Lanes beziehen sich auf die Skylake Generation, da die Cascade Lake CPU´s zur Drucklegung des Handbuchs noch nicht existiert haben))

"Verbrauch": 16 Lanes: Graphikkarte, 4 Lanes: Asus 10 GBIT Netzwerkkarte, 4 Lanes: SATA Controller (extern), 2x PCIe NVME auf dem Mainboard (da weiß ich allerdings nicht, ob eine davon über den Chipsatz läuft)

Letztlich bleiben unter dem Strich übrig: 20-24 Lanes

Rein auf die PCIe Steckplätze bezogen (das Board ist "groß")

(c) MSI Handbuch zum Mainboard

Die Karte ist ein Billigteil von Amazon um 40 Euro:

das sieht dann so aus (eine SSD fehlt noch, wird erst morgen geliefert), zur Graphikkarte

sind gut 2 cm "Luft" und die Karte ist kurz:

Im BIOS mus PCIe Split/Bifurcation oder VROC für den betreffenden Slot aktivierbar sein,

sonst wird genau eine einzige SSD erkannt, und zwar die ganz Links (Nr. 1)

Wenn man danach Windows hoch fährt, passiert genau nichts. Man sieht aber im Gerätemanager

einen nicht erkannten Raid Controller. Hier muss jetzt für das Mainboard oder zumindest

den Chipsatz das passende RST Treibermodul von Intel für die entspr. Windows Version installiert werden.

Danach Reboot und danach sieht man in der Windows Datenträgerverwaltung Folgendes:

Die Plattennamen sind natürlich jetzt willkürlich, alle Platten GPT und als Basispartition.

Wie gesagt, eine Platte fehlt noch.

Performance Tests hänge ich noch an, sobald ich dazukomme.

Physikalisch sind das dann am Ende 2x Kingston NV2 und 2x Fanxiang s500 pro (TLC !!)