Ohman.... das CPU Limit ist ja tragisch....

Ich hatte wirklich gehoft die zeiten der schlechten Konsolen Ports sind vorbei.

Feature mässig ist das spiel ja wirklich Top. Aber das die Engine in so ein Übles CPU Limit rennt hätte ich nicht gedacht.

Dabei hat CB die Tests ja auch schon so gemacht...

Spider-Man Remastered im Test: CPU-Benchmarks in 720p mit und ohne Raytracing (Update) / Das Testsystem und die Benchmark-Szene

www.computerbase.de

Ich wette wenn man da so ein 13900k an die Kotzgrenze für SingleCore übertaktet könnte man noch so einiges mehr rausholen.

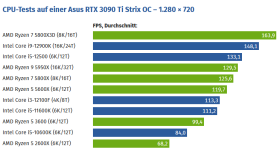

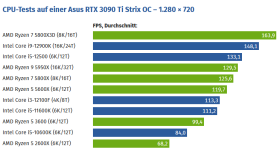

Intel Raptor Lake im Test: Benchmarks in Games / Leistung in Spielen (720p, RTX 3090 Ti) / CPU-Gaming-Leistung im absoluten CPU-Limit

www.computerbase.de

@Igor Wallossek mit welchem Takt läuft denn der 12900k denn du benutzt hast? da steht im Text nur "Übertaktet"

Bestimmt es gibt da so eine einzige Einstellug wie Volumetric Fog oder irgend so nen physics ding das nur SingleThreaded programmiert wurde und alles in den Abrund reisst. Denn auch Computerbase hat mit "Max Details" gebencht.

Würde auch erklären wieso DLSS/FSR Ohne FrameGeneration so gut wie kein Leistungszuwachs bringt. Typisches CPU Limit halt.

Interessant wäre mal zu sehen wie sie das ganze mit Minimalen Details verhält. Ob man da in die FPS Limitierung der Engine rennt?

Aber sehr interessant zu sehen das die FrameGeneration zu lange dauert.

Wenn wir 124.9FPS haben, also ziemlich exakt 8ms zum rendern eines Bildes und mit FrameGeneration 167.6FPS also 5.966ms, aufgerundet 6ms, dann müsste im Frame Time Graph ja eigentlich immer zwischen 8 und 4 ms hin und her schwanken. (denn einmal 8 ms und einmal 4ms ergeben die mittel 6ms) (Was aber auch bedeuten würde das es nicht möglich ist mit FG über 250 FPS zu kommen, weil es 4ms dauert ein Bild zu berechnen. Alles über 250FPS würde Nativ schneller berechner als das zwischenbild fertig ist.)

Sieht man da aber leider nicht weil zu viele Balken drin sind.

Wäre es möglich diesen Graphen mit NUR Nativ FG on und off zu sehen? Wobei das maximal ein 10 sekunden ausschnitt sein sollte ja man ja bei 1670 Datenpunken auch noch unterschiede/ up and downs erkennen möchte.

Ob das auf Dauer so gesund ist, ich hätte da Probleme.

Mach dein Hobby zum Beruf und du musst keinen Tag im Leben Arbeiten.... sagt man so...

Ich träum davon, daß es bald Framegeneration für alle möglichen Sachen auf dem PC gibt. Wennn schon alles höher aufgelöst wird, sieht man ja alles stottern. Bei einem niedrig aufgelösten Video stotterts nicht so bei seitwärts gerichteten Kameraschwenks. Also wenn z.B. das Video oder der Film in der ursprünglichen Auflösung dargestellt wird.

Ähhh...

Bei Filmen wird alles in 24FPS aufgenommen und hinter Motion Blur versteckt. Zbsp der Hobbit gab es sogar in HFR 48 FPS. (Leider nie selber im Kino gesehen...) Aber zuhause gibt es seit Jahren

software die für Videos Live Zwischenbilder berechnet... da ist eine Latenz von 1 Sekunde auch völlig irrelevant und es ist problemlos möglich korrekte zwischenbilder zu berechnen weil man das nächste ja bereits kennt!

Schöner Artikel bin echt mal gespannt wie sich Frame Generation entwickelt. Auf jeden fall ein netter ansatz bei dieser Technologie aber komplett abgeholt hat sich mich bisher nicht. Die Bildfehler die bei DLLS Frame Generation entstehen können wenn etwas für die KI unerwartetes geschieht sind dann doch noch etwas zu krass für mich.

www.svp-team.com

www.svp-team.com