Der Vizepräsident von AMD sagt, dass AMD dem Ansatz von Intel mit Hybrid-Architektur nicht folgen würde und stattdessen Zen 5 so schnell wie möglich auf Desktops bringen will. In dem Interview sprach David McAfee, Corporate Vice President und General Manager des Client Channel Business bei AMD, über das bestehende Portfolio des Unternehmens sowie über kommende (read full article...)

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Internetseiten nicht korrekt angezeigt werden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

AMD spricht über Zen 5, x86S und mehr, will aber Intels P-Core und E-Core-Hybridansatz nicht folgen

- Themenstarter Redaktion

- Beginndatum

arcDaniel

Urgestein

Interessantes Interview. Bin allerdings enttäuscht, dass AMD nicht auf den Weg von Hybrid/bigLITTLE CPUs gehen möchte. Im ARM Bereich seit Jahren ganz Normal und Intel hat es mittlerweile super im Griff.

Was ich auch komisch finde ist das mit RDNA3,5. RDNA3 gab es eher iGPU bevor die Grafikkarten auf den Markt kamen. Mich stimmt dies skeptisch, dass wir RDNA4 Grafikkarten vor 2025 sehen werden. Und RDNA3.5 wird sicher besser als 3, aber auch keinen Riesen Sprung machen, sonst hätte AMD aus Marketing Gründen sofort RDNA4 benutzt.

Mit Ryzen hat es AMD wieder und sogar sehr schnell nach vorne Gebracht. Seit Zen4 sind Plattformpreise gestiegen und persönlich finde ich dass es irgendwie an Inovation fehlt. Meine persönlicher Eindruck ist, dass sie ihr Momentum verloren haben.

Sie stehen zwar im CPU Bereich hervorragend dar, aber wenn sie nicht dahinter bleiben, naja Intel versucht auch wieder auf zu stehen.

Es klingt schon fast, als bräuchten sie hierfür Resourcen die sie nicht hätten, oder nutzen wollen.it makes it very complicated to ensure that the right workloads are scheduled on the right cores, consistently

Was ich auch komisch finde ist das mit RDNA3,5. RDNA3 gab es eher iGPU bevor die Grafikkarten auf den Markt kamen. Mich stimmt dies skeptisch, dass wir RDNA4 Grafikkarten vor 2025 sehen werden. Und RDNA3.5 wird sicher besser als 3, aber auch keinen Riesen Sprung machen, sonst hätte AMD aus Marketing Gründen sofort RDNA4 benutzt.

Mit Ryzen hat es AMD wieder und sogar sehr schnell nach vorne Gebracht. Seit Zen4 sind Plattformpreise gestiegen und persönlich finde ich dass es irgendwie an Inovation fehlt. Meine persönlicher Eindruck ist, dass sie ihr Momentum verloren haben.

Sie stehen zwar im CPU Bereich hervorragend dar, aber wenn sie nicht dahinter bleiben, naja Intel versucht auch wieder auf zu stehen.

Interessantes Interview. Bin allerdings enttäuscht, dass AMD nicht auf den Weg von Hybrid/bigLITTLE CPUs gehen möchte. Im ARM Bereich seit Jahren ganz Normal und Intel hat es mittlerweile super im Griff.

Es klingt schon fast, als bräuchten sie hierfür Resourcen die sie nicht hätten, oder nutzen wollen.

Lies doch erst mal nach was Zen 4c bedeutet.

Nvidia soll die nächste Generation auch erst 2025 bringen.Was ich auch komisch finde ist das mit RDNA3,5. RDNA3 gab es eher iGPU bevor die Grafikkarten auf den Markt kamen. Mich stimmt dies skeptisch, dass wir RDNA4 Grafikkarten vor 2025 sehen werden. Und RDNA3.5 wird sicher besser als 3, aber auch keinen Riesen Sprung machen, sonst hätte AMD aus Marketing Gründen sofort RDNA4 benutzt.

Öhm, also die neuen Epyc-Prozessoren sind im Moment in vielen Fällen klar gegen Intel im Vorteil.Mit Ryzen hat es AMD wieder und sogar sehr schnell nach vorne Gebracht. Seit Zen4 sind Plattformpreise gestiegen und persönlich finde ich dass es irgendwie an Inovation fehlt. Meine persönlicher Eindruck ist, dass sie ihr Momentum verloren haben.

Sie stehen zwar im CPU Bereich hervorragend dar, aber wenn sie nicht dahinter bleiben, naja Intel versucht auch wieder auf zu stehen.

Cunhell

RX_Vega1975

Veteran

- Mitglied seit

- Mrz 22, 2023

- Beiträge

- 165

- Bewertungspunkte

- 46

- Punkte

- 27

RDNA 3.5 kann ein Gefixter Navi 31 mit Mehr Takt und Besserer Effizienz werden

um gegen die 4080 und 4090 gegenhalten zu können.

Fakt ist aber auch das die 7900XTX nun so gut wie immer schneller als eine 4080 ist (und oftmals mehr als nur wenige Prozent)

und zudem auch billiger, so um die 80 bis 150 Euro.

um gegen die 4080 und 4090 gegenhalten zu können.

Fakt ist aber auch das die 7900XTX nun so gut wie immer schneller als eine 4080 ist (und oftmals mehr als nur wenige Prozent)

und zudem auch billiger, so um die 80 bis 150 Euro.

@arcDaniel: Hier findest du genaueres zum Thema Zen 4c.

www.computerbase.de

www.computerbase.de

Da gibt es einige Änderungen im Aufbau.

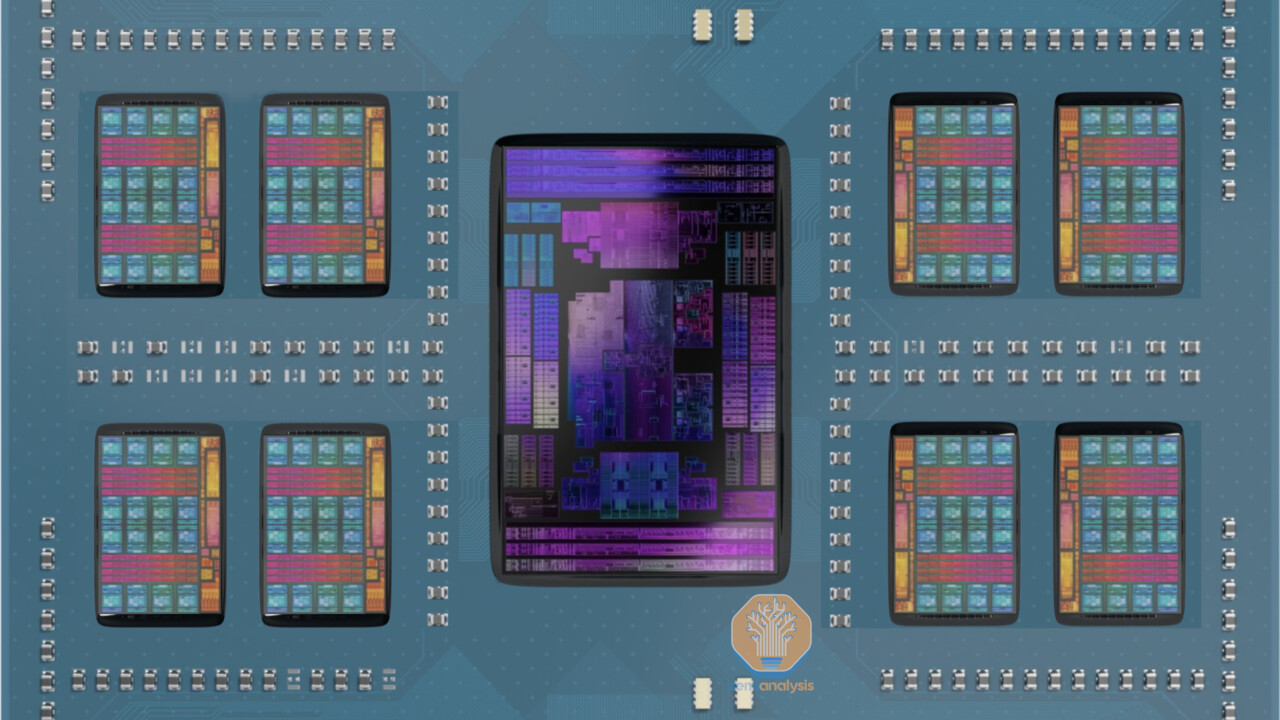

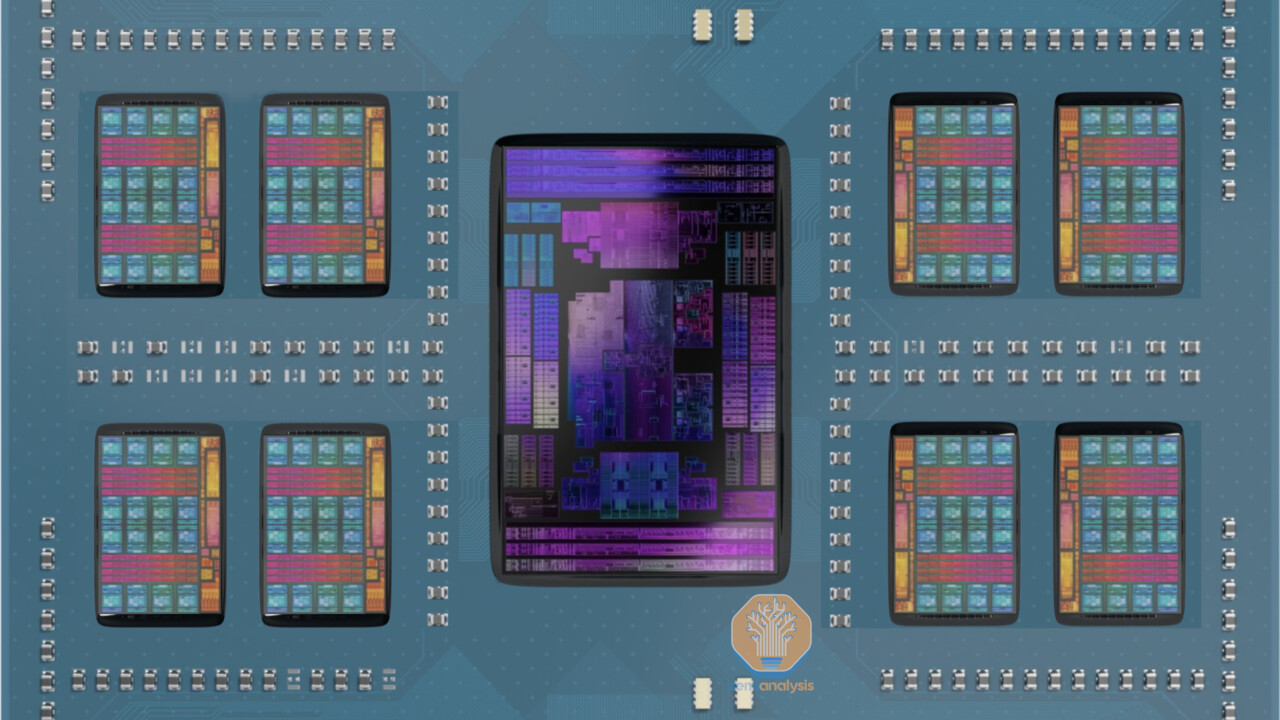

Zen 4c „Bergamo“: AMDs 16-Kern-CCD benötigt nur 9,6 % mehr Fläche als 8 Kerne

AMD greift beim in der kommenden Woche erwarteten ersten Zen-4c-Prozessor „Bergamo“ tief in die Trickkiste und bringt erstaunliches hervor.

Da gibt es einige Änderungen im Aufbau.

Du hast das falsch verstanden. AMD geht den Weg, den ARM schon lange geht: Verschiedene Kerne mit gleichen Features kombinieren. Intel geht bisher den Weg, verschiedene Kerne mit unterschiedlichen Features zu kombinieren. Diesen Weg geht AMD nicht mit. Intel hat deswegen ja so Probleme wie: AVX512 können nur die P-Kerne, nicht die E-Kerne, daher wird es in den P-Kernen deaktiviert (inzwischen wohl per Cut, lässt sich angeblich daher auch nicht mehr aktivieren).Interessantes Interview. Bin allerdings enttäuscht, dass AMD nicht auf den Weg von Hybrid/bigLITTLE CPUs gehen möchte. Im ARM Bereich seit Jahren ganz Normal und Intel hat es mittlerweile super im Griff.

Intel geht den Weg, weil sie die Kerne vorher auch schon hatten: Core und Atom. Und Atom war halt in den Features immer deutlich schwächer als Core. Das ist jetzt immer noch so, daher muss man eben die Features, die Core "mehr" bietet deaktivieren.

Ich gehe davon aus, dass Intel früher oder später die Features angleichen wird, aktuell hat man das aber noch nicht geschafft.

AMD braucht nichts angleichen, die streichen nur Sachen aus Zen weg, welche keine Anpassungen voraussetzen (Cache, Transistoren für hohe Taktraten,...). Ähnliches macht ARM auch. Der A520 hat im Vergleich zum A720 auch weniger L1 und L2 Cache (wobei ARM hier viele Freiheiten gibt, maximal hat der 520 jeweils die Hälfte L1 & L2). AMD's Ziel ist: Jeder Kern (egal ob schnell oder klein) kann immer alles von irgendeinem anderen Kern übernehmen. Also z.B. auch AVX512 Berechnungen. Die Kleinen machen das halt langsamer (da weniger Takt und Cache), aber sie können das trotzdem machen. Insofern fliegt das OS dann halt auch nicht auf die Schnauze, wenn es eine AVX512 Berechnung von einem Kern auf einen anderen verschiebt.

Schade nur dass man die e-cores bei einigen Spielen und Applikationen im Bios ausschalten muss, um mehr Performance / FPS zu bekommen.Interessantes Interview. Bin allerdings enttäuscht, dass AMD nicht auf den Weg von Hybrid/bigLITTLE CPUs gehen möchte. Im ARM Bereich seit Jahren ganz Normal und Intel hat es mittlerweile super im Griff.

Das kann man als "Intel hat es mittlerweile super im Griff" bezeichnen, sagt aber dann viel darüber aus, was man bei Intel alles als "normal" in Kauf nehmen muss.

Bin froh, das es mit AMD wenigstens einen Hersteller gibt, der weiterhin auch CPUs für Konsolen und PC-Spiele produziert.

eastcoast_pete

Urgestein

- Mitglied seit

- Jun 25, 2020

- Beiträge

- 1.508

- Bewertungspunkte

- 852

- Punkte

- 112

Mit der deutlichen Unterschieden in der Architektur zwischen AMD und Intel bleibt's zumindest interessant. Zumindest im Moment kann AMD sich ja auch auf die Fertigungsknoten bedingten Effizienz Vorteile ihrer "großen" Kerne verlassen. Wird interessant sein, was sich da (zumindest im Mobilen Bereich) bei Intel tut wenn Meteor Lake in "Intel 4" im Herbst erscheint. Auch daher wird es hohe Zeit, daß AMD und OEMs ihre 4 nm Phoenix APUs jetzt in größeren Zahlen anbieten; noch ist Intel hier im Nachteil.

@arcDaniel

Intel hat gar nichts im Griff. Deren big.LITTLE Design ist einfach nur Müll. Angefangen bei der inkompatiblen ISA zwischen P- und E-Kernen. Über unterschiedliche Features, wie z.B. SMT. Bis hin zu fragwürdigen Designentscheidungen, wie die Atom Basis der E-Kerne. Was zu unzureichenden Ergebnissen führt, wie der mageren Energieeffizienz der E-Kerne. Intel hat big.LITTLE nur aus einem Grund gebracht, nämlich um AMDs Vorsprung beim Kern- und Chiplet-Design zu kaschieren. Was ihnen mit der aktuellen Implementierung aber keineswegs gelungen ist, wenn man mal genau hinschaut. Intels Glück ist, dass AMD die TDP mittlerweile auch deutlich angehoben hat. So fällt die Diskrepanz teils gar nicht so sehr auf. Schaut man hingegen mal in die deutlich niedrigeren TDP Bereiche, da wird Intel regelrecht massakriert. Und das liegt keineswegs nur am besseren TSMC Prozess von Zen 4.

AMD hat das schon richtig erkannt, big.LITTLE ist maximal für den mobilen Markt zu gebrauchen. Und zu mehr war ARM bisher auch nicht in der Lage. Deswegen setzt Apples M1/2 vorrangig auf big Kerne. Die paar wenigen LITTLE Kerne sind nur Beiwerk für Hintergrundaufgaben. Anders als bei Intel, die weiter die Anzahl der E-Kerne nach oben schrauben. Du versuchst ARM und Intel in den gleichen Topf zu werfen. Da sind sie aber keineswegs.

Im Desktop und professionellen Markt sind hingegen homogene Designs zu bevorzugen. Das hat nichts mit Ressourcen zu tun, die AMD nicht hätte. Vielmehr ist es so, dass Intel mit dem Thread Director einen Aufwand betreibt, der ziemlich sinnfrei ist und mit besseren Kerndesign gar nicht notwendig wäre.

Es kommt im Desktop Markt nicht darauf an, unter Umständen ein paar Milliwatt einzusparen. Die Performance von big Kernen ist da weitaus wichtiger. Und im professionellen Markt ist Flächeneffizienz ein entscheidender Faktor. Genau da setzen die c-Kerne von AMD an. Keiner dieser Märkte braucht big.LITTLE. Ein homogenes Design vereinfacht vieles. Gerade auch die Arbeit der Softwareentwickler.

Ich sehe auch nirgendwo, dass AMD Momentum verloren hat. Im professionellen und mobilen Markt sind sie so gut aufgestellt wie nie zuvor. Im Desktop Markt ist es schon seit Jahren ein enges Duell. Ausnahme war vielleicht nur der miserable Rocket Lake. Da musste Intel etwas Federn lassen. Und mit Zen 5 wird AMD weiter gewaltig nachlegen. Während ich für Intels 14. Gen im Desktop nur einen uninteressanten und lauwarmen Aufguss der 13. Gen erwarte. Erst die 15. Gen dürfte wieder interessant werden. Aber vermutlich nicht vor Ende 2024. Dauert also noch. Während Zen 5 in 1H 2024 erwartet wird.

Intel hat gar nichts im Griff. Deren big.LITTLE Design ist einfach nur Müll. Angefangen bei der inkompatiblen ISA zwischen P- und E-Kernen. Über unterschiedliche Features, wie z.B. SMT. Bis hin zu fragwürdigen Designentscheidungen, wie die Atom Basis der E-Kerne. Was zu unzureichenden Ergebnissen führt, wie der mageren Energieeffizienz der E-Kerne. Intel hat big.LITTLE nur aus einem Grund gebracht, nämlich um AMDs Vorsprung beim Kern- und Chiplet-Design zu kaschieren. Was ihnen mit der aktuellen Implementierung aber keineswegs gelungen ist, wenn man mal genau hinschaut. Intels Glück ist, dass AMD die TDP mittlerweile auch deutlich angehoben hat. So fällt die Diskrepanz teils gar nicht so sehr auf. Schaut man hingegen mal in die deutlich niedrigeren TDP Bereiche, da wird Intel regelrecht massakriert. Und das liegt keineswegs nur am besseren TSMC Prozess von Zen 4.

AMD hat das schon richtig erkannt, big.LITTLE ist maximal für den mobilen Markt zu gebrauchen. Und zu mehr war ARM bisher auch nicht in der Lage. Deswegen setzt Apples M1/2 vorrangig auf big Kerne. Die paar wenigen LITTLE Kerne sind nur Beiwerk für Hintergrundaufgaben. Anders als bei Intel, die weiter die Anzahl der E-Kerne nach oben schrauben. Du versuchst ARM und Intel in den gleichen Topf zu werfen. Da sind sie aber keineswegs.

Im Desktop und professionellen Markt sind hingegen homogene Designs zu bevorzugen. Das hat nichts mit Ressourcen zu tun, die AMD nicht hätte. Vielmehr ist es so, dass Intel mit dem Thread Director einen Aufwand betreibt, der ziemlich sinnfrei ist und mit besseren Kerndesign gar nicht notwendig wäre.

Es kommt im Desktop Markt nicht darauf an, unter Umständen ein paar Milliwatt einzusparen. Die Performance von big Kernen ist da weitaus wichtiger. Und im professionellen Markt ist Flächeneffizienz ein entscheidender Faktor. Genau da setzen die c-Kerne von AMD an. Keiner dieser Märkte braucht big.LITTLE. Ein homogenes Design vereinfacht vieles. Gerade auch die Arbeit der Softwareentwickler.

Ich sehe auch nirgendwo, dass AMD Momentum verloren hat. Im professionellen und mobilen Markt sind sie so gut aufgestellt wie nie zuvor. Im Desktop Markt ist es schon seit Jahren ein enges Duell. Ausnahme war vielleicht nur der miserable Rocket Lake. Da musste Intel etwas Federn lassen. Und mit Zen 5 wird AMD weiter gewaltig nachlegen. Während ich für Intels 14. Gen im Desktop nur einen uninteressanten und lauwarmen Aufguss der 13. Gen erwarte. Erst die 15. Gen dürfte wieder interessant werden. Aber vermutlich nicht vor Ende 2024. Dauert also noch. Während Zen 5 in 1H 2024 erwartet wird.

Ifalna

Veteran

- Mitglied seit

- Mrz 31, 2022

- Beiträge

- 329

- Bewertungspunkte

- 293

- Punkte

- 63

Als Alder-Lake nutzer möchte ich hier mal ganz ehrlich sein:Bin allerdings enttäuscht, dass AMD nicht auf den Weg von Hybrid/bigLITTLE CPUs gehen möchte.

Ich hab den Sinn von den E-Cores bis heute nicht verstanden.

Wenn ich mein OS oder irgendein game beobachte, krallen sich die Prozesse random irgendwelche cores auf die die grade Lust haben. Manchesmal läuft dann auch etwas von einem game auf einem E-Core anstatt auf einem P-Core und Windows eigene Dödelei läuft dann halt auch auf einem P-Core anstatt wie für einen Hintergrund task gedacht auf nem E-Core.

Die allermeisten Anwendungen nutzen weniger als 8 Cores. Da würden nicht vorhandene E-Cores nicht weiter auffallen. Das Einzige Programm was ich nutze, dass die CPU auslastet und mal von den E-Cores profitiert ist Blender (rendering). Man muss aber schon hart masochistisch sein, dass auf der CPU anstatt mit der GPU zu machen, welche dafür < 10% der Zeit braucht.

Soweit ich das sehe gibt es nur folgende Gründe für E-Cores:

- Intel kann keine sinnvolle Ausbeute mit 20+ P-Cores erzielen.

- 20+ P-Cores wären für normale Kühllösungen nicht handelbar.

Also schnappt man sich abgespeckte Cores die man massenweise draufklatschen und dann auch noch kühlen kann.

Ich bleib dabei, auch als Intel Nutzer: Big-LITTLE ist im Desktopbereich absuluter Blödsinn.

Tronado

Urgestein

Ohne E-Cores wäre Intel in der Leistung mit dem 7/10nm Prozess nicht mehr im MC konkurrenzfähig gewesen, das haben sie sehr geschickt gemacht. Sollte 4nm und darunter effizienter arbeiten, wird es auch irgendwann keine E-Cores mehr brauchen. Die Spiele und Programme, die (unter Windows 11 wohlgemerkt) nicht korrekt auf die Cores verteilen, lassen sich an einer Hand abzählen. Mich würde bei AMDs 7900X3D und 7950X3D eher der 3D-Cache auf nur einem CCD stören, von wegen "homogene Kerne". Und bei der IPC hinkt AMD immer noch hinterher.

arcDaniel

Urgestein

Also ich hatte einen Ryzen 5600X und habe die Plattform gewechselt (Grund würde Thema hier sprengen) und habe mich bewusst für Intel entschieden. Jetzt habe ich einen Intel 13400 und habe noch keine Nachteile wegen der E-Cores feststellen können. Nach 6 Jahren Ryzen der erste Wechsel zu Intel.

Der 13400 und 5600X sind bei im Marketing-Jargon in 7Nm gefertigt, ist man böse kann man sogar sagen, dass der Intel nur in 10Nm gefertigt ist.

Dennoch verbrät der Intel weniger Energie, bietet ein gutes Stück mehr Leistung und bleibt auch Kühler (unter gleichen Voraussetzungen).

Vor dem Wechsel habe ich mich natürlich auch Richtung AMD 7600 informiert und was soll ich sagen: durch die Bank nur geringfügig schneller, verbraucht dabei mehr Energie, wird also auch wärmer und der (gezwungene) Wechsel hätte mich mehr gekostet.

Würde man den 7600 so begrenzen, dass er die gleiche Energie wie der 13400 verbraucht, sind beide gleich schnell. Dann betrachte ich eine Intel7/10Nm CPU mit einer 5Nm CPU... wo ist also der Fortschritt bei AMD? Und hier muss ich @Tronado zustimmen. Rein von der IPC hinkt AMD immer noch hinterher. AMD konnte immer mit einem besseren Preis/Leistungsverhältnis locken, was mit AM5 leider vorbei ist.

Die CPUs 13900K(S) oder 7950X(3D) sind alle nur alle Murks, hier wird auf biegen und Brechen Leistung herausgeholt um die Spitze beanspruchen zu können. Leider wird zu oft an diesen Alpha-Tieren ausgemacht, wer der bessere ist.

Schaut man sich die Vernünftigeren CPUs an, kann sich das Bild sehr schnell drehen.

Zudem frage ich mich wer im Moment mehr Probleme hat, Intel mit den E-Cores oder AMD mit ihrer CCD Aufteilung und den SMT Probleme?

Wobei ich mir sicher bin, dass der normale Nutzen nicht von diesen Geringfügigen Problemchen etwas mit bekommt. Hier muss man schon aufwändige Analysen durchführen um etwas feststellen zu können.

Das Bedeutet nun nicht, dass ich Intel Fan... wäre. Bei meinem nächsten Plattformwechsel werde ich die Situation neu bewerten. Wie ich mich kenne wäre dies wieder in 2 Jahren.

Der 13400 und 5600X sind bei im Marketing-Jargon in 7Nm gefertigt, ist man böse kann man sogar sagen, dass der Intel nur in 10Nm gefertigt ist.

Dennoch verbrät der Intel weniger Energie, bietet ein gutes Stück mehr Leistung und bleibt auch Kühler (unter gleichen Voraussetzungen).

Vor dem Wechsel habe ich mich natürlich auch Richtung AMD 7600 informiert und was soll ich sagen: durch die Bank nur geringfügig schneller, verbraucht dabei mehr Energie, wird also auch wärmer und der (gezwungene) Wechsel hätte mich mehr gekostet.

Würde man den 7600 so begrenzen, dass er die gleiche Energie wie der 13400 verbraucht, sind beide gleich schnell. Dann betrachte ich eine Intel7/10Nm CPU mit einer 5Nm CPU... wo ist also der Fortschritt bei AMD? Und hier muss ich @Tronado zustimmen. Rein von der IPC hinkt AMD immer noch hinterher. AMD konnte immer mit einem besseren Preis/Leistungsverhältnis locken, was mit AM5 leider vorbei ist.

Die CPUs 13900K(S) oder 7950X(3D) sind alle nur alle Murks, hier wird auf biegen und Brechen Leistung herausgeholt um die Spitze beanspruchen zu können. Leider wird zu oft an diesen Alpha-Tieren ausgemacht, wer der bessere ist.

Schaut man sich die Vernünftigeren CPUs an, kann sich das Bild sehr schnell drehen.

Zudem frage ich mich wer im Moment mehr Probleme hat, Intel mit den E-Cores oder AMD mit ihrer CCD Aufteilung und den SMT Probleme?

Wobei ich mir sicher bin, dass der normale Nutzen nicht von diesen Geringfügigen Problemchen etwas mit bekommt. Hier muss man schon aufwändige Analysen durchführen um etwas feststellen zu können.

Das Bedeutet nun nicht, dass ich Intel Fan... wäre. Bei meinem nächsten Plattformwechsel werde ich die Situation neu bewerten. Wie ich mich kenne wäre dies wieder in 2 Jahren.

Ifalna

Veteran

- Mitglied seit

- Mrz 31, 2022

- Beiträge

- 329

- Bewertungspunkte

- 293

- Punkte

- 63

Die CPUs 13900K(S) oder 7950X(3D) sind alle nur alle Murks, hier wird auf biegen und Brechen Leistung herausgeholt um die Spitze beanspruchen zu können. Leider wird zu oft an diesen Alpha-Tieren ausgemacht, wer der bessere ist.

Das sind Desktop Prozessoren, da interessiert mich nur die Leistung aber ned ob die die Kiste im Endeffekt 20W weniger oder mehr braucht. Das mag bei Batteriegestützte Geräten wichtig sein, aber ned bei Desktops.

Natürlich solange Energieverbrauch und Wärmeentwicklung im Rahmen bleiben.

Nen unhinged-Overclock 340W Monster will ich dann auch nicht in der Kiste haben.

Ein untervolteter 13900KS ist sicher effizienter als dein 13400, allein schon wegen der höheren Chipgüte und damit einhergenend niedrigerer Spannung.

Hagal77

Veteran

- Mitglied seit

- Dez 5, 2022

- Beiträge

- 134

- Bewertungspunkte

- 87

- Punkte

- 28

Dann bietet endlich Quad Channel RAM an, für Desktop. Hört sich erst mal so an als wird ZEN5 auch langweilig.

Nicht mehr max. Kerne und nicht mehr Speicherkanäle, bestimmt auch wieder kein Dualcache X3D...

Dann muss ich wohl auf AM6 warten.

Einzig positive keine Schmutz E Cores.

mfg

Nicht mehr max. Kerne und nicht mehr Speicherkanäle, bestimmt auch wieder kein Dualcache X3D...

Dann muss ich wohl auf AM6 warten.

Einzig positive keine Schmutz E Cores.

mfg

Casi030

Urgestein

- Mitglied seit

- Sep 9, 2019

- Beiträge

- 11.923

- Bewertungspunkte

- 2.339

- Punkte

- 113

Sicher nicht sondern 1000% auf jeden Fall,ob er wie bei AMD den halben Verbrauch schaft ist aber fraglich.Ein untervolteter 13900KS ist sicher effizienter als dein 13400, allein schon wegen der höheren Chipgüte und damit einhergenend niedrigerer SpSpannung.

arcDaniel

Urgestein

Sorry war gestern nicht sonderlich gut Gelaunt, deshalb waren meine Posts etwas Schorf...

@Ifalna (aber auch die anderen) ich gebe die ganz klar Recht und auch weiss ich dass mein 13400 nicht perfekt ist. Ich braucht aber jetzt eine neue Plattform und hätte lieber einen 13900T gekauft. Da der Raptor Lake refresh for der Tür steht, wollte ich aber die günstigste CPU welche mir jetzt von der Leistung reicht.

Ich möchte auch nicht von Hand Optimierte CPUs vergleichen, da dies leider sehr viele User total überfordern. Hier im Forum weniger (liest man dennoch), gibt es User, welche mit dem Simplen installieren eines Treibers total überfordert sind, wie soll man hier verlangen eine CPU zu optimieren?

Reviews basieren sich leider immer nur auf diese K(S) und X Modelle, wo egal wie der Verbraucht ist, versucht wird, so gut wie Möglich gegenüber der Konkurrenz da zu stehen.

So ein komplettes Review einer T CPU findet man eher selten. Ich habe jetzt nur einen sehr kurzen Teste 13900T vs 12900K gefunden, und hier hat der 13900T mehr Leistung bei 28% vom Verbrauch der TDP (35W vs 125W) und weniger als der Hälte beim Turbo (106W vs 241W)

Dies Per Hand zu optimieren, benötigt schon sehr viel Zeit ohne jemals die Garantie zu haben, dass auch wirklich zu 1000% alles Stabil läuft.

Was die E-Cores angeht:

www.techpowerup.com

www.techpowerup.com

Hier sieht man, dass im Überschlag, es keinen Nachteil gibt. Was ich hier interessant finden würde, wäre eine normale Tagesnutzung verglichen mit und ohne E-Cores, was am Ende des Tages an Ersparnis raus kommt oder auch nicht. Damit meine ich nicht von Morgens bis Abends Benchmarks laufen lassen, sondern gemischt, Office, Internet, vielleicht etwas Bildverarbeitung, oder sogar rendern, wie normales Gaming (kein Gaming Benchmark). Erst dann sollte man beurteilen ob die E-Cores etwas bringen oder nicht.

Ja auch hier hat AMD ihre non-X CPUs welche wirklich sehr Sparsam sind ohne wirklichen Leistungsverlust. Dennoch sieht man beim Vergleich von solchen CPUs, wo nicht versucht wurde auf Teufel komm raus, den längsten Balken zu generieren, Intel doch noch immer die Nase vorn hat, trotz eines schlechteren Fertigungsverfahren.

Früher war Intel teils so mächtig, weil sie das beste Fertigungsverfahren hatten und genau hier sind sie stark zurückgefallen, während AMD von der super TSMC Fertigung profitieren kann. Mit all dem was ich jetzt festgestellt habe (während ich mich Aktiv und Objektiv damit Beschäftigt habe och ich bei AMD bleibe oder zu Intel wechsle), Frage ich mich, was passiert, wenn Intel bei ihrer Fertigung wieder aufholt und/oder TSMC in Stocken gerät.

Dann kommt noch mein Gewissen dazu: Intel baut in Deutschland eine Fab (ich bin weder Deutscher noch lebe ich dort), was Arbeitsplätze bringt, Steuereinnahmen... Sprich Europa hier auch profitiert und unabhängiger vom immer komplizierten östlichen Markt macht. TSMC hat Europa eine Absage erteilt. (Welche Bedeutung hat Globalfoundries überhaupt nach im aktuellen Chip Markt?)

@Ifalna (aber auch die anderen) ich gebe die ganz klar Recht und auch weiss ich dass mein 13400 nicht perfekt ist. Ich braucht aber jetzt eine neue Plattform und hätte lieber einen 13900T gekauft. Da der Raptor Lake refresh for der Tür steht, wollte ich aber die günstigste CPU welche mir jetzt von der Leistung reicht.

Ich möchte auch nicht von Hand Optimierte CPUs vergleichen, da dies leider sehr viele User total überfordern. Hier im Forum weniger (liest man dennoch), gibt es User, welche mit dem Simplen installieren eines Treibers total überfordert sind, wie soll man hier verlangen eine CPU zu optimieren?

Reviews basieren sich leider immer nur auf diese K(S) und X Modelle, wo egal wie der Verbraucht ist, versucht wird, so gut wie Möglich gegenüber der Konkurrenz da zu stehen.

So ein komplettes Review einer T CPU findet man eher selten. Ich habe jetzt nur einen sehr kurzen Teste 13900T vs 12900K gefunden, und hier hat der 13900T mehr Leistung bei 28% vom Verbrauch der TDP (35W vs 125W) und weniger als der Hälte beim Turbo (106W vs 241W)

Dies Per Hand zu optimieren, benötigt schon sehr viel Zeit ohne jemals die Garantie zu haben, dass auch wirklich zu 1000% alles Stabil läuft.

Was die E-Cores angeht:

RTX 4090 & 53 Games: Core i9-13900K E-Cores Enabled vs Disabled Review

In this week's TPU50 Megabench we're testing whether you can unlock additional gaming performance by disabling the E-Cores on a Raptor Lake Core i9-13900K processor. For our benchmarks we used the mighty GeForce RTX 4090, with 53 games at three resolutions.

Hier sieht man, dass im Überschlag, es keinen Nachteil gibt. Was ich hier interessant finden würde, wäre eine normale Tagesnutzung verglichen mit und ohne E-Cores, was am Ende des Tages an Ersparnis raus kommt oder auch nicht. Damit meine ich nicht von Morgens bis Abends Benchmarks laufen lassen, sondern gemischt, Office, Internet, vielleicht etwas Bildverarbeitung, oder sogar rendern, wie normales Gaming (kein Gaming Benchmark). Erst dann sollte man beurteilen ob die E-Cores etwas bringen oder nicht.

Ja auch hier hat AMD ihre non-X CPUs welche wirklich sehr Sparsam sind ohne wirklichen Leistungsverlust. Dennoch sieht man beim Vergleich von solchen CPUs, wo nicht versucht wurde auf Teufel komm raus, den längsten Balken zu generieren, Intel doch noch immer die Nase vorn hat, trotz eines schlechteren Fertigungsverfahren.

Früher war Intel teils so mächtig, weil sie das beste Fertigungsverfahren hatten und genau hier sind sie stark zurückgefallen, während AMD von der super TSMC Fertigung profitieren kann. Mit all dem was ich jetzt festgestellt habe (während ich mich Aktiv und Objektiv damit Beschäftigt habe och ich bei AMD bleibe oder zu Intel wechsle), Frage ich mich, was passiert, wenn Intel bei ihrer Fertigung wieder aufholt und/oder TSMC in Stocken gerät.

Dann kommt noch mein Gewissen dazu: Intel baut in Deutschland eine Fab (ich bin weder Deutscher noch lebe ich dort), was Arbeitsplätze bringt, Steuereinnahmen... Sprich Europa hier auch profitiert und unabhängiger vom immer komplizierten östlichen Markt macht. TSMC hat Europa eine Absage erteilt. (Welche Bedeutung hat Globalfoundries überhaupt nach im aktuellen Chip Markt?)

Ifalna

Veteran

- Mitglied seit

- Mrz 31, 2022

- Beiträge

- 329

- Bewertungspunkte

- 293

- Punkte

- 63

Eine interessante Frage.Hier sieht man, dass im Überschlag, es keinen Nachteil gibt. Was ich hier interessant finden würde, wäre eine normale Tagesnutzung verglichen mit und ohne E-Cores, was am Ende des Tages an Ersparnis raus kommt oder auch nicht. Damit meine ich nicht von Morgens bis Abends Benchmarks laufen lassen, sondern gemischt, Office, Internet, vielleicht etwas Bildverarbeitung, oder sogar rendern, wie normales Gaming (kein Gaming Benchmark). Erst dann sollte man beurteilen ob die E-Cores etwas bringen oder nicht.

Technisch gesehen, müsste man doch nur den idle-Verbrauch der beiden Kernsorten vergleichen. Denn sobald Leistung gefordert wird, läuft der Prozess sowieso auf den P-Cores. E-Cores machen (abseits von Anwendungen die alle cores hart rannehmen die nich bei 3 auf den Bäumen sind) sonst ja nur Windows internes Hintergrundgedudel.

Man sollte immer bedenken, dass diese Kernmonster heutzutage nur sehr selten wirklich mal unter Vollast laufen. Außerhalb von Benchmarks sehe ich bei meiner CPU nie die 200W.

Ich vermute, dass die Unterschiede im Desktopbetrieb im Bereich der Vernachlässigbarkeit liegen.

Ich gebe Dir Recht: die wenigsten Nutzer werden sich die Mühe machen ihr System von Hand zu optimieren und stundenlanges testen + evtl. Instabilitäten in Kauf nehmen nur um 10-20W zu sparen. Ich hab auch nur einen "primitiven" quick&dirty Overclock drin, weil ich da 5000+ sehen wollte. :'D

@arcDaniel Globalfoundries geht es besser denn je. Ihre Entscheidung im Wettrennen nicht mehr mit zu machen zahlt sich aus. Die Produzieren inzwischen für die Industrie.

arcDaniel

Urgestein

finde ich gut, Frage mich nur was und für wen sie im Moment fertigen. Kann ja sehr weit gehen.@arcDaniel Globalfoundries geht es besser denn je. Ihre Entscheidung im Wettrennen nicht mehr mit zu machen zahlt sich aus. Die Produzieren inzwischen für die Industrie.