- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.201

- Bewertungspunkte

- 18.825

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

Das geht nicht. Entweder oder.

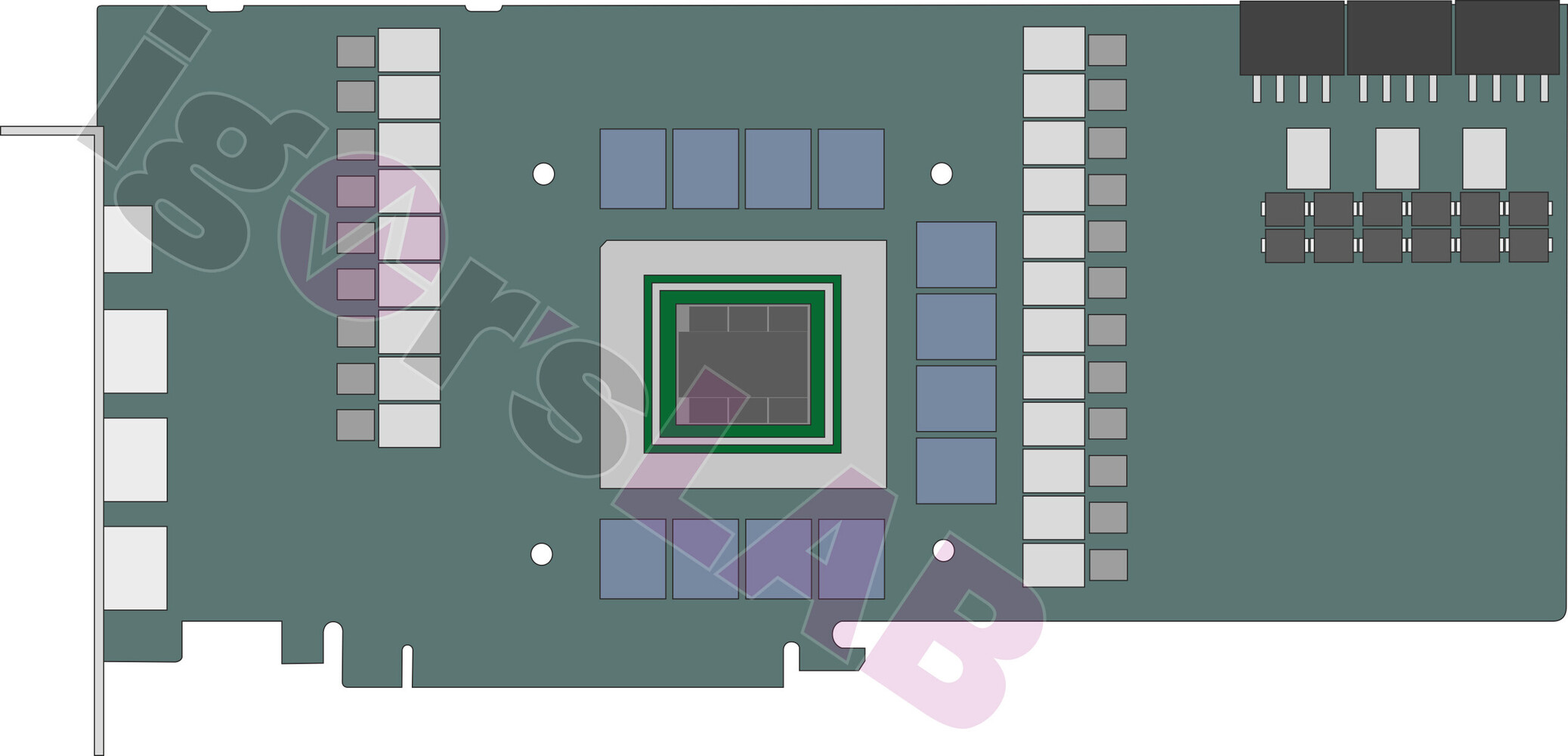

Die Spikes, um die es ja primär geht, kommen von der GPU, die ja auch bei AMD abgeregelt wird. Da ist es Wurst, wo man misst und regelt. Bei NV zählen ja sogar die Lüfter mit im Budget. NV's Falle ist das schleichende Runtertakten nach Erwärmung der VRM, weil auch deren Verluste im Budget signifikant sind. Und ATX 3.0, selten so einen Dünnschiss gelesen. Dagegen helfen auch keine Shunts sondern zweckmäßige Schaltungsdesigns und gute Filter (siehe Zeichnung). Da reicht auch ein simpler LC-Pass 1. Ordnung

Die Spikes, um die es ja primär geht, kommen von der GPU, die ja auch bei AMD abgeregelt wird. Da ist es Wurst, wo man misst und regelt. Bei NV zählen ja sogar die Lüfter mit im Budget. NV's Falle ist das schleichende Runtertakten nach Erwärmung der VRM, weil auch deren Verluste im Budget signifikant sind. Und ATX 3.0, selten so einen Dünnschiss gelesen. Dagegen helfen auch keine Shunts sondern zweckmäßige Schaltungsdesigns und gute Filter (siehe Zeichnung). Da reicht auch ein simpler LC-Pass 1. Ordnung