Guten Morgen,

vielen Dank

@Martin Gut und

@Yve für Euren Input hier. Die verlinkten Dokumente schaue ich mir im Laufe des Tages einmal an.

Hintergrund meiner Fragestellung. Ich bearbeite derzeit einen wiederkehrenden WorkFlow mit 2 GPU "alt" mit insgesamt knapp 6.000 CUDA-Cores. Mit viel Konfigurationstuning der Anwendung habe ich einen für mich geschwindigkeitsseitig zufriedenstellenden Arbeitsmodus gefunden, der allerdings eine gewisse und auch zeit in Anspruch nehmende Vorbereitung darf.

Konkret: für die Erstellung / Produktion von Videos (4K Material input - output 1080p) mit Davinci Resolve Studio ist mnur dann ein flüssiges Arbeiten möglich, wenn alle zu verarbeitenden Filmdaten zuvor über den anwendungsinternen Proxy (Umwandlung der Fildaten und Bereitstellung in Einzelbildern, falls ich das richtig verstanden habe) zugespielt werden. Wenn ich die Filmdaten ohne den Umweg über den Proxy direkt verarbeiten will, geht das zwar auch irgendwie, aber von flüssigem Arbeiten kann auch mit viel good-will nicht gesprochen werden.

Die Bereitstellung der Proxydaten erfolgt sowohl über eine NVME-M2 SSD als auch - für weniger komplexe Daten - über klassische Platten im internen RAID5 - Verbund (6 mal WD Black) des PC. Die Performance der Platten / der NVME-M2 SSD ist nicht zu beanstanden und sollte bei der weiteren Betrachtung aussen vorgelassen werden.

Da allerdings die Umwandlung der Filmdaten merklich Zeit kostet, frage ich mich, ob mehr CUDA-Cores (und auch wieviele) einen so großen Geschwindigkeitsvorteil bringen könnten, die Proxy-Bereitstellung zu vermeiden. Daher versuche ich ein Verständnis dafür zu entwickeln,

* ob bspw. eine Verdoppelung der CUDA-Cores auch eine Verdoppelung der CUDA-Verarbeitungsgeschwindigkeit bringen würde

* ob bspw. bei gleicher Anzahl CUDA-Cores (und gleicher GPU) die CUDA-Verarbeitungsgeschwindigkeit durch Erhöhung der GPU-Taktfrequenz linear oder exponentiell erhöht wird

* ob bspw. ein CUDA-Core von Ampere langsamer rechnet (und wieviel) als ein CUDA-Core von ADA (bei gleichem Takt von Ampere / Ada)

um ggf. in andere GPU-Hardware zu investieren.

Mir ist dabei wohlbewusst, dass es auch für Benchmarks und Reviews gibt, jedoch erschließt sich mir nicht, welche Werte ich da zwischen den einzelnen Karten / Generationen vergleichen soll, um die CUDA-Performance zu bewerten, gehe aber nach

@Martin Gut Ausführungen davon aus, dass unter den von mir getroffenden Annahmen CUDA-Core "neu" grundsätzlich schneller rechnet als CUDA Core "alt" und -

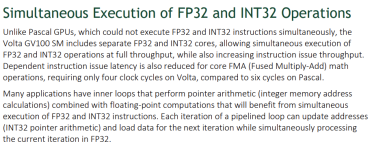

@Yve - eventuell Aussagen zur FP32 Berechnungsgeschwindigkeit eine Vergleichsmöglichkeit der CUDA-Leistung einzelner Karten verschiedener Generationen darstellt. Habe ich das so richtig verstanden?

Wenn ich nun festhalten darf, dass CUDA-Core der GPU "neu" aus verschiedenen Optimierungen heraus schneller ist als CUDA-Core "alt" und zudem noch die Erhöhung der Taktgeschwindigkeit der GPU zur Verbesserung der CUDA-Core Leistung beiträgt, sind 6.000 CUDA Core "neu" in jedem Fall schneller als 6.000 CUDA-Core "alt".

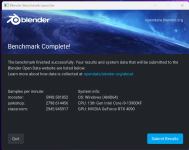

Nur das wieviel schneller, das treibt mich um, denn um auf die Proxies verzichten zu können, müsste ich vermutlich das 10-fache an CUDA-Core Rechenleistung einsetzen um die für flüssige Bearbeitung ohne Proxies notwendige Darstellungsgeschwindigkeit (24 fps konstant - auch bei Einsatz von Effekten - heute ohne Proxy teilweise unter 3 fps) zu erhalten. Und das würde ich gerne vor einem Kauf in der Theorie zumindest mal durchspielen, um zu wissen, was es bringen könnte. Und um das dazu passende "Modell" aufzustellen, müsste ich besser verstehen, wie sich die CUDA-Cores über die Zeit entwickelt haben und wie man sie vergleichen kann.

Vielleicht mache ich mir das Leben hier aber auch zu schwer, und es genügt einfach, die Werte X und/oder Y in den jeweiligen technischen Spezifikationen zu vergleichen, um eine Annäherung zu erzielen. (vielleicht die FP32 Rechenleistung?) Dann würde es mich freuen, wenn jemand die zu vergleichenden Werte hier einstellt.

Diese Gedanken mache ich mir hier ganz bewußt und schließe - derzeit noch - einen praktischen Test mit einer oder zwei neuen Karten aus, denn der Umbau meines PCs, bis dann im Endeffekt alles wieder läuft, dauert schon seine Zeit, ich müsste zudem nicht unerheblich viel Geld in die Hand nehmen, um Karten zu erwerben und dan ggf. auch teure Karten an einen Händler zurücksenden. Das würde ich gerne vermeiden. Und versuche die Materie vorher zu verstehen ...

In jedem Fall - vielen Dank für Eure Gedanken.

.

.