Verschiebung der Performance im Limit?

Nein, es liegt nicht an Horizon Zero Dawn, welches ich aus vielen anderen angetesteten Spielen ausgewählt habe, es liegt wirklich an einem anderen Problem, das ich später noch verorten möchte. Denn die Mutmaßung, ob man dies jetzt alles pauschal auf einen durch was auch immer erzeugten Treiber-Overhead oder etwas anderes zurückführen kann, hilft an dieser Stelle erst einmal nicht weiter. Wir müssen testen, testen, testen!

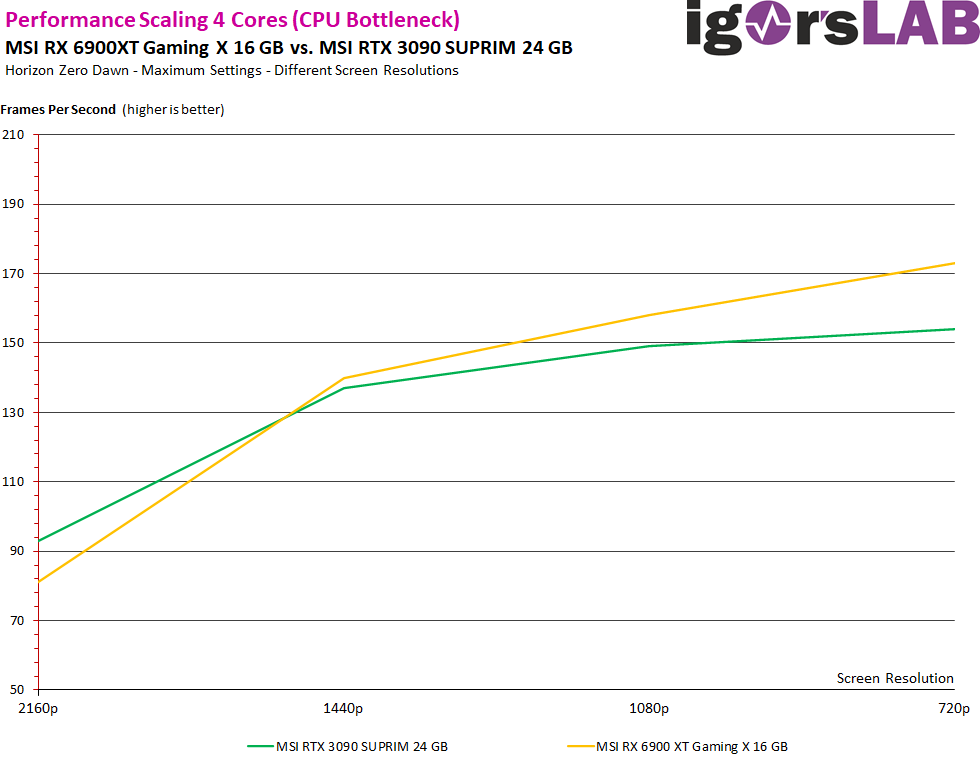

Betrachten wir nun zunächst einmal die Performance mit 4 Kernen (8 Threads). Während die Radeon in 2160p noch ca. 13 Prozentpunkte zurückliegt, sind es in 1440p bereits 2 Prozentpunkte Vorsprung, der dann bei 1080p auf 6 Prozente ansteigt, um in 720p sogar noch auf 11 Prozentpunkte anzusteigen. Die 11 merken wir uns bitte mal. Interessant ist aber auch, dass die Werte beider Karten in 2160p bereits einigermaßen identisch zu denen mit 6 oder 8 Kernen sind, hier also kaum noch die CPU limitiert. Ab WQHD greift jedoch der CPU-Flaschenhals immer stärker. Die Auswirkungen treffen die GeForce-Karte jedoch deutlich stärker als die Radeon-Karte, wenn auch nur relativ bei den FPS!

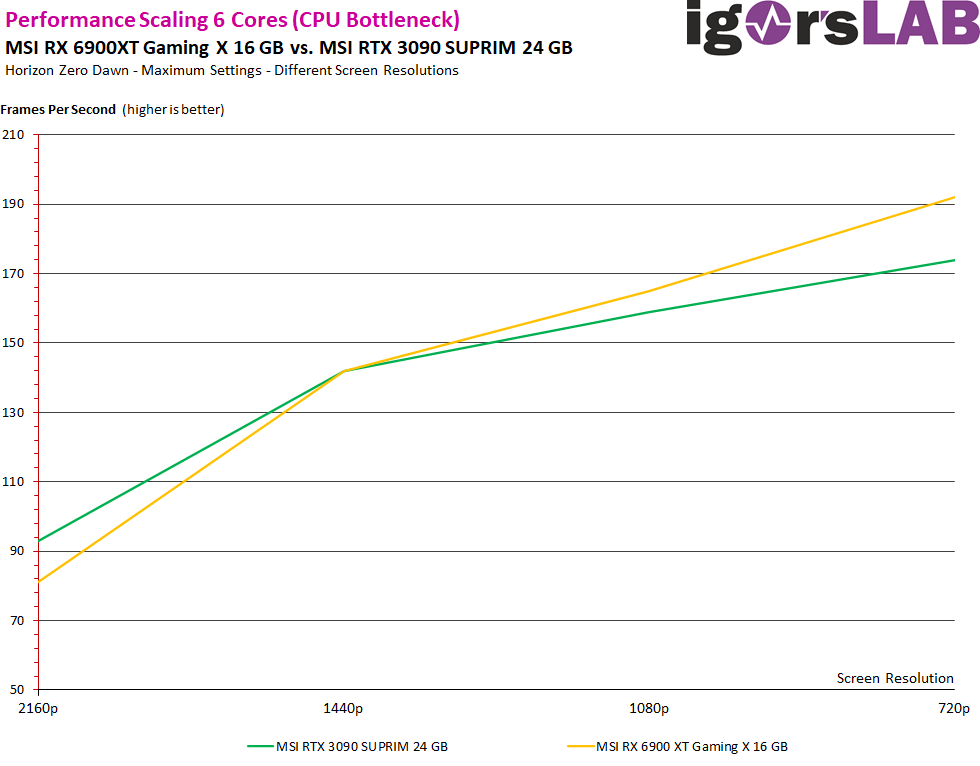

Mit 6 Kernen bzw. 12 Threads wird es jetzt erst unterhalb von 1440p interessant, denn in WQHD performen beide Karten gleich schnell. Der Abstand in 2160p ist der gleiche wie mit 4 Kernen. Kunststück, denn auch die FPS sind gleich, da hier nur die Grafikkarte limitiert. Der Vorsprung der Radeon zeigt sich erst in 1080p, wo er knapp 4 Prozentpunkte beträgt. Die Radeon ist mit nur 4 Kernen übrigens genauso schnell wie jetzt die GeForce mit 6 Kernen. interessante Erkenntnis am Rande. Und in 720p? Da sind es genau 10 Prozentpunkte mehr!

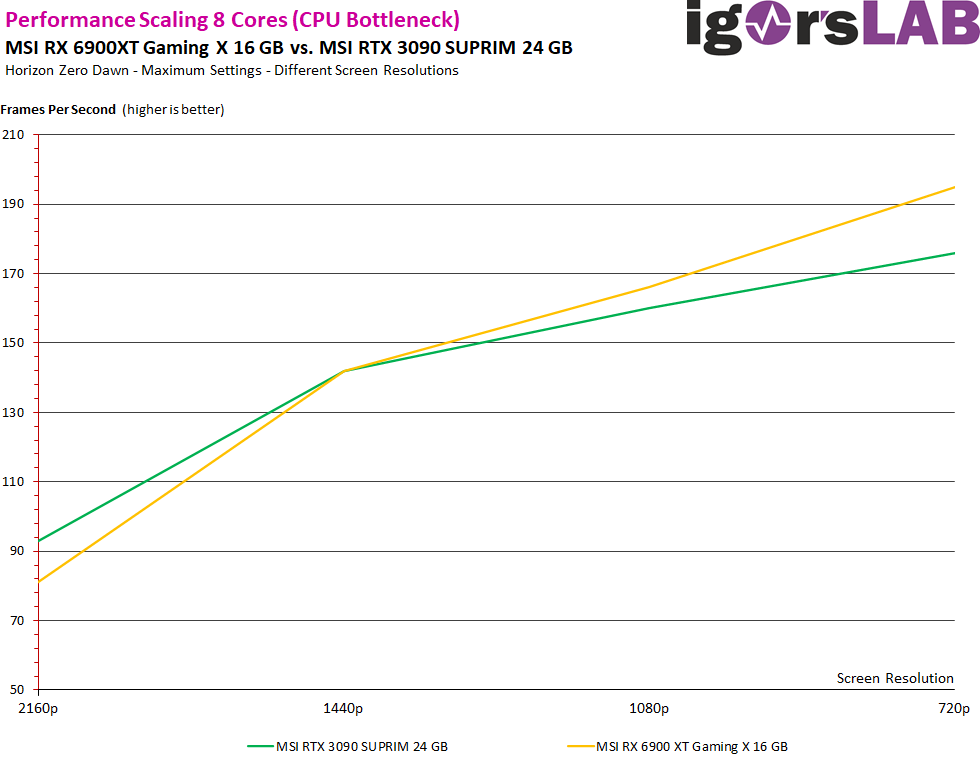

Und was passiert, wenn man beide Karten mit 8 Kernen und 16 Threads laufen lässt? In 2160p liegt die Radeon genauso hinten wie immer, in 1440p herrscht mal wieder Gleichstand und in 1080p führt die Radeon mit immer noch mit 4 Prozentpunkten und in 720p sind es jetzt wieder knapp 11 Prozentpunkte. Es steigen unterhalb 1440p die FPS immer noch leicht an (aber nur noch leicht) und bleiben beim Performancezuwachs aber im nahezu gleichen Verhältnis.

Ein Gegentest mit einem Ryzen 9 5950X samt manueller Übertaktung schafft im Gesamtsystem mit der Radeon RX 6900XT in 720p ganze 4 FPS mehr, mit der GeForce knapp 3 FPS. Auch hier bleibt das Verhältnis in etwa gleich, aber trotz fast 300 MHz mehr Takt gewinnen beide Karten nur noch marginal hinzu.

Zwischenfazit

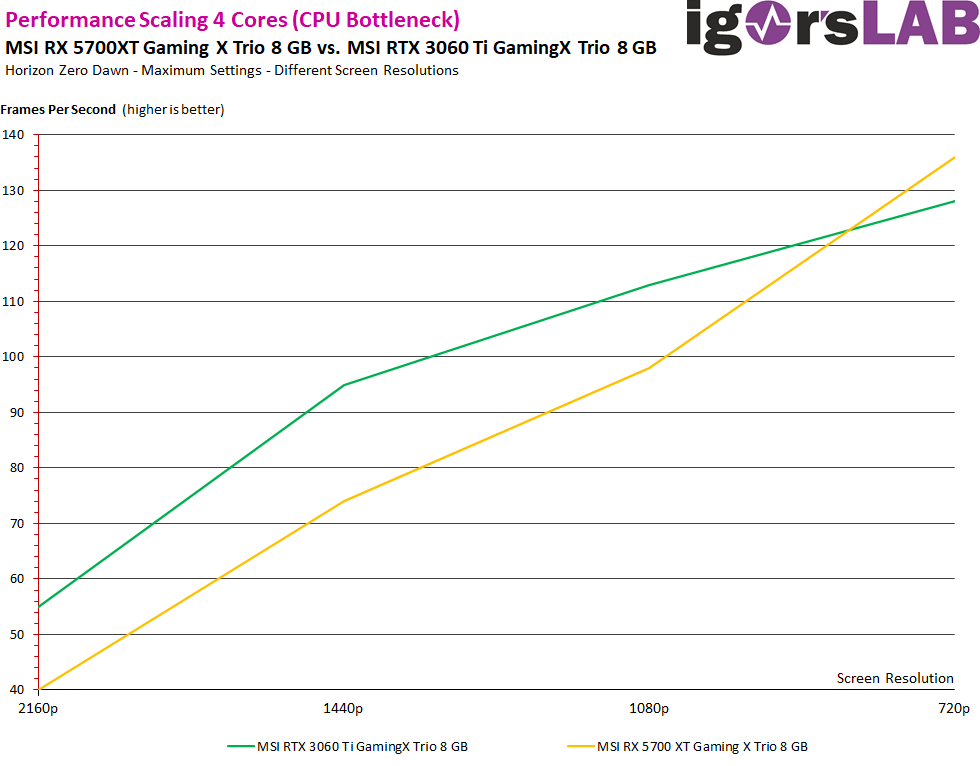

Diese Erkenntnisse hätte ich so nicht erwartet (oder vielleicht doch?) und sie stehen sogar ein klein wenig im Widerspruch zu den Benchmarks der Kollegen von Hardware Unboxed, die zwar das gleiche Phänomen beobachten konnten, aber auch mit verschiedenen Plattformen und älteren Generationen testeten. Eine zum Vergleich getestet, viele schwächere Karte in Form der MSI Radeon RX 5700XT Gaming X Trio war nämlich nicht in der Lage, selbst bei nur 2 oder 4 Kernen die GeForce RTX 3090 zu überholen. So extrem ist es also nicht.

Aber man kommt sich deutlich näher als erwartet. Bei 4 Kernen sind es in 720p nur noch 154 FPS für die GeForce RTX 3090 und immerhin 136 FPS für die Radeon RX 5700XT, die nominell ja Lichtjahre hinter NVIDIAs aktuellem Spitzenmodell liegen müsste. Das sind nur noch 13 Prozentpunkte Rückstand! Mit älteren DirectX11-Titeln lässt sich das Verhalten in dieser Form sowie nicht wirklich nachvollziehen. Und weil es vielleicht interessant sein könnte, habe ich die Radeon RX 5700XT noch einmal mit einer nominell ebenfalls schnelleren MSI RTX 3060 Ti gegengetestet. Der besseren Spielbarkeit halber mit der 4-Kern-Variante:

Wir sehen unterhalb von 1080p, wenn beide Karten wieder in das CPU-Limit laufen, den gleichen Effekt, wo die nominell deutlich langsamere Radeon RX 5700XT plötzlich an der GeForce RTX 3060 Ti vorbeiziehen kann.

143 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Urgestein

1

Veteran

1

Veteran

Urgestein

Urgestein

1

Veteran

Urgestein

Veteran

Urgestein

Veteran

Moderator

1

Veteran

Alle Kommentare lesen unter igor´sLAB Community →