Platinenanalyse und Spannungsversorgung

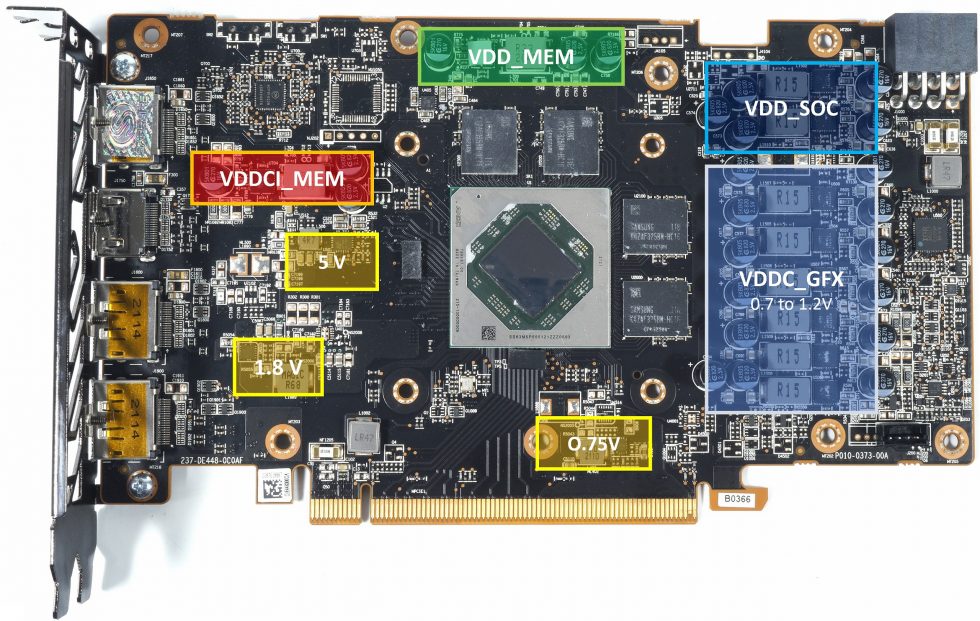

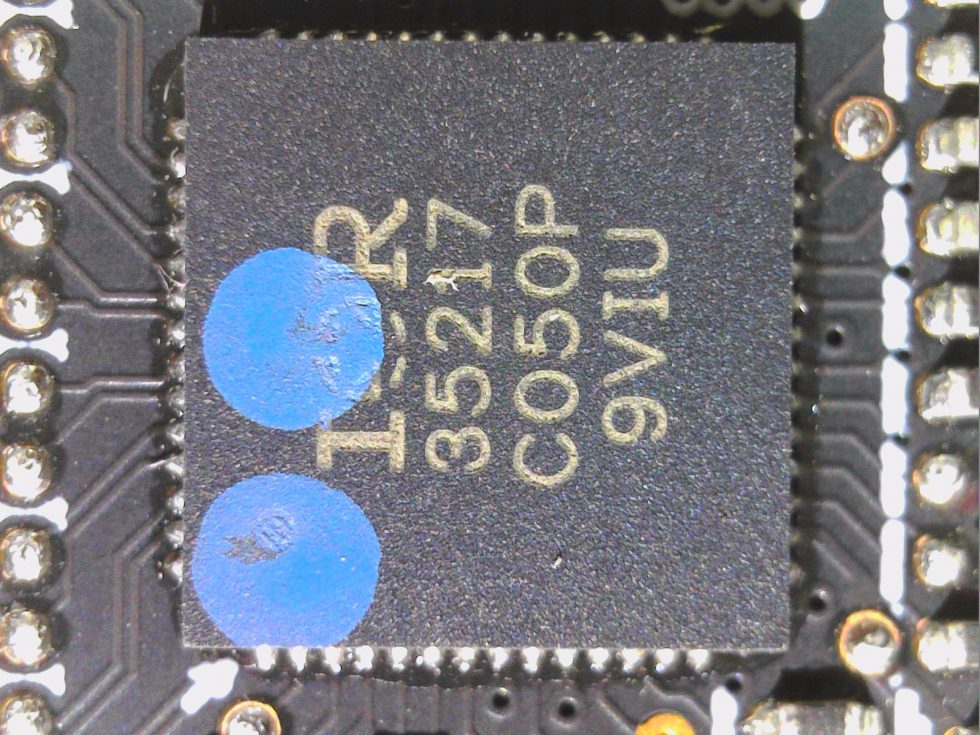

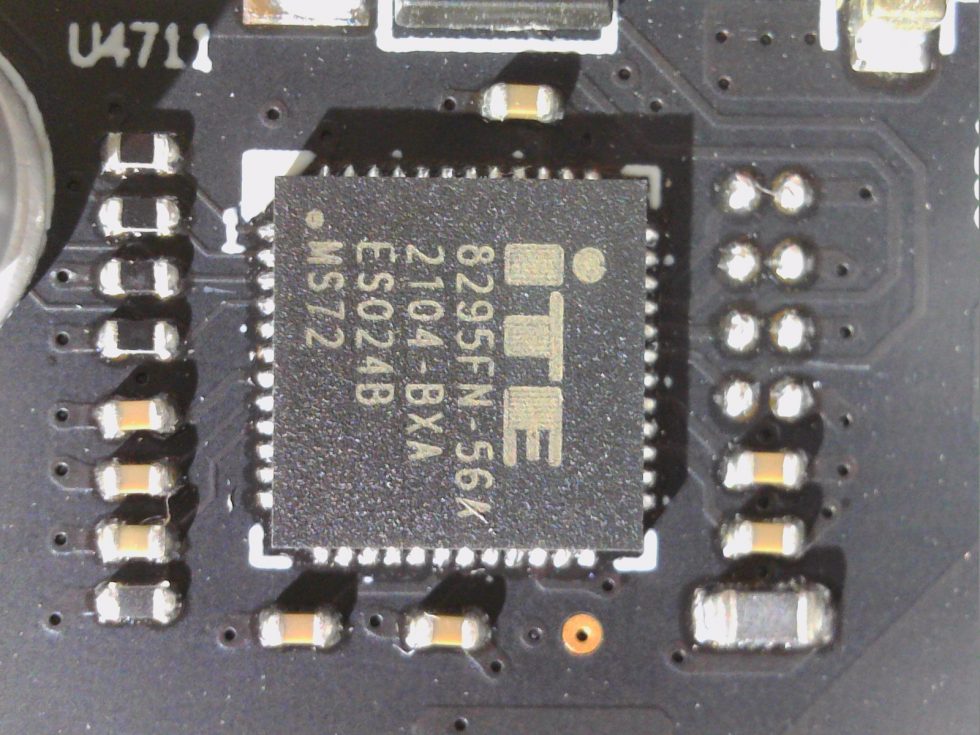

Bei der Platine hat man etwas gespart, sie ist deutlich einfacher gehalten als die der RX 6800 und RX 6700 XT. Gut entzerrte Hotspots sind allerdings auch diesmal ein Pluspunkt, auch wenn man auf die sehr ordentliche Eingangsfilterung mit einem richtigen LC-Filter (Tiefpass) verzichtet und nur auf Längsspulen (Drosseln) und Sicherungen setzt. Mit einem 35217 von International Rectifier setzt Sapphire auf einen eher durchschnittlichen PWM-Controller, der die 6 Phasen für VDDC_GFX der RX 6600 XT ansteuert und die beiden Phasen für VDD_SOC generiert.

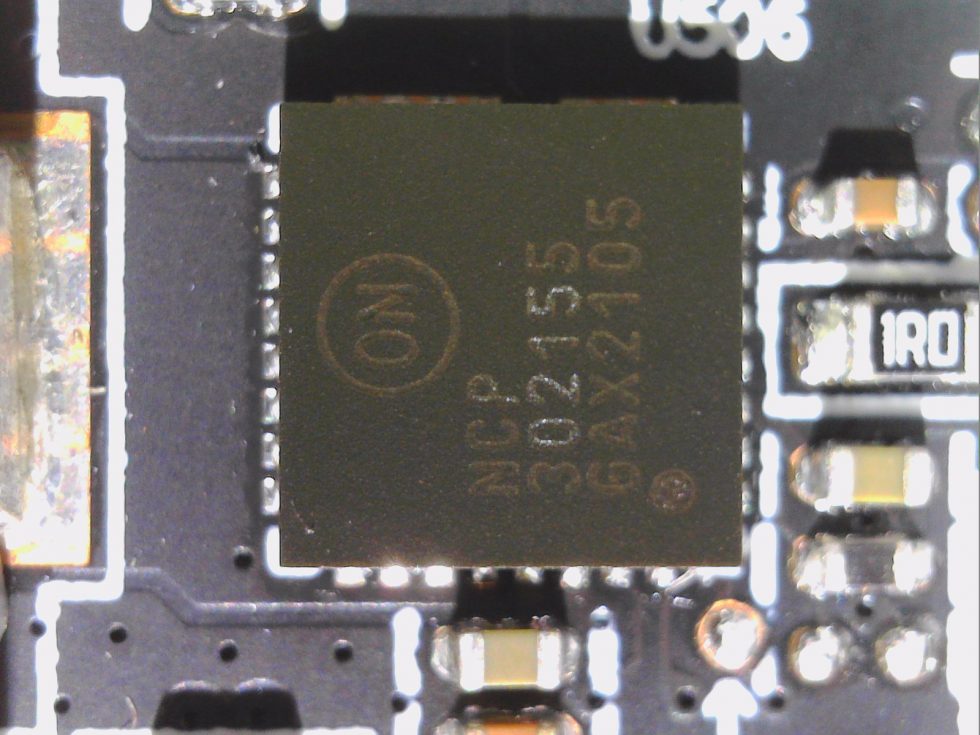

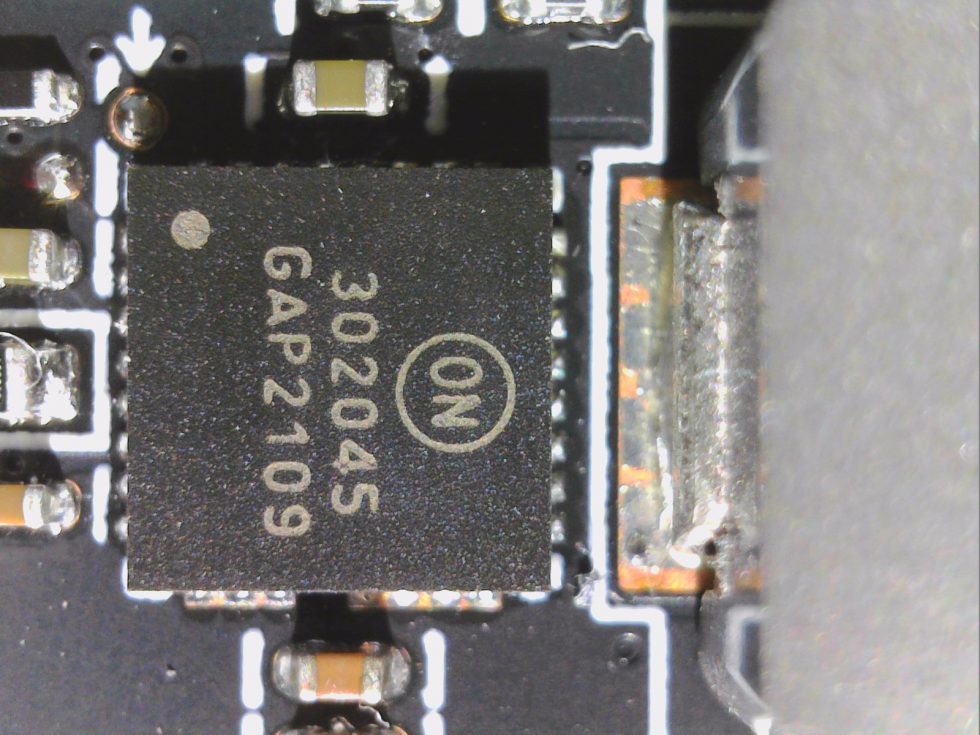

Die eher günstigen DrMOS NCP302155 von ON Semi (55 Ampere max.) bieten zwar keine echte MOSFET DCR, jedoch zumindest eine Temperatur-Schutzschaltung und einen Auslese-Ausgang. Man nutzt sie übrigens für alle Regler bis auf SoC und VDDCI, da kommen etwas kleinere NCP302145 mit 45A zu Einsatz. Der Spannungsspielraum bei VDDC_GFX liegt zwischen 0.7 und maximal 1.2 Volt, wobei der Maximalwert ohne spezielle Firm- und Software vom Endanwender eh nie überschritten werden kann. Das kann man erst einmal so lassen, zumal der DrMOS NCP302155, also die Kombination aus MOSFET Treiber, High- und Low-Side MOSFET in einem Package, auch recht effizient und kühl zu Werke geht.

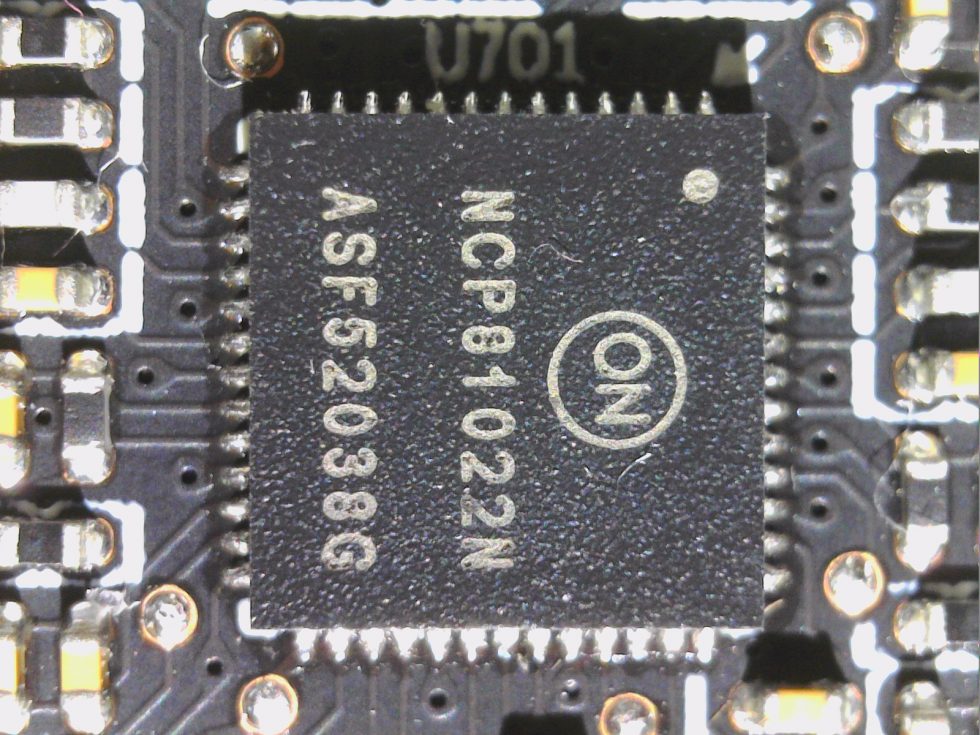

Parallel dazu arbeitet noch ein NCP 81022N von On Semi für die Erzeugung anderen Teilspannungen wie VDD_MEM und eine Phase für VDDCI_MEM, so dass sich in der Summe insgesamt 10 Phasen für die verschiedenen Hauptspannungen ergeben, die allesamt mit den gleichen DrMOS bestückt sind.

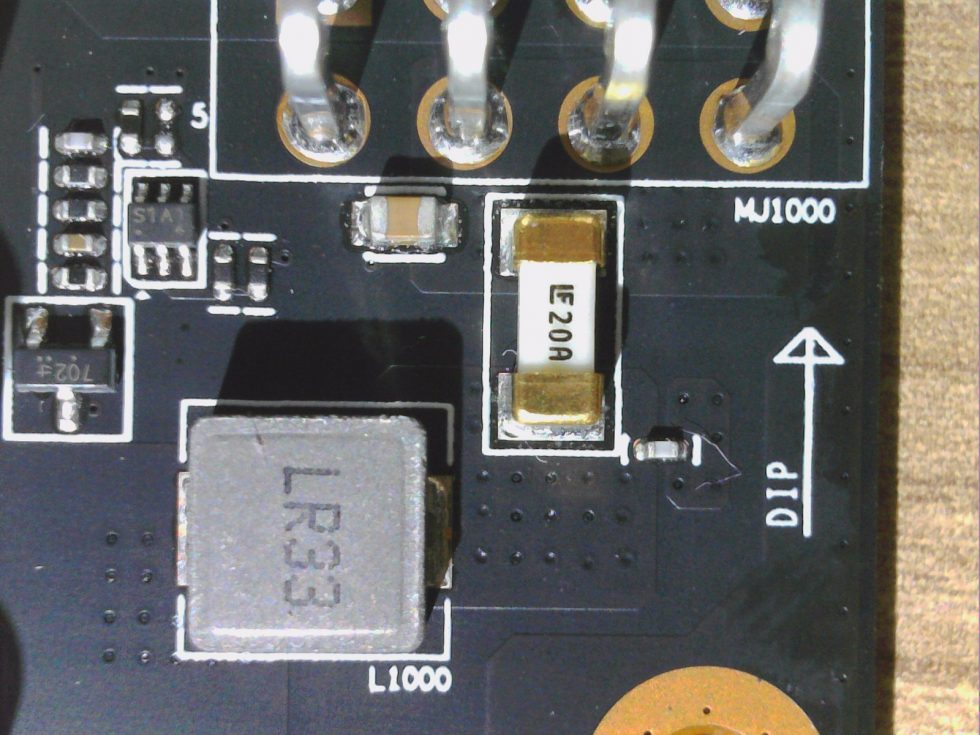

Zur Eingangsglättung nutzt man jeweils eine Spule mit 470 mH für den 8-Pin und den PEG Motherboard-Slot. Außerdem sieht man die vier 2 GB großen GDDR6 Speichermodule mit den 16 Gbps von Samsung. Mehr Aufreger gibt es nicht.

Kühler und Demontage

Die Front wird geprägt von den zwei 8,7-cm-Lüfter-Modulen mit jeweils 8 Rotorblättern, die recht leise agieren. Mehr Besonderheiten gibt es von oben erst einmal nicht zu beobachten. Das Auseinandernehmen ist simpel, wenn man ein paar simple Regeln befolgt und ordentliche Schraubendreher besitzt.

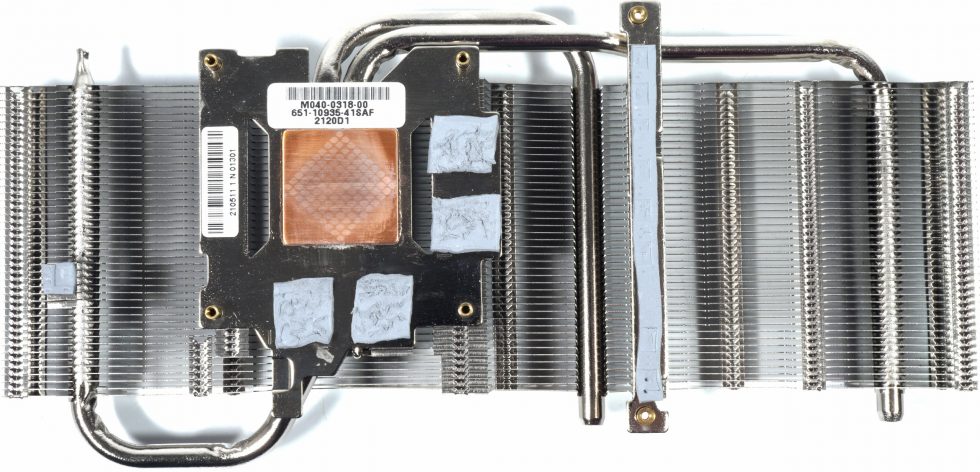

Nach dem Abschrauben der oberen Abdeckung über die Backplate und der GPU-Schrauben lassen sich auch der Kühler und die Abdeckung recht einfach entfernen. Man muss nur das Lüfterkabel abziehen. Die sehr soften Pads auf den Speichermodulen und den VRM erledigen Ihren Job, sind aber nicht aus dem obersten Regal und kleben dafür wie die Hölle. Wir sehen insgesamt drei vernickelte 6-mm-Heatpipes aus Kupfer-Komposit-Material, die oberhalb der GPU am Kupfer-Heatsink angebracht wurden. Der Speicher wird über die 2 mm dicken Pads aus dem eher billigen Regalfach gekühlt, die Spannungswandler am Kühler auch.

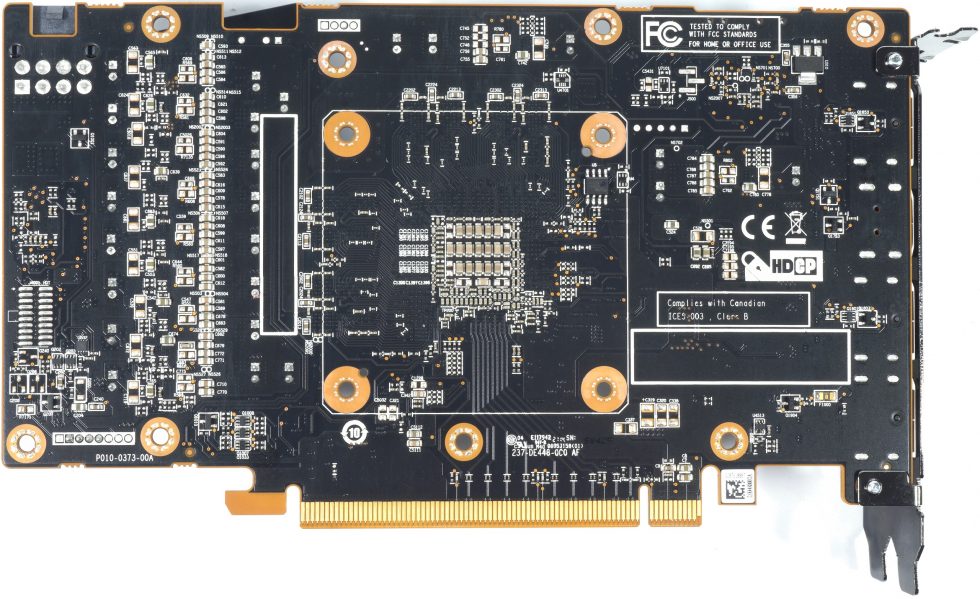

Rückseitig findet man noch eine Backplate aus Leichtmetall, dazu leider keine Pads hinter den Speichern und den Spannungswandlern für eine passive Kühlfunktion. Schade.

- 1 - Einführung und technische Daten

- 2 - Testsystem und Methodik

- 3 - Teardown, Platinenanalyse und Kühler

- 4 - Gaming Performance

- 5 - Leistungsaufnahme und Effizienz

- 6 - Lastspitzen und Netzteilempfehlung

- 7 - Temperaturen und Infrarot-Tests

- 8 - Geräuschemission / Noise

- 9 - Zusammenfassung. Features und Fazit

81 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →