Was lange währt, wird gut? Zumindest materialisiert sich Sapphire Rapids (SPR) nun endlich und man wirbt bei Intel, trotz fast zweijähriger Anlaufzeit, mit eine Reihe neuer Features, die AMDs Ansatz bei Genoa ziemlich konträr gegenüberstehen. Allein über nur die Anzahl der Kerne und die tatsächliche „Rohleistung“ wird Sapphire Rapids mit so viel Anlauf kaum Land sehen, aber wir wollen auch mal emotionslos schauen, wo welcher Hersteller seine Vorteile sieht. In diesem Fall ist das heute mal Intel und es gibt durchaus auch Dinge, wo man sich im blauen Lager ganz vorn sieht und neue Chancen entdeckt.

Ich schrieb ja letztes Jahr bereits über eine möglicherweise sehr geringe Ausbeute, extrem viele Steppings und ein sehr weit auseinander gezogenes Release-Fenster, welches zunächst die High-End-Varianten (XCC-Modelle) vorsieht, während die HBM-Versionen und vor allem die sehr wichtigen MCC-Chips als Mainstream-Lösungen noch hinten anstehen, obwohl sich gerade hier ja der hohe Markanteil Intels begründet. Denn wir dürfen bei aller Launch-Euphorie ja auch nicht vergessen, dass SPR bereist für 2021 avisiert war und Granite Rapids, also der ehemalige Nachfolger bereits für 2022. Und nun haben wir 2023 und es ist endlich so weit.

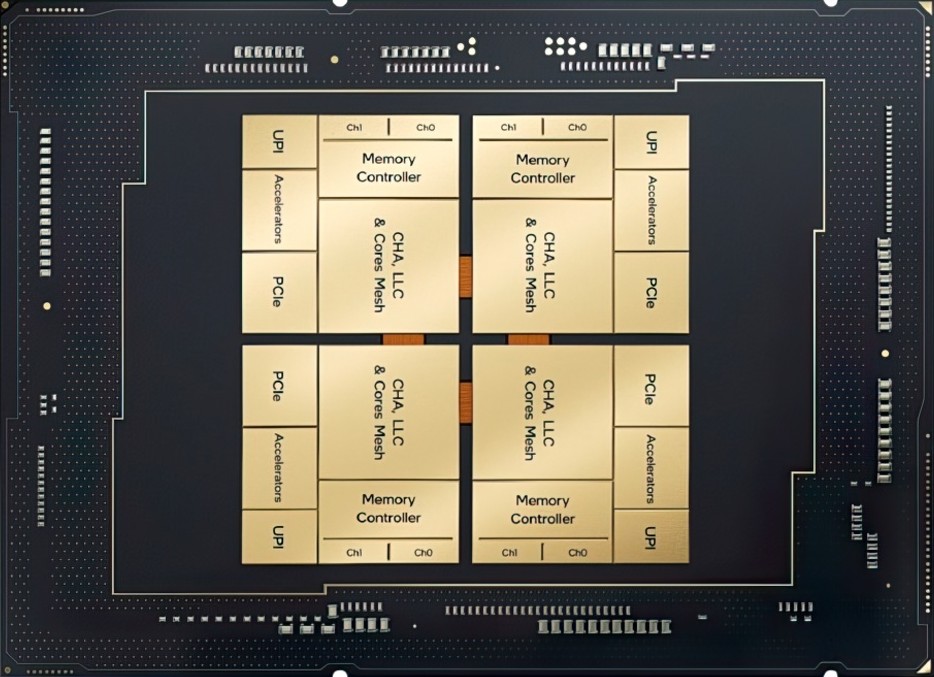

Das variable Chiplet-Design

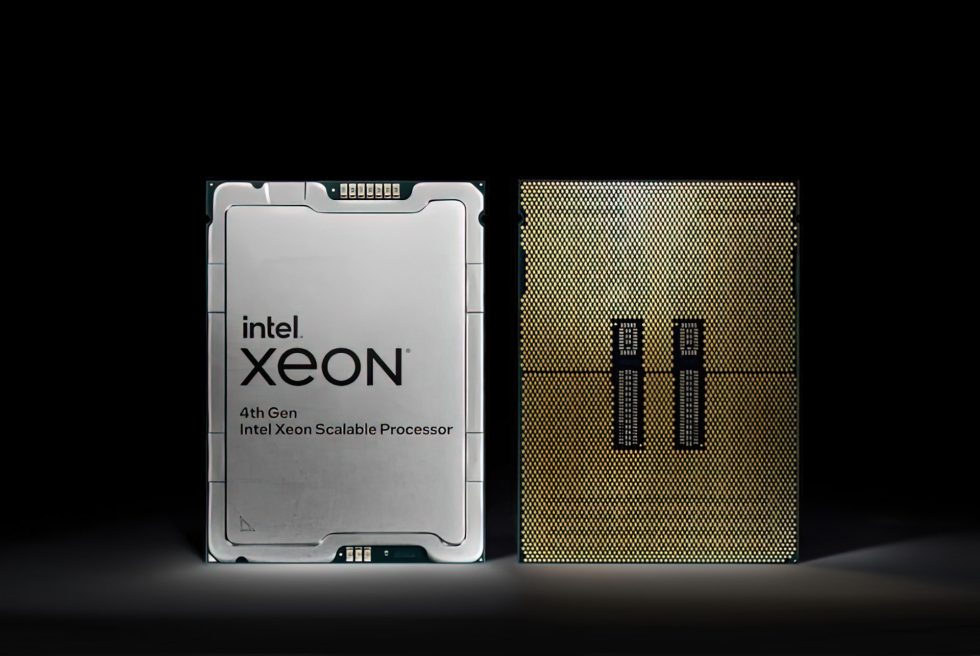

Sapphire Rapids wird auf einem Chiplet-Design mit vier 15-Core-Dies/Tiles basieren, die über Intels modernes EMIB-Interconnect verbunden sind. Man kolportierte bereits 2019 eine Gesamtkernzahl von bis zu 60 Kernen, was zwar eine Premiere für die Serverangebote Intels ist, jedoch auch einen bemerkenswerten Schritt nach vorn darstellt, wenn man es mit Ice Lake-SP vergleicht. Sapphire Rapids ist damit zwar eines der innovativsten Serverdesigns von Intel, aber die sich wiederholenden Verzögerungen haben der CPU durchaus schon geschadet. Sapphire Rapids sollte ja ursprünglich gegen AMDs Epyc Milan Prozessoren antreten, aber aufgrund der Verspätung muss man nun gegen die neuere AMD Genoa-Reihe antreten, was den Wettbewerb sicher nicht einfacher macht.

Dank des MCM-Designs wird Sapphire Rapids endlich wieder größere Margen und höhere ASPs aufweisen, was für Intel und seine Partner in der Lieferkette nominell natürlich auch endlich wieder höhere Gewinne bedeutet. AMDs Epyc Genoa-Prozessoren der 4. Generation bieten mittlerweile sowohl im Single- als auch im Multi-Thread-Betrieb Spitzenleistungen, so dass Intel für direkte, competitive Benchmarks eigentlich nur die teurere HBM-Variante bleibt, die sich ihrerseits aber dann mit Genoa-X, der 3D-V-Cache-Variante von Genoa, messen muss. Auch nicht einfach.

Außerdem ist da ja auch noch ARM, denn die schiere Masse an guten ARM-Designs auf dem Servermarkt ist ein weiterer Grund zur Besorgnis für Intel, da diese Chip-Hersteller oft zu viel niedrigeren Preisen und mit viel höherer Rechendichte verkaufen. Denn Emerald Rapids als Nachfolger war eigentlich für 2023 avisiert und könnte ein ähnliches Schicksal teilen, wenn nichts so perfekt läuft, wie es laufen sollte. Aber da sollte man die Hoffnung nicht aufgeben oder Intel vorschnell abschreiben.

Skalierung als wichtigstes Instrument

Die Leistung pro Kern ist da natürlich so eine Sache, die Skalierbarkeit eine andere. Bei beidem sieht man sich gegenüber AMD aktuell im Vorsprung und man setzt zudem auf ein doch sehr breites breites Einsatzgebiet, welches die vielen Modelle abdecken sollen. Egal, ob mit oder ohne HBM. Und so wird Intel auch nicht verlegen, wenn man das Ganze dann mit „most built-in accelerators in the market“ bewirbt. Es sei Ihnen ja gegönnt. Man muss jedoch Intel in diesem Punkt zugutehalten, dass das Portfolio geradezu von den unterschiedlichsten Modellen überquillt. Doch dazu gleich mehr.

Xeon Slides

Intel sieht sich mehr denn je als Vorreiter eines angepassten und maßgeschneiderten – also fein skalierten – Portfolios, was die tatsächlichen Ansprüche eines Unternehmens erfüllen soll und dabei ökonomisch noch sinnvoll bleibt. So viel zur Theorie von den am schnellsten wachsenden Arbeitslasten in den Bereichen künstliche Intelligenz (KI), Datenanalyse, Netzwerke, Speicher und High-Performance-Computing (HPC). Intel wirbt hier ebenfalls mit seinen vielen integrierten Beschleunigern und einer Zero-Trust-Sicherheitsstrategie.

Man soll leichter und sicherer über mehrere Clouds und Edge-Umgebungen skalieren können und trotzdem flexibel bei der Cloud-Auswahl bleiben und eine reibungslose Anwendungsportabilität geboten bekommen. Die integrierte Beschleunigung ist aus der Sicht Intels also eine alternative, effizientere Methode, um eine höhere Leistung zu erzielen als die reine Erhöhung der CPU-Kernzahl, so wie sie AMD gerade mit Genoa zeigt. Und dann wirbt man in diesem Zusammenhang auch mit mehr Nachhaltigkeit. Intel wirbt zudem auch mit der sehr effizienten Verbindung von CPU Max und GPU Max.

Wie sich das Ganze dann in den Bereichen KI, HPC, Datenanalyse, Netzwerk und Speicher, Verschlüselung und Sicherheit im Detail darstellt, kann man in Intels Folie auch gern noch einmal nachlesen:

01 4th-gen-xeon-scalable-processors-brief

22 Antworten

Kommentar

Lade neue Kommentare

Mitglied

Urgestein

Mitglied

Veteran

Urgestein

Mitglied

Urgestein

Urgestein

Veteran

Urgestein

Veteran

Urgestein

Veteran

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →