Mit der NVIDIA RTX A5000 habe ich heute eine Workstation-Grafikkarte im Test, die nicht nur die Vorgängerin RTX 5000 locker ersetzen soll, sondern die in manchen Bereichen sogar die RTX 6000 noch ärgern kann. Dazu kommen natürlich die neuen Features, die Ampere gegenüber Turing bietet, sowie diverse Feinheiten, durch die es laut NVIDIA mehr als nur ein effizienteres Replacement sein soll. Genau deshalb werde ich die RTX A5000 auch in verschiedenen Workloads testen und nicht nur bei reiner Rastergrafik.

NVIDIA bietet bei der RTX A5000 (analog zur RTX A6000) zudem mit NVLink eine 112 GB/s schnelle Grafikprozessor-Zusammenschaltung, die eine wesentlich schnellere Alternative für Multi-GPU-Systeme darstellt als herkömmliche, auf PCI-E basierende Lösungen. Durch die Verschaltung zweier NVIDIA -Grafikkarten mit NVLink lassen sich Speicherplatz und Leistung elegant skalieren, um den Anforderungen an große visuelle Rechenaufgaben gerecht zu werden.

Die RTX A5000 kann zudem NVIDIA RTX Virtual Workstation-Software (vWS) nutzen, was Raum fürs Visual Computing bietet und damit die Leistung virtueller Workstations aus dem Rechenzentrum oder der Cloud auf jedem Gerät nutzbar machen kann. So lassen sich auf dem Niveau einer physischen Workstation selbst die anspruchsvollsten Anwendungen auf jedem Gerät nutzen und dabei gleichzeitig die nötigen Sicherheitsanforderungen erfüllen. Die IT kann jede Anwendung vom Rechenzentrum aus virtualisieren und damit auch lokal ein Arbeitsumfeld schaffen, das von einer physischen Workstation nicht zu unterscheiden ist. So bietet jedes am Ende jedes Gerät die gleiche Leistung wie eine Workstation.

Hier handelt es sich also um ein Feature, um in einer virtuellen Umgebung eine Grafikkarte an mehrere Benutzer faktisch „portionsweise“ aufzuteilen. Man verteilt an die VMS die passenden Profile, in denen die zugeteilten Ressourcen geregelt sind. Allerdings ist dieses Produkt Lizenz-pflichtig und es müssen dafür, gerade im VMware Umfeld, auch Enterprise Plus Lizenzen vorhanden sein. Außerdem benötigt man spezielle Nvidia Treiber, die nur mit passendem Account gibt. Die vGPU funktioniert nicht ohne den Lizenz Server, womit sich der administrative Aufwand auch erhöht.

Unboxing, Optik, Haptik und Konnektivität

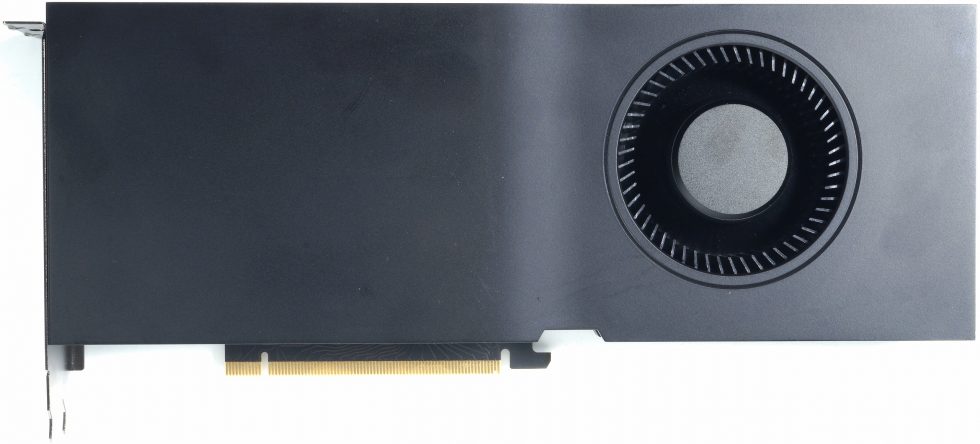

Die Karte wiegt 1013 Gramm und ist damit sogar fast 100 Gramm leichter als AMDs Radeon Pro W6800 und somit auch kein wirkliches Schwergewicht. Sie ist mit ihren üblichen 27 cm gut einbaubar, ist 10,5 cm hoch (Einbauhöhe ab PEG) und dazu 3.5 cm dick (Dual-Slot-Design), wobei hier keine Backplate zum Einsatz kommt, da auch rückseitig kein Speicher verbaut wurde. Die insgesamt 12 Module GDDR6 mit ECC Funktionalität sitzen alle auf der Frontseite, was designtechnisch eine interessante Lösung darstellt.

Versorgt wird die Karte mit einer TBP von bis zu 230 Watt über eine standesübliche 8-Pin-Buchse, es bleibt also alles wie bekannt und erwartet. Interessanterweise sieht man auf der Platine noch die freien Lötaugen für zwei 8-Pin-Buchsen am rechten Ende des oberen Randes der Platine. Auch NVIDIA setzt wie gewohnt auf das DHE-Prinzip (Direct Heat Exhaust) für die Kühlung und einen recht potenten, aber nicht allzu lauten 6,5-cm-Radiallüfter. Die angesaugte Luft verlässt also das Gehäuse auf direktem Weg an der Rückseite, was wirklich zweckmäßig ist.

Die Slot-Blende ist mit einem Wabengitter für den Luftaustritt versehen und trägt vier DisplayPort-Buchen (1.4) nebeneinander. Das schafft Platz, damit die heiße Abluft auch wirklich gut entweichen kann.

Technische Daten

Mit den insgesamt 8.192 CUDA Cores (nach NVIDIAs Zählweise) des GA102-850 lassen sich bereits größere Workflows bewältigen und die Karte ist nur unwesentlich mehr beschnitten als eine GeForce RTX 3080 mit 8704 CUDA Cores. Mit insgesamt 256 Tensor Cores, 64 RT Cores, 256 TMUs und 96 ROPs setzt die Karte mit dem beschnittenen GA 102 auf insgesamt 64 Streaming Multiprocessors (SM), die bei Ampere ja komplett neu gestaltet wurden. Die Basis mag noch ähnlich der von Turing sein, aber es haben sich wichtige und vor allem entscheidende Dinge geändert.

Die SM haben eine wirklich große Wandlung vollzogen, die letztendlich auch in der gesteigerten Leistung resultiert. Ein einzelner SM bei Turing bestand noch aus 64 FP32-ALUs für die Gleitkomma-Berechnungen sowie 64 INT32-ALUs für Ganzzahl-Berechnungen, aufgeteilt in vier Blöcke zu je 16 FP32- und 16 INT32-ALUs. Der Trick dabei: die FP- und die INT-ALUs können gleichzeitig angesprochen werden. Und Ampere? Die 64 reinen FP32-ALUs pro SM bleiben weiterhin erhalten, aber die 64 INT32-ALUs stockt man um 64 weitere auf, die nach wie vor auch wahlweise Floating-Point- und zusätzlich Integer-Berechnungen durchführen können, mit einer Einschränkung: das geht nun nicht mehr parallel. Die Aufteilung in jeweils 4 Blöcke bleibt erhalten, jedoch mit einem getrennten Datenpfad.

Während der Basistakt mit 1170 MHz angegeben wird, liegt der Boost-Takt bei bis zu 1695 MHz, der jedoch in der Praxis unter absoluter Volllast nicht immer erreicht wird. Die Karte setzt auf satte 24 GB GDDR6 mit 16 Gbps, die sich aus 12 Modulen mit 2 GB Größe auf der Vorderseite der Platine ergeben. Dazu gehören auch das 384-Bit Speicherinterface (768 GB/s Bandbreite).

nvidia-rtx-a5000-datasheet

- 1 - Einführung und technische Details

- 2 - Testsystem und Methodik

- 3 - Teardown: PCB und Kühler

- 4 - AutoCAD 2021

- 5 - Solidworks 2021 (No FSAA)

- 6 - Solidworks 2021 (FSAA Enabled)

- 7 - Inventor Pro 2021

- 8 - 3ds Max, Catia,Creo, Energy

- 9 - Maya, Medical, Siemens NC, SW 2017

- 10 - DirectX 11, DirectX 12, Vulkan, OpenGL und DXR

- 11 - AI und Compute

- 12 - Rendering

- 13 - Leistungsaufnahme, Spannungen und Normeinhaltung

- 14 - Lastspitzen und Netzteil-Empfehlung

- 15 - Taktraten, Temperaturen, Lüfter und Lautstärke

- 16 - Übersicht, Zusammenfassung und Fazit

29 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

1

1

Urgestein

Urgestein

1

Veteran

Veteran

Urgestein

1

1

Urgestein

Veteran

Veteran

Veteran

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →