Teardown

Das Gehäuse bzw. der massive Gehäusedeckel als Träger wurde mittels Aluminiumdruckguss gefertigt und lässt sich relativ leicht abnehmen, wenn man über die zwei passenden Torx-Schraubendreher verfügt. Auch die Slotblende sollte enfernt werden, damit sich die Platine später leichter entnehmen lässt. Aber über die Wertigkeit der Lösung muss man nicht viel schreiben, die ist optisch und haptisch schnell begründet.

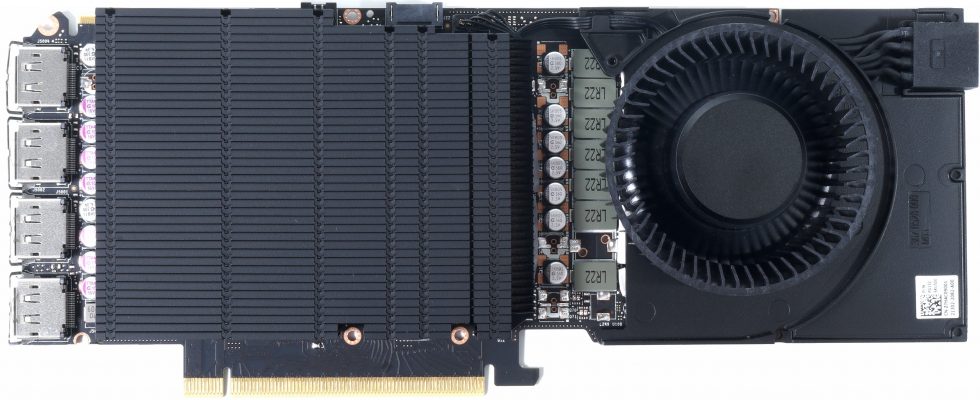

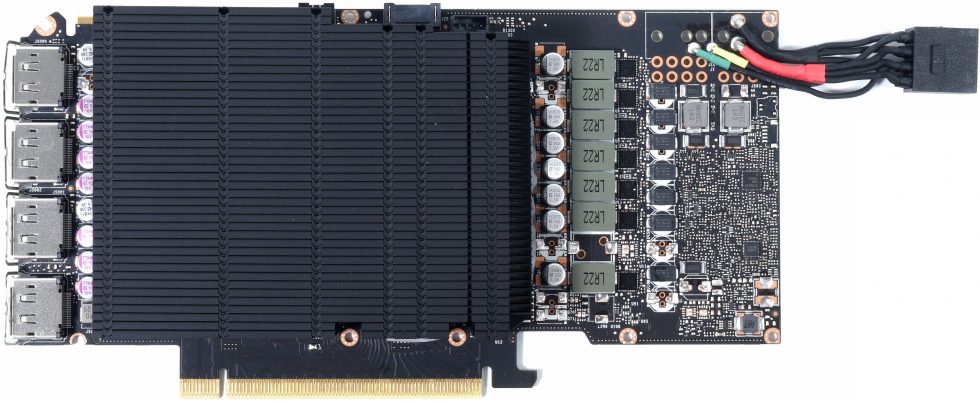

Darunter liegt die Platine, auf der sowohl der Kühler über vier Schrauben samt Spannkreuz, als auch das Lüftermodul befestigt wurden. Das Lüftermodul, dessen Trägerplatte ebenfalls aus Leichtmetall besteht, überdeckt dabei allerdings die Lötbereiche für die beiden 8-Pin-Buchsen, so dass man hier auf eine separate Buchse am Kartenende setzt, die mit Klebeband am Lüftermodul leicht fixiert wurde.

Das Lüftermodul mit dem 6.5-cm-Lüfter ist schnell entfernt und gibt dann den Blick auf die Platine frei, die in diesem Bereich keine höheren Bauelemente aufweist. Das ist so eine Art Sokoban für Erwachsene und wir sehen auch, dass die Längsdrosseln der beiden zusammengeschalteten Eingänge ebenfalls sehr flach ausfallen. Die rechte Spannungswandler-Reihe wird somit direkt von Lüftermodul mitgekühlt, während der Rest dann unter dem eigentlichen Kühler sitzt. Das ist eine recht interessante, aber sehr wirkungsvolle Lösung.

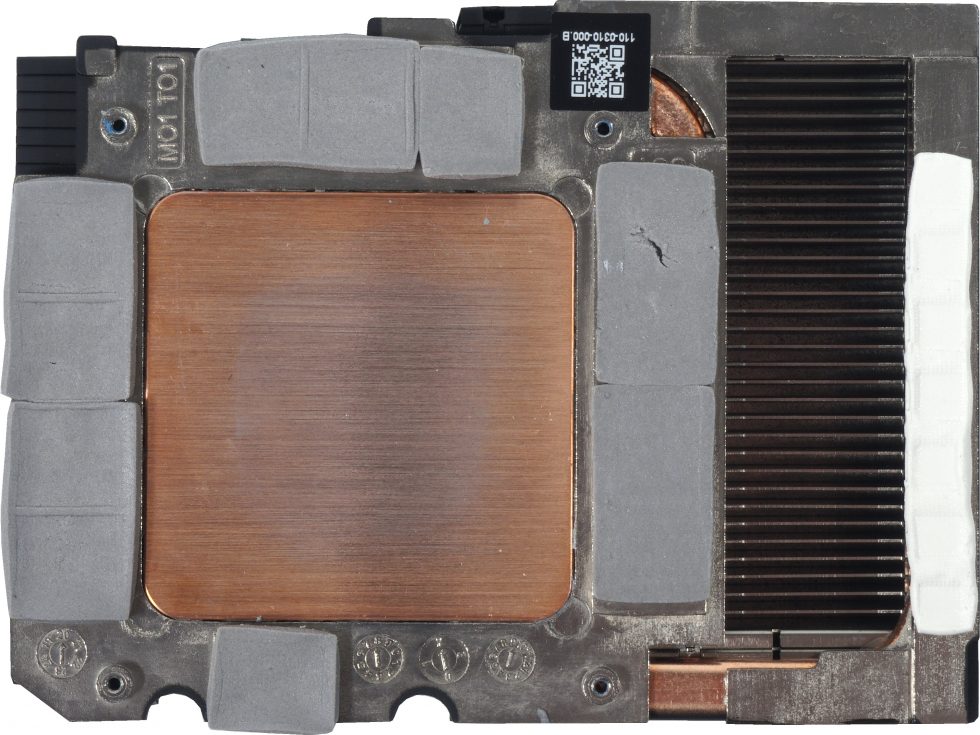

Der Kühler setzt auf einen großen, stark angeschliffenen Kupfer-Heatsink sowie umlaufende Heatpipe-Elemente für den Transport der Abwärme von der linken Spannungswandler-Reihe zum Kühlblock (hier spiegelverkehrt und deshalb rechts sichtbar unter dem hellen Wärmeleitpad) und der insgesamt 12 Speichermodule. Kompakt, aber wirkungsvoll, denn hier werden immerhin um die 200 Watt abgeführt. Die ca. 10 bis 15 Watt Platinenverluste und die Spannungswandler unter dem Lüfter zählen dann extra.

Platine und Spannungsversorgung

Die Platine ist recht interessant und deckt sich mit keiner Platine der Consumer-Karten wirklich genau. Sie ähnelt noch am ehesten der Referenzplatine der GeForce RTX 3080, aber es gibt durchaus Unterschiede im Detail und bei der Aufteilung Spannungsversorgung. Man hat hier auf 21,2 cm Länge ein Menge untergebracht und die Superposition zeigt auch, dass z.B. ein Wasserblock, der auf eine Referenzplatine der GeForce RTX 3080 passt, hier ebenfalls passen könnte, wenn die Leave-Out-Areas sauber umgesetzt wurden.

Die Karte basiert auf dem bereits erwähnten PG132 Referenz-Design, einer 12-Layer-Platine mit Backdrill-Verfahren, wurde aber modifiziert. Die Zweiteilung der Hauptspannungsversorgung wurde beibehalten. NVVDD steht für die herkömmliche Core-Voltage, also das, was wir gern als GPU- Spannung bezeichnen. Hier sind es insgesamt acht einzelne Phasen (eine weniger als bei der FE), die von einem uP9512R von UPI Semiconductor auf der Rückseite bereitgestellt werden. Hier handelt es sich um einen digitalen PWM-Controller mit VID-Interface, kompatibel zu NVIDIAs Open VReg Spezifikation. Diese Phasen werden jeweils mit etwas günstigeren 50-A Powerstages AOZ5239QI von Alpha & Omega bestückt, die keine echte MOSFET DCR ermöglichen, jedoch eine Temperatur-Schutzschaltung und einen Auslese-Ausgang bieten.

Die Bestückung der zweiten GPU-Spannungsversorgung MSVDD, die ich als “Gedönsspannung” bezeichnet hatte und die für “Miscellaneous” steht, ist sehr ähnlich aufgebaut. Wir finden insgesamt vier einzeln angesteuerte Phasen, die von einem RT8845A erzeugt werden. Die Powerstages sind AOZ5311NQI, etwas stärkere 55A-Modelle von A&O. Am Ende ergeben sich also 11 Phasen allein für die GPU und die verschiedenen Spannungen zur selbigen. Damit sollte auch das Power-Gating in der GPU etwas einfacher werden, wobei AMD mit VDDCI ja eine ähnliche, wenn auch viel kleinere Auslagerung nutzt. Der Spannungsspielraum beider Bereiche liegt zwischen 0.7 und maximal 1.2 Volt, wobei der Maximalwert ohne spezielle Firm- und Software vom Endanwender nie erreicht werden kann. Wichtig ist hingegen der Minimalwert, so dass es fürs Untervolting technische Grenzen gibt, die jedoch NVIDIA für alle so vergibt.

Für den Speicher nutzt NVIDIA zwei Phasen, die ebenfalls auf die bekannten Power Stages von Alpha & Omega setzen. Der PWM-Controller (RT8845A) befindet sich jedoch auf der Vorderseite Die Power Stages der PCI-Express-Spannung PEXVDD und der 1,8 Volt befinden sich samt der dazugehörigen Spulen vorn auf der Frontseite. Das Kondensator-Six-Pack auf der Unterseite des BGA enthält zwei MLCC-Kombinationen und vier SP-CAPs, reicht. Zur Eingangsglättung nutzt man drei Spulen mit jeweils 1 µF hinter denen ein Shunt liegt, über dessen Spannungsabfall man mittels eines uS5650 von UPI die fließenden Ströme misst.

- 1 - Einführung und technische Details

- 2 - Testsystem und Methodik

- 3 - Teardown: PCB und Kühler

- 4 - AutoCAD 2021

- 5 - Solidworks 2021 (No FSAA)

- 6 - Solidworks 2021 (FSAA Enabled)

- 7 - Inventor Pro 2021

- 8 - 3ds Max, Catia,Creo, Energy

- 9 - Maya, Medical, Siemens NC, SW 2017

- 10 - DirectX 11, DirectX 12, Vulkan, OpenGL und DXR

- 11 - AI und Compute

- 12 - Rendering

- 13 - Leistungsaufnahme, Spannungen und Normeinhaltung

- 14 - Lastspitzen und Netzteil-Empfehlung

- 15 - Taktraten, Temperaturen, Lüfter und Lautstärke

- 16 - Übersicht, Zusammenfassung und Fazit

29 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

1

1

Urgestein

Urgestein

1

Veteran

Veteran

Urgestein

1

1

Urgestein

Veteran

Veteran

Veteran

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →