Spiele-Performance

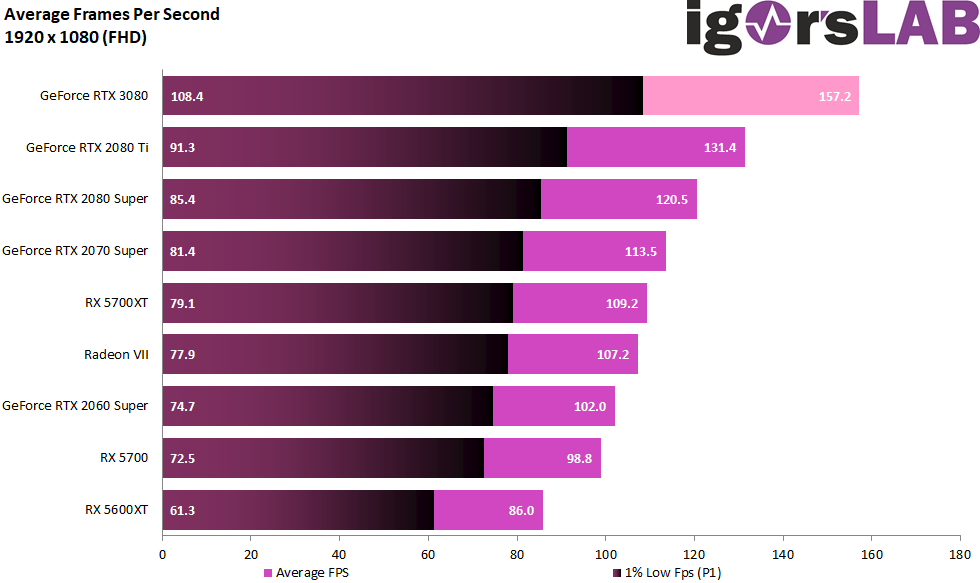

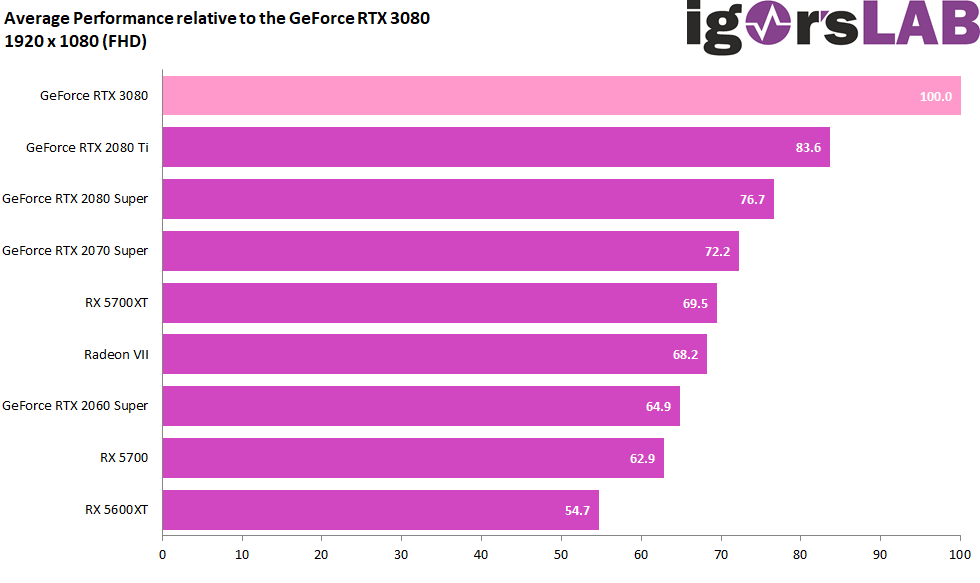

In den nachfolgenden Ergebnisübersichten habe ich einerseits die durchschnittlichen FPS aller Karten und in allen Spielen kumuliert sowies dies dann noch prozentual berechnet und gegenübergestellt. Insgesamt 10 Spiele in drei Auflösungen habe ich getestet, um dann am Ende doch die Full-HD-Auflösung bei den ganzen Einzelbenchmarks wegzulassen. Der Grund ist schnell erklärt, denn weder der wassergekühlte und auf 4.5 GHz übertaktete Ryzen 9 3900XT, noch der auf 5 GHz laufende und ebenfalls bestens gewässerte Intel Core i9-10900K waren durchgängig in der Lage, diese Grafikkarte nicht zu limitieren. In manchen Spielen hatte die Intel-CPU die Nase leicht vorn, in anderen war es eher ein gemeinsames Versagen. Da ich mir auf diese Weise 240 Grafiken sparen kann, ich aber trotzdem ja alles gebenchmarkt habe, stelle ich diese Werte nun wenigstens am Schluss noch mit auf die Zusammenfassung-Seite.

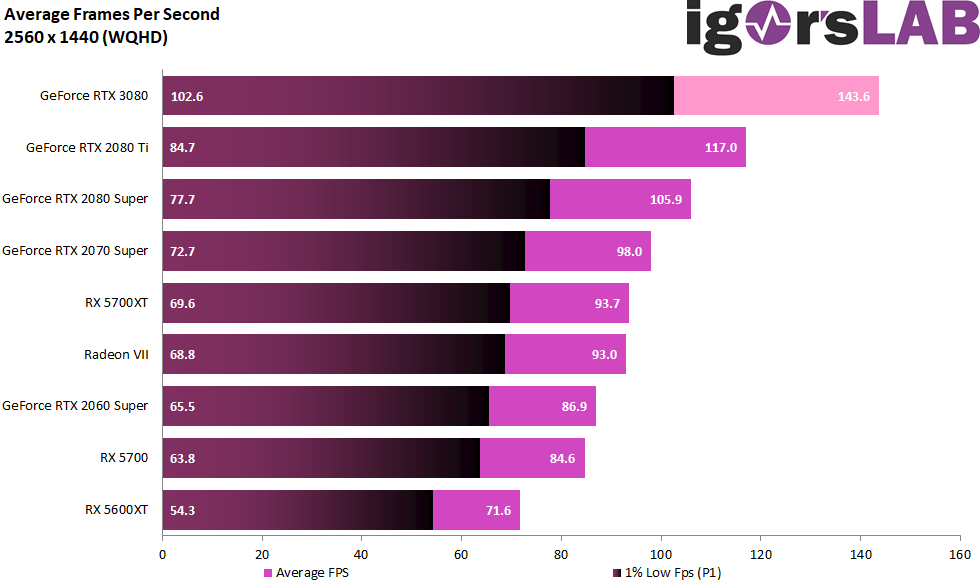

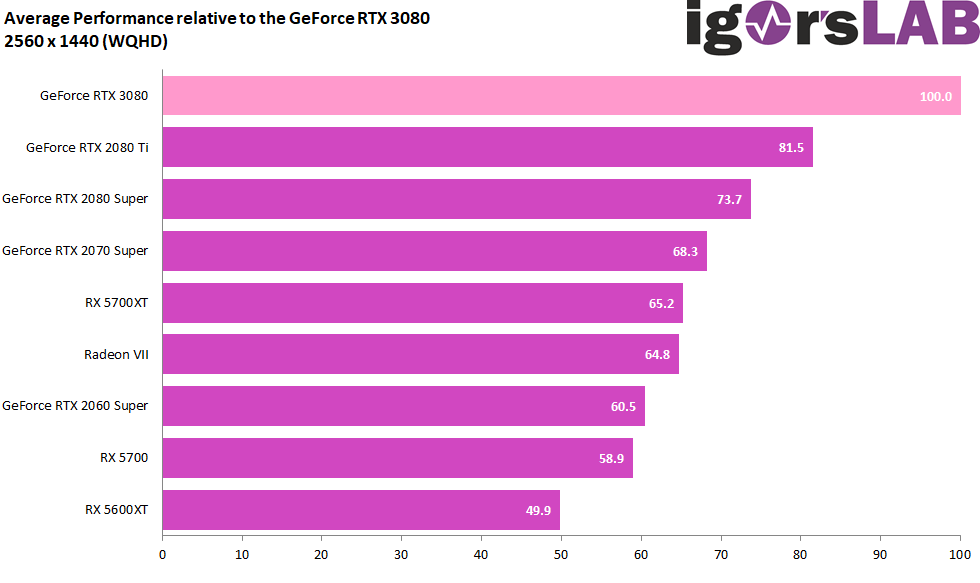

In WQHD zieht die GeForce RTX 3080 leicht an und der Vorsprung vergrößert sich leicht.

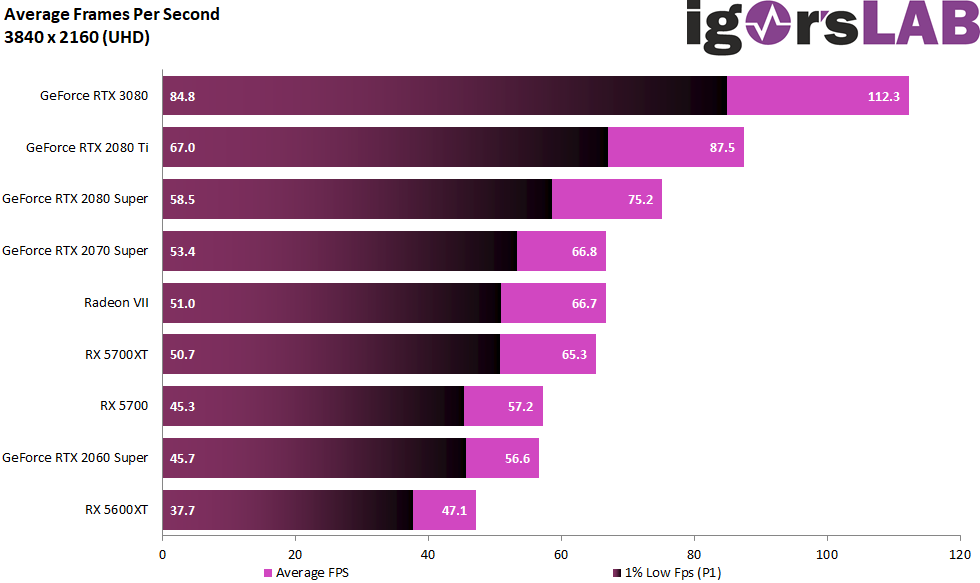

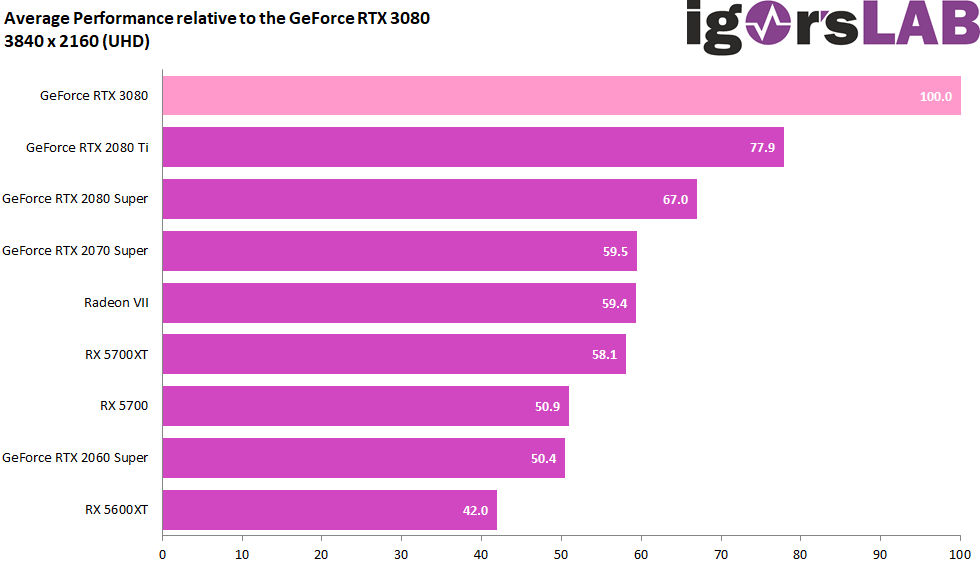

In Ultra-HD geht dann die Post ab und wir dürfen nie vergessen, dass dies kein Cherry-Picking ist, sondern sich in jeder Situation Spiele in der Auswahl befinden, die die Schönwetterfront leicht durchbrechen können.

Zusammengefasst: Es soll ja keine Werbeverkaufsveranstaltung werden, sondern ein möglichst objektiver und fairer Test, auch wenn die Ergebnisse trotzdem so solide sind, dass man im Gaming-Bereich schon etwas mit dem Haben-Wollen-Faktor kämpfen muss. Vor allem bei höheren Auflösung ist diese Karte ein echtes Brett, denn auch wenn der Vorsprung zur GeForce RTX 2080 Super nicht immer hoch zweistellig ausfällt, so reicht es doch immer, quasi die nächste Qualitätsstufe bei der Spielbarkeit zu erreichen. Rechtsanschlag vieler Qualitätsregler inbegriffen. Besonders dann, wenn die Spiele der GeForce RTX 3080 und der neuen Architektur liegen, sind auch schon mal bis zu 80% Steigerung gegenüber der RTX 2080 Super drin und eine RTX 2080 Ti wird mit fast 40% geschlagen. Auch das muss man anmerken, wenn man fair bleiben möchte. Aber es ist erst der Anfang und nicht pauschal bei den Spiele-Engines einklagbar, leider.

Zusammengefasst: Es soll ja keine Werbeverkaufsveranstaltung werden, sondern ein möglichst objektiver und fairer Test, auch wenn die Ergebnisse trotzdem so solide sind, dass man im Gaming-Bereich schon etwas mit dem Haben-Wollen-Faktor kämpfen muss. Vor allem bei höheren Auflösung ist diese Karte ein echtes Brett, denn auch wenn der Vorsprung zur GeForce RTX 2080 Super nicht immer hoch zweistellig ausfällt, so reicht es doch immer, quasi die nächste Qualitätsstufe bei der Spielbarkeit zu erreichen. Rechtsanschlag vieler Qualitätsregler inbegriffen. Besonders dann, wenn die Spiele der GeForce RTX 3080 und der neuen Architektur liegen, sind auch schon mal bis zu 80% Steigerung gegenüber der RTX 2080 Super drin und eine RTX 2080 Ti wird mit fast 40% geschlagen. Auch das muss man anmerken, wenn man fair bleiben möchte. Aber es ist erst der Anfang und nicht pauschal bei den Spiele-Engines einklagbar, leider.

Es ist auch genau der Zuwachs, denn man z.B. beim Spielen in Ultra-HD schon immer eingefordert hat. Bitte schön, hier ist eine Offerte dafür. Dass der RAM mit seinen 10 GB spätestens in Ultra-HD dann aber ab und an schon mal knapp werden könnte, liegt in der Auslegung durch NVIDIA und auch an vielen Spieleherstellern, die mit daten genau das zumüllen, was zuzumüllen geht. Was natürlich keine pauschale Entschuldigung und somit auch der einzige Kritikpunkt wäre. Das Doppelte hätte es schon sein dürfen, Preispunkt hin oder her.

Abhilfe schafft da in jedem Fall DLSS 2.0, denn das, was man mit DLSS bei NVIDIA vorgelegt hat, ist fast schon eine Art Wunderwaffe, solange es denn implementiert ist. Da sind natürlich auch die Spielehersteller gefragt, so dass man sich bei NVIDIA natürlich auch nicht darauf verlassen sollte. Das gilt im Übrigen auch für den inflationären Einsatz der fordernden Raytracing-Features. Weniger ist mehr und wenn es zweckmäßig implementiert wird, dann muss auch keine Karte nach Luft schnappen. In Kombination mit DLSS und Brain 2.0 ist das Gesamtpaket sicher zukunftsweisend, wenn man denn auf solche Dinge steht. Schöner sterben kann Spaß machen, vor allem dann, wenn es nicht mehr in Zeitlupe geschieht.

Und für die Schnellklicker gibt es ja auch noch NVIDIA Reflex. Vorausgesetzt man besitzt eine Ampere-Karte, einen geeigneten G-Sync-Monitor und ein Spiel, wo das Feature im Spiel integriert ist. Dann kann man die Systemlatenzen durchaus noch minimieren. Dazu hatte ich ja unlängst auch einen längeren einen Artikel. Der Reflex Low Latency-Modus in Spielen wie Valorant oder Apex Legends ist durchaus eine Offerte, aber es wird sich noch durchsetzen müssen. Und dann sind ja auch noch dien fiesen Latenzen im Internet, für die NVIDIA nichts kann, die einem aber den Erfolg schon mal verhageln können. Nur ist die Summe immer kleiner, wenn man wenigsten den Haufen abträgt, der vor der eigenen Tür liegt. Das bringt oft auch schon was. Siehe Artikel.

Aber der mündige Kunde hat ja eh immer was zu meckern (was übrigens gut ist und die Anbieter schön auf Trab hält) und man hält sich bei NVIDIA auf diese Art und Weise im Gegenzug alle Optionen offen, eine eventuelle Navi2x-Karte mit 16 GB Speicherausbau später dann noch einmal mit 20 GB toppen zu können. Und erinnert sich noch wer an die geheimnisvolle SKU20 zwischen der GeForce RTX 3080 und RTX 3090? Falls es AMD diesmal nicht wieder versemmelt, wird diese SKU20 sicher noch zum Tie-Break beim Pixel-Tennis. Abwarten.

Anwendungsperformance und Studio

Insgesamt 17 Benchmarks und viele Stunden später kann man in diesem Bereich fast noch mehr Begeisterung aufbringen als es ein Nur-Gamer vielleicht nachvollziehen kann. Denn immer dann, wenn es um FP32-Berechnungen geht und man z.B. beim finalen Rendern jedes Mal der Rente ein Stück näher zu kommen glaubt, ist die RTX 3080 ein Spielverderber im positiven Sinne. Teilweise wird sogar eine Quadro-RTX 600 dermaßen deklassiert, dass man sich fragen muss, welchen Film man gerade sieht. Apropos Film, der NvEnc macht das leben ja schon seit Turing leichter, aber wenn die ganzen Postprocessing-Filter jetzt auch noch ordentlich Beine gemacht bekommen, dann reicht die Zwangspause am Schneidetisch noch nicht mal mehr für eine schöne Kaffeepause.

Und weil wir gerade bei den Bewegtbildern waren, die neuen Ampere-Karten unterstützen beim Decoder nativ auch AV1 (Intels Xe wird dies wohl ebenfalls tun). Doch warum AV1? Der Codec ist bis zu 50% effizienter als H.264, was bedeutet, dass man nur noch die Hälfte der Internet-Bandbreite benötigt, um die gleiche Qualität zu übertragen – einschließlich HDR und auch 10-Bit-Codierung. Das ginge bis zu 8K – theoretisch. Leider sieht die Praxis selbst bei den Kabelanbietern ein Deutschland eher mau aus. Aber die Anfänge sind gemacht und der Wille zählt ja irgendwie auch.

Zusammengefasst: Ja, man kann mit der GeForce RTX 3080 richtig gut arbeiten und man kann sie dabei sogar richtig schön finden, auch wenn man sie noch nicht einmal sieht, weil sie im Gehäuse steckt. Die 3D-Gemeinde wird wohl genüsslich zuschlagen und hyperventilieren, denn egal ob nun Octane, Arnold oder Blender – hier geht wirklich die Post ab. Mit OptiX mutiert die GeForce RTX 3080 zur Kannibalin, die teilweise fast doppelt so schnell agiert, als die RTX 2080 Ti. Quadro-Punishment fest mit inkludiert. Was natürlich auch für die Videobearbeitung gilt und alle die Workstation- oder CAD-Anwendungen, die keine zertifizierten und optimierten Treiber zum Sprinten benötigen.

GeForce RTX 3080 Founders Edition

Die hauseigene Founders Edition macht diesmal vieles richtig und deutlich besser als die Vorgängerinnen, auch wenn die heftigen Klimmzüge beim Dual-Slot-Design ab und zu dann doch nicht ganz reichen, um die Karte thermisch und akustisch auf den Thron zu setzen. Optisch und haptisch ist das Teil allererste Sahne und relativ platzsparend dazu. Das mit dem 12-Pin-Stecker ist mittlerweile ein Running-Gag, aber wirklich tolerierbar. Es ist, das muss man neidlos zugestehen, das Maximum dessen, was man bei 320 Watt und mehr aus einem so kompakten Kühlerdesign herausquetschen kann.

Genau deshalb wird sie ihre Freunde und Käufer finden, da bin ich mir sicher. Aber ohne spoilern zu wollen, mit mehr Kühlfläche ginge sicher mehr. Doch die Umsetzung der FE ist smart und spätesten die Platine macht sie mit Sicherheit mal zu einem begehrten Sammlerstück. Die Größe der Karte liegt in ihrer Größe, der Rest ist zu verschmerzen. Kaufen? Durchaus. Umbau auf Wasserkühlung? Ginge auch. So gesehen passt das also. Der Rest steht ja im Test.

Fazit und Schlussbemerkung

Den Kauftipp gibt es für den Chip, der mit einem cleveren INT32-Schachzug die vermeintlichen Nachteile aus Samsungs 8-nm-Node vergessen machen kann. Gut, die Leistungsaufnahme ist noch einmal gestiegen, die Performance allerdings auch. Liegt die Effizienz beim Spielen in WQHD noch zwischen der GeForce RTX 2080 Super und RTX 2080 Ti, ist spätestens in Ultra-HD sichtbar, dass man wohl eben doch nicht nur die Steckdose aufgebohrt hat. Wenn die CPU als limitierender Faktor komplett wegfällt und pure Rechenleistung gefragt ist, geht auch das Konzept wieder auf.

Das sieht man vor allem im Produktivbereich, egal ob nun Workstation oder Creation. Studio ist das neue GeForce-Wunderland und die Quadros dürfen sich langsam wieder in die professionelle Ecke der zertifizierten Spezialprogramme zurückziehen. Was AMD damals mit der Vega Frontier Edition begonnen und leider nicht weitergeführt hat (warum eigentlich nicht?), hat NVIDIA mittlerweile längst aufgegriffen und konsequent perfektioniert. Der Markt hat sich gewandelt und Studio ist keine exotische Worthülse mehr. Erinnert sich noch jemand, wenn man noch in den frühen 1990ern wegen jedes kleinen Ausdrucks zum Grafiker rennen musste? Damals war es DTP und heute kommt eben Studio. Immer mehr Multimedia im Selbstverlag und das Verlagern von vielen Aufgaben aus den teuren Renderfarmen zurück auf dem PC haben genau die Lücke geschaffen, in die man jetzt mit solchen Karten stoßen kann.

Warten wir also mal auf die Boardpartnerkarten und das, was die jeweilige Interpretation der Hersteller so bietet. Getestet wird das alles natürlich auch noch, Step-by-Step. Langeweile? Eher kaum. Und dann kommt AMD…

- 1 - Einführung und Testsystem

- 2 - Teardown, Platinenanalyse und Kühler

- 3 - Grafik-Performance: WQHD und Full-HD mit RTX On

- 4 - Grafik-Performance: Ultra-HD mit und ohne DLSS

- 5 - FPS, Perzentile, Frame Time & Varianzen

- 6 - Frametimes vs. Leistungsaufnahme

- 7 - Workstation: CAD

- 8 - Studio: Rendering

- 9 - Studio: Video- und Bildbearbeitung

- 10 - Leistungsaufnahme: GPU und CPU in allen Spielen

- 11 - Leistungsaufnahme: Effizienz im Detail

- 12 - Leistungsaufnahme: Übersicht & Netzteil-Empfehlung

- 13 - Temperaturen und Infrarot-Tests

- 14 - Geräuschemission / Noise

- 15 - NVIDIA Broadcast - Mehr als nur eine Spielerei?

- 16 - Zusammenfassung. Features und Fazit

Kommentieren