Display-Ausgänge: Ein Controller für die Zukunft

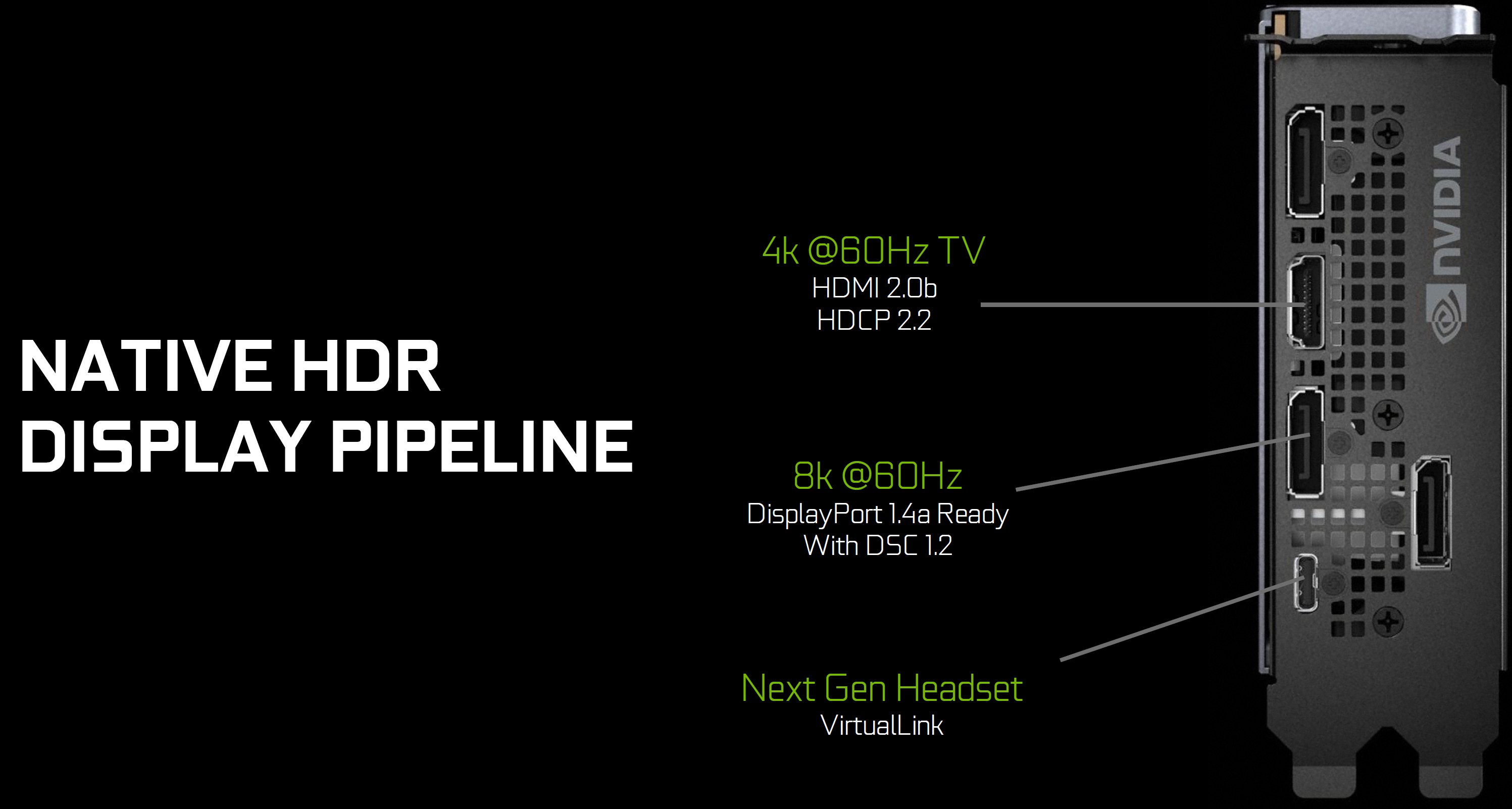

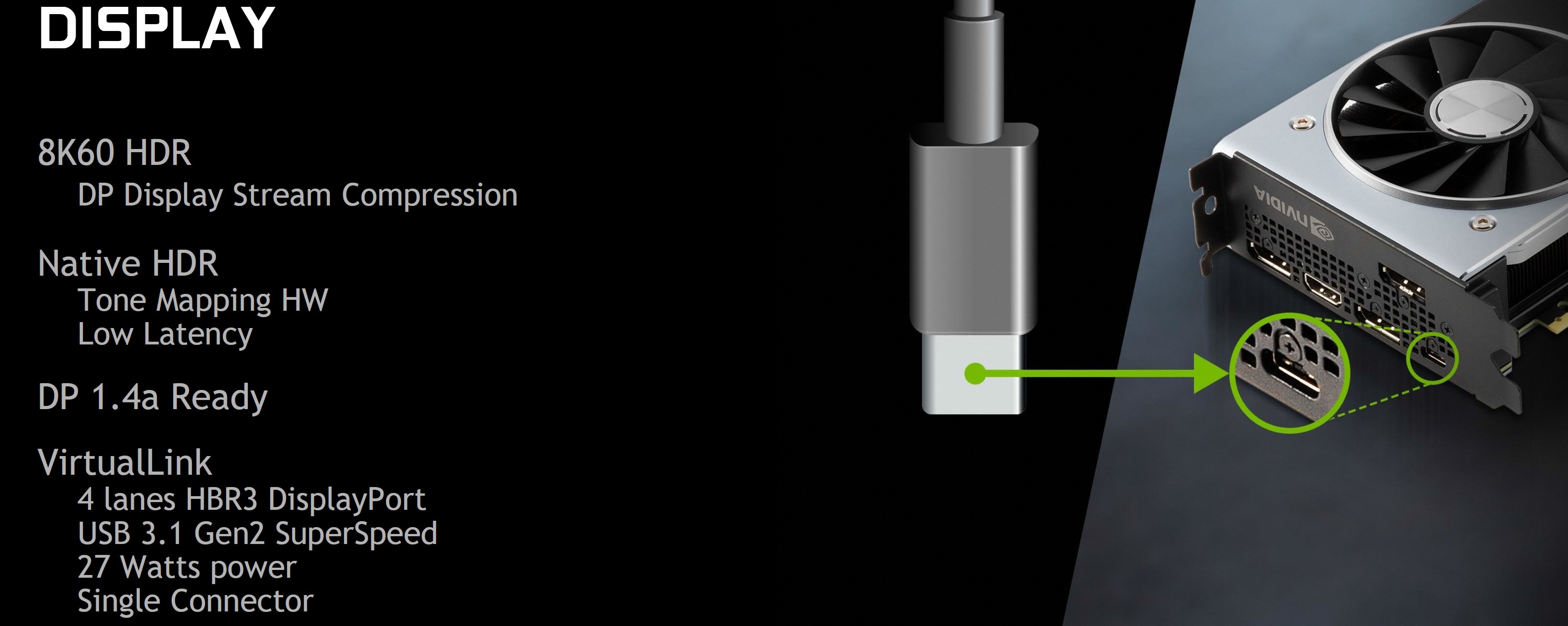

Die GeForce RTX Founders Edition Karten verfügen über drei DisplayPort 1.4a, einen HDMI 2.0b Ausgang und eine VirtualLink Schnittstelle. Sie unterstützen bis zu vier Monitore gleichzeitig und sind natürlich HDCP 2.2 kompatibel. Turing ermöglicht auch die Display Stream Compression (DSC) über den DisplayPort, wodurch es möglich ist, ein 8K (7680 x 4320 Pixel) Display über einen einzelnen Stream mit 60 Hz zu betreiben. Es ist auch der Schlüssel zum Betrieb bei 4K (3840 x 2160 Pixel) mit 120 Hz Refresh und HDR.

Aber warum nur HDMI 2.0? Die HDMI 2.1 Spezifikation wurde erst Ende November 2017 fertig gestellt und freigegeben, was weit über den Zeitrahmen des Turing Designs hinausging.

Apropos HDR, Turing liest jetzt nativ HDR-Inhalte über eine spezielle Tone-Mapping-Hardware ein. Pascal hingegen musste hierfür eine spezielle Verarbeitung anwenden, die die Latenzzeit erhöhte. Schließlich enthalten alle drei Karten der Founders Edition VirtualLink-Anschlüsse für VR-HMDs der nächsten Generation. Die VirtualLink-Schnittstelle verwendet einen USB-Typ-C-Stecker, basiert aber auf einem alternativen Modus mit neu konfigurierten Pins, um vier DisplayPort-Lanes, einen bidirektionalen USB 3.1 Gen2-Datenkanal für hochauflösende Sensoren und bis zu 27 W Leistung zu liefern.

Laut dem VirtualLink-Konsortium arbeiten bestehende Headsets typischerweise innerhalb eines 15W-Spektrums, einschließlich Displays, Controller, Audio, Leistungsverlust über ein 5m langes Kabel, Kabelelektronik und Steckerverluste. Diese neue Schnittstelle wurde nun dafür entwickelt, um Geräte mit höherer Leistung und verbesserten Anzeigefunktionen, bessere Audioqualität, High-End-Kameras und Zubehöranschlüsse zu unterstützen.

Man sollte sich auch bewusst sein, dass sich die Leistungsaufnahme von VirtualLink nicht in der TDP-Spezifikation der GeForce RTX-Karten widerspiegelt. Nvidia gibt an, dass die Verwendung der Schnittstelle bis zu 35 W zusätzlich erfordert.

Videobeschleunigung: Verbesserungen bei der Kodierung und Dekodierung

Hardware-beschleunigte Videofunktionen erhalten nicht so viel Aufmerksamkeit von den Lesern wie Spiele, aber neue Grafikarchitekturen fügen in der Regel Verbesserungen hinzu, die die neuesten Komprimierungsstandards unterstützen, fortschrittlichere Codierungstools/Profile integrieren und die Arbeit von der CPU zur GPU hin verlagern

Die Kodierungsleistung ist für Spieler, die Inhalte auf soziale Plattformen streamen, aber wichtiger denn je. Ein Grafikprozessor, der in der Lage ist, die Arbeitsbelastung in der Hardware zu bewältigen, entlastet andere Plattformressourcen, so dass die Kodierung einen geringeren Einfluss auf die Bildraten der Spiele hat.

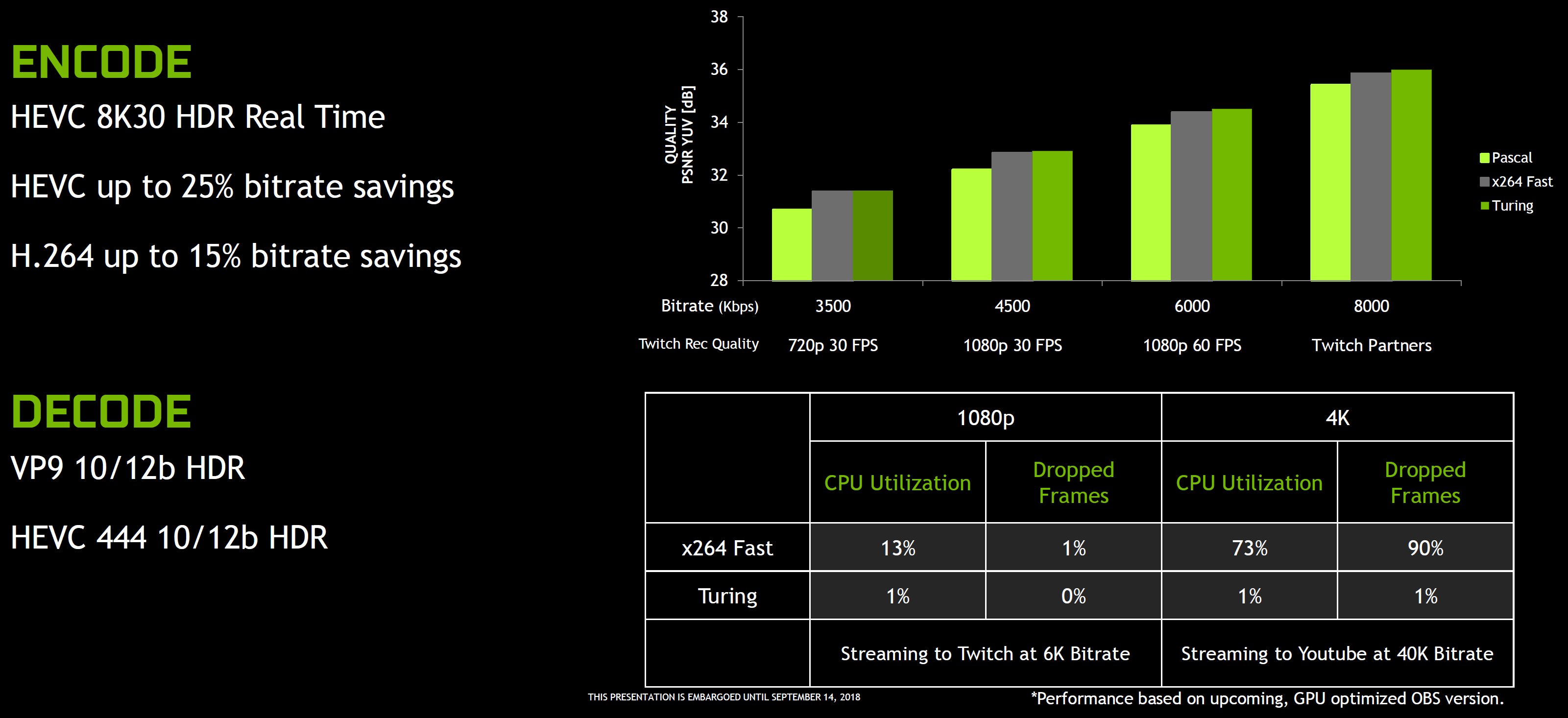

In der Vergangenheit entsprach die GPU-beschleunigte Codierung jedoch nicht ganz der Qualität einer Softwarecodierung bei einer bestimmten Bitrate. Nvidia behauptet nun, dass Turing dies ändert, indem es die Arbeitsbelastung absorbiert und sogar noch die Qualität einer softwarebasierten x264 Fast Kodierung übertrifft (gemäß seinem eigenen Benchmark für das Signal-Rausch-Verhältnis). Ab einem bestimmten Punkt bieten Qualitätsverbesserungen eine sinkende Effizienz. Es ist also durchaus bemerkenswert, dass Nvidia nun sagt, zumindest dem Fast Profil zu entsprechen. Aber Streamer sind vor allem an der Fähigkeit der GPU interessiert, die CPU-Auslastung und die Bitrate zu minimieren.

Der NVEnc Encoder ist schnell genug für 8K HDR in Echtzeit bei 30 FPS. Optimierungen am Encoder ermöglichen Bitrateneinsparungen von bis zu 25% im HEVC (oder eine entsprechende Qualitätssteigerung bei gleicher Bitrate) und bis zu 15% im H.264. Die Hardwarebeschleunigung macht auch die Echtzeit-Encodierung bei 4K zu einer durchaus praktikablen Option, obwohl Nvidia nicht angibt, mit welcher CPU sie getestet wurde, um im reinen Softwarevergleich eine Auslastung von 73% zu erreichen.

Zusätzlich unterstützt der Dekodierblock VP9 10-12-bit HDR. Es ist jedoch nicht klar, worin sich das Ganze von GP102-basierten Karten unterscheidet, da GeForce GTX 1080 Ti in Nvidias NVDec-Supportmatrix eindeutig mit VP9 10/12-Bit-Unterstützung aufgeführt ist. Ebenso wird HEVC 4:4:4:4 10/12-Bit-HDR als neues Feature für Turing aufgeführt. Da das gesamte Pascal-basierte Portfolio bereits HEVC 4:4:4:4 10-Bit unterstützt, müssen wir davon ausgehen, dass Nvidia das ursprüngliche 4:4:4:4 12 Profil zu TU102 hinzugefügt hat.

- 1 - Einführung und Vorstellung

- 2 - TU102 + GeForce RTX 2080 Ti

- 3 - TU104 + GeForce RTX 2080

- 4 - TU106 + GeForce RTX 2070

- 5 - Performance-Anstieg für bestehende Anwendungen

- 6 - Tensor-Kerne und DLSS

- 7 - Ray Tracing in Echtzeit

- 8 - NVLink: als Brücke wohin?

- 9 - RTX-OPs: wir rechnen nach

- 10 - Shading-Verbesserungen

- 11 - Anschlüsse und Video

- 12 - 1-Klick-Übertaktung

- 13 - Tschüss, Gebläselüfter!

- 14 - Zusammenfassung und Fazit

Kommentieren