Was bitte ist hier smart?

Kommen wir noch einmal kurz zum PWM Controller zurück. Der auf meinem Sample verwendete uP9512 verfügt über programmierbare Ausgangsspannungs- und Aktivspannungs-Positionierungsfunktionen, um die Ausgangsspannung in Abhängigkeit vom Laststrom so einzustellen, so dass er optimal für einen guten Laststromübergang positioniert ist. Der uP9512 unterstützt zudem NVIDIA Open Voltage Regulator Typ 4i+ mit PWMVID-Funktion. Der PWMVID-Eingang wird gepuffert und gefiltert, um eine sehr exakte Referenzspannung zu erzeugen. Die Ausgangsspannung wird dann präzise auf den Referenzeingang geregelt.

Und was macht solche Chips nun so besonders? Es ist die flexible Hardware-Vorgabe, um die Betriebsphasenzahl in verschiedenen Laststromzuständen anzupassen. Das ist zwar im Prinzip nicht neu, wurde aber noch einmal deutlich verbessert und sollte genau das erfüllen, was Nvidia bei der Präsentation auf der Folie gezeigt hat. Um also eine so smarte Regelung hinzubekommen, hilft es nicht, die Anzahl der Phasen ins Unendliche zu treiben, sondern die 8 Phasen nur sinnvoll genug einzusetzen und zu koordinieren bzw. bei Nichtgebrauch auch abzuschalten.

Im Niedriglastbereich ist es daher sehr einfach, die drei nicht doppelt belegten Phasen sehr sinnvoll und fein abgestimmt arbeiten zu lassen. Dass die Leistungsaufnahme im Idle für das gesamte Board dann trotzdem recht hoch ausfiel, muss andere Ursachen habe wie z.B. einen noch aktiven NVLink-Controller, der trotz nicht angeschlossener Geräte deutlich zu viel Saft zieht. Hier sollte man mittels Treiber- oder Firmware-Update ggf. nachbessern (können). Aber es hat wohl eher nichts mit der Bereitstellung der VDDC zu tun.

Dazu kommen Soft-Start zur Vermeidung von Spitzen, Kanalstrombegrenzung, Unterspannungsschutz, Überspannungsschutz und Power Good Output. Die integrierte SMBus-Schnittstelle bietet genug Flexibilität, um sowohl die Leistung und Effizienz zu optimieren, als auch die passende Software anbinden zu können. Der Controller unterstützt zudem, und das ist ganz wichtig, auch die neuen Smart-Power-Stage-Chips (SPS), wie ich sie auf dem Sample gefunden habe.

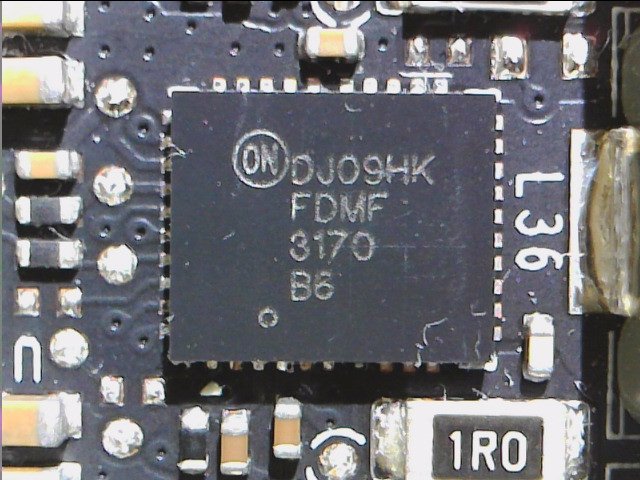

Der FDMF 3170 von ON Semiconductor ist eigentlich ein PowerTrench® MOSFET und Äquivalent zum Original von Fairchild und vereint in sich die High- und Low-Side, die Schottky-Diode und die Gate-Treiber. Doch warum Smart Power Stage (SPS) und nicht nur Power Stage? Diese SPS liefern dann nämlich zusätzlich noch sehr genaue Informationen über z.B. Ströme (IMON) und Temperaturen (TMON) und zwar hochauflösend und in Echtzeit! Jetzt wissen wir auch, warum Nvidia nicht auf die herkömmlichen Doubler setzt, denn die Kommunikation zwischen SPS und PWM Controller ist extrem wichtig!

Netzteilkiller Spikes? Doch Stopp! Welche Spikes?

Die meisten wissen ja, dass ich seit Jahren auf diesem Thema immer wieder herumreite und der eingangs verlinkte Grundlagenartikel ist ja auch einer der Gründe, warum auch die Netzteilhersteller mittlerweile viel sensibilisierter mit ihrer Sekundärseite umgehen und diese fast schon verhätscheln. Ich habe nun Nvidia beim Wort genommen, die bei der Präsentation von deutlich geringeren Lastwechseln sprachen und noch einmal im Millisekundenbereich nachgemessen!

Zunächst habe ich überprüft, mit welcher Frequenz die einzelnen Phasen der VDCC takten. Es sind bei der GeForce GTX 1080 Ti und bei der RTX 2080 Ti jeweils 300 KHz. Mal abgesehen davon, dass beide Werte identisch sind, können wir so (a) beim nachfolgenden Vergleich den Einfluss dieses Wertes auf das jeweilige Ergebnis ausschließen und (b) sehen wir auch, dass die Specs beider PWM-Controller im Vergleich zur realen Schaltung total over-the-top sind. Galerie-Feeling, mehr nicht.

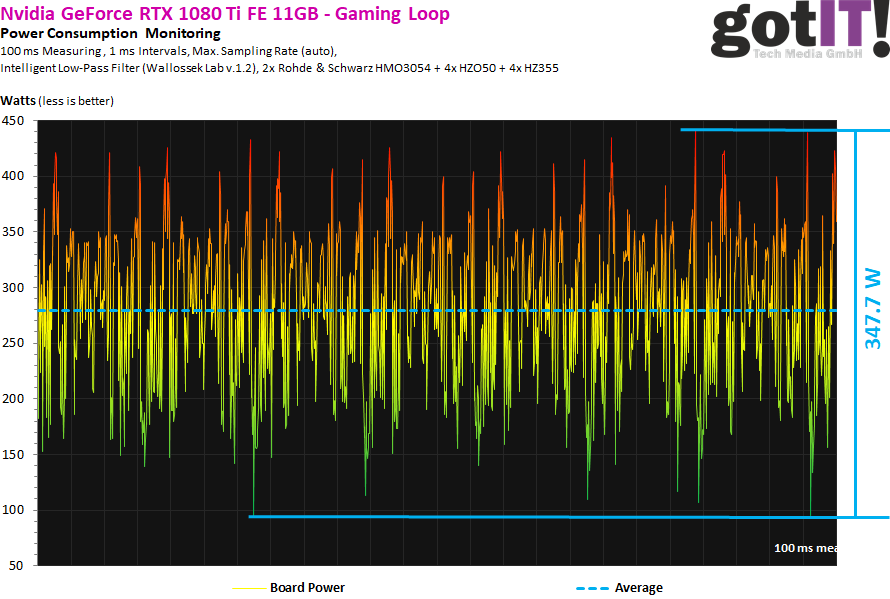

Um im Test wirklich vergleichbar zu bleiben, habe ich zunächst eine GeForce GTX 1080 Ti so übertaktet, dass bei gleicher 3D-Last (spezielles Witcher-3-Savegame) annähernd dieselbe Leistungsaufnahme von knapp 280 Watt anlag. Eine Leistungsspitze von 442 Watt war da keine Seltenheit und man sieht auf dem Bild auch sehr gut, wie sich das gesamte Konstrukt geradezu im „Panik-Modus“ befindet, nur um mit hektischem Herunterregeln den Mittelwert einhalten zu können.

Wir sehen auch sehr schön, dass die Intervalle sehr granulär ausfallen und für jedes Netzteil geradezu die Pest sein können. Jedes weitere Übertakten würde die Sache übrigens nur noch schlimmer machen. Aber es ist wirklich schön, wenn mal jemand zuhört und dort endlich auch gegensteuert. Da spielt es für mich auch keine Rolle, aus welchen Gründen Nvidia dies umgesetzt hat, denn es war längst überfällig! Die gemessenen fast 348 Watt zwischen höchstem und niedrigstem Lastzustand beim Gaming sind bei der Pascal-Karte einfach unhaltbar.

Zusammen mit Boost 4 und den smarten PWM Controllern und SPS lässt sich die gesamte Last nunmehr viel schöner regeln. Auf dem nächsten Bild kann man nämlich sehr gut erkennen, dass die Wechselintervalle nun viel kleiner ausfallen und die Regelhäufigkeit damit steigt. Man erkennt aber auch, dass alles nun sehr viel entspannter zugeht! Die gelieferte Leistung beträgt ebenfalls annährend 280 Watt im Durchschnitt, aber der Mittelwert sagt nun einmal nicht alles aus.

Die Leistungsspitzen liegen nunmehr nur noch bei bis zu 377 Watt, das sind satte 65 Watt weniger! Und auch die Regelung nach unten hin fällt um ca. 50 Watt geringer aus. Damit liegt die gemessene, maximale Differenz zwischen den beiden Extremen mit nur noch 236 Watt um beeindruckende 111 Watt niedriger als bei der Vorgängerin. Das ist schon ein kleines Universum und das Wellness-Programm für jeden verbauten Stromversorger.

Neben den sehr positiven Aspekten der aktuellen Lösung gibt es aktuell nur zwei Probleme. Das eine ist die etwas zu hohe Leistungsaufnahme im Idle (ich hatte da reichlich 17 Watt gemessen) und einen wohl doch sehr seltenen Spezialfall unter extremen Laborbedingungen, bei dem extrem hohe Leistungsspitzen aufgetreten sein sollen. Ersteres sollte man einfach lösen können, das Letztere wird von Nvidia wohl gerade untersucht. Es ist aber, um falsche Sensationsmeldungen gleich mal abzubiegen, auch nichts, was der Kevin-Normalzocker jemals mit seinem Umfeld auslösen können dürfte.

Da trifft es die OC-Gilde schon deutlich härter, dass bis auf spezielle OC- und LN2-BIOSe alles das, was normal über den Tresen geht, sehr restriktiv abgedrosselt wird. Nvidia begrenzt die Boardpower sehr hart und es ist schon eine Art eingebaute Spaßbremse, wenn man trotz Chiller kaum signifikant über 2 GHz kommt, obwohl alle Werte eigentlich gut aussehen. Es fehlt dann schlicht die Power, die aber eigentlich auf ein echtes Spannungsdefizit zurückzuführen sein dürfte. Der Strom ist ja nur ein Faktor, denn für das OC braucht man nun mal die Spannung. Und genau da hat Nvidia den Riegel angesetzt. Man wird schon wissen, warum.

Damit endet der kleine Exkurs erst einmal, aber ich bin mir sicher, da kommt sicher noch das eine oder andere noch hinzu. Versprochen!

Kommentieren