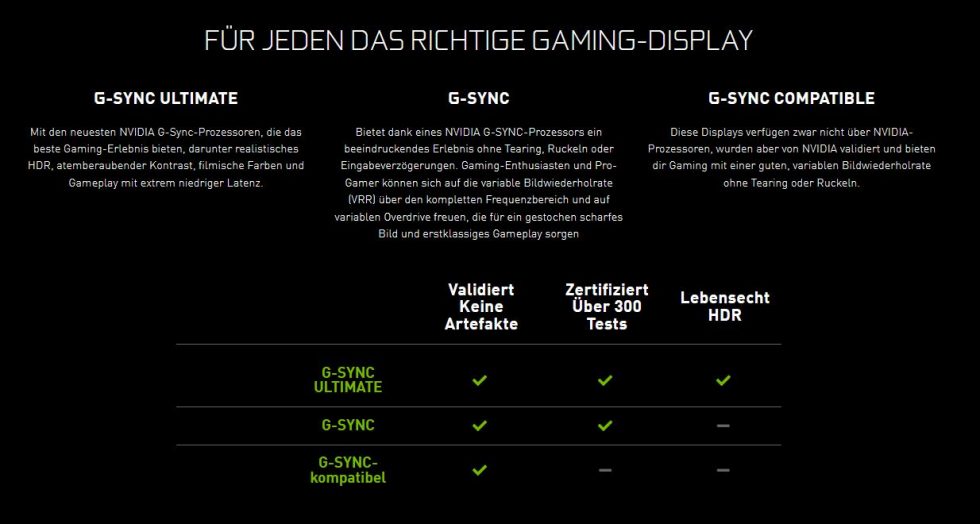

Fangen wir mal mit Nvidia an. G-SYNC ist eine Hardware-Lösung, die direkt im Monitor verbaut ist. Daher kosten diese Monitore auch deutlich mehr als FreeSync Monitore. Ja, leider ist dem so! Aber seit der RTX 2000er Generation hat sich Nvidia bzgl. FreeSync Monitoren geöffnet und diesen offenen Standard für Nvidia Grafikkarten möglich gemacht. Das Ganze funktioniert rückwirkend bis zur GTX 1000er Generation also Pascal. Immerhin!

An der Stelle mal ganz allgemein und auch nur kurz erklärt, was diese adaptiven Synchronisierungstechnologien machen. Egal ob FreeSync oder G-SYNC, beide passen die aktuellen FPS der Bildwiederholrate an. Was den Vorteil hat, dass weniger bis gar kein Tearing auf dem Monitor entsteht. Vielleicht hat der ein oder andere den Begriff VRR gehört? Variable Refresh Rate (Bsp.: FreeSync Premium)! Wer also einen echten G-SYNC Monitor hat, der hat auch die VRR Unterstützung von 1 – XXX Hertz. Ab hier geht es jetzt richtig los und es bedarf eines gesonderten Artikels. Andererseits langweile ich euch jetzt mit viel technischem Bla Bla. Ich plane hierzu einen Artikel, der sich mit dem Thema noch näher beschäftigt.

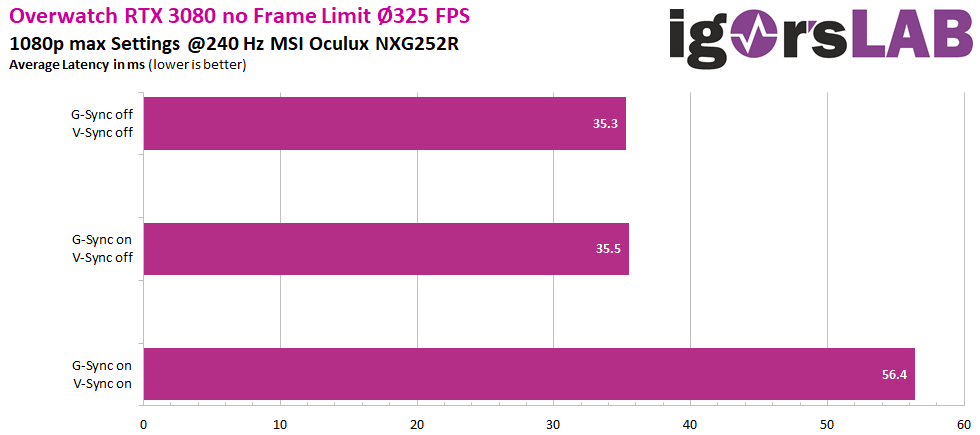

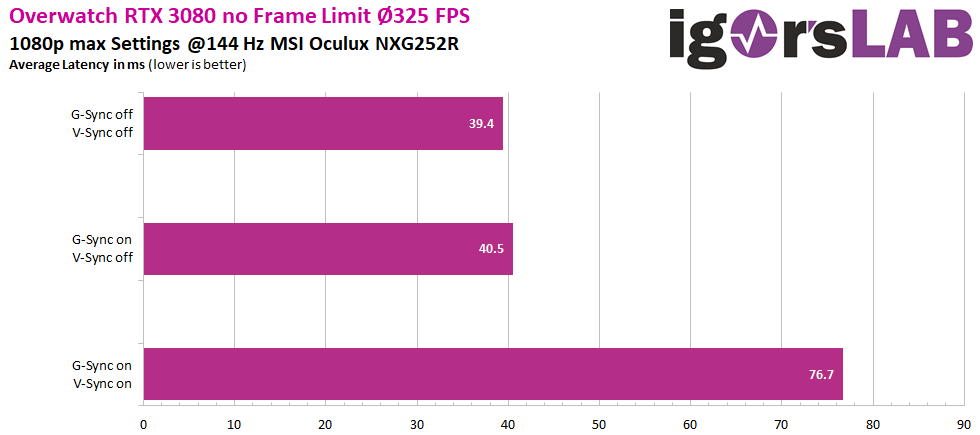

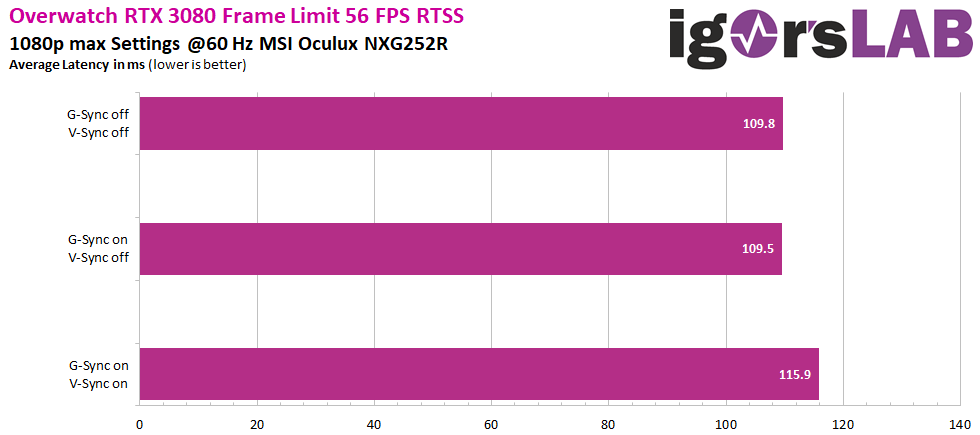

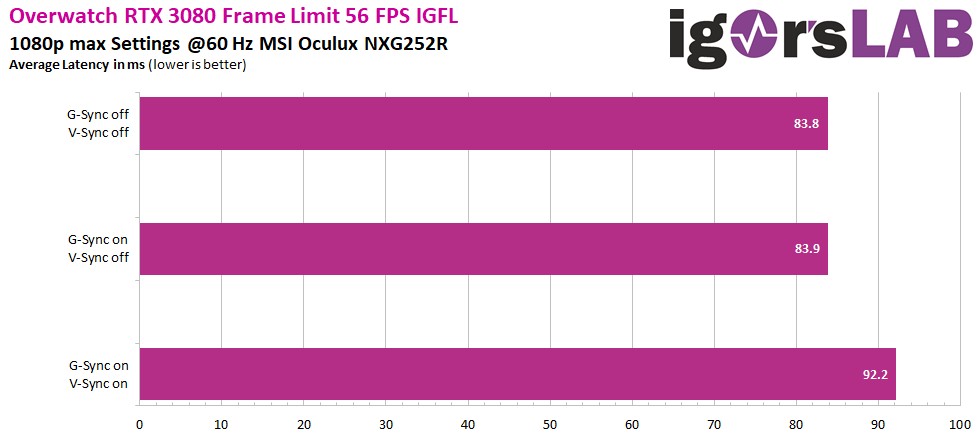

Jetzt schauen wir uns aber mal an, was mit einem Nvidia G-SYNC Monitor bzgl. der Latenzen passiert. Hierzu kommen jetzt ein paar Grafiken. Was habe ich hier gemacht? Nvidia LDAT auf den MSI Oculux geschnallt und das Spiel Overwatch genutzt, um die Latenzen zu messen. Hierbei habe ich unterschiedliche Einstellungen und verschiedene Bildwiederholraten getestet. Dabei habe ich als Referenz zuerst immer G-SYNC und V-Sync deaktiviert. Danach beide Technologien sequenziell aktiviert. Letztlich habe ich noch mit dem IGFL (Ingame Frame Limiter) bzw. RTSS (Rivatuner Statistics Server) die Framerate limitiert, um aufzuzeigen, wie sich V-Sync auf die Latenzen auswirkt.

Overwatch mit RTX 3080 und G-SYNC Monitor MSI Oculux NXG252R

Hier die Einstellungen im Spiel.

Der gute alte Ryzen 7 2700X in Verbindung mit der RTX 3080 bringt es in diesem DX11 Spiel auf durchschnittliche 325 FPS. Kein Nvidia Driver-Overhead – 240 Hz Monitor locker ausgereizt! Hinweis: Die Serverlatenz lag zwischen 30 – 40 ms.

Erste Erkenntnis? G-SYNC hat keinen Einfluss auf die Latenz. Grüße an alle Gerüchteverbreiter!

Ich kann an der Stelle das Mysterium um diese Behauptung mal lüften. Als Nvidia mit G-SYNC um die Ecke kam, war im Treiber sowohl G-SYNC als auch V-Sync standardmäßig aktiviert. Somit war den e-Sportlern vermutlich klar, G-SYNC macht zwar Tearing weg, aber ich habe einen Latenznachteil. Gerücht geboren und bis heute hält es sich noch hartnäckig. Das hat sich in dem Fall Nvidia selbst eingebrockt! Wer sich heute die Treibereinstellungen anschaut, der wird feststellen, dass nur G-SYNC standardmäßig aktiviert ist, wenn ein entsprechender Monitor erkannt wird. Liebe e-Sportler, für ein besseres Spielerlebnis (weniger Tearing) – lasst G-SYNC doch einfach an! Schauen wir mal ein paar weitere Folien an. Wir lesen uns gleich wieder!

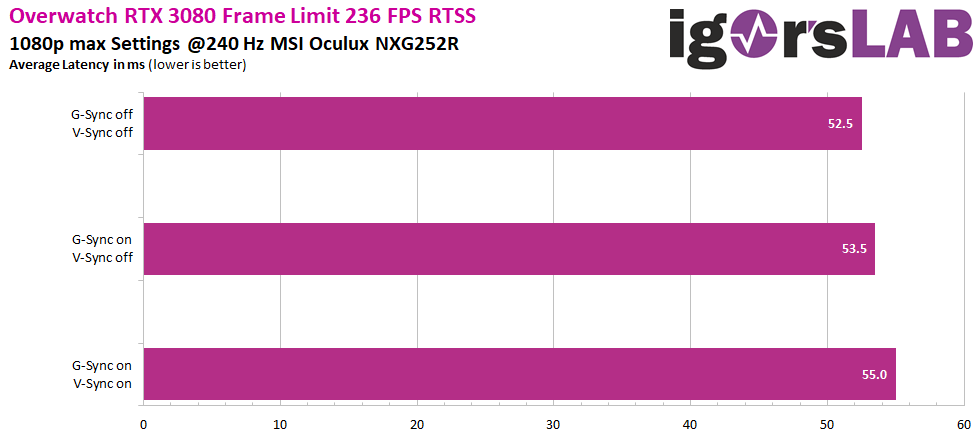

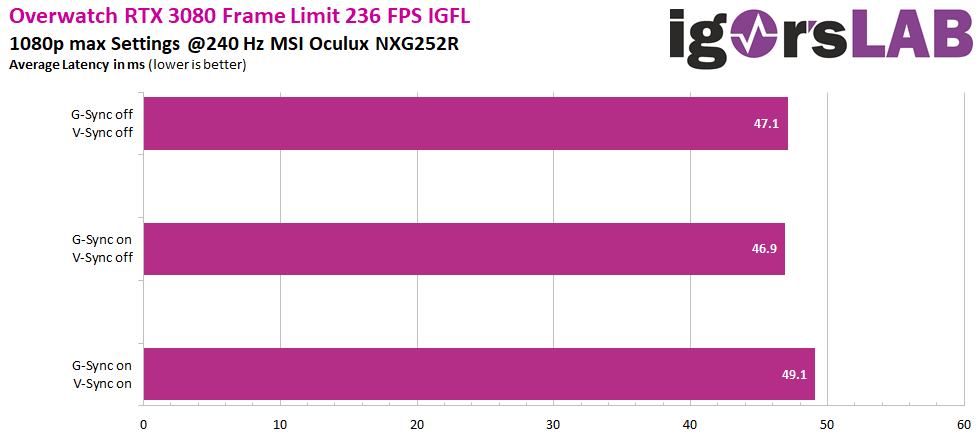

Wieder was gelernt? Wo immer möglich, den IGFL nutzen! Ein Eingriff von außen, beeinträchtigt die Latenz. In dem Fall verursacht RTSS eine um ca. 5 ms schlechtere Latenz.

Was euch sicher auch aufgefallen ist, dass bei richtiger Anwendung eines IGFL bzw. RTSS die Latenz bei der Nutzung von V-Sync nur noch um ca. 2 ms schlechter wird. Das liegt daran, weil ich mit der limitierten Framerate hier 4 FPS unterhalb der Bildwiederholfrequenz des Monitors bleibe. Würde ich noch ein paar FPS runter gehen, dann wäre hier sehr wahrscheinlich die Differenz (mit/ohne V-Sync) im Bereich der Messtoleranz. Warum ich so auf das Thema V-Sync abgehe? Weder G-SYNC noch FreeSync können Tearing in Gänze vermeiden.

Es kann immer noch zu Tearing im unteren Bildschirmdrittel kommen! Zumindest dann, wenn deutlich mehr FPS auf den Monitor losgelassen werden als es die Bildwiederholrate hergibt. Wer das nicht haben will, der kommt um eine Limitierung der FPS (min. 4 FPS < Hz des Monitors) und die Aktivierung von V-Sync nicht herum! Man verliert hier ca. 10-12 ms Latenz vergleicht man die Werte ohne FPS-Begrenzung. Letztlich muss das jeder für sich entscheiden! Die e-Sportler werden das sicher nicht machen, aber für ein Singleplayer-Game wäre das eine nützliche Optimierung, um das beste Bild zu bekommen.

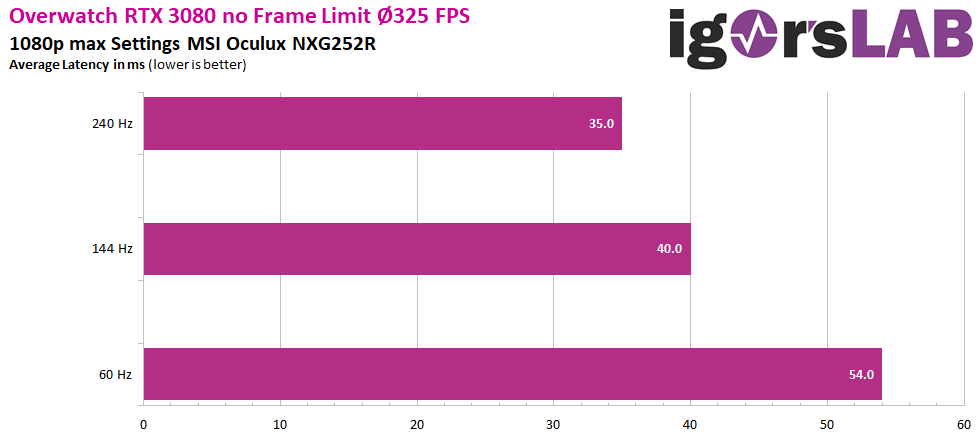

Der Vollständigkeit halber hier noch die Grafiken für 144 Hz und 60 Hz.

Was können wir aus den Grafiken lernen? Zum einen bestätigt sich das offensichtliche, mit abnehmender Bildwiederholrate des Monitors – steigt die Latenz, trotz gleicher FPS (Ø 325). Die Werte auf der folgenden Grafik sind auf 0 hinter dem Komma gerundet!

Grüße an alle 60 Hz Spieler: 35 % niedrigere Latenz auf einem 240 Hz Panel bei 325 FPS. So viel zu dem Thema, mir reicht ein 60 Hz Monitor! Bedeutet nicht nur bzgl. der End-zu-End Latenz hat der 60 Hz Spieler das Nachsehen, sondern wichtiger ist: Der 240 Hz Spieler kann euch im Schnitt um ca. 35 % schneller sehen als ihr den Gegner auf dem 60 Hz Monitor seht. Was der 60 Hz Spieler dann noch sieht: Du wurdest von Spieler XXX getötet! Haha. Also nicht nur die FPS machen den Unterschied. Hier macht es auch die restliche Hardware. Skill kann die Hardware aber nicht ersetzen! Schade… Zum anderen sehen wir weiterhin, dass sich der IGFL hier bzgl. der Latenzverringerung deutlich mehr eignet als RTSS. Und das V-Sync bei niedrigen Bildwiederholraten noch drastischer die Latenz beeinfluss als ohnehin schon. Ok, an der Stelle wechseln wir mal das Thema – jetzt kommt FreeSync dran.

134 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

Moderator

Moderator

Urgestein

Urgestein

Urgestein

Moderator

Urgestein

Moderator

Urgestein

Moderator

Urgestein

Neuling

Mitglied

Neuling

Moderator

Alle Kommentare lesen unter igor´sLAB Community →