Benchmarks, Testsystem und Auswertungssoftware

Für die Benchmarks habe ich, analog zum Launchartikel der Radeon RX 6700 XT , die gleichen 9 Spiele gewählt (Far Cry New Dawn musste wegen der CPU-Limitierung in Full-HD weichen) und dabei zwischen alt und neu, sowie AMD- oder NVIDIA-speziell gewichtet. Außerdem habe ich noch 2 weitere Titel zugefügt, die sowohl DLSS als auch FSR beherrschen.

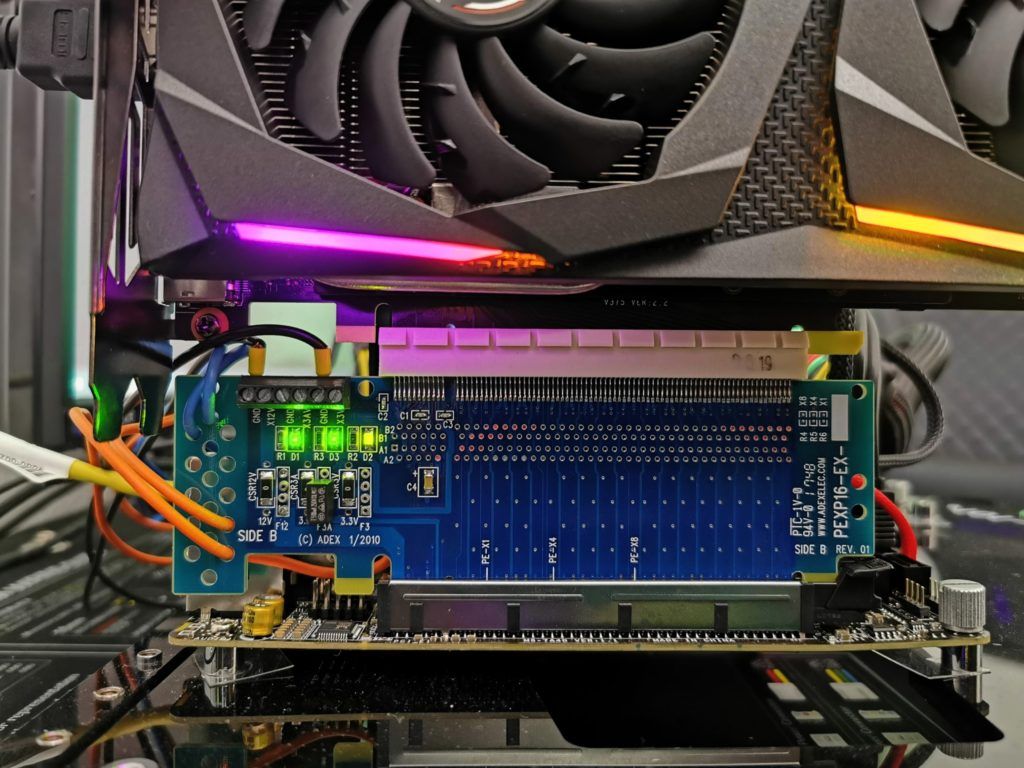

Das Benchmarksystem ist neu und ich setze nunmehr auch auf PCIe 4.0, passende X570 Motherboards in Form der MSI MEG X570 Godlike und einen selektierten Ryzen 9 5900X, der wassergekühlt übertaktet wurde (PBO + 500 MHz). Dazu kommen der passende DDR4 4000 RAM von Corsair, sowie mehrere schnelle NVMe SSDs. Für das direkte Loggen während aller Spiele und Anwendungen nutze ich meine eigene Messstation mit Shunts und Riser-Karte, sowie NVIDIAs PCAT in Spielen, was den Komfort ungemein erhöht.

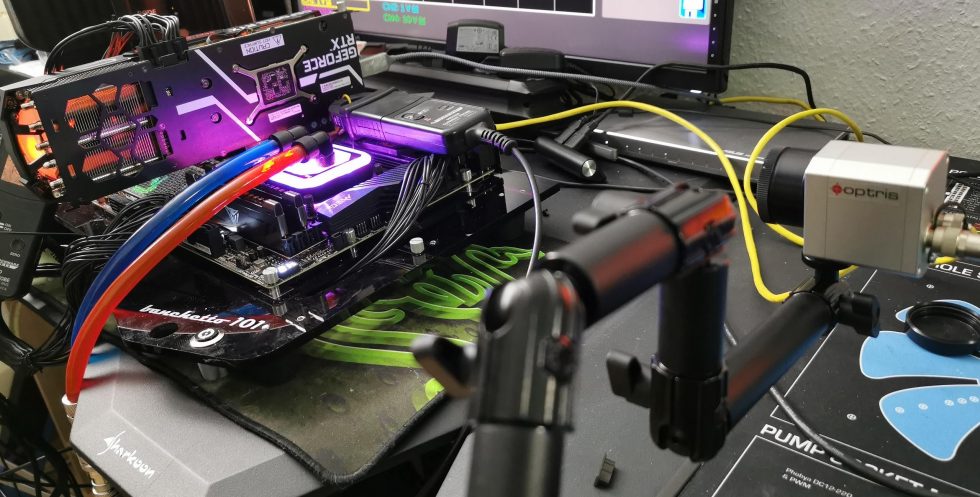

Die Messung der detaillierten Leistungsaufnahme und anderer, tiefergehender Dinge erfolgt hier im Speziallabor auf einem redundanten und bis ins Detail identischem Testsystem dann zweigleisig mittels hochauflösender Oszillographen-Technik…

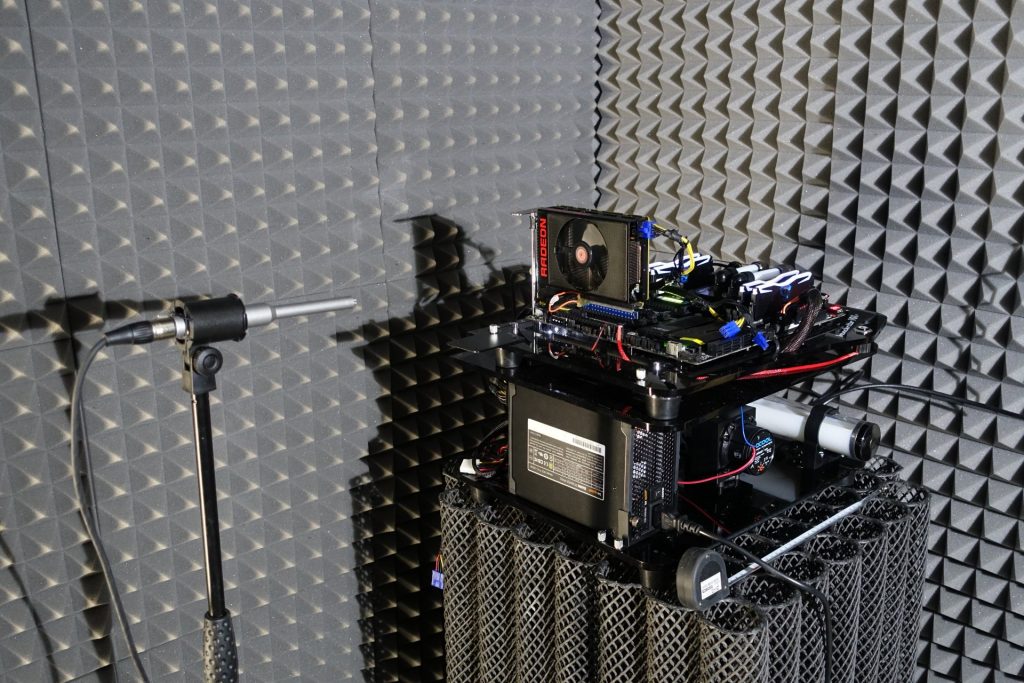

…und dem selbst erschaffenen, MCU-basierten Messaufbau für Motherboards und Grafikkarten (Bilder unten), wo am Ende im klimatisierten Raum auch die thermografischen Infrarot-Aufnahmen mit einer hochauflösenden Industrie-Kamera erstellt werden. Die Audio-Messungen erfolgen außerhalb in meiner Chamber (Raum im Raum).

Die einzelnen Komponenten des Testsystems habe ich auch noch einmal tabellarisch zusammengefasst:

| Test System and Equipment |

|

|---|---|

| Hardware: |

AMD Ryzen 9 5900X OC MSI MEG X570 Godlike 2x 16 GB Corsair DDR4 4000 Vengeance RGB Pro 1x 2 TByte Aorus (NVMe System SSD, PCIe Gen. 4) 1x 2 TB Corsair MP400 (Data) 1x Seagate FastSSD Portable USB-C Be Quiet! Dark Power Pro 12 1200 Watt |

| Cooling: |

Alphacool Eisblock XPX Pro Alphacool Eiswolf (modified) Thermal Grizzly Kryonaut |

| Case: |

Raijintek Paean |

| Monitor: | BenQ PD3220U |

| Power Consumption: |

Oscilloscope-based system: Non-contact direct current measurement on PCIe slot (riser card) Non-contact direct current measurement at the external PCIe power supply Direct voltage measurement at the respective connectors and at the power supply unit 2x Rohde & Schwarz HMO 3054, 500 MHz multichannel oscilloscope with memory function 4x Rohde & Schwarz HZO50, current clamp adapter (1 mA to 30 A, 100 KHz, DC) 4x Rohde & Schwarz HZ355, probe (10:1, 500 MHz) 1x Rohde & Schwarz HMC 8012, HiRes digital multimeter with memory function MCU-based shunt measuring (own build, Powenetics software) NVIDIA PCAT and FrameView 1.1 |

| Thermal Imager: |

1x Optris PI640 + 2x Xi400 Thermal Imagers Pix Connect Software Type K Class 1 thermal sensors (up to 4 channels) |

| Acoustics: |

NTI Audio M2211 (with calibration file) Steinberg UR12 (with phantom power for the microphones) Creative X7, Smaart v.7 Own anechoic chamber, 3.5 x 1.8 x 2.2 m (LxTxH) Axial measurements, perpendicular to the centre of the sound source(s), measuring distance 50 cm Noise emission in dBA (slow) as RTA measurement Frequency spectrum as graphic |

| OS: | Windows 10 Pro (all updates, current certified or press drivers) |

Raytracing / DXR

Spätestens seit der Präsentation der neuen Radeon-Karten ist klar, dass auch AMD Raytracing unterstützen wird. Hier geht man einen zu NVIDIA deutlich abweichenden Weg und implementiert einen sogenannten „Ray Accelerator“ pro Compute Unit (CU). Da die Radeon RX 6700XT insgesamt 40 CUs besitzt, ergeben sich somit auch 40 solcher Beschleuniger. Eine GeForce RTX 3070 kommt auf 46 RT Cores. Allerdings sind die RT-Cores anders organisiert und man wird abwarten müssen, was hier Menge gegen Spezialisierung ausrichten kann. Es ist am Ende also erst einmal ein Äpfel und Birnen Vergleich.

Doch was hat sich AMD hier ausgedacht? Jeder dieser Beschleuniger ist erst einmal in der Lage, gleichzeitig bis zu 4 Strahl-/Box-Schnittpunkte oder einen einzigen Strahl-/Dreieckschnitt pro Takt zu berechnen. So berechnet man die Schnittpunkte der Strahlen mit der Szenengeometrie (analog zur Bounding Volume Hierarchy), sortiert sie zunächst vor und gibt diese Informationen dann an die Shader zur weiteren Bearbeitung innerhalb der Szene zurück bzw. gibt das finale Shading-Resultat aus. NVIDIAs RT-Cores scheinen da allerdings deutlich komplexer vorzugehen, wie ich es beim Turing-Launch bereits ausführlich erläutert habe. Was zählt, ist allein das Ergebnis und genau dafür haben wir auch passende Benchmarks.

Smart Access Memory (SAM)

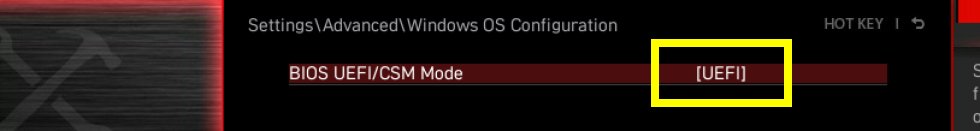

AMD zeigte auf der Präsentation der neuen Radeon-Karten bereits SAM, also Smart Access Memory – ein Feature, das ich heute zusätzlich auch zu den normalen Benchmarks aktiviert habe, womit auch ein direkter Vergleich möglich wird. Doch eigentlich ist SAM nicht Neuers, nur verbal schöner verpackt. Dahinter verbirgt sich nämlich nichts anderes als der clevere Umgang mit dem Base Address Register (BAR) und genau dieser Support muss zwingend auch im Unterbau aktiviert sein. Bei moderner AMD-Grafikhardware spielen größenveränderbare PCI-Bars (siehe auch PCI SIG vom 24.0.4.2008) schon länger eine wichtige Rolle, da die eigentlichen PCI BARs normalerweise ja nur auf 256 MB begrenzt sind, während man bei den neuen Radeon Grafikkarten nun bis zu 16 GB VRAM (hier sind es 12 GB) vorfindet.

Die Folge ist, dass nur ein Bruchteil des VRAM für die CPU direkt zugänglich ist, was ohne SAM eine ganze Reihe von Umgehungslösungen im sogenannten Treiber-Stack erfordert. Das kostet natürlich stets Performance und sollte demzufolge vermieden werden. AMD setzt bei SAM also genau dort an. Neu ist das nicht, muss aber sauber im UEFI implementiert und später auch aktiviert werden. Das wiederum geht nur, wenn das System im UEFI Modus läuft und CSM/Legacy deaktiviert sind.

CSM steht dabei für das Compatibility Support Module. Das Compatibility Support Module gibt es ausschließlich unter UEFI und es sorgt dafür, dass ältere Hardware und Software auch mit UEFI funktioniert. Das CSM ist immer dann hilfreich, wenn nicht alle Hardware-Komponenten zu UEFI kompatibel sind. Einige ältere Betriebssysteme sowie die 32-Bit-Versionen von Windows lassen sich auch nicht auf UEFI-Hardware installieren. Genau diese Kompatibilitätseinstellung verhindert jedoch die saubere und für die neuen AMD-Komponenten benötigte Windows-Variante oft schon bei der Installation.

- 1 - Einführung und Testsystem

- 2 - Testsystem und Methodik

- 3 - Teardown, Platinenanalyse und Kühler

- 4 - Gaming Performance Full-HD

- 5 - Gaming Performance WQHD

- 6 - Gaming Performance DXR & FSR vs. DLSS

- 7 - Details: Frames per Second (Curve)

- 8 - Details: Percentiles (Curve)

- 9 - Details: Frame Times (Bar)

- 10 - Details: Frame Times (Curves)

- 11 - Details: Variances (Bar)

- 12 - Leistungsaufnahme und Effizienz der Einzelspiele

- 13 - Leistungsaufnahme: Übersicht & Netzteil-Empfehlung

- 14 - Temperaturen und Infrarot-Tests

- 15 - Geräuschemission / Noise

- 16 - Zusammenfassung. Features und Fazit

40 Antworten

Kommentar

Lade neue Kommentare

Veteran

Moderator

Mitglied

Urgestein

Veteran

1

1

Veteran

Veteran

Veteran

Mitglied

Urgestein

Veteran

Mitglied

Mitglied

Urgestein

Veteran

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →