Platinenanalyse und Spannungsversorgung

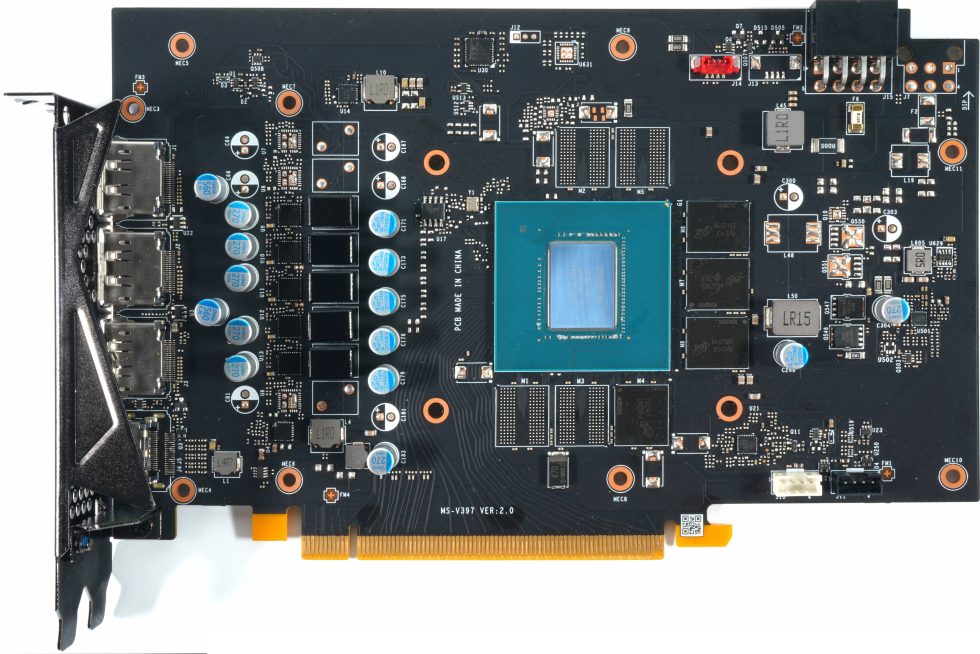

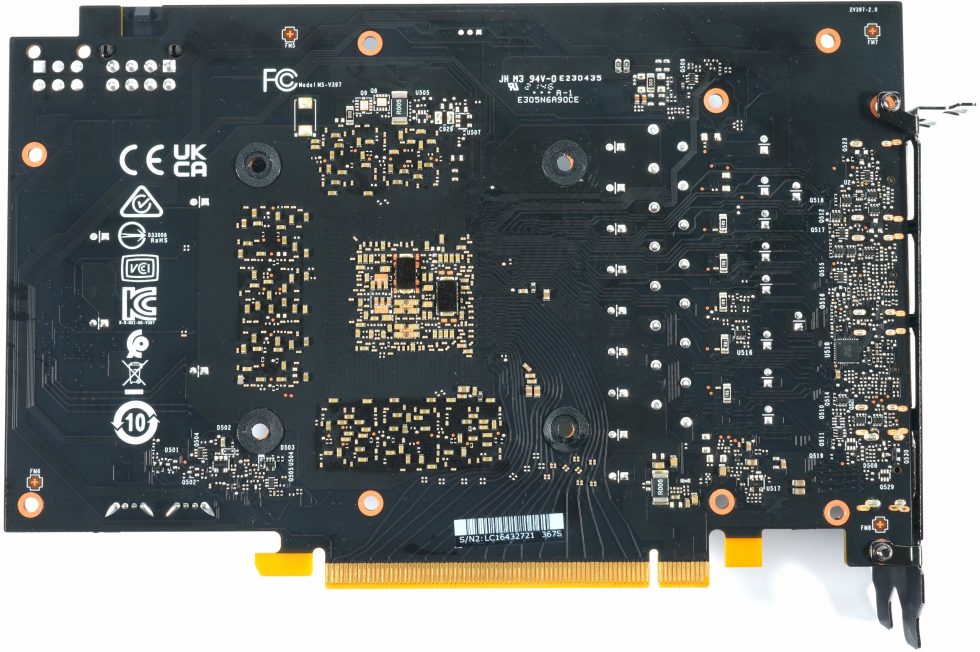

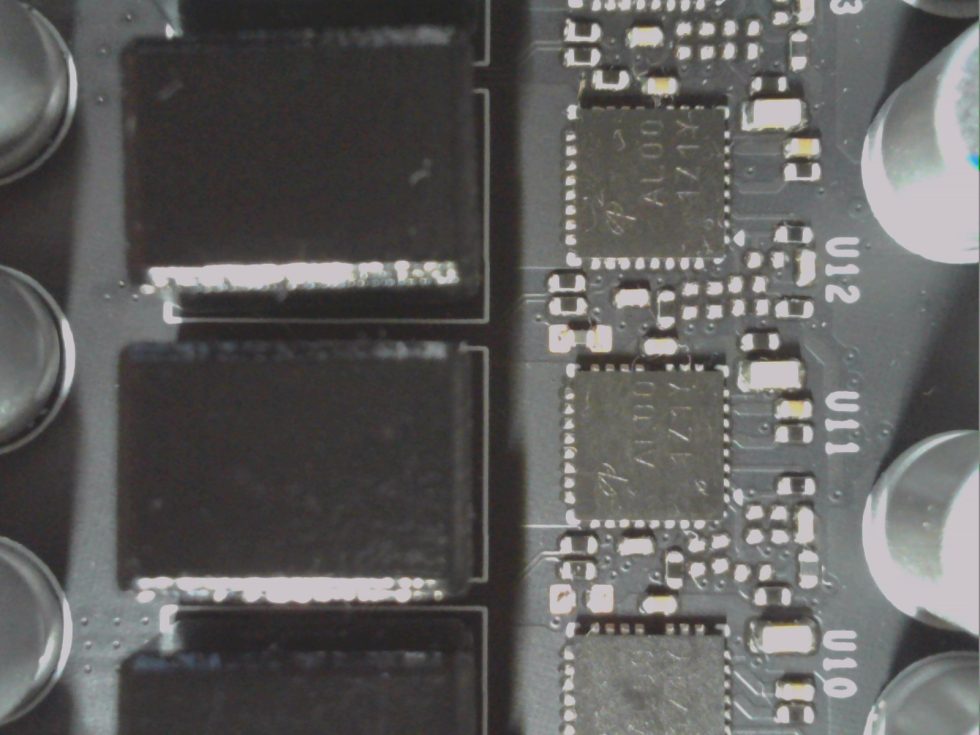

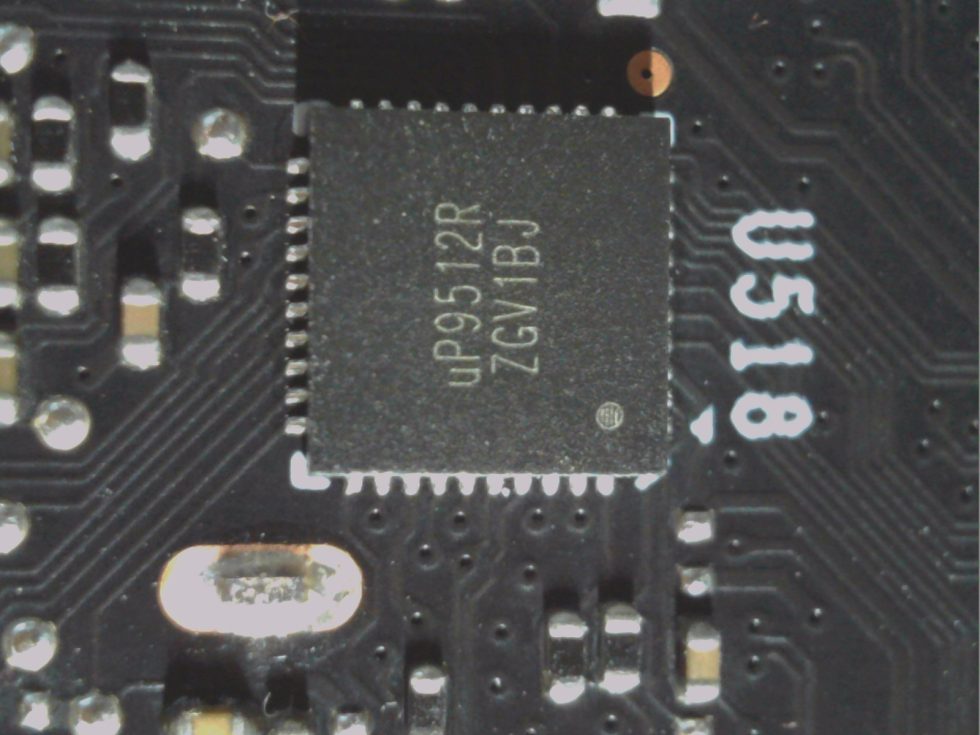

Die Karte besitzt die gleiche Multi-Layer-Platine ohne das aufwändigere Backdrill-Verfahren wie schon die GeForce RTX 3060 Gaming X. Die Art der Spannungsversorgung ist altbekannt und wurde für die RTX 3050 lediglich noch etwas weiter eingekürzt (was man an den leer gebliebenen Stellen gut erkennen kann). Hier sind es insgesamt noch fünf einzelne Phasen (eine mehr als bei Palit, maximal wären 8 möglich), die von einem uP9512R von UPI auf der Rückseite bereitgestellt werden. Hier handelt es sich um einen recht ordentlichen digitalen PWM-Controller mit VID-Interface, kompatibel zu NVIDIAs Open VReg Spezifikation.

Diese fünf Phasen werden jeweils mit den günstigen DRMOS AOZ5332QI von Alpha & Omega Semiconductor (50 Ampere max.) realisiert, die zwar keine MOSFET DCR ermöglichen, jedoch wenigstens noch eine Temperatur-Schutzschaltung bieten. Die hier verwendeten fünf Phasen gehen wesentlich effizienter vor als die vier Phasen auf der Dual OC von Palit, so dass es auch zu deutlich weniger Verlusten kommt. Die so eingesparte Verlustleistung steht dafür wiederum der GPU zur Verfügung, denn das TDP-Korsett der Karten ist ja gleich und wird an den Anschlüssen gemessen. Jeder Verlust auf der karte geht also zu Lasten der GPU. Deshalb schafft es die Gaming X von MSI auch, mit der gleichen oder stellenweise sogar niedrigeren Leistungsaufnahme einen höheren Boost-Takt zu erreichen (bis zu 110 MHz mehr!).

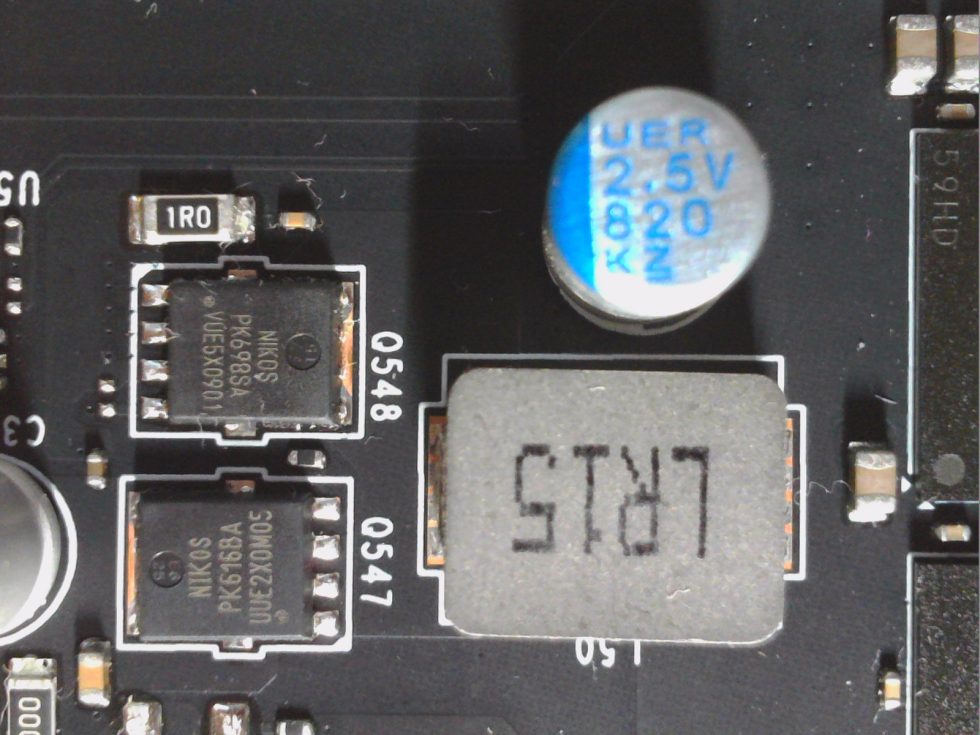

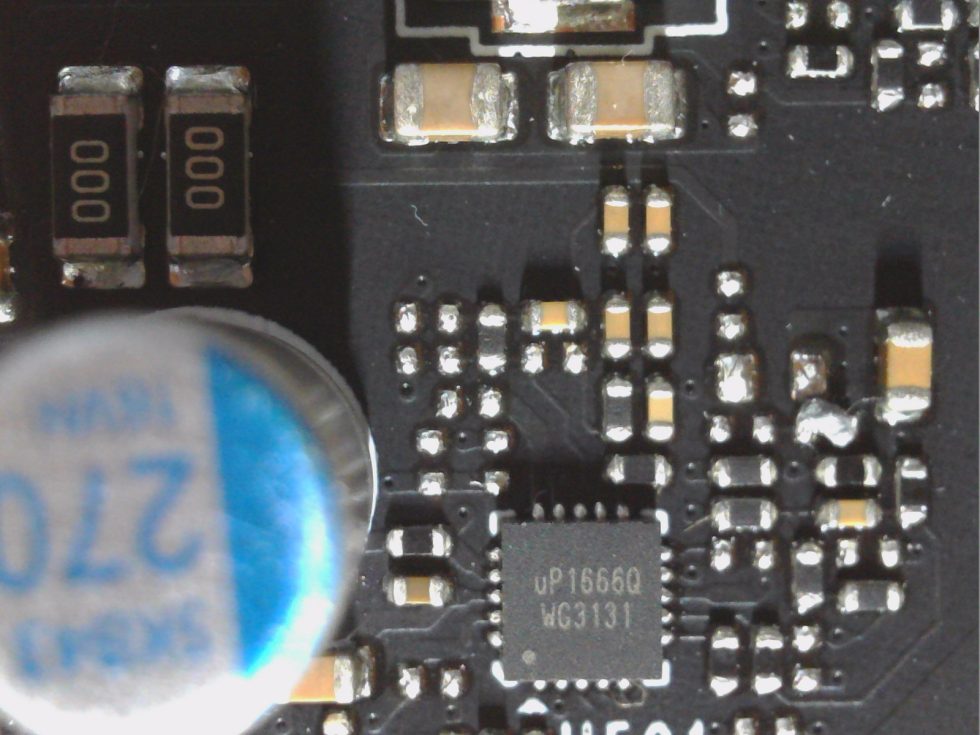

Für den genügsameren GDDR6-Speicher von Micron in Form von vier 2GB-Modulen (D9ZBM) nutzt MSI ebenfalls keinen mehrphasigen Wandler, sondern einen simplen Step-Down-Converter mit diskreter Bestückung, wobei auch hier eine eher günstige Lösung mit jeweils einem PK698SA (90 Ampere) und PK6116BA (50 Ampere) N-Channel MOSFET von Niko Semiconductur anstelle eines PowerStages hinter dem uP1666Q (Frontseite) zum Einsatz kommt. Die zweite mögliche Phase hat man bei der Karte einfach eingespart (leerer Platz rechts oberhalb der einen Phase unter der 8-Pin-Buchse).

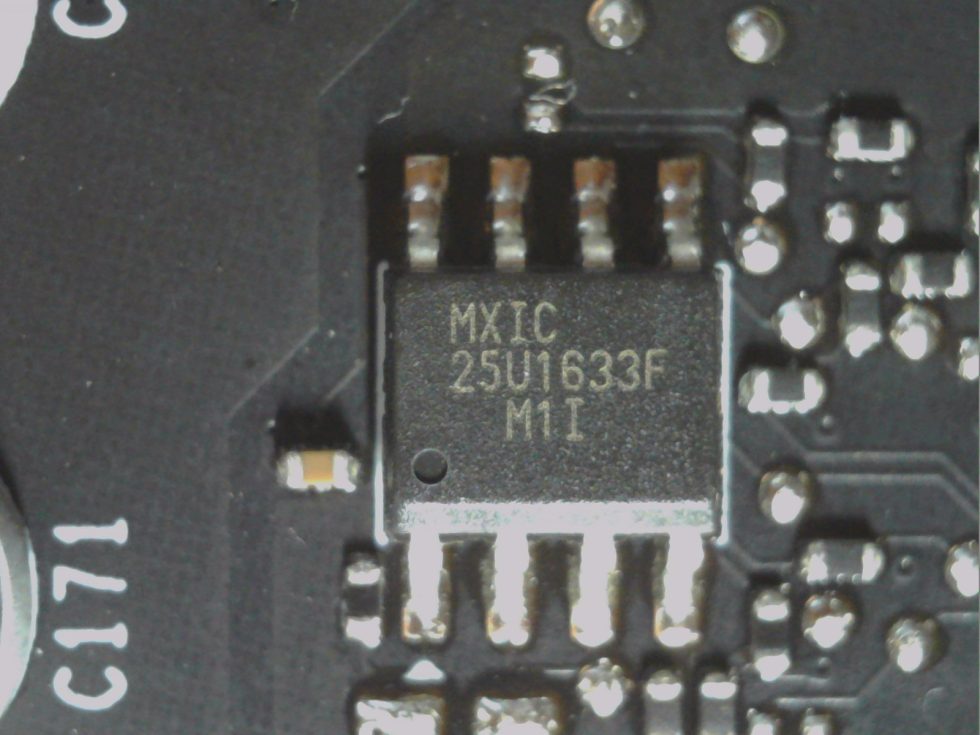

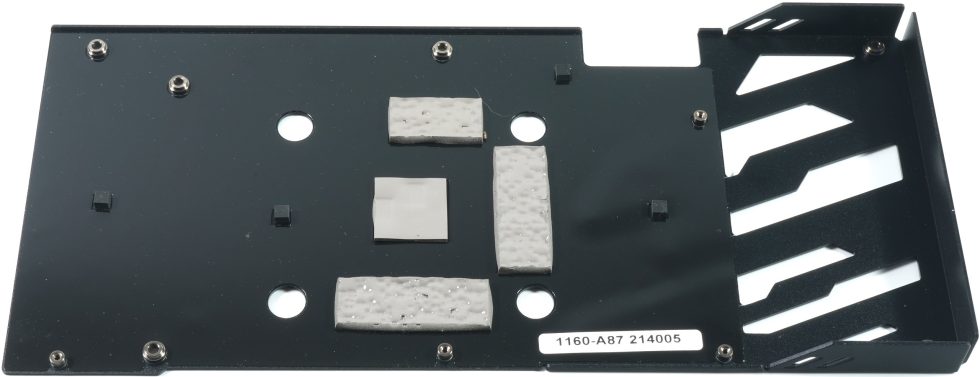

Diese simple Bestückung verwendet man auch für weitere Teilspannungen auf der Platine, was übrigens völlig ausreicht. Frontseitig gibt es noch einen einfachen Single-UEFI EEPROM zu entdecken, während die Rückseite außer dem PWM-Controller und einigen kleinen MOSFETs keinerlei interessante Bestückungen-Varianten zeigt.

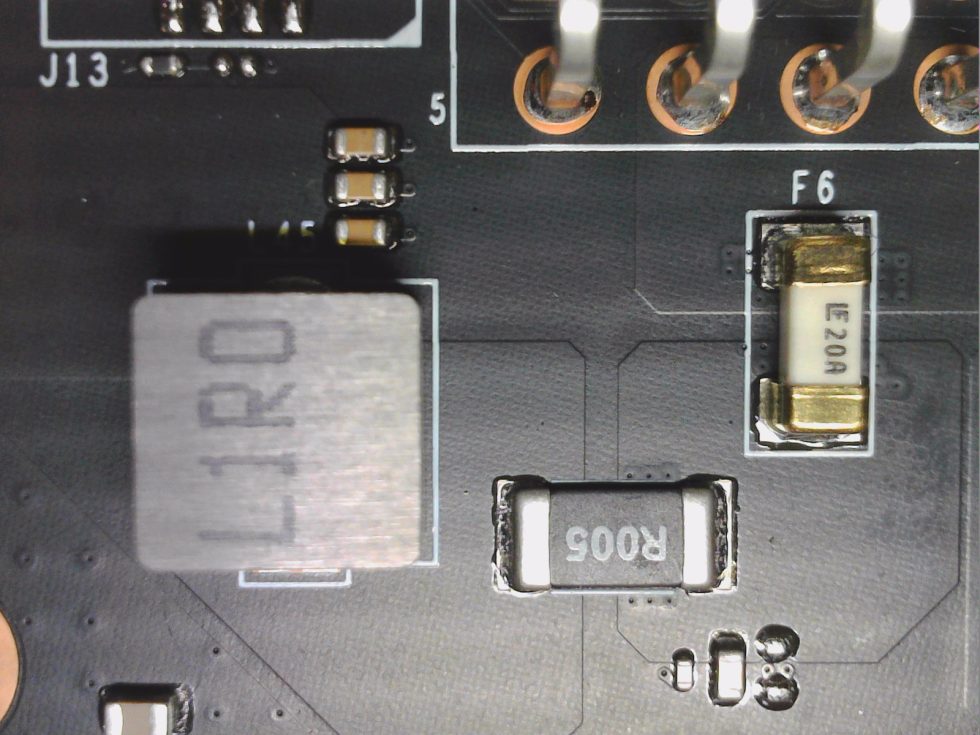

Zur Eingangsglättung nutzt man jeweils eine Spule mit 1 µH (Vorderseite) hinter denen ein Shunt (Rückseite) liegt für den 8-Pin-Anschluss, als auch für den PEG Motherboard-Slot zusammen mit einer 20A-Schmelzsicherung. Über den Spannungsabfall des Shunts misst man die fließenden Ströme. Dafür kommt ein simpler ON Semi Chip zum Einsatz. Die kleine MCU von LTE erledigt die RGB-Beleuchtung und die Lüftersteuerung. Mehr Aufreger gibt es nicht. Die nachfolgenden Bilder zeigen die erwähnten Komponenten noch einmal im Detail:

Kühler und Demontage

Die Front wird geprägt von zwei 9,5-cm-Lüftern mit jeweils 5 Doppel-Rotorblättern, die sehr leise agieren und denen auf den anderen Gaming-X-Modellen entsprechen. Mehr Besonderheiten gibt es von oben erst einmal nicht zu beobachten. Die Kühlerabdeckung sitzt auf dem Kühler und dieser wird quasi nur über die Verschraubung der GPU getragen.

Das Auseinandernehmen ist simpel. Nach dem Abschrauben der Hälfte der Schrauben der Backplate und des Stabilisierungs-Frames an der Slotblende, lässt sich auch der Kühler recht einfach komplett entfernen. Man muss nur noch die Lüfterkabel und die RGB-Lebensader abziehen. Die extrem dicken, sehr soften Pads auf den Speichermodulen und den VRM tragen dafür Sorge, sogar etwaige Fertigungstoleranzen des Packages von bis zu 0.5 mm in der Höhe noch locker ausgleichen zu können.

Wir sehen insgesamt drei vernickelte 6-mm-Heatpipes aus Kupfer-Komposit-Material, die oberhalb der GPU mit dem Heatsink rückseitig verlötet wurden wurden und von denen zwei noch einmal umlaufend den Block über GPU und VRM kühlen. Der Speicher wird über die dicken Pads vom Heatsink mitgekühlt, der Spannungswandler-Heatsink sitzt separat. Die Spulen werden hier ebenfalls mit gekühlt. Die zwei MOSFETs der einen Spannungswandler-Phase sind leider ungekühlt und man hätte sie wenigstens rückseitig thermisch an die Backplate anbinden können. Dafür habe ich später ja noch die Infrarot-Messbilder im zerlegte Zustand ohne Backplate. Die Pads sind diesmal aus einer anderen Fabrikation, so dass ich auch keine Ölspuren feststellen konnte.

Rückseitig findet man noch eine Backplate aus Leichtmetall, die diesmal kühltechnisch eine helfende Funktion erfüllt und damit nicht nur nur der Optik und Stabilisierung des Kühleraufbaus zusammen mit der Platine dient.

- 1 - Einführung und Testsystem

- 2 - Teardown, Platinenanalyse und Kühler

- 3 - Gaming Performance Full-HD

- 4 - Leistungsaufnahme und Norm-Einhaltung

- 5 - Lastspitzen (Transienten) und Netzteilempfehlung

- 6 - Temperaturen und Infrarot-Tests

- 7 - Geräuschemission / Noise

- 8 - Zusammenfassung. Features und Fazit

13 Antworten

Kommentar

Lade neue Kommentare

Veteran

Veteran

1

Mitglied

Mitglied

Veteran

Urgestein

1

Urgestein

Veteran

Urgestein

1

Veteran

Alle Kommentare lesen unter igor´sLAB Community →