Teardown

Die KFA2 GeForce RTX 4070 EX Gamer 12 GB ist nicht ganz so schnell zerlegt, weil die Verschraubung der Backplate auch von der Frontseite aus erfolgt. Das macht die Zerlegung etwas aufwändiger, zumal man auch drei statt zwei Stecker abziehen muss (2x Lüfter und LED). Aber sie gingen relativ leicht ab, aber ohne die Gefahr, von allein einfach herauszurutschen. Die Slotblende wird zwischen Platine und Backplate geschraubt und am Kühler extra arretiert. Wieso, das erkläre ich gleich noch.

PCB-Layout und Komponenten

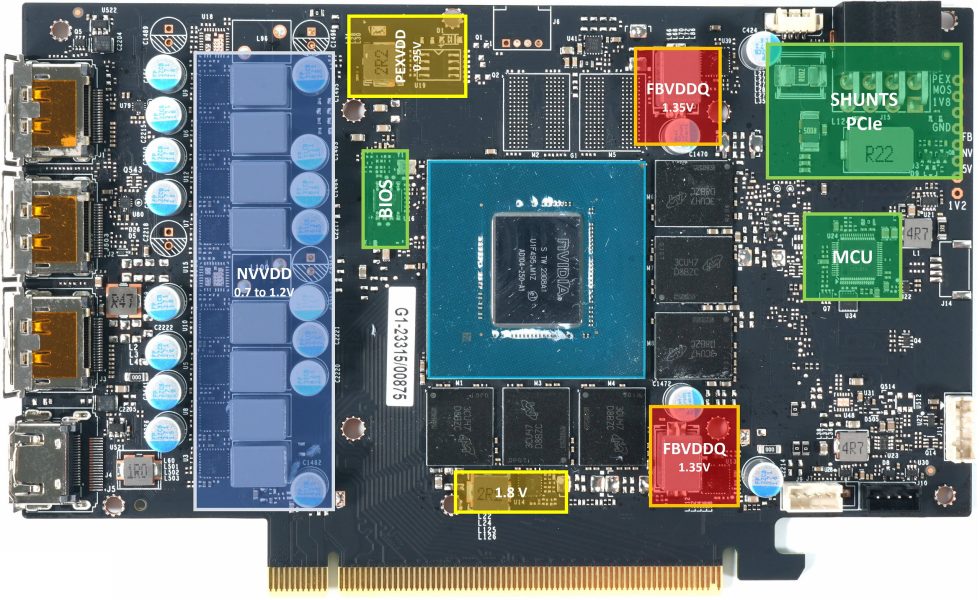

Beginnen wir zunächst wie immer mit der Platine der KFA2 GeForce RTX 4070 EX Gamer 12 GB. NVVDD ist immer noch die wichtigste Spannung und man nutzt sogar ein Spannungswandler-Design mit insgesamt 8 echten Phasen (statt 6 bei der FE und vielen MSRP-Karten) und den daraus resultierenden 8 Regelkreisen allein für NVVDD. Man spart also im Vergleich zur RTX 4070 Ti ordentlich was ein, was jedoch in Anbetracht der deutlich niedrigeren TDP noch zu akzeptieren ist.

Trotzdem besitzt die Karte eine interessante Eigenheit, denn der bei allen anderen Karten (auch der FE) einzeln oberhalb der nicht bestückten RAM-Plätze positionierte Spannungswandler entfällt komplett. Er wird durch eine zusätzliche DrMOS-Bestückung links unten in der NVVDD-Spannungswandlerreihe ersetzt. Das hat einen Vor- und einen Nachteil. Vorteil: Der Kühler wird einfacher (Heatsink kann kürzer sein) und damit günstiger. Nachteil: Diese Phase ist am Motherboardslot angebunden, was dort den Stromfluss deutlich erhöht.

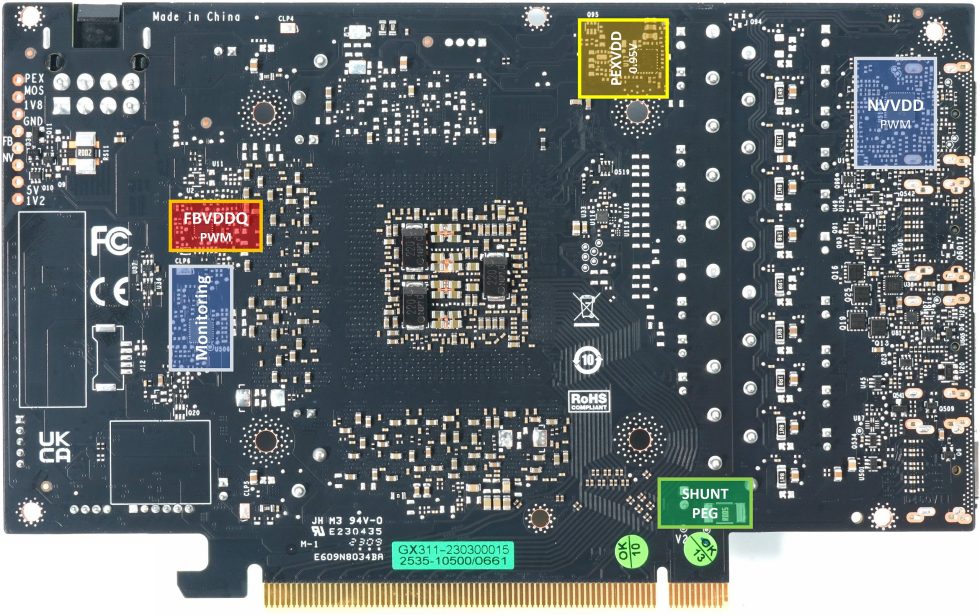

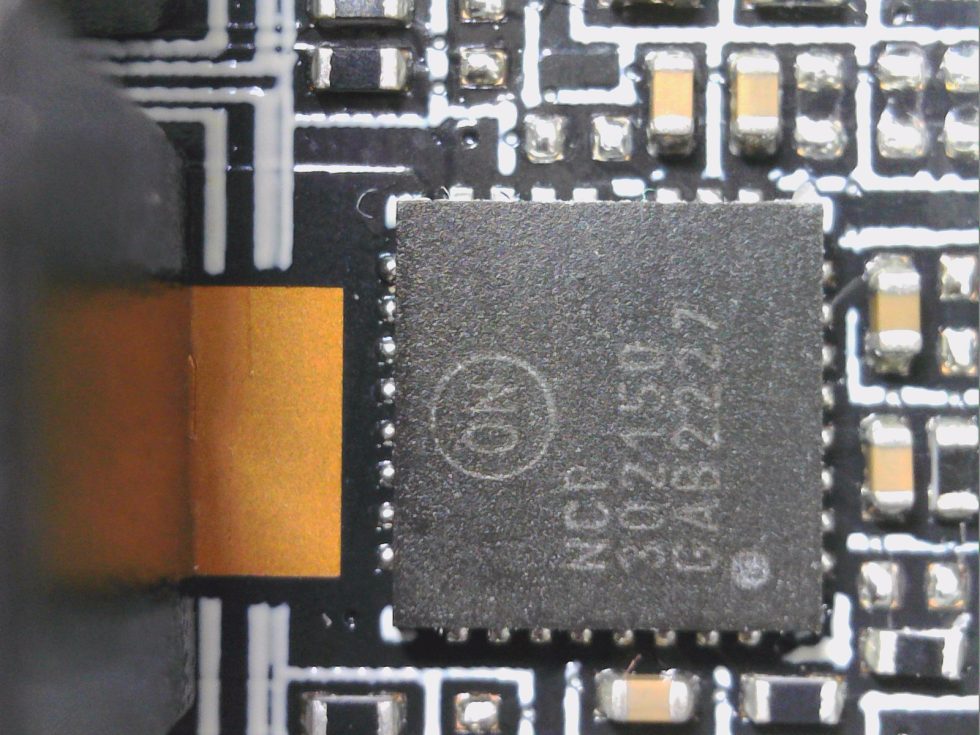

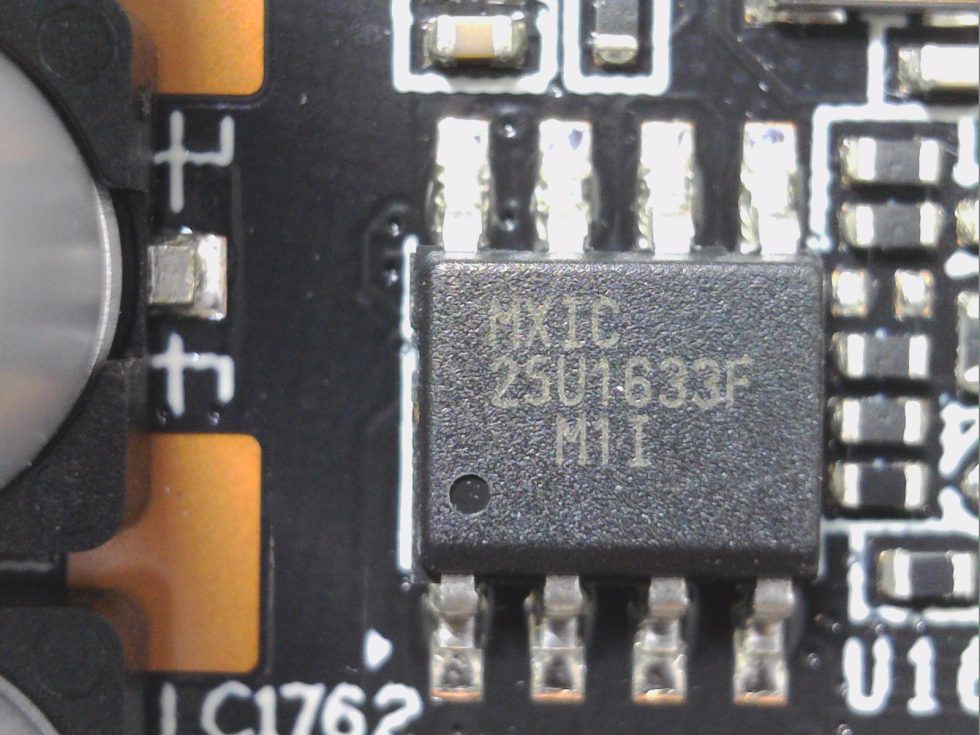

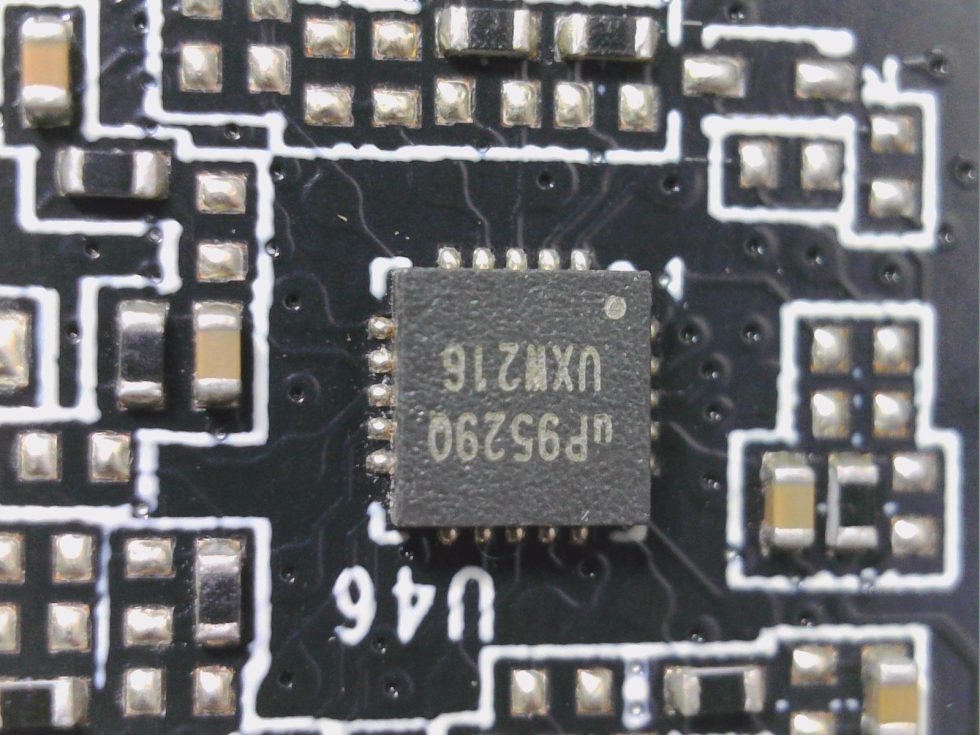

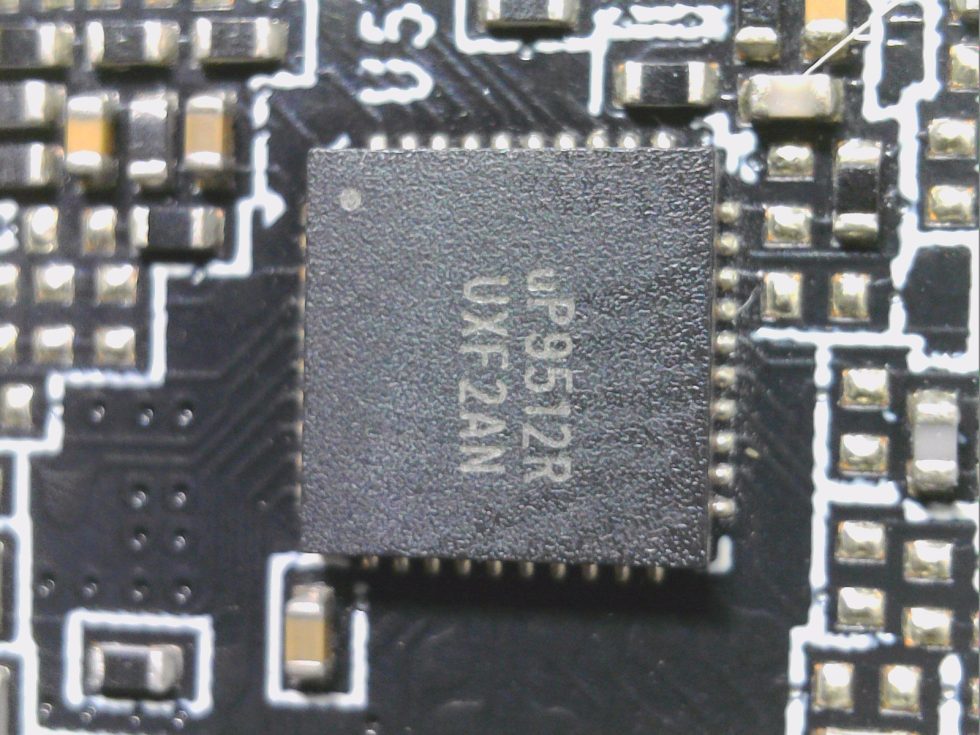

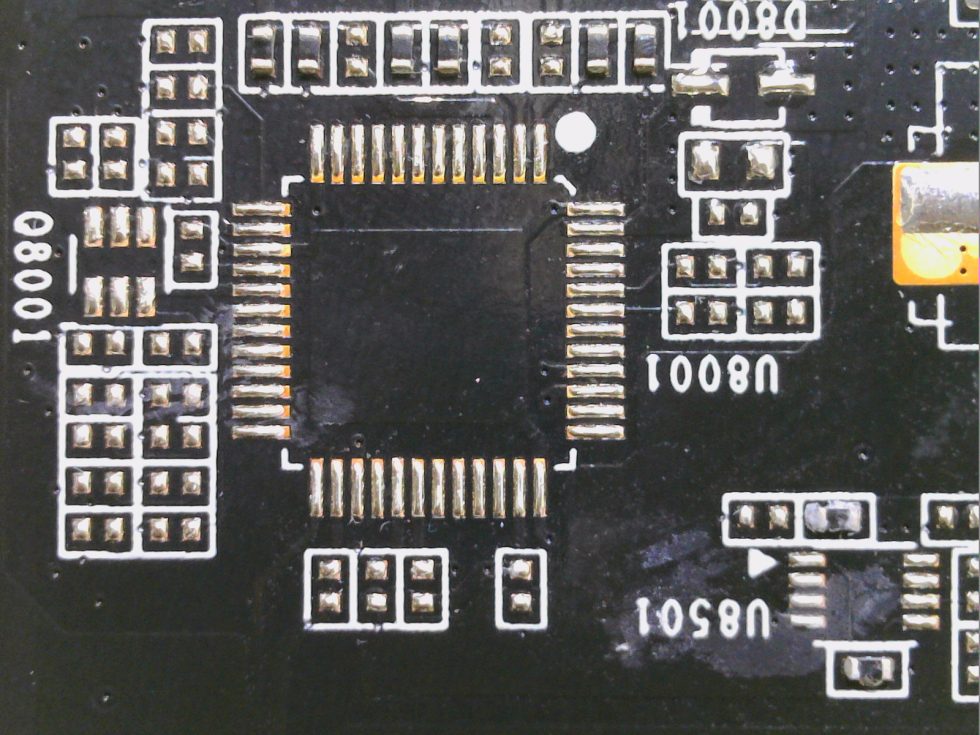

Das sieht am Ende aber alles genauso mager aus wie bei der FE, was in Anbetracht des Preises ok sein mag. Man nutzt ebenfalls getrennte PWM-Controller für NVVDD (GPU Core) und FBVDDQ (Speicher), denn die Top-Modelle unter den PWM-Controllern sind leider viel zu teuer. Und deshalb muss es wieder der gute und altbekannte uP9512R von UPI Semi richten, der die 6 Phasen locker generieren kann und deutlich günstiger ist als die Modelle von Monolith, was aber völlig ausreicht. Mit einem zweiten PWM-Controller in Form des kleinen uP9529Q steuert man dann die zwei Phasen für den Speicher an. Beide Controller befindet sich übrigens auf der Rückseite der Platine. Direkt dazwischen liegt noch ein uPI uS5650Q für die Überwachung der vier 12V-Rails (3x Aux und 1x PEG).

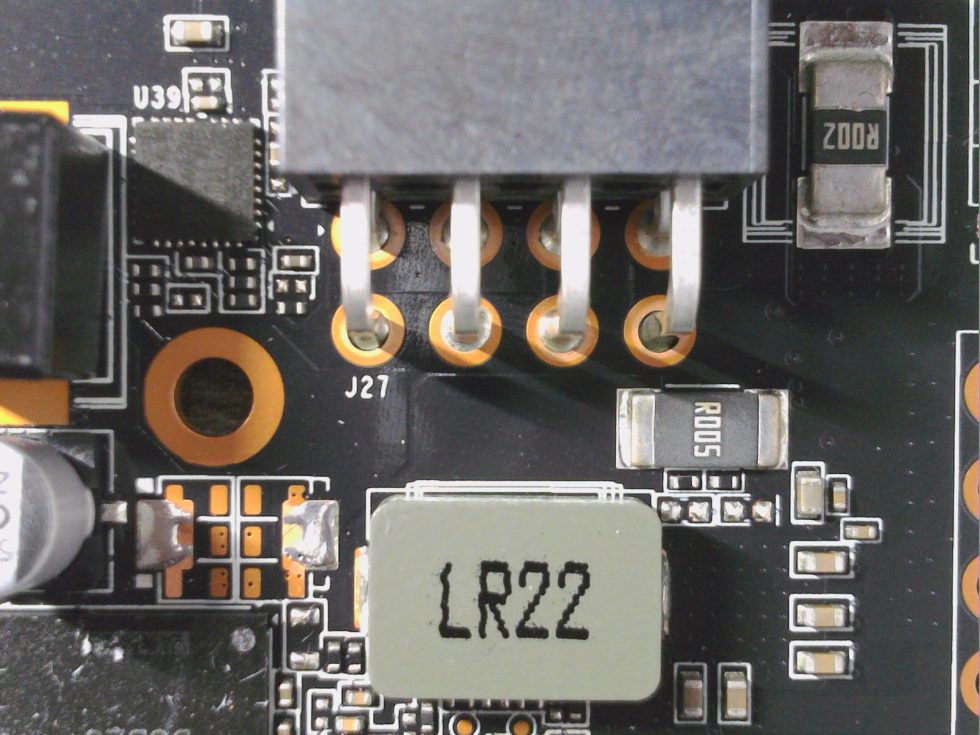

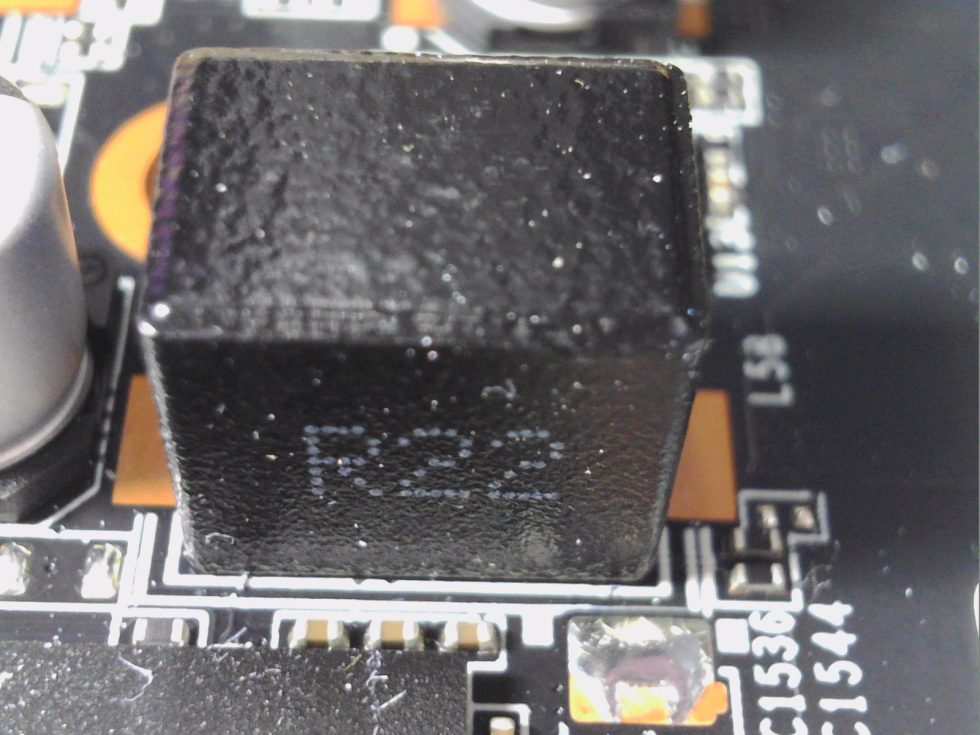

Alle verwendeten DrMOS, auch die für den Speicher, sind eher günstige Produkte von Alpha & Omega, die wir bereits von der Founders Edition kennen. Der in allen Regelkreisen für NVVDD und FBVDDQ (Speicher) genutzte AOZ5311NQI-03 mit 55 A Spitzenstrom integriert einen MOSFET-Treiber, einen High-Side-MOSFET und Low-Side-MOSFET in einem einzigen Gehäuse. Dieser Chip wurde speziell für Hochstromanwendungen wie z.B. DC-DC-Buck-Leistungswandlungsanwendungen konzipiert. Diese integrierte Lösung reduziert den Platzbedarf auf der Leiterplatte im Vergleich zu einer Lösung mit diskreten Komponenten. Die verwendeten Spulen für NVVDD und den Speicher besitzen eine Induktivität von 220 nH, die Kondensatoren sind in Becherform, was günstiger ist.

Und ich will (und muss) mal noch ein Wort zu den beliebten Listen verlieren, die im Internet gern zur Bewertung der Grafikkarten-Komponenten verwendet werden und sich nur auf die jeweils verwendeten DrMOS beziehen. Diese Listen sind nämlich reichlich wertlos und sogar irreführend, solange man nicht die verwendete Schaltfrequenz der Spannungswandler, die tatsächlichen Temperaturen und fließenden Ströme kennt und im Zusammenhang beurteilt. Denn die Maximalangaben in den Spezifikationen sind weit von dem entfernt, was im praktischen Betrieb dann auf einer Karte auftritt. Das kann, trotz gleicher DrMOS, sogar in der Bewertung von Karte zu Karte extrem unterschiedlich ausfallen und man muss schon die Messkurven zu Rate ziehen und keine theoretischen Endwerte.

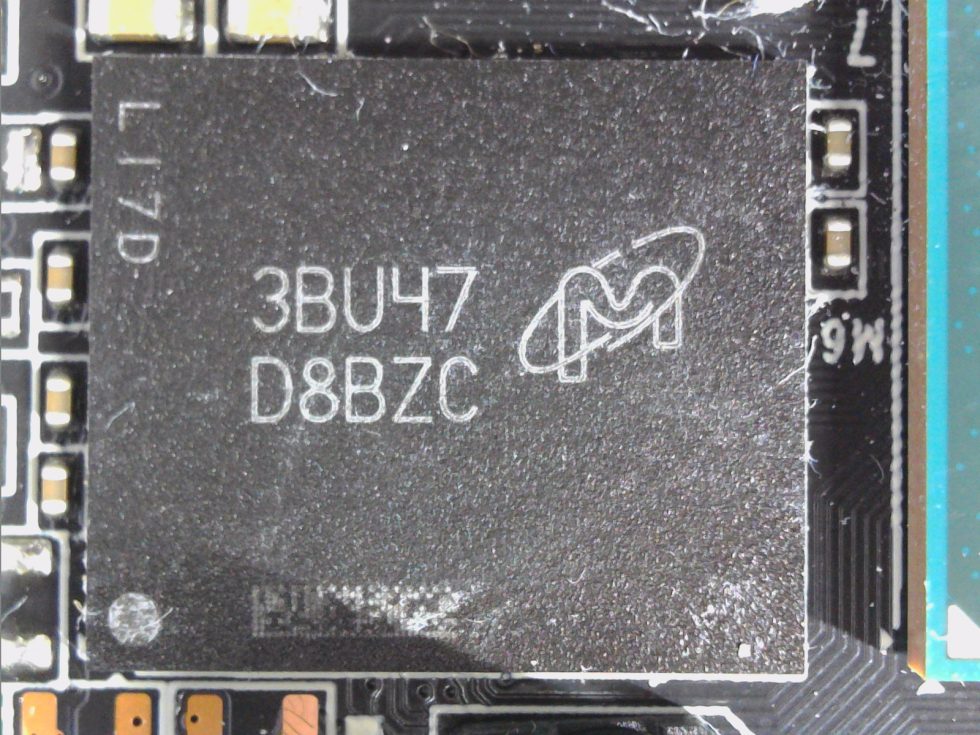

Die 12V-Rails am 8-Pin-Anschluss werden direkt nach der Buchse zu einer einzigen Rail zusammengefasst, eine weitere liegt am PEG an, und wird für NVVDD nur gering genutzt. Das BIOS liegt am gewohnten Ort und auch die Generierung der restlichen Kleinspannungen ist wie gehabt. Die GDDR6X-Speicherchips werden von Micron hergestellt und tragen die Modellnummer D8BZC, die zu MT61K512M32KPA-21:U dekodiert wird. Sie sind für eine Taktfrequenz von 1313 MHz (21 Gbps GDDR6 effektiv) spezifiziert. Mehr Besonderheiten gibt es nicht.

Teardown: Der Kühler

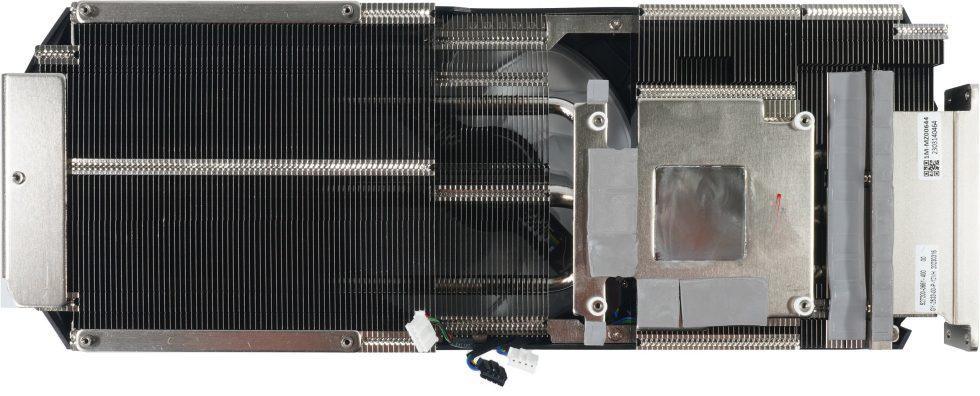

KFA2 setzt auf die üblichen günstigen RGB-Lüfter, in diesem Fall sogar drei. Zwei Lüfter mit jeweils 9 cm Rotordurmesser (Öffnung 9,2 cm) flankieren einen mittig angeordneten 10-cm-Lüfter (Öffnung 10,2 cm). Alle Lüfter besitzen jeweils 11 Rotorblätter ohne umlaufenden Ring, was einen eher breiten Luftstrom in Richtung Kühler abgibt und auch zu mehr Verwirbelungen und Verlusten am Lufteinlass und unterhalb der Kühlerabdeckung führt (Abrissgeräusche). Der Motor ist ein klein wenig knurrig, aber dazu komme ich später noch.

Insgesamt drei vernickelte Heatpipes (2x 6 mm, 1x 8 mm) aus Kupfer-Kompositmaterial führen vom Heatsink zum Ende des Kühlers, von dem ein Teil auch über die sehr kurze Platine herausragt. Hier kommt es dann zu einem gern gesehenen „Durchzug“, da keine Platine den Luftstrom ausbremsen kann. Alle Heatpipes führen dann auch noch in Richtung Slotblende. Hier sitzt auch der im Vergleich zur MSI RTX 4070 Ventus deutlich stabilere VRM-Heatsink, der seinen Job sehr gut erledigt. Auch die beiden Spannungswandler für den Speicher werden durch Kühlflächen am großen GPU-Heatsink aktiv und valide gekühlt.

Die verwendeten Pads sind ok, aber nicht aus dem obersten Regal. Etwas Cost-Down findet man also auch hier. Die Backplate aus Leichtmetall ist mit der Kühlerabdeckung und der Platine verschraubt. Das stabilisiert die Platine nahezu perfekt und bewahrt sie vorm Durchbiegen im horizontalen Aufbau. Zum Luftstrom schrieb ich ja bereits etwas und wir sehen hier noch die passende Aussparung dafür (links im Bild).

Und jetzt kommen wir noch einmal, wie versprochen, auf die Slotblende zurück. Da die Slotblende fest mit der Platine und der Backplate verbunden ist, stabilisiert KFA2 sogar mit vier Schrauben diesen Winkel zusätzlich noch mit der Kühlerabdeckung. Das garantiert einen gleichbleibend guten Anpressdruck auf die zu kühlenden Bereiche (VRM).

- 1 - Einführung, technische Daten und Technologie

- 2 - Test System im igor'sLAB MIFCOM-PC

- 3 - Teardown: PCB und Komponenten

- 4 - Gaming Performance

- 5 - Details: Leistungsaufnahme und Lastverteilung

- 6 - Lastspitzen, Kappung und Netzteilempfehlung

- 7 - Temperaturen, Taktraten und Infrarot-Analyse

- 8 - Lüfterkurven und Lautstärke

- 9 - Zusammenfassung und Fazit

96 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Mitglied

Urgestein

Veteran

1

Urgestein

Moderator

Mitglied

Mitglied

Mitglied

Mitglied

Mitglied

Mitglied

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →