Leistungsaufnahme und Normeinhaltung

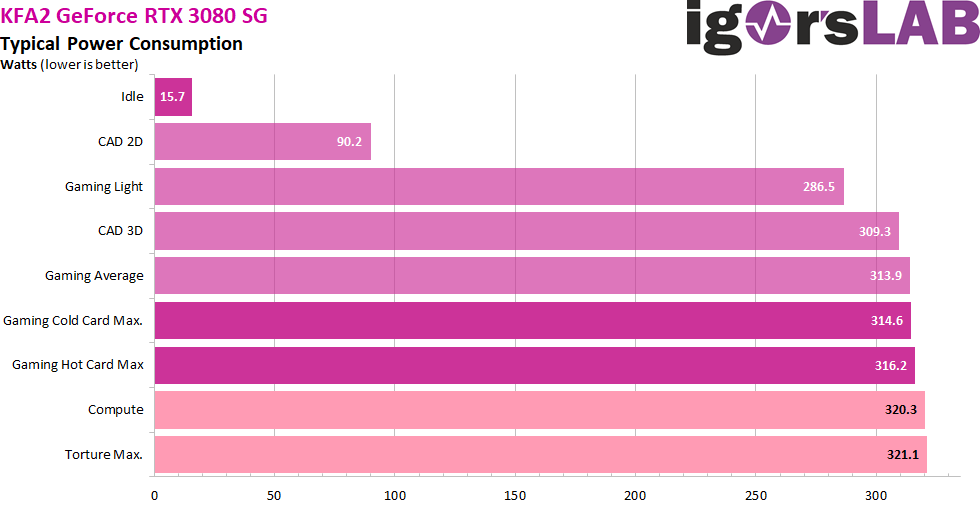

Bei der Leistungsaufnahme gibt es eigentlich keine großen Geheimnisse, denn das, was NVIDIA als TGP vorgibt, wird weitgehend auch eingehalten. Mit knapp 16 Watt im Idle liegt man im Bereich vieler Boardpartner-Karten der GeForce RTX 2070 Super bis RTX 2080 Ti, wenn auch relativ hoch. Die Teillastbereiche werden relativ sparsam realisiert, was auch am besser geregelten Takt liegen könnte. Allerdings erreicht die Karte bei echter Volllast im Witcher 3 bei Ultra-HD und voller Erwärmung dann um die 314 Watt, also 6 Watt weniger als in den Specs angegeben. Das wiederum ist jedoch die Folge der leicht abgeänderten Treiber mit geringeren Lastspitzen. Die nachfolgende Tabelle zeigt nun die Maximalwerte der jeweiligen Lastszenarien.

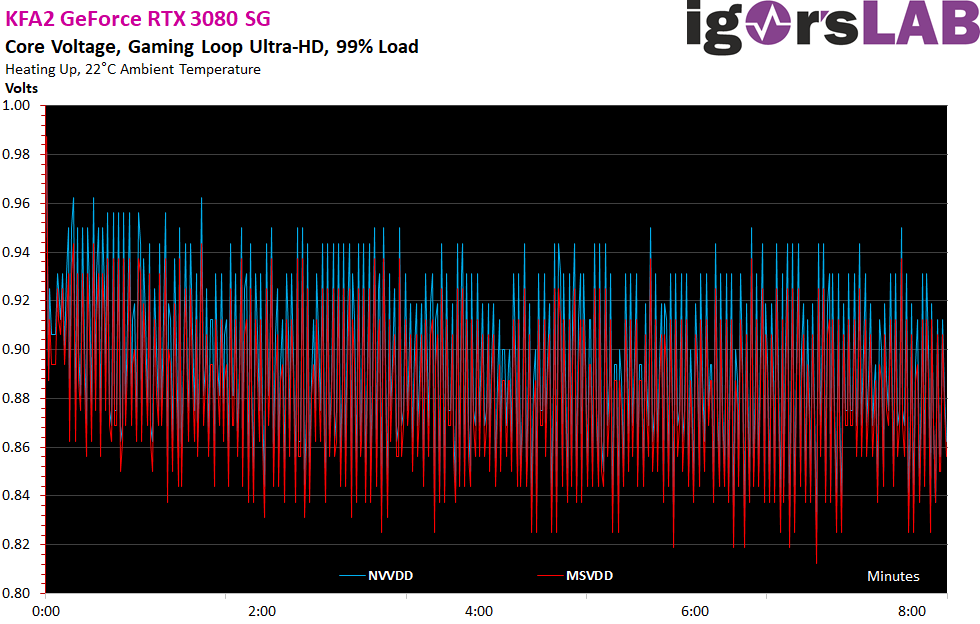

Vergleichen wir nun einmal die Voltage (NVDD vs. MSVDD). die bei Ampere (technisch gesehen) zwischen 0,7 und 1.2 Volt liegen kann und die aus Sicherheitsgründen bei den normalen Consumer-Karten auch selten die 1-Volt-Grenze reißt. Man sieht an der Kurve sehr deutlich, dass die etwas wärmere Karte mit geringeren Spannungsänderungen agiert.

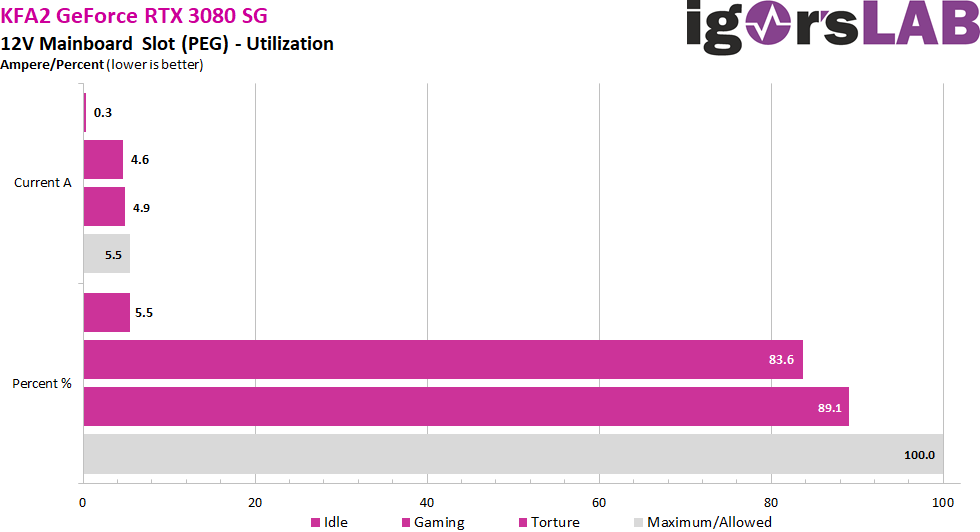

Kommen wir nun zur Auslastung des Motherboard-Slots, dessen Belastung von der PCI SIG ja mit 5.5 Ampere spezifiziert würde. Das ergibt bei 12 Volt eine maximale Leistung von 66 Watt. Man sieht sehr deutlich, dass unter voller Last wieder fast 5 Ampere erreicht werden, was natürlich zulässig ist. Aber es ist trotzdem deutlich mehr als noch bei den meisten Turing-Karten, wohl auch, um den 12-Pin Anschluss der 12-Volt-Schiene zu entlasten.

Transienten und Netzteilempfehlung

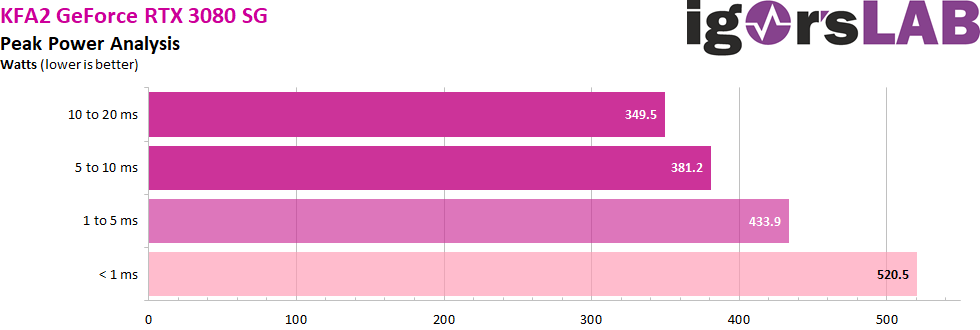

Wie ich in meinem Grundlagenartikel “Der Kampf von Grafikkarte gegen Netzteil – Leistungsaufnahme und Lastspitzen entmystifiziert” bereits ausführlich nachgewiesen habe, existieren durchaus auch kurzzeitig höhere Lasten im Millisekundenbereich, die bei ungünstig entworfenen oder nicht zweckmäßig bestückten Netzteilen bereits zu unerklärlichen Abschaltungen führen können. Da hilft dann allein die vom Grafikkartenhersteller oder den Reviewern gemessene TBP (Typical Board Power) für eine stabile Auslegung des Systems nicht wirklich weiter.

Spitzen mit Intervallen zwischen 1 bis 10 ms können bei sehr schnell reagierenden Schutzschaltungen (OPP, OCP) vor allem bei Multi-Rail-Netzteilen zu Abschaltungen führen, obwohl die durchschnittliche Leistungsaufnahme noch in der Norm liegt. Für diese Karte würde ich deshalb beim Normal-OC als Grafikkarten-Last mindestens 430 bis 450 Watt anteilig an der sekundärseitigen Gesamtleistungsaufnahme des Systems kalkulieren, um genügend Reserven für den Fall der Fälle zu besitzen. Einen kurzen Auszug mit höher Auflösung zeigen uns nun die 20-ms-Messungen (10 μS Intervalle), wie ich sie automatisiert zur Wertermittlung laufen lasse:

Das Lastwechselverhalten mit altem und neuem Treiber

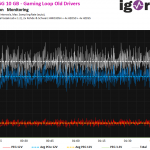

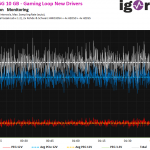

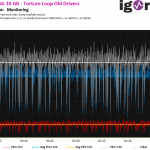

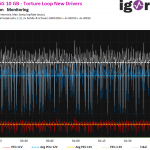

Zunächst habe ich die Leistungsaufnahme beim Gaming Loop verglichen. Das Power Limit der Grafikkarte liegt bei 320 Watt, erreicht habe ich beim alten Treiber 318 Watt. Beim neuen Treiber waren es mit 314 Watt dann 4 Watt weniger. Das ist als Differenz weniger als vermutet, setzt aber wirklich ein ordentliches Equipment voraus, das wirklich fast alle Lastwerte erfasst. Je gröber die Auflösung, um so schwankender waren dann sogar die Messungen mit derselben Karte im selben Savegame. Alles ab ca. 10 ms als Intervallgrenze war einfach nicht mehr sauber zu gebrauchen, um überhaupt von ordentlichen Toleranzbereichen sprechen zu können.

Das Problem dieser Auflösung mit 20 ms ist allerdings, dass man die richtigen Spikes auch nicht sieht, weil sie in der gemittelten Erfassung untergehen und schlichtweg kaputt kumuliert werden. Wechseln wir deshalb einmal in den Mikrosekundenbereich, wo ja auch NVIDIAS Boost agiert. Und siehe da, die Spikes sind jetzt auch deutlich sichtbar. Genau hier sehen wir nun auch den eigentlichen Unterschied bei den Spikes! Waren es mit dem alten Treiber öfters mal zwischen 580 und 600 Watt, sind es nun plötzlich mindestens 70 Watt weniger und auch die Ausprägung und Häufigkeit nehmen stark ab! Wir sehen also sehr gut, wo die fehlenden 4 Watt geblieben sind. Nicht im Durchschnitt, nein, sondern überwiegend in den maximalen Spitzen! Das ist auch einer der Gründe, warum die Performance-Einbuße am Ende wohl doch überschaubar klein ausfallen dürfte. Regelwut eingebremst, sichtbar.

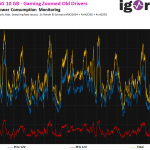

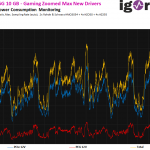

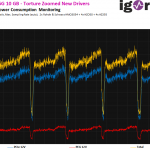

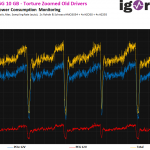

Beim Stresstest sieht man die Unterschiede auf eine andere Art und Weise, denn da helfen uns interessanterweise die 20 ms Intervalle rein optisch sogar besser weiter. Wir sehen im direkten Vergleich, dass die Intervalle der Leistungsbegrenzung deutlich kleiner geworden sind, die Karte also viel schneller auf vermeintliche oder reale Überlasten reagiert. Vergleichen wir zunächst die großen Intervalle und achten einmal auf die Abstände und Form der Einbrüche:

Wo diese Einbrüche herkommen, zeigt und die analog zum Boost mitlaufende Messung im Mikrosekundenbereich, wo man auch den Selbstschutz sehr schön sehen kann:

Kommentieren