NVIDIA macht alles richtig, eigentlich…

NVIDIAs Überwachung erfolgt auf der Platine an den jeweiligen 12-Volt-Schienen, also an den jeweiligen externen PCIe-Buchsen (Aux) und dem Motherboard-Slot (PEG), BEVOR die jeweiligen Verbraucher versorgt werden. Man erledigt diese Aufgabe, so ähnlich wie in meinem bereits gezeigten Messaufbau, mit sogenannten Shunts im Eingangsbereich gleich vor der Filterung direkt an den jeweiligen Schienen. Die eingesetzten, sehr niederohmigen Längs-Widerstände (Shunts) erzeugen einen kleinen Spannungsabfall, der durch zwei Spannungsabgriffe (vor und nach dem Widerstand) ermöglicht wird. Die hier anfallenden ca. 1,5 bis 5 Watt (je nach den fließenden Strömen) fallen noch nicht ins TBP-Budget (Power Limit) der Grafikkarte.

Berechnet wird das Ganze dann mit einem geeigneten Monitoring Chip, der meist bis zu vier Kanäle überwachen kann. Aus der Spannungsdifferenz kann man auf den fließenden Strom und zusammen mit der Ausgangsspannung hinter dem Shunt sogar auf die Leistungaufnahme in Watt (W) schließen. Das Ganze ist also im Grunde genommen nichts anderes als mein bereits gezeigter Messaufbau und damit auch für die GESAMTE Karte gültig!

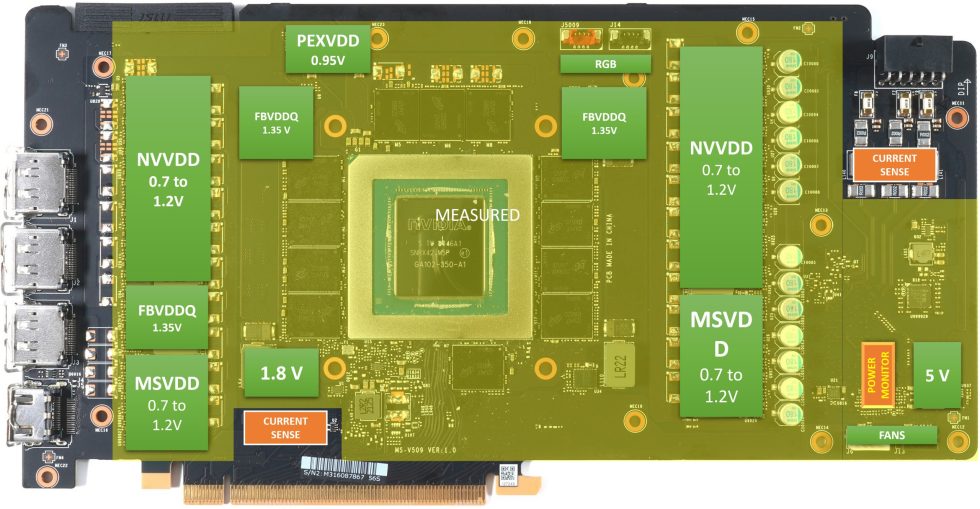

Betrachten wir nun einmal die Grafikkarte als Schema. Wir sehen hier als „Current Sense“ die beiden Stellen, wo die Ströme (und Spannungen) erfasst werden und wo dann im „Power Monitor“ die Daten für die Firmware zur Einhaltung des Power Budgets generiert werden. Wir sehen im gelb markierten Bereich, dass sowohl die GPU, also auch der Speicher und alle anderen Verbraucher einschließlich deren Spannungswandler (und deren Verluste), sowie die Verluste aller Komponenten und sogar der Platine mit einbezogen werden. Unter Total Board Power (TBP) versteht NVIDIA somit die Leistungsaufnahme der gesamten Grafikkarte einschließlich der Lüfter und RGB-Spielereien!

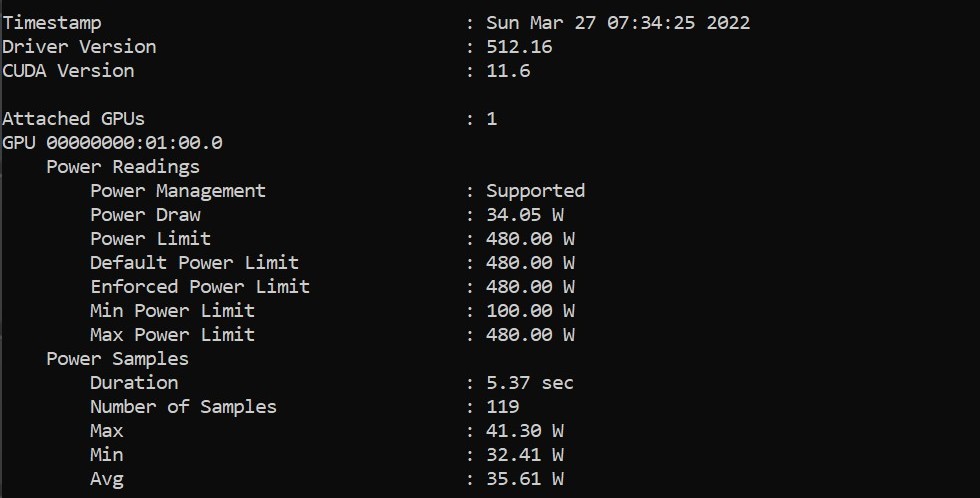

Die Firmware (und natürlich damit Boost) können jetzt dafür sorgen, dass dieser Maximalwert nie für längere Zeit überschritten wird und auch in der Summe in einem größeren Intervall wieder der Vorgabewert eingehalten wird. All diese Werte lassen sich über die NVAPI (Programierer-Schnittstelle) recht einfach auslesen und verwerten. Hier sieht man auch, welcher Maximal- bzw. Minimalwert zulässig ist bzw. gerade eingestellt wurde. An diesen Werten orientieren sich auch Programme wie der MSI Afterburner, wenn es um die Anfangs- und Endwerte des Slider für das zu wählende Power Target geht. Im schimmsten Fall ist das eingestellte Power Target gleich dem in der Firmware hinterlegten Max Power Limit und man kann nichts mehr manuell erhöhen.

Warum bei heißen Karten die Performance stark sinkt

Wir kennen den Effekt, dass bei voll aufgewärmten NVIDIA-Karten (vor allem bei schlechterer Kühlung) der Takt (und damit auch die Performance) stärker sinken, als es bei meist AMD-Grafikkarten zu beobachten ist. Das wiederum liegt an der Art und Weise, wie NVIDIA sein sehr restriktives Power Budget verwaltet. Meist schiebt man das Fehlen der höchsten Boost-Steps bei aufgewärmten Karten auf die GPU und die Leckströme, was aber nur ein Teil der Wahrheit ist. Der kleinste wohlgemerkt, denn die größten Verluste fahren die heißen Spannnungswandler ein!

Dass man Spannungswandler möglichst gut kühlen muss, ist vielen nicht sonderlich bewusst. Doch die Verluste, die hier auftreten, sind enorm! Arbeitet eine normale Regelung mit Smart Power Stages (SPS) oder DrMOS für NVVDD/MSVDD (also die GPU) meist mit einem Wirkungsgrad von 85% und höher, wenn die Karte kalt ist, sinkt dieser Wirkungsgrad auf bis zu 80%, falls die Spannungswandler heiß werden. Je effizienter und höherwertiger diese Komponenten sind, umso kleiner ist dieser Effekt. Mit einer diskret aufgebauten Low- und High-Side aus Einzel-MOSFETs sowie separaten Gate-Treibern erreichen manche Karten noch nicht einmal 80% im kalten Zustand und dieser Wert kann dann sogar noch auf unter 75% absinken! Alles das, was hier an Leistung verloren und bereits in Wärme umgewandelt wird, geht der GPU später verloren. Das gilt auch für alle andere Komponenten, die eine Verlustleistung erzeugen, egal, wo sie sich auf der Platine befinden.

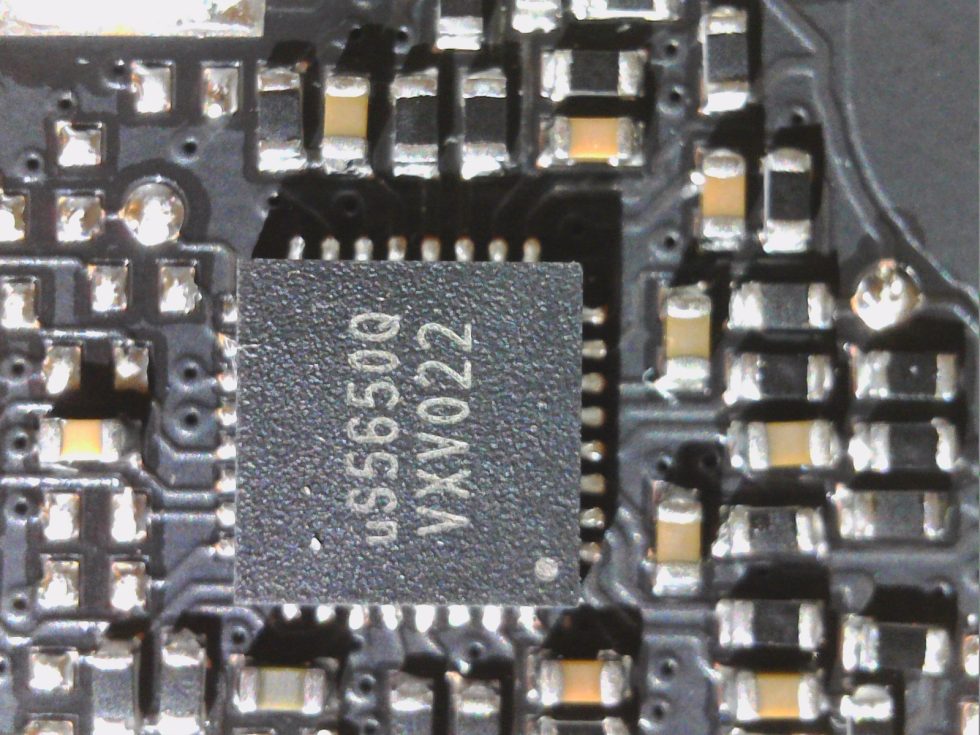

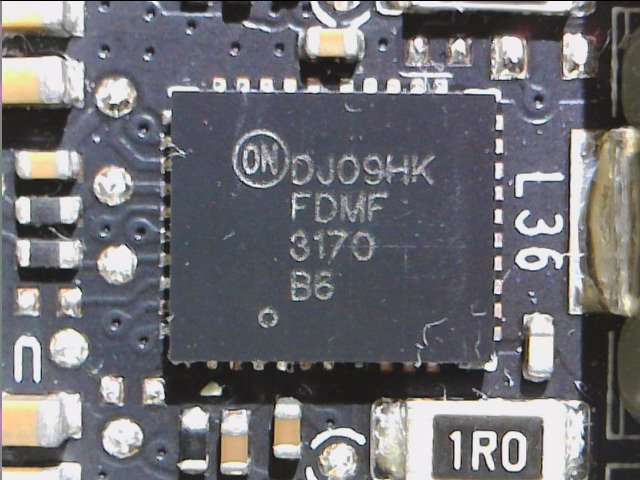

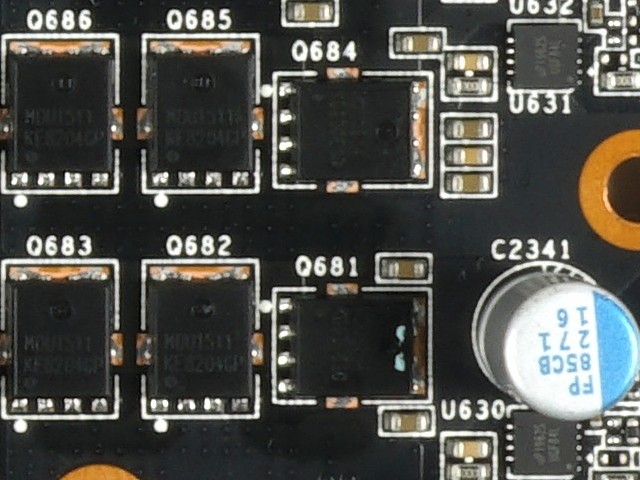

Nicht ganz zufällig ist Nvidia vom sogenannten Phase-Doubling wieder abgerückt, wo die bis zu acht echten Phasen, die so ein PWM-Controller bereitstellen kann, mittels sogenannter Doubler-Chips quasi verdoppelt wurden, indem man die neu generierte Phase einfach phasenverschoben ansteuert. Mittlerweile gibt es jedoch auch PWM-Controller, die den parallelen und damit phasengleichen Betrieb mehrerer Spannungswandlerkreise erlauben. Im nachfolgenden Bild sehen wir links einen hochintegrierten Smart Power Stage (SPS) mit integrierter High- und Low-Side, sowie Gate-Treiber und Schottky-Diode. Rechts sehen wir zwei diskret aufgebaute Phasen mit jeweils einem MOSFET auf der High-Side (Q681 und Q684) und einem parallel arbeitenden Paar auf der Low-Side (Q686+Q685 und Q683+Q682), sowie jeweils einen externen Gate-Treiber (U630 und U631)

Da man aber nicht mit Kondensatoren allein auskommt, um eine qualitativ hochwertige und rippelfreie Spannung am Ende der PWM-Nodes hinzubekommen (siehe auch Wirkungsweise eines Schaltnetzteils), wird der Ausgang des Spannungswandlerkreises mit einem LC-Glied (Spule + Kondensator) abgeschlossen. Diese Spulen, welche die kurzeitig geladene Energie abspeichern und dann wieder freigeben, haben sowohl einen elektrischen als auch einen induktiven Widerstand, der die Effizienz noch einmal deutlich nach unten drückt. Klingt als Problem unlösbar, und das ist es übrigens auch, denn man kann ja die Querschnitte der Wicklungen nicht endlos erhöhen, um zumindest den ohmschen Widerstand zu senken. Zumal die Induktivität ja bleibt. Im Bild unten sehen wir links eine typische Spule für die GPU-Phase und recht eine mit höherer Induktivität für den Speicher. Obwohl man auch dafür mittlerweile wieder niedrigere Werte nutzt.

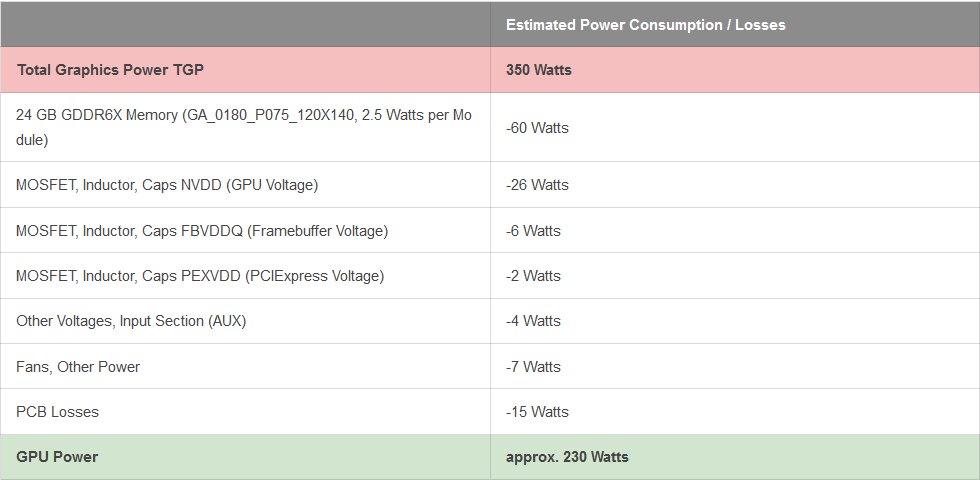

Dazu kommen natürlich noch Gleichlauf- und Balancing-Probleme, je mehr Phasen man so verdongelt. Mittlerweile sind jedoch die PWM-Controller in der Lage, bei Niedrig- und Teillasten die Auslastung und Nutzung der Phasen intelligent zu steuern. Doch wie wirkt sich das alles auf die GPU selbst aus? Eine Karte, die z.B. insgesamt 350 Watt an Leistung aufnimmt (Beispiel einer GeForce RTX 3090 FE), kann im kalten Zustand effektiv davon 230 Watt nutzen. Sinkt der Wirkungsgard aller verbauten Spannungswandler durch eine extreme Erwärmung stark ab, sind das noch 200 bis 210 Watt, die verbleiben!

Das Auslesen per Software ist möglich und plausibel

Die gute Seite an NVIDIAs Kontroll und Begrenzungs-Wahn ist der Umstand, dass man die Werte der Leistungs-Begrenzung und -Überwachung mittels Software recht einfach und auch genau auslesen kann. Die sehr groben Intervalle lassen zwar keine Aussagen über Lastspitzen zu, aber wenn man über einen langen Zeitraum protokolliert, ist das Ergebnis kaum anders als das, was ich mit viel aufwändigerer Technik im gleichlangen Zeitraum als Langzeitwert messen kann. Hier kann man den Ergebnissen des aktuellen MSI-Afterburners, von GPU-Z und HWInfo also gut vertrauen. dazu später noch mehr.

657 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Urgestein

Veteran

Mitglied

Veteran

Urgestein

Urgestein

Urgestein

1

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →