Da auch heute noch viele Anwender und vor allem auch YouTuber sowie Twitcher die Werte, die Tools wie der MSI Afterburner oder auch AMDs Radeon-Software für die Leistungsaufnahme iherer Grafikkarte als bare Münze nehmen, muss ich doch noch einmal nachlegen. Die Unmengen an Videos, die zeigen sollen, um wie viel „sparsamer“ die Grafikkarte A gegenüber der Grafikkarte B sein soll, bringen diejenigen, die es besser wissen (und können) immer noch reihenweise zum Weinen. Lustige Randnotiz: Selbst NVIDIA vertreibt heute unter Redaktionen und einschlägigen Videoschaffenden mit PCAT ein Tool, das der Wahrheitsfindung bei der Leistungsaufnahme von Grafikkarten dient. So recht geholfen hat es bisher aber eher weniger, leider.

Und weil immer wieder Fragen aufkamen, warum die von mir in Spielen gemessenen Werte von den Herstellerangaben (TBP) für die gesamte Grafikkarte so abweichen, habe ich einen bestehenden Artikel etwas überarbeitet und zudem ein neues Kapitel vorangestellt. Hier analysiere ich zunächst 11 Spiele mit und ohne Raytracing-Last in Ultra-HD (mit und ohne DLSS/FSR) für die meisten relevanten Karten, die wir auch noch aus dem Launchartikel zur NVIDIA GeForce RTX 4090 24 GB kennen. Denn des Ergebnis ist durchaus interessant. Abweichend zum letzten Test habe die Radeon RX 6950XT mit einem Referenz-BIOS laufen lassen, weil es sonst die Messungen etwas verzerrt hätte.

Wir werden uns nach dieser Einführung auch primär mit dem Lösungsansatz beider Hersteller befassen, was die Ermittlung und das Logging der Leistungsaufnahme betrifft, denn hier gibt es immer noch jede Menge Nachholbedarf. Software-Tools und AMD-Karten sind schon immer ein leidiges Problem, aber dazu später mehr. Denn man kann Radeons natürlich ordentlich an den Stromzuführungen messen, aber eben nicht sauber auslesen. Das, was alle Tools anzeigen, ist leider nicht alles, was durch die Leitungen geht. Aber dazu ab der nächsten Seite gleich mehr.

450-Watt-Karte ungleich 450-Watt-Karte!

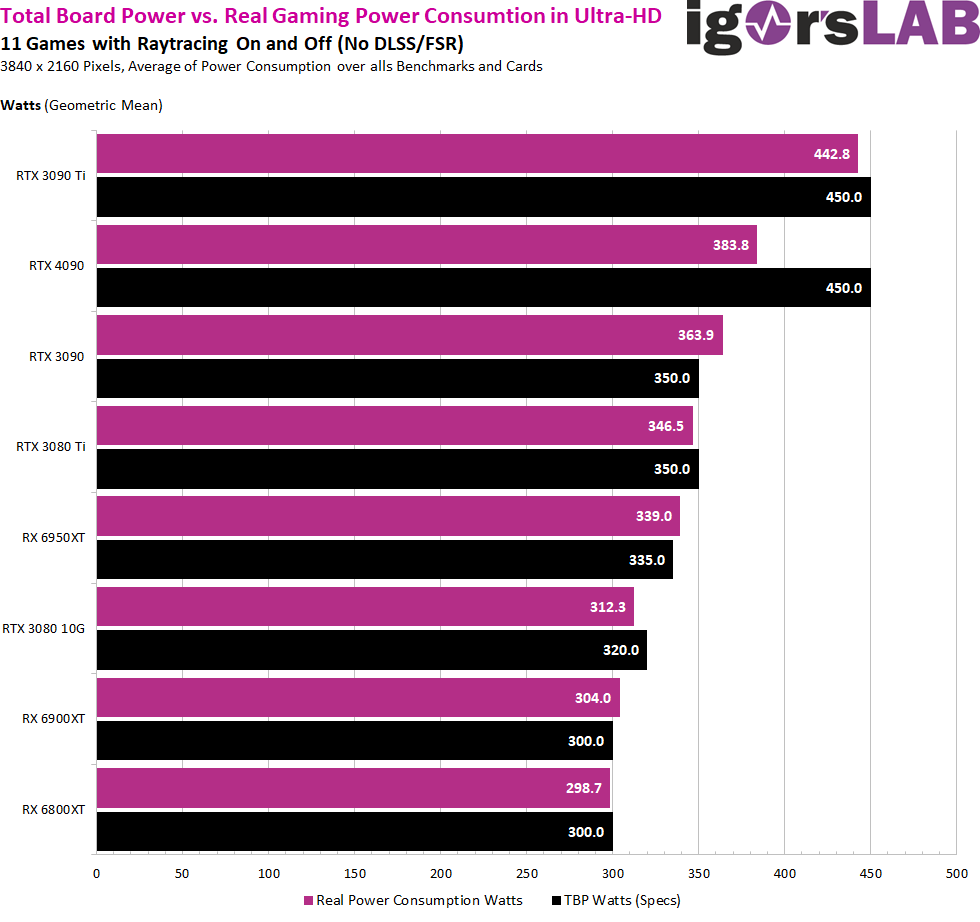

Wenn wir uns die erste Grafik anschauen, dann sehen wir, dass die GeForce RTX 3090 Ti mit 450 Watt Power Limit (TBP) eine echte 450-Watt-Karte ist, die diese Leistungsaufnahme auch im Gaming leider voll erreicht. Die so oft (völlig zu Unrecht) gescholtene GeForce RTX 4090 ist allerdings beim Gaming eher eine 380-Watt-Karte, die den verfügbaren Leistungsspielraum nur dann überhaupt ausnutzt, wenn man Stresstests laufen lässt oder reines Compute auf den Shadern betreibt!

Bei Ada hat NVIDIA im Gegensatz zu den eigenen Ampere-Karten und zu AMD einen extremen Puffer eingebaut, der zwar stellenweise erreicht werden kann, aber normalerweise nicht in jeder Anwendung erreicht wird. Jedes Spiel ist da anders und es gibt auch hier extreme Beispiele, die ordentlich Leistung abverlangen. Aber in der ganzen Bandbreite der Anwendungen sind Durchschnittswerte stets die objektivste Aussage. Denn man fährt ja auch nicht im realen Leben immer nur steil bergauf.

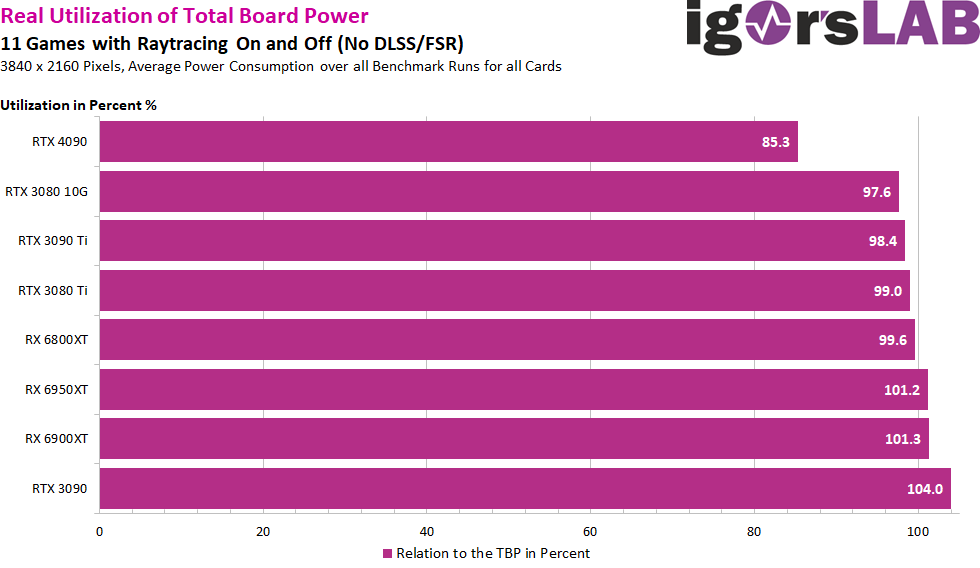

Bei allen anderen Karten liegen Hersteller-Angaben und Leistungsaufnahme im UHD-Gaming mit 98 bis 99% GPU-Last sehr nah an der angegebenen TBP bzw. überschreiten diese sogar leicht (die letzten drei Karten in den Charts unten). Aber es sind Abweichungen im niedrigen einstelligen Prozentbereich. Für die noch nicht gelaunchte GeForce 4080 16GB kann man aus NDA-Gründen nur den Taschenrechner zücken und TBP sowie die reale Messung ins Verhältnis setzen. Dann hieße es 274 Watt im Gaming für diese mit 320 Watt angegebene neue Karte. Das wird nicht ganz reichen, denn der Chip sollte auf Grund der geringeren Größe und Shaderanzahl höher takten und damit etwas ineffizienter werden. Doch um die 280 Watt könnten es dann durchaus werden. Rein spekulativ.

Da AMDs Karten bisher die angegebene TBP in Ultra-HD immer erreicht haben, könnte man durchaus annehmen, dass es auch bei der Radeon 7900XTX bzw. RX 7900XT der Fall sein könnte. Nur stellt sich eben die Frage, ob es auch AMD gelungen ist, ein ähnlich breites Fenster bei der tatsächlichen Leistungsaufnahme zu ermöglichen. Denn nur dann wäre die Karte der GeForce RTX 4080 an der Steckdose im täglichen Einsatz gewachsen. Hier wird man wirklich mehrmals und genauer hinsehen müssen, wie effizient beide Kontrahentinnen wirklich agieren können.

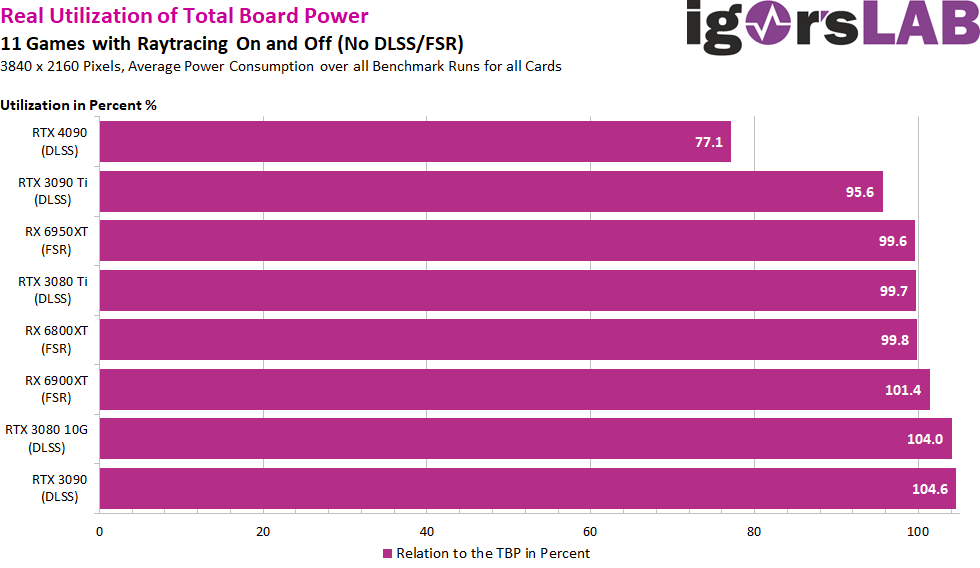

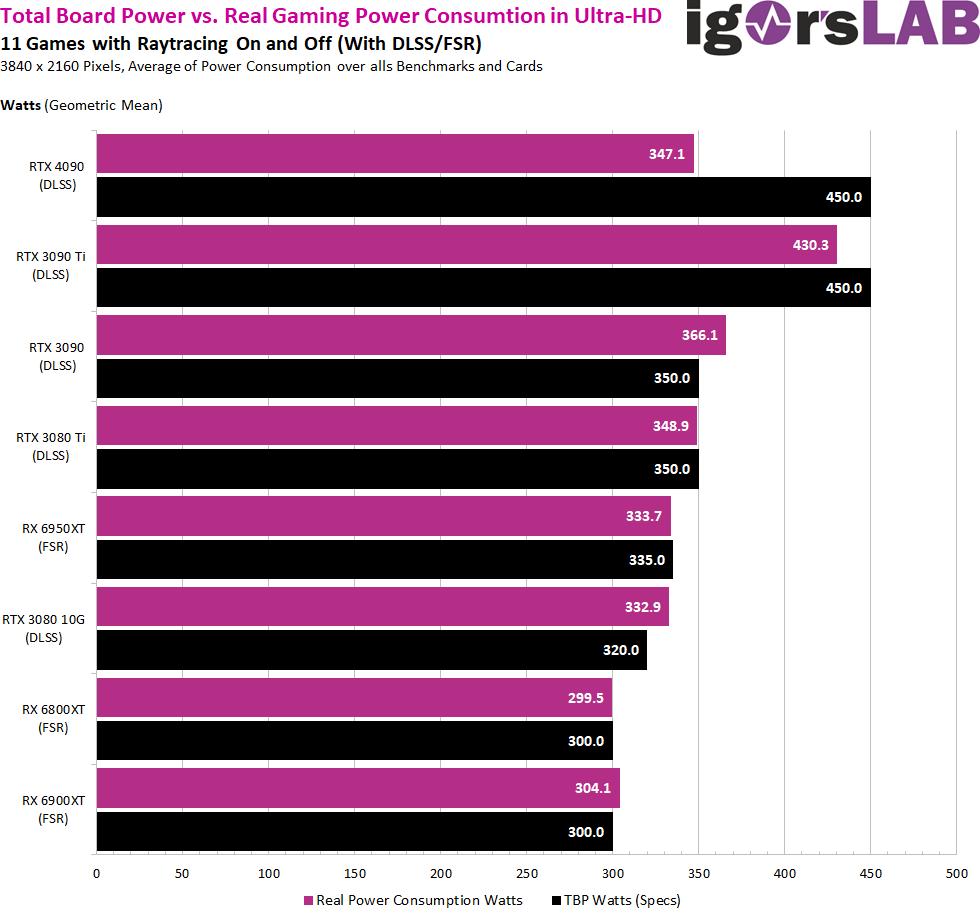

Mit Bildbeschleunigungs-Verfahren wie DLSS, FSR oder XeSS wird aus der 450-Watt-Karte in Form der GeForce RTX 4090 eine (auch den Durchschnitt bezogene) 350-Watt-Karte, während sich die GeForce RTX 3090 Ti nicht aus der 400-Watt-Zone lösen kann. Die anderen Karten liegen hier wieder in etwa gleichauf. Dazu kommt, dass die große Ada-Karte natürlich auch bereits ab und zu von der CPU gebremst wird. Genau an dieser Stelle kann man das spätestens am Launchtag der GeForce RTX 4080 16GB gegentesten, denn wenn man hier den Faktor ansetzen würde, der sich für die RTX 4090 ergibt. Wäre es ein echtes, alleiniges Bottleneck für die RTX 4090, dann dürfte die kommende GeForce RTX 4080 16GB nur sehr wenig beeinflusst werden und annährend wieder das verbrauchen, was auch ohne DLSS messbar war.

Mit Bildbeschleunigungs-Verfahren wie DLSS, FSR oder XeSS wird aus der 450-Watt-Karte in Form der GeForce RTX 4090 eine (auch den Durchschnitt bezogene) 350-Watt-Karte, während sich die GeForce RTX 3090 Ti nicht aus der 400-Watt-Zone lösen kann. Die anderen Karten liegen hier wieder in etwa gleichauf. Dazu kommt, dass die große Ada-Karte natürlich auch bereits ab und zu von der CPU gebremst wird. Genau an dieser Stelle kann man das spätestens am Launchtag der GeForce RTX 4080 16GB gegentesten, denn wenn man hier den Faktor ansetzen würde, der sich für die RTX 4090 ergibt. Wäre es ein echtes, alleiniges Bottleneck für die RTX 4090, dann dürfte die kommende GeForce RTX 4080 16GB nur sehr wenig beeinflusst werden und annährend wieder das verbrauchen, was auch ohne DLSS messbar war.

Auch für diese Messungen habe ich noch einmal das prozentuale Verhältnis zur angegebenen TBP ermittelt. Das ist wirklich eindeutig:

Nachdem das jetzt auch geklärt wäre, können wir uns den weiteren Betrachtungen widmen, bevor nächste Woche der nächste große Launch ansteht. Wer noch einmal den Unterschied zwischen TBP, TGP und TDP hinterfragen möchte, den verweise ich auf einen weiterführenden Artikel, der fast schon ein Klassiker ist, aber immer noch Gültigkeit besitzt. Und nur mal ganz nebenbei: es gibt auch noch viele andere Lastszenarien als Games oder Stresstests. Das nur mal am Rande, aber Ihr kennt das ja bereits aus meinen ganzen Reviews.

Nachdem das jetzt auch geklärt wäre, können wir uns den weiteren Betrachtungen widmen, bevor nächste Woche der nächste große Launch ansteht. Wer noch einmal den Unterschied zwischen TBP, TGP und TDP hinterfragen möchte, den verweise ich auf einen weiterführenden Artikel, der fast schon ein Klassiker ist, aber immer noch Gültigkeit besitzt. Und nur mal ganz nebenbei: es gibt auch noch viele andere Lastszenarien als Games oder Stresstests. Das nur mal am Rande, aber Ihr kennt das ja bereits aus meinen ganzen Reviews.

657 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Urgestein

Veteran

Mitglied

Veteran

Urgestein

Urgestein

Urgestein

1

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →