Wo liegen die Grenzen?

So toll PCAT für die Messung und Datenerfassung ist – alles, was meine Seite hier ausmacht, kann auch PCAT nicht realisieren. Und das ist auch gut so, sonst wäre ich ja quasi über Nach obsolet geworden. Was aber gut funktioniert: PCAT ist eine ideale, weil sehr komfortabel einzusetzende Lösung, die meine aufwändigen Messungen ergänzen kann bzw. viele Wege abzukürzen hilft. Für alle Auswertungen der vorigen Seite ist das natürlich das Kuscheln in der Komfortzone schlechthin, denn es sind ja nur 100-ms-Intervalle.

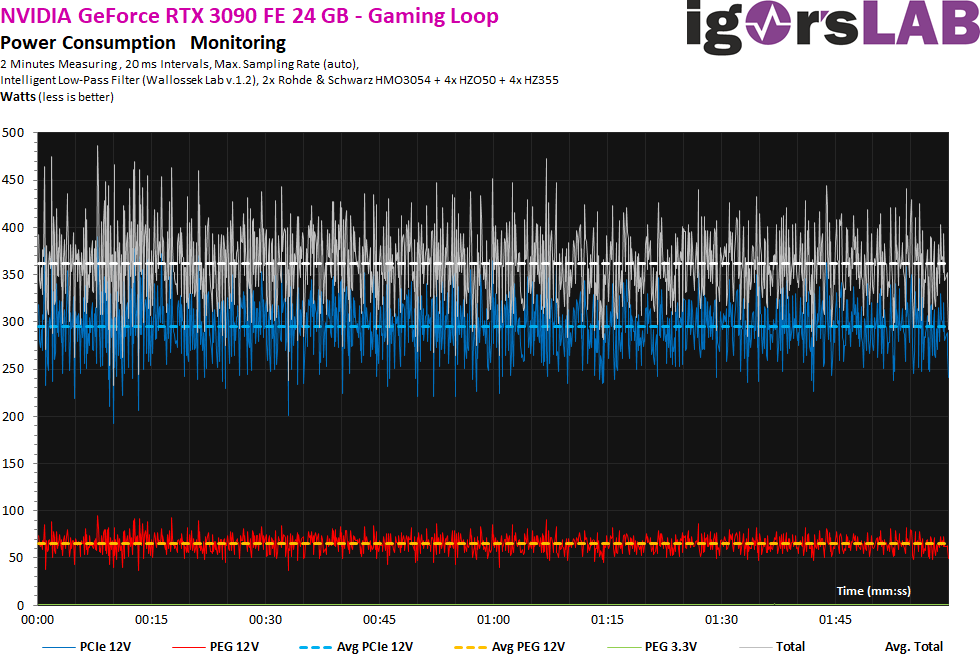

Detailmessungen bei maximaler Spielelast? Man kommt durchaus auch mit einer GeForce RTX 3090 fast an die 500 Watt Grenze, doch das nur im Mikrosekunden-Bereich, wo PCAT natürlich keine Hilfe mehr ist. Die erste Grafik zeigt 20-ms-Messintervalle, wo der Mittelwert jedoch nicht die richtigen Spikes abbildet, die wirklich auftreten können.

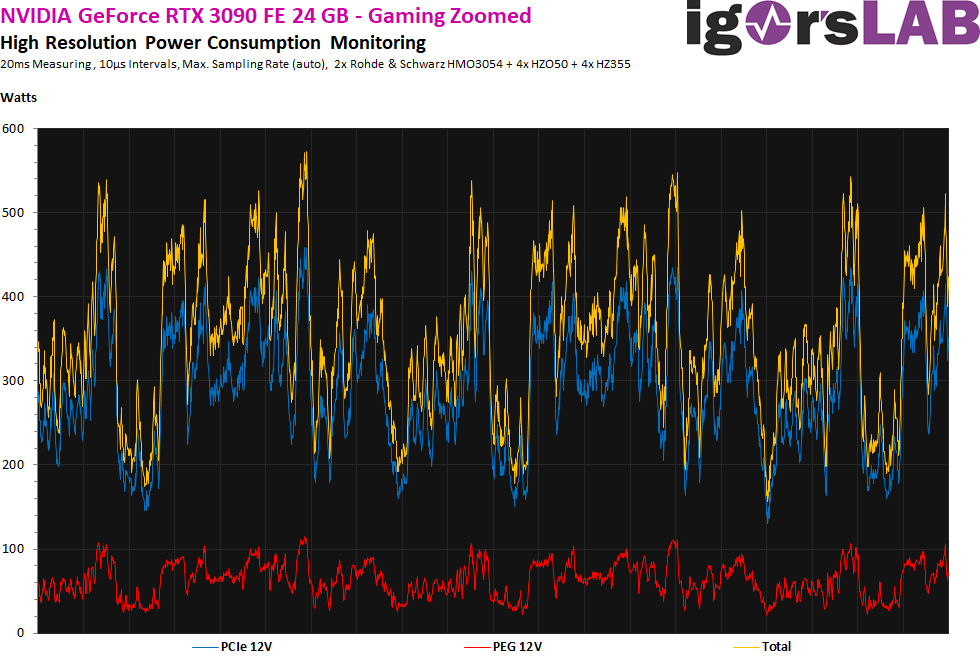

Lösen wir einmal so einen 20-ms-Intervall auf, dann sehen wir das wahre Problem hinter der sehr schnellen Arbeit von NVIDIAs Boost. Dann sind einzelne, wenn auch sehr kurze Spitzen bis 600 Watt durchaus keine Seltenheit!

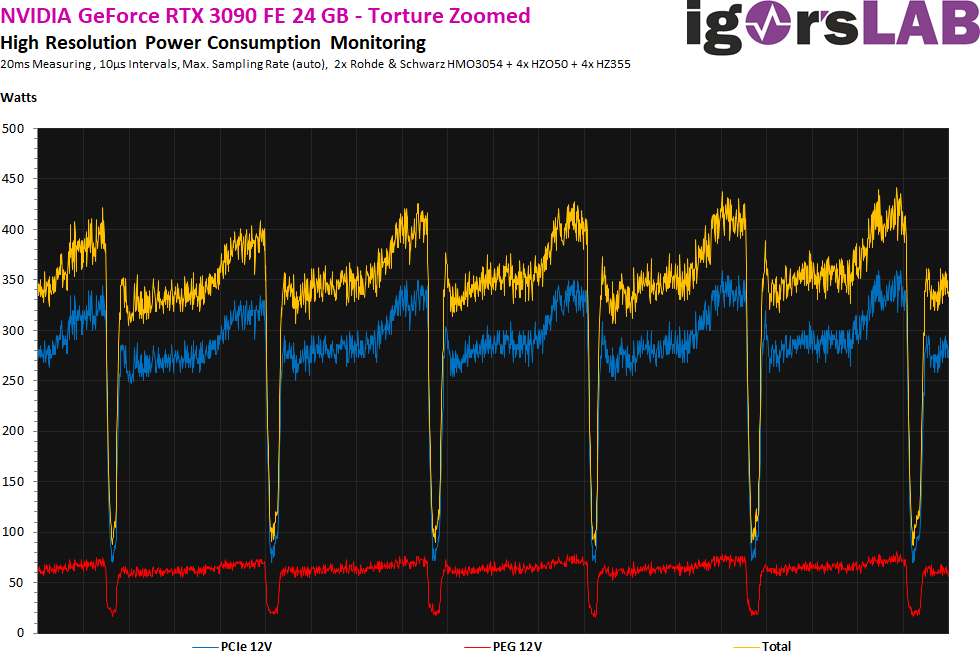

Der Stresstest verursacht übrigens ein sehr interessantes Bild. Die Länge der echten Lastintervalle halbiert sich nämlich! Auch wenn man schon für eine einzige Millisekunde einmal ca. 410 bis 430 Watt erreicht, ist es im 4,5-ms-Fenster dann ein Durchschnitt von ca. 360 Watt. Dann regelt die Karte für ca. 0.25 ms erst einmal komplett ab. Auch bei den Strömen wird es deutlich entspannter. Das liegt nun noch einmal deutlich unter dem, was gerade beim Gaming mit den häufigen Lastwechseln auftrat.

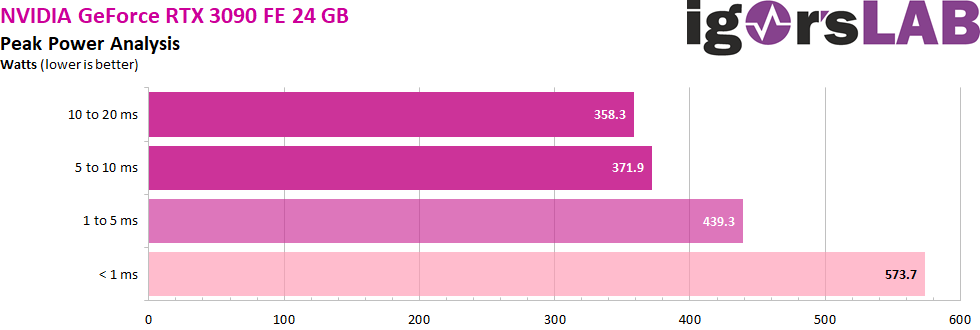

Moderne Schaltnetzteile sollten bei den fließenden Strömen, wie sie Grafikkarten erzeugen, eigentlich keine Schwierigkeiten haben. Ich konnte bei keiner einzigen Karte und in keiner der unterschiedlichsten Lastsituationen wirklich sensationell hohe Ströme messen. Sehr hohe Spikes von bis zu 440 Watt mit einer Länge von ca. 5 Millisekunden sind vorhanden, keine Frage. Würde man bis in den Nanosekunden-Bereich skalieren, dann sind auch Spitzen weit über 50 Ampere denkbar, aber wenn dann eine OCP oder OPP bereits auslöst, ist die Schaltung verhunzt und man muss die Schuld nicht bei den Grafikkarten suchen.

Die ganz kurzen Lastspitzen kann man getrost beiseitelegen und man sollte sich wirklich nur über Werte Gedanken machen, die über ein bis zwei Millisekunden liegen. Übrigens nicht nur wegen der möglichen Abschaltung des Netzteils durch einen Schutzmechanismus, sondern auch wegen der Haltbarkeit. Je hektischer so ein Grafikbeschleuniger am Netzteil saugt, umso schneller kommen die Sekundärkondensatoren in den Bereich der Pflegeversicherung. Wer dann am Ende spart, ist falsch beraten.

Zusammenfassung und Fazit

Das soll als kleiner Exkurs erst einmal reichen, denn die Infrarot-Messungen habe ich ja schon mehrmals ausführlich beschrieben. Da hat sich auch nichts groß geändert, so dass ich das überspringen kann. Alles andere von heute sollte der Transparenz sicher Genüge tun und die wichtigsten Fragen geklärt haben. Mehr will ich dann dazu auch gar nicht schreiben, denn es war eigentlich schon wieder mehr, als ich eigentlich vorhatte zu schreiben. Sollte noch etwas unklar sein, dann gibt es ja noch das Forum und den verlinkten Thread.

- 1 - Low-Level-Datenerfassung mit FrameView und PCAT

- 2 - Leistungsaufnahmemessung mit NVIDIA PCAT

- 3 - igorsLAB Interpreter und Template

- 4 - FPS und Perzentile, Balken und Kurven

- 5 - Frame Time und Varianzen als Kurven und Balken

- 6 - Leistungsaufnahme und Effizienz in Spielen (GPU und CPU)

- 7 - Leistungsaufnahme, Lastspitzen und Fazit

18 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Neuling

Neuling

Alle Kommentare lesen unter igor´sLAB Community →