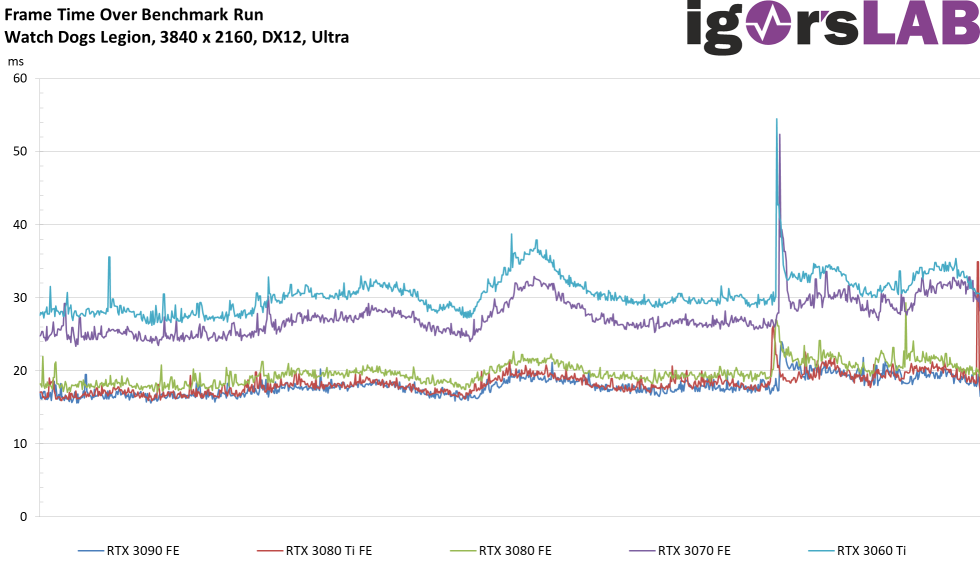

Frame Time aller Karten als Kurve

Interessanter sind da schon die Frame-Time-Verläufe. Sauber interpoliert, liegen diese Daten auch fein säuberlich auf einer gemeinsamen Zeit-Achse, damit man die Karten auch untereinander besser vergleichen kann. Allerdings haben diese Kurven mit den vielen Schwankungen auch den Nachteil, dass man sie nicht mehr den einzelnen Karten ein jedem Fall zuordnen kann. Die ganzen Überlappungen erschweren so eine Aussage nicht unerheblich. Die langsamsten Karten haben hier auch die höchste Renderzeit in ms pro gerendertes Einzelbild (Frame) und die im Verhältnis auch höchsten Einbrüche.

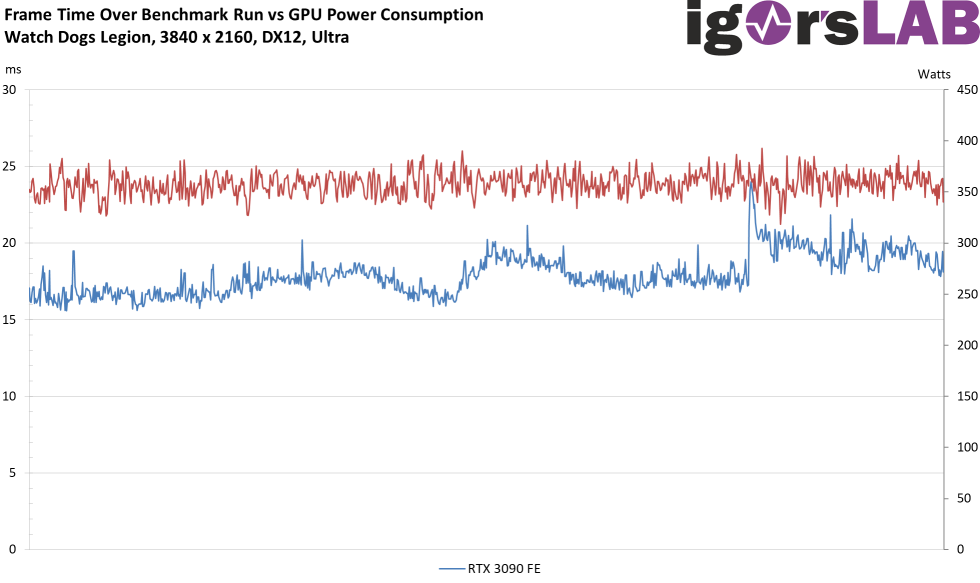

Frame Time einer Karte als Kurve (Solo-Grafik)

Passend dazu werden auch die Leistungsaufnahme-Werte von PCAT entsprechen in die gemeinsame Zeitachse skaliert (auch wenn ich dem Kapitel mit der Leistungsaufnahme nicht vorgreifen möchte). In diesem Fall sehen wir die übrigens die gemessenen Werte für die jeweilige Grafikkarte auf allen Rails und nicht nur Schätzungen. Da muss man dann bei AMD auch nicht mit unklaren Größen wie ASIC herumspekulieren, das ist die Gesamtleistungsaufnahme, also die Board-Power jeder einzelnen Karte in genau diesem Zeitfenster. Blau ist die Frame Time Kurve, Rot steht für die Leistungsaufnahme.

Will man es noch genauer, dann kann man sogar für jede einzelne Karte die Frame Time zusammen mit der jeweiligen Leistungsaufnahme auf einer gemeinsamen Zeitachse abbilden, da ich auch auf der Messtation mit den Oszillographen genaue und einheitliche Zeitstempel produziere, so dass man es später im Interpreter zusammenführen könnte. Nur ist dies schon over the top und wäre purer Mess-Luxus. NVIDIA löst das zwar mit PCAT etwas granulärer als mein Messaufbau mit dem Oszillographen, spart sich aber die viel aufwändigere Zusammenführung riesiger Datensätze über den Ethernet-Timestamp. Das reicht für die visuelle Darstellung und einen recht genauen Mittelwert (auf den gehe ich später noch ein) locker aus.

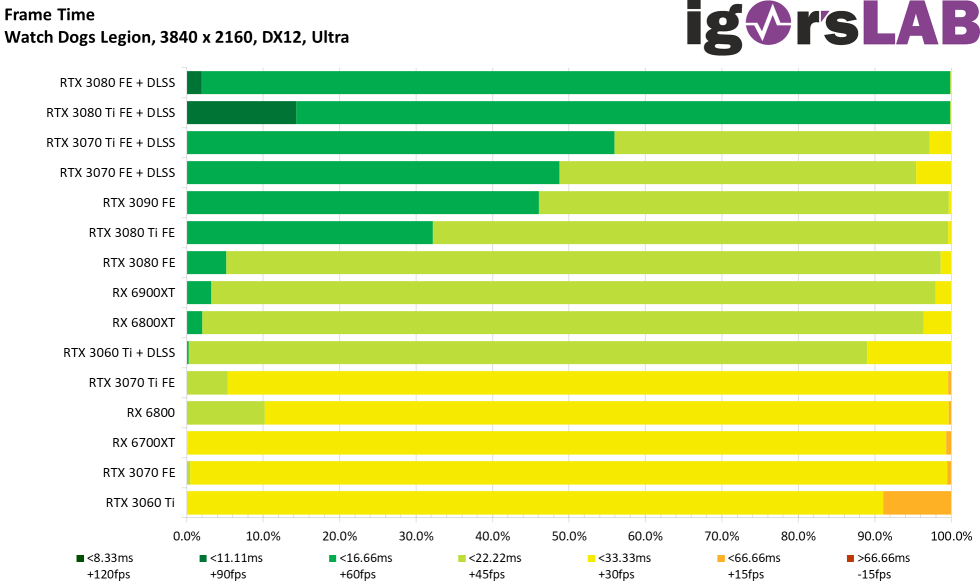

Frame Time aller Karten als Balkengrafik

Hier gehe ich jetzt anders vor als bei den Perzentilen, denn ich kumuliere die jeweils aufgetreten Menge an Frames pro bestimmten Intervall (siehe Legende). Je nachdem, wie schnell das Bild gerendert wurde, erhöht sich dann der Anteil des jeweiligen Zeitfensters. Lässt man DLSS mal beiseite, dann sehen wir auch hier, dass die RTX 3090 ohne diese Hilfe den höchsten Anteil der Frames mit < 16.66 ms besitzt, was im Durchschnitt ja mehr als 60 FPS darstellen würde, auch wenn hier ja in der Sekunde einer Messung sehr unterschiedliche Renderzeiten zusammenkommen können.

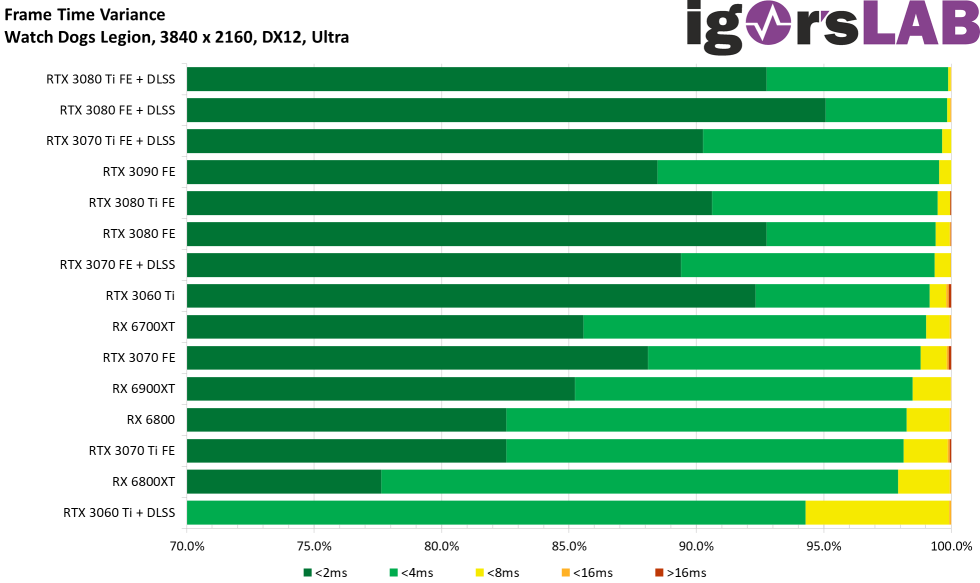

Varianzen – Unbestechlicher Indikator für einen smoothen Bildlauf

Unter Varianz verstehen wir die zeitlichen Unterschiede zwischen zwei aufeinanderfolgenden Frames. Hierbei handelt es sich um Absolutwerte der jeweiligen Differenz aus den zwei Renderzeiten, denn es spielt für den Betrachter keine Rolle, ob der darauffolgende Frame nun besonders schnell oder der vorangegangene besonders langsam gerendert wurde. Mikroruckler sieht man in beiden Fällen. Alle Varianzen unterhalb von 4 ms sind für den Betrachter eigentlich nicht sichtbar, das wird erst bei ca. 8 ms und mehr ein Thema. Ab 16 ms sieht man dann schon so ausgeprägte Ruckler, dass man den Bildlauf nicht mehr als smooth bezeichnen kann.

- 1 - Low-Level-Datenerfassung mit FrameView und PCAT

- 2 - Leistungsaufnahmemessung mit NVIDIA PCAT

- 3 - igorsLAB Interpreter und Template

- 4 - FPS und Perzentile, Balken und Kurven

- 5 - Frame Time und Varianzen als Kurven und Balken

- 6 - Leistungsaufnahme und Effizienz in Spielen (GPU und CPU)

- 7 - Leistungsaufnahme, Lastspitzen und Fazit

18 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

1

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Neuling

Neuling

Alle Kommentare lesen unter igor´sLAB Community →