ATX 3.0 and the origin of senselessly high load peaks

Here we also have to come back to PCIe 5.0, because one also meshes with the other. In the end, it is thanks to the dear graphics card manufacturers that the PCI SIG includes this madness bindingly in the PCIe 5.0 standard for all cards with a TBP of 300 watts or more. Of course, you cannot directly compare individual load peaks in the PCIe 5.0 definition with the load cycles of the power supplies in the ATX 3.0 document, but these cycles are based in the logical continuation exactly on what was previously entered in the PCIe 5. Specification was included. This was ensured by the demands jointly brought in by AMD and NVIDIA, and it would be richly unfair to bash NVIDIA alone for this energetic nonsense.

The most important thing in the current standardization up to 600 watts is first of all the so-called Combined Power, which precisely specifies that in the sum of external PCIe power supply (Aux) and the PCIe motherboard slot (PEG), no more than 600 watts may be called up as an average continuous load. It does not matter which rail delivers how much power in detail and the usual adding of the partial values of all rails is obsolete. So this also affects the power supply, but…. There is no need to go into PCI power management and power budgeting (yet), because there are simply no suitable PCIe 5.0 graphics cards and ATX 3.0 power supplies. Aha!

Furthermore, these standards listed below and called for by NVIDIA and AMD together only apply to graphics cards in the 300 to 600 watt ranges; the ranges below that remain as usual.

- Sustained Power – Average power in a time frame of 1 second or more

- TDP – Thermal Design Power is the maximum continuous power output

- Power Excursion – A temporary condition in which the power exceeds the maximum continuous power

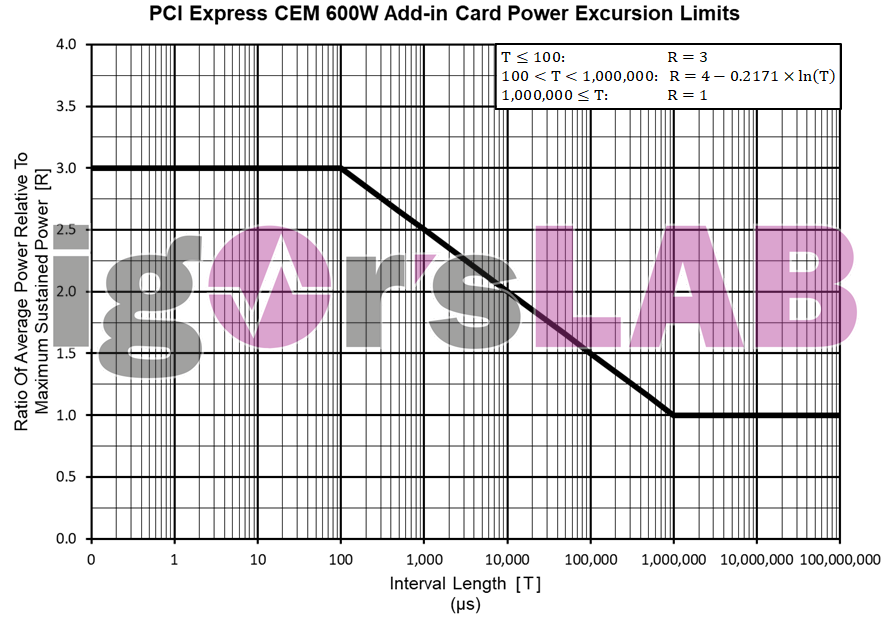

In general, TDP and Sustained Power can be equated, so I will generally use the term Sustained Power here in the following. I had already mentioned on the first page that different power levels are defined for different time intervals in the individual overload ranges. Since this applies to all graphics cards in the range between 300 and 600 watts regardless of their Sustained Power (also TBP at NVIDIA or TDP at AMD), you can’t work with absolute wattages, but have to define a ratio between the average load measured in the respective interval and the Sustained Power.

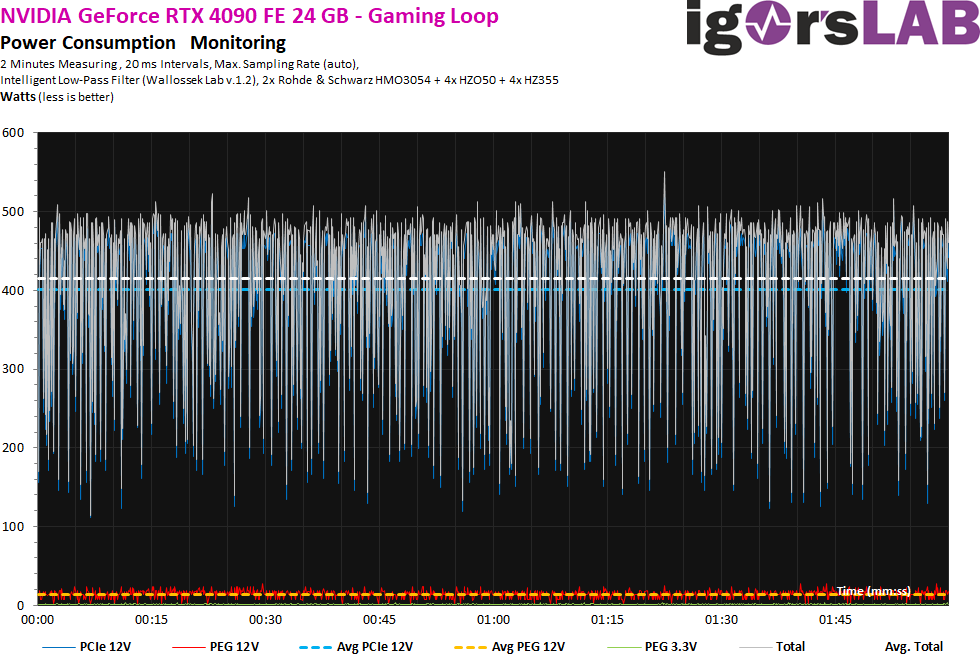

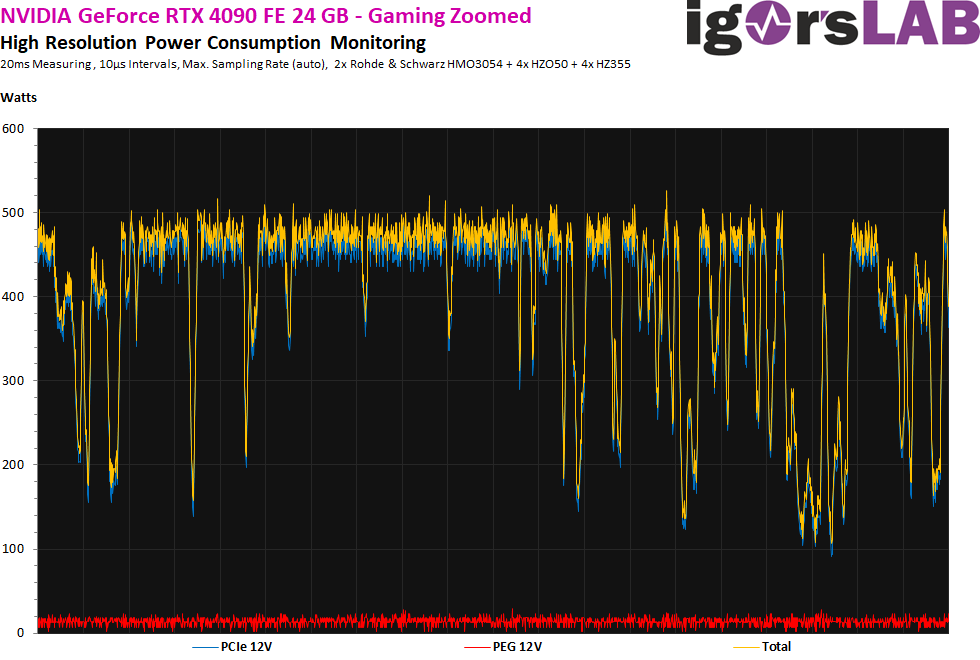

The following diagram now shows very clearly where the journey is heading for the individual intervals. From one second and more, the ratio of 1 applies, which is why the average power consumption may then no longer exceed the TDP. The other limit is 100 µs, where the one ratio of 3 allows even three times. With the interval used by many power supplies for the supervisor during monitoring of 20 ms the ratio is 1.25. And now at the latest, we also notice that the tested NVIDIA RTX 4090 FE had a ratio of 1.23, which is certainly anything but a coincidence (415 watts in gaming average and 512 watts peak load, both real measurements in the picture above).

A ratio of 2.5 would even be allowed in not really rare load peaks of around 1 ms, which would result in a power consumption of 1038 watts with the 415 watts measured in the example. Interestingly, the load peaks at 10 microseconds don’t exceed 516 watts either, so the ratio of around 1.24 is still miles away from ratio 3, which specifies an insane 1245 watts here. Here, the practice proves how detached the engineering involved has planned and what nonsense the standard actually represents.

A ratio of 2.5 would even be allowed in not really rare load peaks of around 1 ms, which would result in a power consumption of 1038 watts with the 415 watts measured in the example. Interestingly, the load peaks at 10 microseconds don’t exceed 516 watts either, so the ratio of around 1.24 is still miles away from ratio 3, which specifies an insane 1245 watts here. Here, the practice proves how detached the engineering involved has planned and what nonsense the standard actually represents.

Power consumption and load peaks as an extreme mix

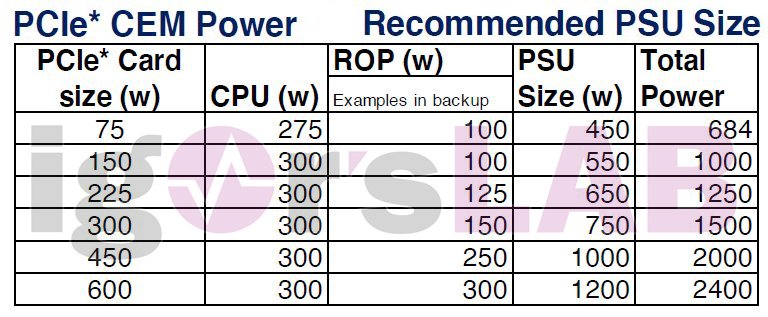

I will now show you the small excerpt of what Intel has given the manufacturers from 2022 onwards and we are still amazed by the numbers. For those who don’t know, CEM means PCI SIG Card Electromechanical, i.e. the plugged-in add-in cards. The CPU manufacturer estimates between 275 and 300 watts for the CPU, which is, however, plenty generous. However, I have also managed to squeeze far more than 350 watts into a Core i9-13900K, which quickly puts the generous rating into perspective again.

The power consumption values of the graphics cards are also anything but utopian, because the new flagships can call up around 500 to 600 watts of real board power with maximum OC. But that should then already be the “vomit limit”. The estimation for the rest of the system is rather inconsistent, as the 100 watt approach is already a bit tight with motherboard power consumption of up to 50 watts even at the low end, while the 300 watts is a bit excessive for the largest system. In spite of everything, however, this should somehow work out in total, because much of what I have already written about the ratio coincides. The table shown here is also not my invention, but originates from internal briefing documents from Intel:

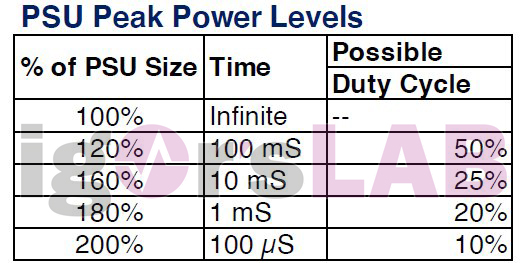

The estimated values for the PSU measurement (“PSU Size”) are thus clarified, but what is the Total Power all about? This is exactly what we need to talk about now, because it is exactly the part that worries me (and the power supply manufacturers) the most! Intel also has a defined idea for this and at the same time an announcement to the producers of the power suppliers. Let’s take a look at it now and get wide-eyed. Even if the length of the highest load peak intervals is limited to 100 μS each, the permissible total share of up to 10% of the total volume is downright abstruse. This means that the power supply must actually deliver 200% of the power over 10% of the operating time!

This actually turns the 1.2 kW power supply into a 2.4 kW power supply in disguise. This is because it is also defined in this way that normal operation can be at just 50% without a surcharge and the rest of the time can be blithely overloaded. Of course, this will all more or less amount to a pure single-rail solution as well, but from a purely electrotechnical point of view, this is outright madness. Which supervisor chip should still be able to realize a reliable protection circuit for OCP/OPP in a fixed defined interval here? What then is still an allowable load and where does the emergency begin?

And in case one or the other eye remained dry now: NVIDIA originally even worked towards a whopping 235% and also gave this to the power supply manufacturers as a “recommendation” and “advice”. This statement still stands even today and companies like be quiet! and Corsair silently comply, while they more qualified PSU testers always rub their eyes in wonder. However, after all the measurements from my daily practice, the question must be allowed as to what the whole thing is actually intended for. For the NVIDIA cards with Ada architecture, these specifications are demonstrably obsolete, for RDNA3 as well, by the way, if I can trust the measurements of my sources (even though I cannot give exact numbers at the moment due to NDA reasons).

ATX v3.0 – Soften limits, close eyes and somehow through!

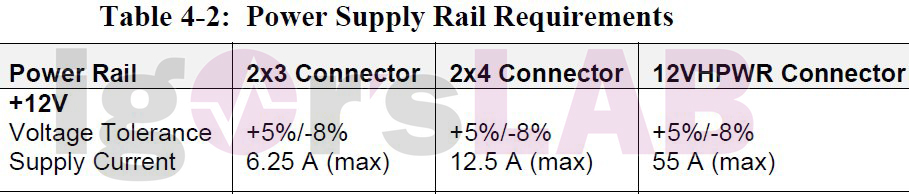

Even though some of the manufacturers might be able to produce such power supplies under the currently valid ATX specifications with the corresponding costs, the bar for the quality of the power supplies and the limits to be met is much too high for most of the cheap manufacturers. Or the products would then at least be so expensive again that acceptance would be completely zero. So you bend the whole thing a bit and even risk backwards compatibility. But let’s start again at the PCI SIG and see what they specify:

So far, so clear. And now the circle of the energetic show is closed, if we still include the transients. I know it was a lot of theory again, but I hope it still came across well despite, or rather because of, the deliberate breaking down to more generally understandable formulations. As already written several times, it refers to the upper performance class, which is of course also particularly thirsty. Whether you will really play the game as an end customer is up to you. In the end, it is also a matter of conscience.

Summary and conclusion

Do we even need such an extremely oversized ATX 3.0 power supply at this point? For the moment, I would really answer this question with a clear no, if you follow certain basic rules when sizing the power supply when buying a new one. On the one hand, such power supplies can cause problems with older systems (voltage) and on the other hand it complicates the production (and costs) of really efficient power supplies and complete systems unnecessarily. Expensive instead of sensible, what a farce for the customer…

If you are planning a NEW system with a high-end graphics card, you can of course rely on a new ATX 3.0 power supply, especially since you won’t have to search for the 12VHPWR cable. But buying such a usually more expensive power adapter just because you only want to replace the included 12VHPWR adapter is complete nonsense. As long as the current power supply is still good and not too old. Here, it is first worth taking a look at the optional accessories on the third-party market.

The good power supplies come with at least 5 years warranty to the customer, some even up to 10 years. If you now think you can’t go wrong with a new, expensive ATX 3.0 power supply and are making a sensible investment in the more distant future, you are unknowingly making a fundamental mistake! Because what has currently been announced as ATX 3.0 or has just come onto the market does not yet offer anything that older power supplies can’t, at least in terms of the graphics card connection and the smart power management. With a bit of bad luck, the great 400-euro PSU will be back to the technical stone age in two years when all four sense pins are finally used.

97 Antworten

Kommentar

Lade neue Kommentare

Veteran

Urgestein

Urgestein

Urgestein

Urgestein

Veteran

1

Urgestein

1

Urgestein

Veteran

Veteran

Mitglied

Mitglied

Mitglied

Mitglied

Veteran

Mitglied

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →