Benchmarks, Test system and evaluation software

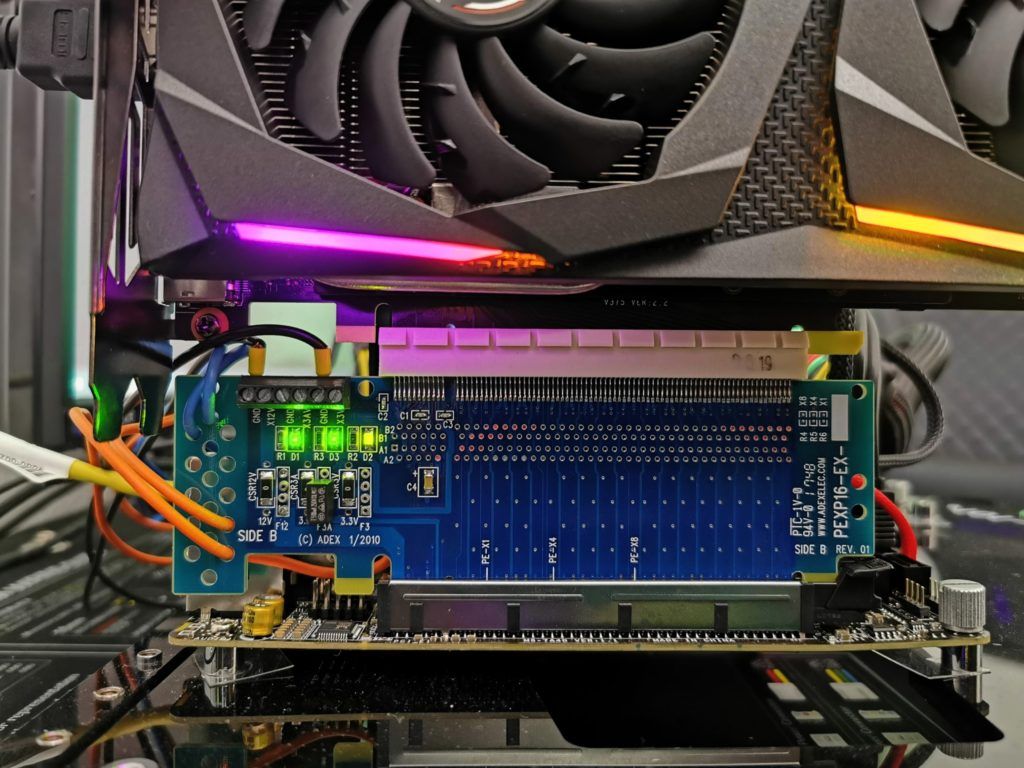

For the benchmarks, I chose the same games as in the launch article of the Radeon RX 6600 XT, but omitted Control because of the driver bug. The benchmark system relies on PCIe 4.0, the matching X570 motherboard in the form of the MSI MEG X570 Godlike and a selected Ryzen 9 5900X that was overclocked water-cooled (PBO + 500 MHz). Add to that the matching DDR4 4000 RAM from Corsair, as well as several fast NVMe SSDs. For direct logging during all games and applications, I use my own measurement station with shunts and riser card, as well as NVIDIA’s PCAT in games, which adds to the convenience immensely.

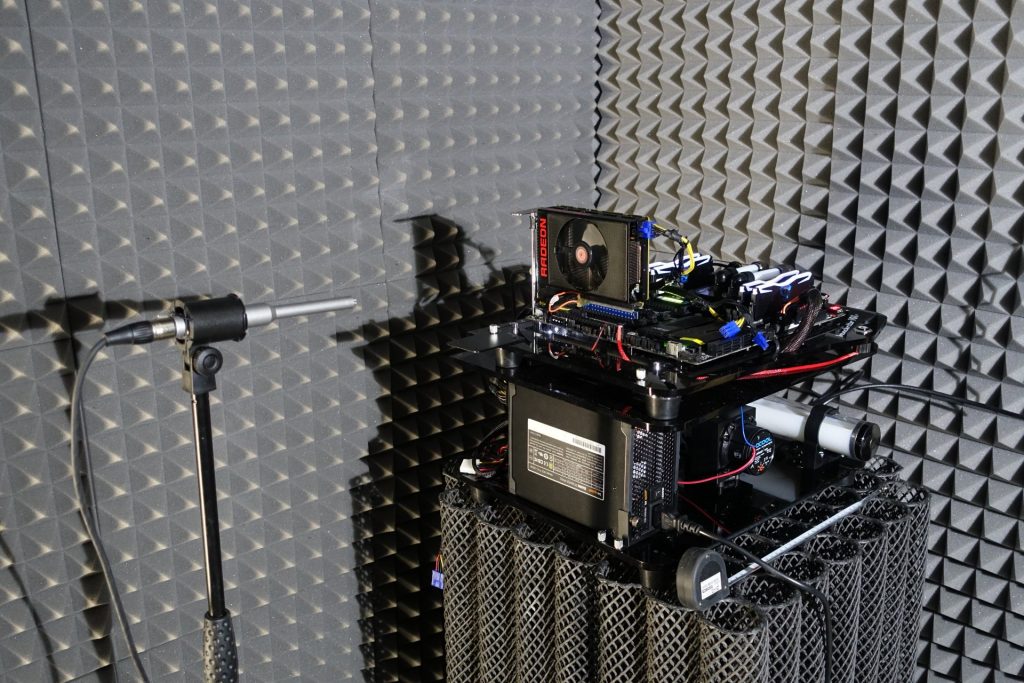

The measurement of the detailed power consumption and other, more profound things takes place here in the special laboratory on a redundant and in detail identical test system then double-tracked by means of high-resolution oscillograph technology…

…and the self-created MCU-based measurement setup for motherboards and graphics cards (pictures below), where at the end in the air-conditioned room also the thermographic infrared images are created with a high-resolution industrial camera. The audio measurements are done outside in my Chamber (room within a room).

I have also summarized the individual components of the test system in a table:

| Test System and Equipment |

|

|---|---|

| Hardware: |

AMD Ryzen 9 5900X OC MSI MEG X570 Godlike 2x 16 GB Corsair DDR4 4000 Vengeance RGB Pro 1x 2 TByte Aorus (NVMe System SSD, PCIe Gen. 4) 1x2 TB Corsair MP400 (Data) 1x Seagate FastSSD Portable USB-C Be Quiet! Dark Power Pro 12 1200 Watt |

| Cooling: |

Alphacool Ice Block XPX Pro Alphacool Ice Wolf (modified) Thermal Grizzly Kryonaut |

| Case: |

Raijintek Paean |

| Monitor: | BenQ PD3220U |

| Power Consumption: |

Oscilloscope-based system: Non-contact direct current measurement on PCIe slot (riser card) Non-contact direct current measurement at the external PCIe power supply Direct voltage measurement at the respective connectors and at the power supply unit 2x Rohde & Schwarz HMO 3054, 500 MHz multichannel oscilloscope with memory function 4x Rohde & Schwarz HZO50, current clamp adapter (1 mA to 30 A, 100 KHz, DC) 4x Rohde & Schwarz HZ355, probe (10:1, 500 MHz) 1x Rohde & Schwarz HMC 8012, HiRes digital multimeter with memory function MCU-based shunt measuring (own build, Powenetics software) NVIDIA PCAT and Fr |

| Thermal Imager: |

1x Optris PI640 + 2x Xi400 Thermal Imagers Pix Connect Software Type K Class 1 thermal sensors (up to 4 channels) |

| Acoustics: |

NTI Audio M2211 (with calibration file) Steinberg UR12 (with phantom power for the microphones) Creative X7, Smaart v.7 Own anechoic chamber, 3.5 x 1.8 x 2.2 m (LxTxH) Axial measurements, perpendicular to the centre of the sound source(s), measuring distance 50 cm Noise emission in dBA (slow) as RTA measurement Frequency spectrum as graphic |

| OS: | Windows 10 Pro (all updates, current certified or press drivers) |

Raytracing / DXR

At the latest since the presentation of the new Radeon cards it is clear that AMD will also support ray tracing. Here one goes a way clearly deviating to NVIDIA and implements a so-called “Ray Accelerator” per Compute Unit (CU). Since the Radeon RX 6700XT has a total of 40 CUs, this also results in 40 such accelerators. A GeForce RTX 3070 comes with 46 RT cores. However, RT cores are organized differently and we will have to wait and see what quantity can do against specialization here. So in the end it’s an apples and oranges comparison for now.

But what has AMD come up with here? Each of these accelerators is first capable of simultaneously computing up to 4 beam/box intersections or a single beam/triangle intersection per cycle. This way, the intersection points of the rays with the scene geometry are calculated (analogous to the Bounding Volume Hierarchy), first pre-sorted and then this information is returned to the shaders for further processing within the scene or the final shading result is output. NVIDIA’s RT cores, however, seem to have a much more complex approach to this, as I explained in detail during the Turing launch. What counts is the result alone, and that’s exactly what we have suitable benchmarks for.

Smart Access Memory (SAM)

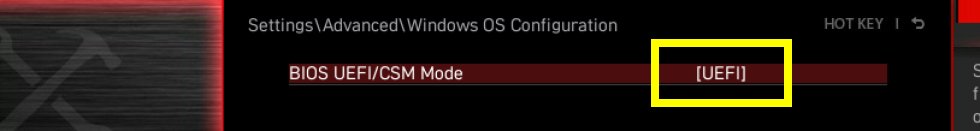

AMD already showed SAM, i.e. Smart Access Memory, at the presentation of the new Radeon cards – a feature I enabled today in addition to the normal benchmarks, which also allows a direct comparison. But actually SAM is not Neuers, just verbally more nicely packaged. This is nothing else than the clever handling of the Base Address Register (BAR) and exactly this support must be activated in the substructure. With modern AMD graphics hardware, resizable PCI bars (see also PCI SIG from 4/24/2008) have played an important role for quite some time, since the actual PCI BARs are normally only limited to 256 MB, while with the new Radeon graphics cards you can now find up to 16 GB VRAM (here it’s 12 GB).

The result is that only a fraction of the VRAM is directly accessible to the CPU, which without SAM requires a whole series of workarounds in the so-called driver stack. Of course, this always costs performance and should therefore be avoided. So that’s where AMD comes in with SAM. This is not new, but it must be implemented cleanly in the UEFI and later also activated. This only works if the system is running in UEFI mode and CSM/Legacy are disabled.

CSM stands for the Compatibility Support Module. The Compatibility Support Module is exclusive to UEFI and ensures that older hardware and software will work with UEFI. The CSM is always helpful when not all hardware components are compatible with UEFI. Some older operating systems and the 32-bit versions of Windows also do not install on UEFI hardware. However, it is precisely this compatibility setting that often prevents the clean Windows variant required for the new AMD components from being installed.

- 1 - Einführung und Technische Daten

- 2 - Testsystem und Methodik

- 3 - Gaming Performance Full-HD

- 4 - FPS-Verläufe als Kurven pro Karte und Spiel

- 5 - Kurven der Percentile pro Karte und Spiel

- 6 - Frame Time Kurven pro Karte und Spiel

- 7 - Frame Time Balkengrafiken pro Karte und Spiel

- 8 - Varianzen pro Karte und Spiel

- 9 - Leistungsaufnahme pro Karte und Spiel

- 10 - Leistungsaufnahme CPU pro Karte und Spiel

- 11 - Effizienz pro Karte und Spiel

- 12 - Kumulation, Zusammenfassung und Fazit

14 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Mitglied

Veteran

Veteran

Veteran

Moderator

Mitglied

Urgestein

Mitglied

Mitglied

Veteran

Urgestein

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →