The bars are getting longer and longer: NVIDIA DLSS 3.0

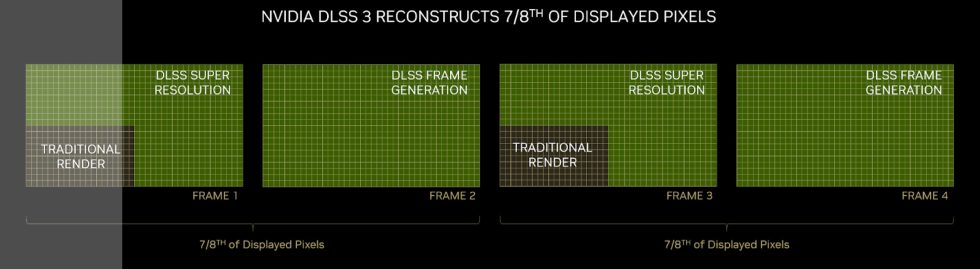

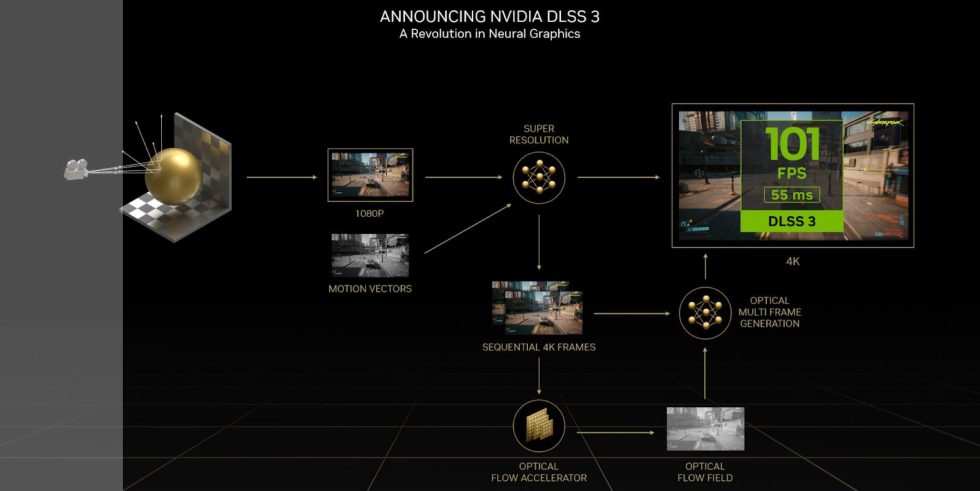

The question is of course: What changes or improves now with DLSS 3.0? In summary, DLSS 3.0 consists of three components: 1. Super Resolution (upscaling), 2. Frame Generation and 3. NVIDIA Reflex (I’ll get to that on the next page). The special feature here is: the frame generation. If you activate this, you also get a kind of intermediate image calculation via the “Ada-Only” Optical Flow Accelerator. (all following pictures are from NVIDIA)

Thus, it should be understandable that DLSS 3.0 will only be possible with ADA GPUs. This is a great pity and somehow not exactly customer-friendly towards the buyers of an RTX 3000 card, but a kind of collateral damage in the context of technical progress. Well, at least the owners of the 2000 or 3000 cards can use DLSS 2.x and NVIDIA Reflex (goes back to Maxwell).

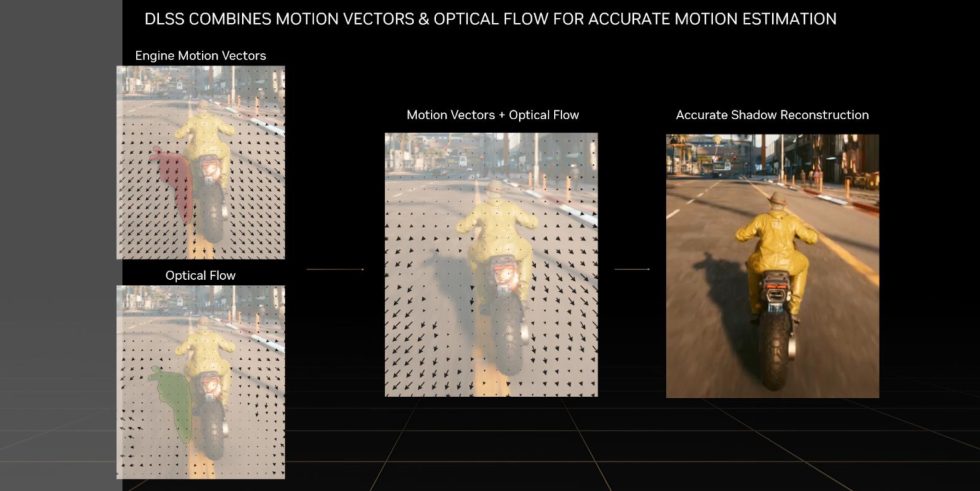

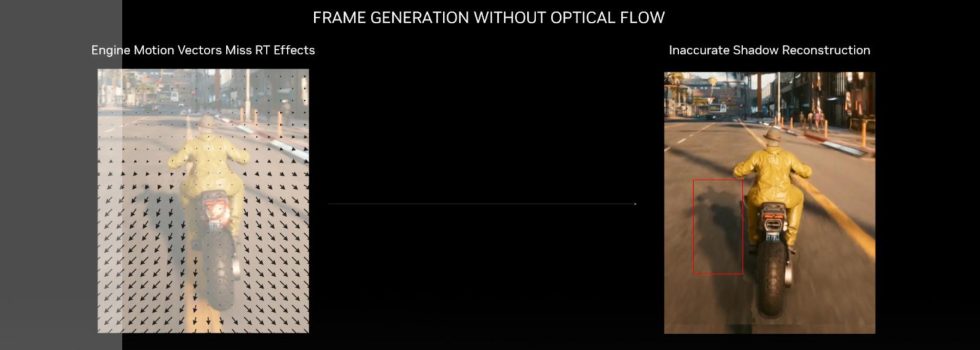

From now on, the inclined NVIDIA customer of an RTX 4000 with the fourth generation Tensor cores – besides the AI network (for learning the game graphics) and the previously known DLSS 2.3 features (which form the Super Resolution) – also has the new Frame Generation. This ultimately consists of four inputs: the current and previous frame, the motion vectors of the game engine and the optical flow acceleration. This analyzes two sequential frames in the game and calculates an optical motion field from them. All information (particles, light, shadows, reflections, etc.) is taken into account.

Otherwise, you would see ghosting effects again during fast movements. See picture below…

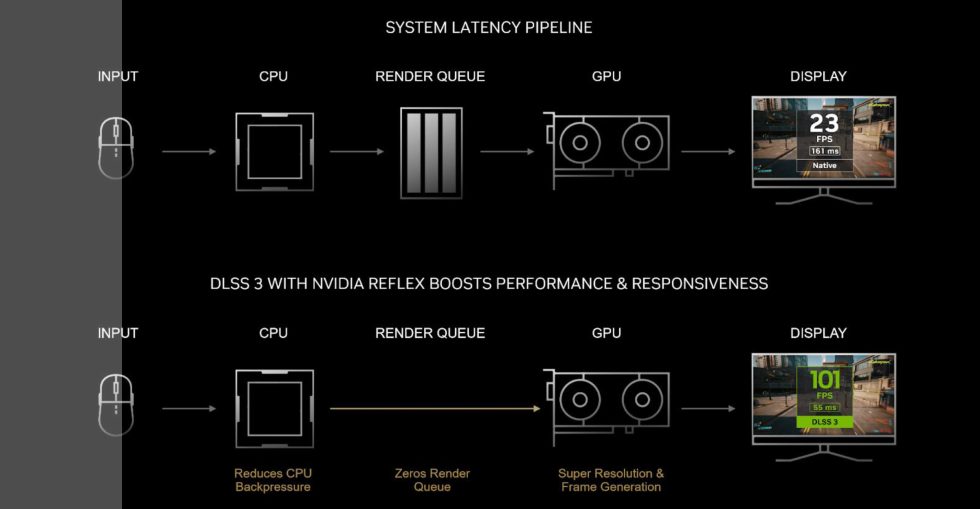

NVIDIA has extended the previously known DLSS 2.3 with DLSS 3.0 and manages to conjure up even more FPS on the monitor by means of “intermediate image calculations” – especially in the CPU limit. At least that’s how NVIDIA advertises it. But stop, doesn’t that end up affecting latencies? According to NVIDIA, the whole arithmetic is only supposed to cost 10 ms latency (depending on the game engine and resolution, even a bit more), which is why they decided to implement Reflex in all games with DLSS 3.0. Thus, Reflex has now become a fixed part of DLSS 3.0. For me, Reflex belongs in every game, but not every publisher will follow NVIDIA without bias.

DLSS 3.0 in practice

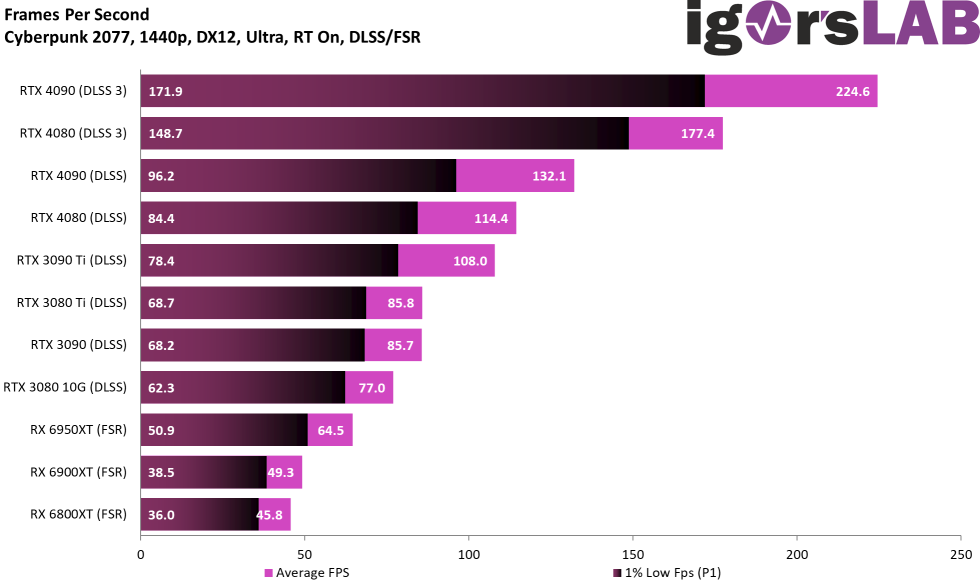

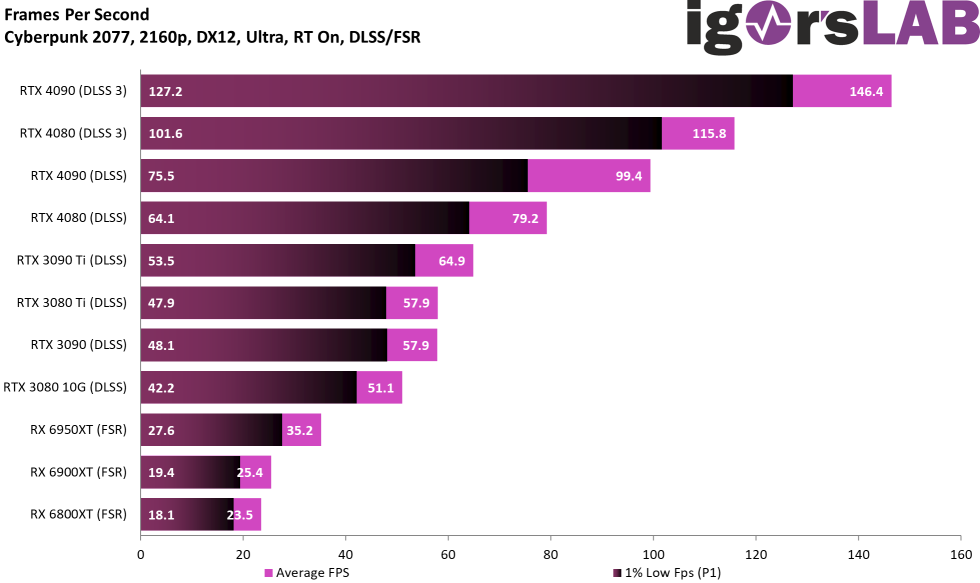

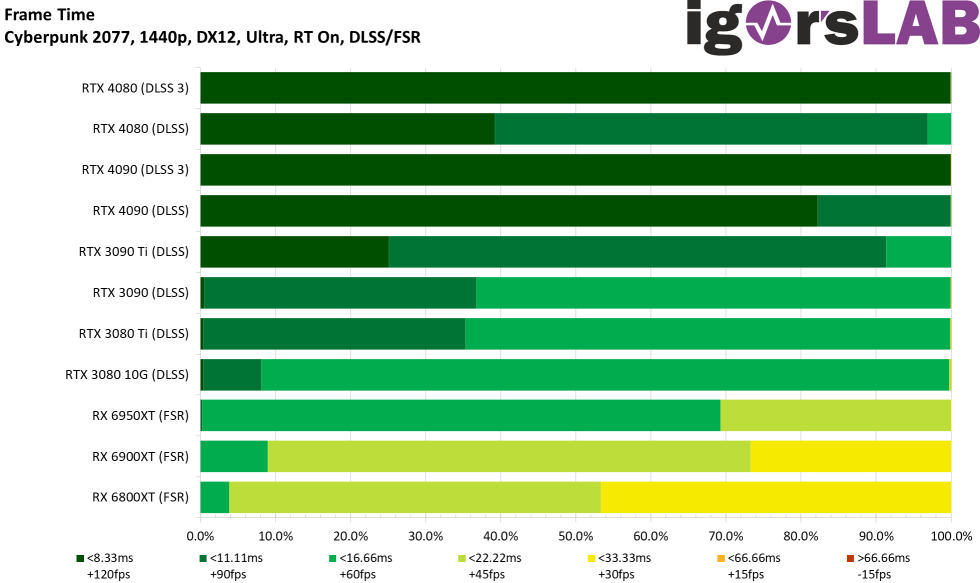

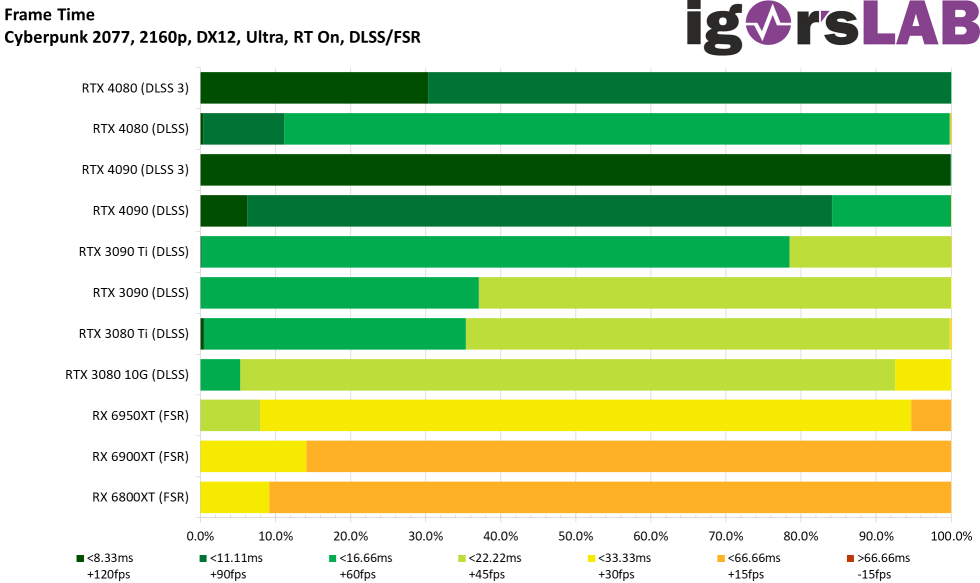

You can certainly claim a lot of things, but you can also measure them. I’ll just anticipate part of the next article and at least include the appropriate benchmarks for Cyberpunk 2077 here, so we know what it’s actually about in practice. In QHD, DLSS 3.0 achieves an amazing FPS increase compared to DLSS 2.3. We’ll talk about the latencies on the next page, because that’s less overhead than I feared. From a purely visual point of view, this is more than okay, because you can’t really see the dirt. UHD has the advantage that, for example, a suitable OLED panel like the LG’s can sync with the promised 120 Hz, which is definitely good for the eye. However, even the GeForce RTX 4080 is strong enough for QHD, so DLSS alone is sufficient.

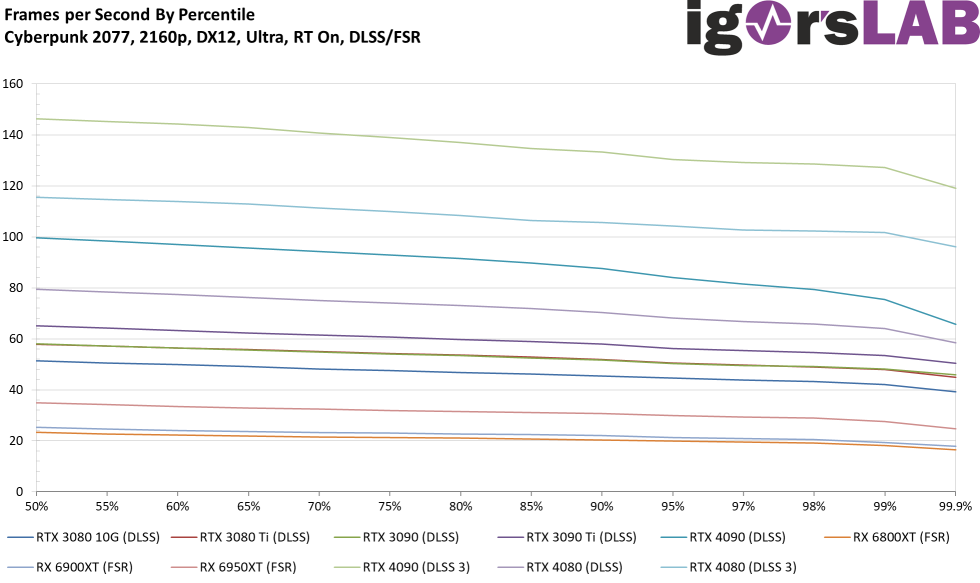

The percentiles also show the immense FPS increase above the P1, whereby the benefit in UHD is clearly higher here as well.

The card is also clearly ahead in frame times with DLSS 3.0, which is not surprising:

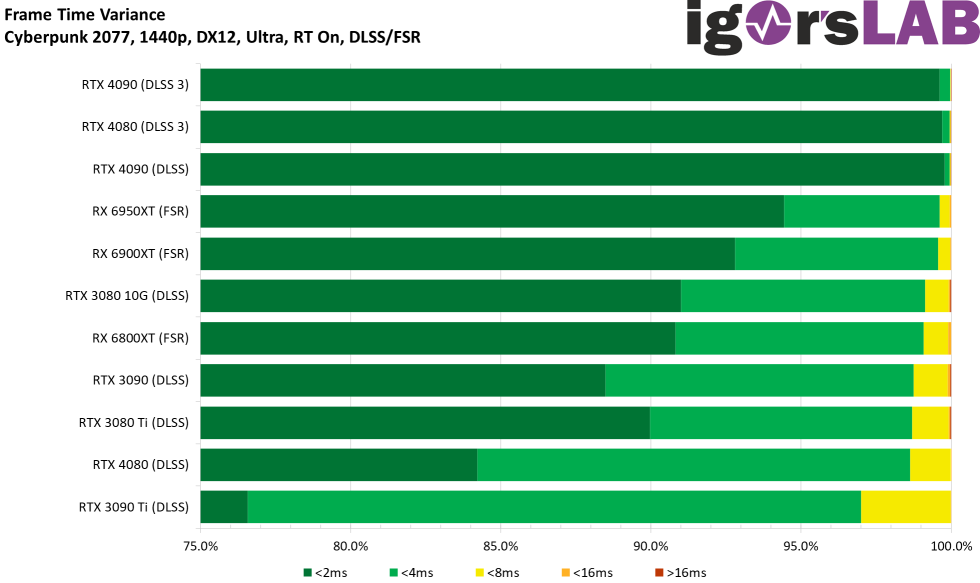

DLSS 3.0 also scores well in terms of variances! If we take a look at the high UHD resolution, we see that the RTX 4090 with DLSS even has to yield to the Radeon RX 6950XT, whereas its picture quality with FSR is significantly worse. But it runs a little smoother. This question does not arise with DLSS 3.0, where everything runs smoothly. You are then about 10 ms behind in the latencies, but we will see that in a moment. purely subjectively, the image including the gradient looks much better than with only DLSS 2.3.

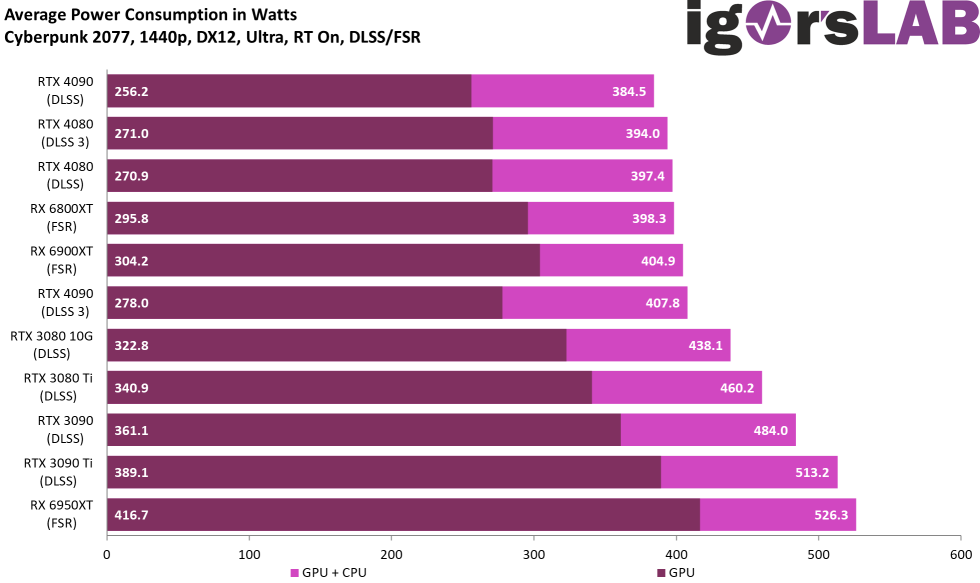

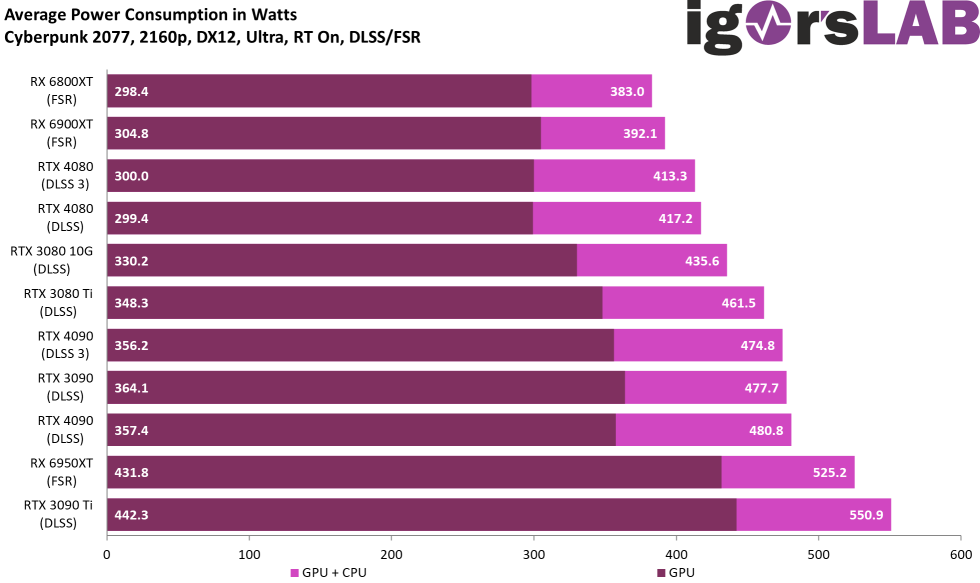

The GeForce RTX 4000 cards usually consume less power with DLSS than with DLSS 3.0, since the frame rate is also a bit lower and less has to be calculated (no frame generation).

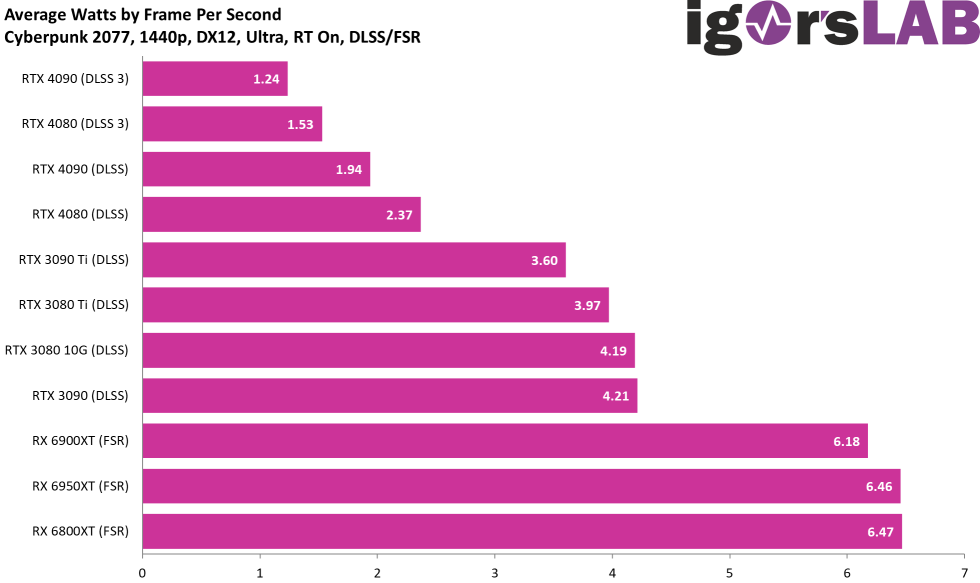

Of course, this is also reflected in the efficiency, which can be increased even further with DLSS 3.0. The RTX 4090 with DLSS 3.0 always wins, before the RTX 4080 and then both cards again with DLSS and the rest

And because I am also an eye person, the optics must not be neglected. As a teaser, here is an excerpt from our special that starts the day after tomorrow. The video is of course only a small part of many, but it loosens now after so much theory also times something:

Click for full screen in a separate window

Related links

How DLSS 2.x works, we had already discussed long and wide last year. Therefore I link the article from that time again at the end of this page (on page 2 you will find the complete article).

NVIDIA DLSS und AMD FSR im DIREKTEN Vergleich | Performance-Boost und Qualitätcheck in der Praxis

- 1 - Introduction, technical data and technology

- 2 - Test system and the igor'sLAB MIFCOM-PC

- 3 - Teardown: PCB, components and cooler

- 4 - Gaming performance WQHD (2560 x 1440 Pixels)

- 5 - Gaming performance UHD (3840 x 2160 Pixels)

- 6 - Gaming performance UHD + DLSS/FSR/XeSS (3840 x 2160 Pixels)

- 7 - DLSS 3.0 and the longest benchmark bars

- 8 - NVIDIA Reflex and latencies

- 9 - Workstation performance

- 10 - Power consumption, load levels and standards

- 11 - Transients and PSU recommendation

- 12 - Temperatures, clock rates, OC, fans and noise

- 13 - Summary and conclusion

168 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Veteran

1

Veteran

Mitglied

Urgestein

Veteran

Moderator

Veteran

Urgestein

Mitglied

Veteran

Urgestein

Veteran

Mitglied

Neuling

Urgestein

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →