Return values and telemetry

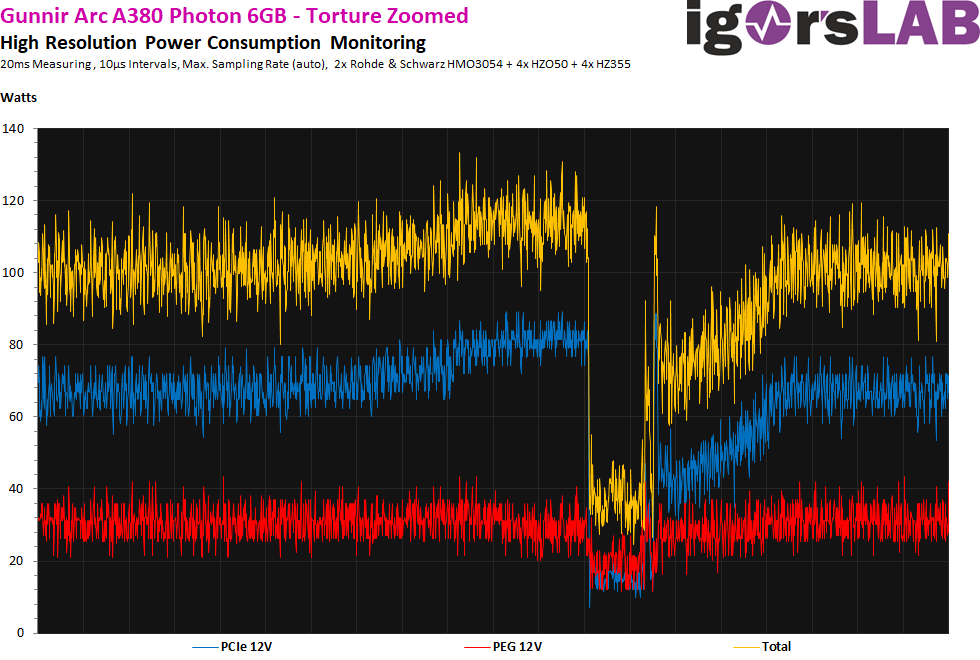

You have to watch carefully for some return values in third-party programs, because the clock rates are not always rendered cleanly either, for example. Even if there is hardly any difference between 2448 MHz and 2450 MHz, it should rather be a matter of conversion errors, because zero was returned from time to time, even if there were no frame drops. I also don’t really trust the reported power consumption, since on the one hand the value only exclusively refers to the GPU (and not the whole card) and on the other hand it doesn’t correlate (load change) with what could be measured directly at the PCIe port.

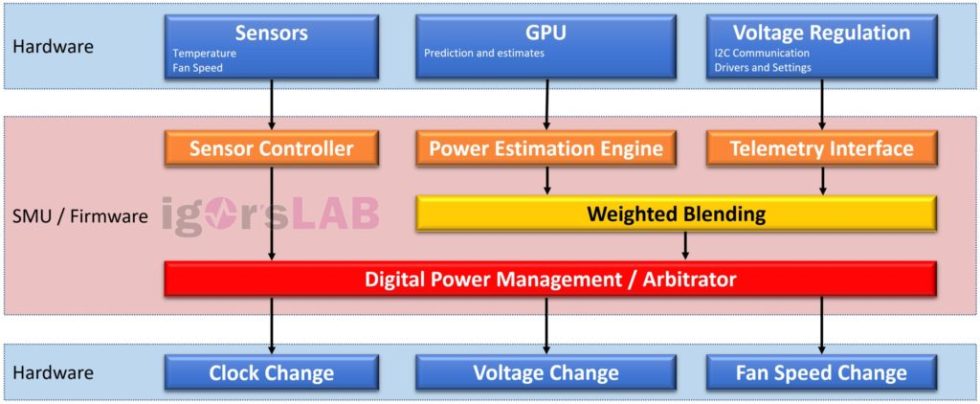

In general, the arbitrator seems to work much more granularly, i.e. much coarser, than AMD’s Power Tune or NVIDIA’s Boost, and a real power estimation does not seem to take place either. This certainly explains the exploding power consumption during permanent loads like compute or in stress tests. In contrast to the Radeon RX 6400, the dip is more than ten times as long when the load is too high, and the curve up to the dip is also ascending and not descending. This is reminiscent of a certain hiccup and could also be one (of several) causes for the rather modest image output.

Resizable Bar (rBAR)

Without this feature enabled in the motherboard for direct access to the extended address range, the card is virtually helpless and extremely slow. This is actually always true, even when running games or even workstation applications that do not officially use rBAR or have been optimized for it. I already mentioned the MX25U6432F from Macronix in the teardown and the assumption that Intel microcode that is not on current Ryzen systems has to be reloaded here. This at least explains why a Ryzen 7 5800 X3D on an MSI MEG X570 Godlike with the very latest BIOS generates just as bad results in benchmarks as the used Z690 board with disabled rBAR. The results sometimes coincided almost to the decimal place.

If this continues with the larger cards, Intel has deliberately implemented a hard separation from other (and its own older) platforms, which is completely unacceptable for the unsuspecting customer in this form. Intel cards thus only perform on some current Intel motherboards? If this continues, it should definitely be discussed in public.

Overclocking

The Arc Control Center allows overclocking by a maximum of 100 MHz. If you move the slider further to the right, you end up back at 2450 MHz instead of the maximum possible 2550 MHz, and even further to the right (if you make a mistake), the entire system freezes irrecoverably, because everything is taken over in real time and you didn’t have to use the Apply button. Useless, especially since the whole GUI has the character of an unfinished piece of frickleware that lacks important functions. One wonders what has really happened since the software was announced three years ago (!) and today.

You get the 2550 MHz with about 20% preset power increase if you have increased the offset for the voltage BEFORE. If you forget this by mistake, you will get a frozen system again with a bit of bad luck. If you then check the box that the values should be automatically applied at Windows startup, then good night. The only solution is to use a second graphics card of a different type and to remove the Arc Control Center after the reboot.

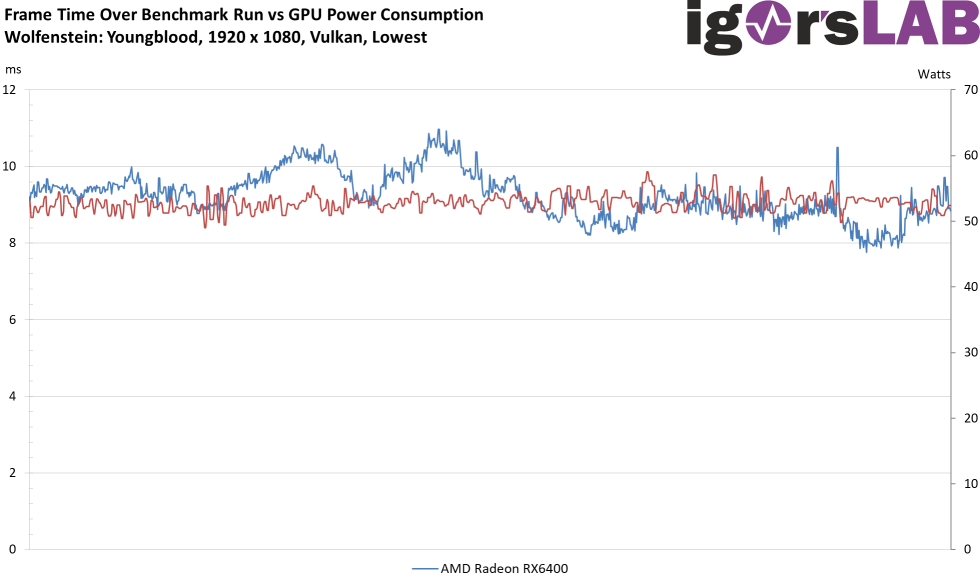

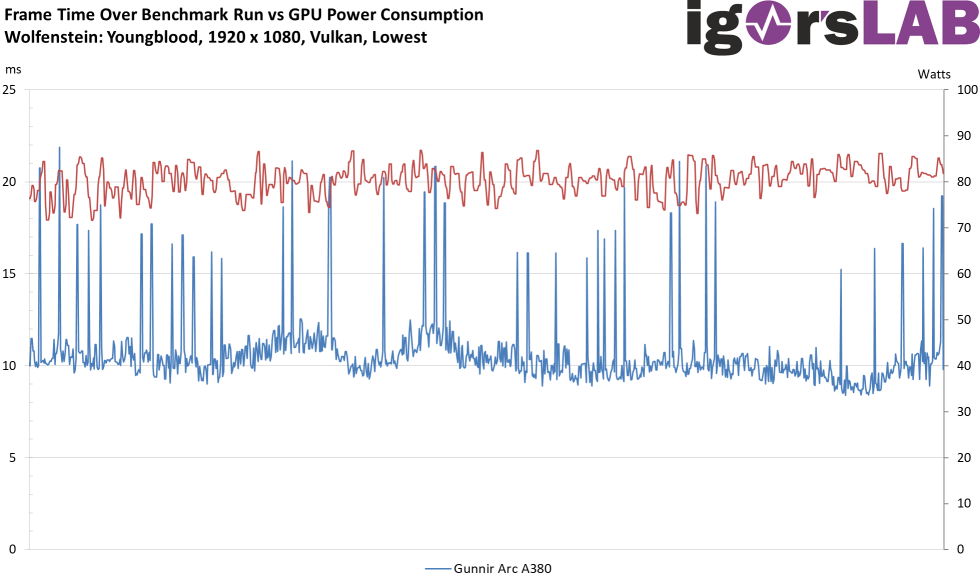

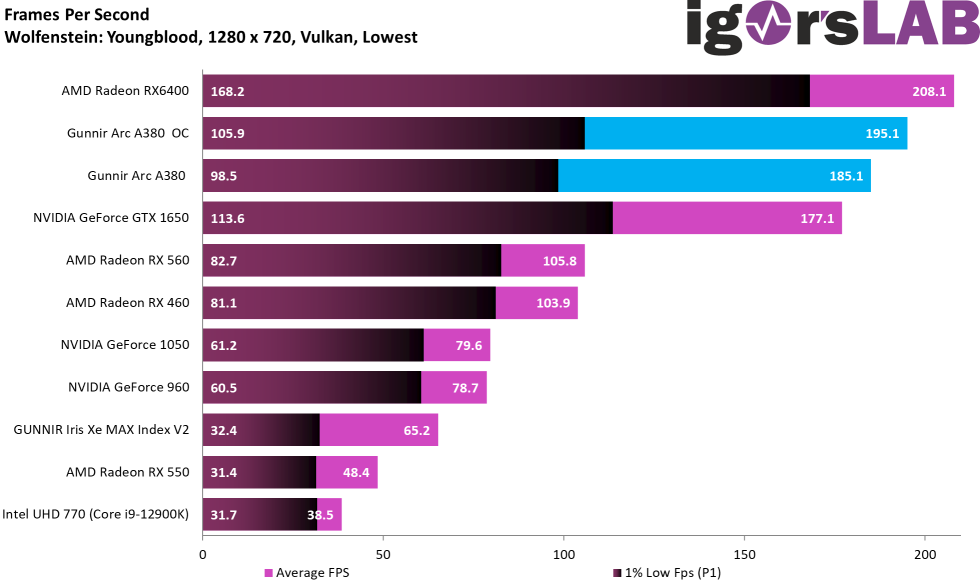

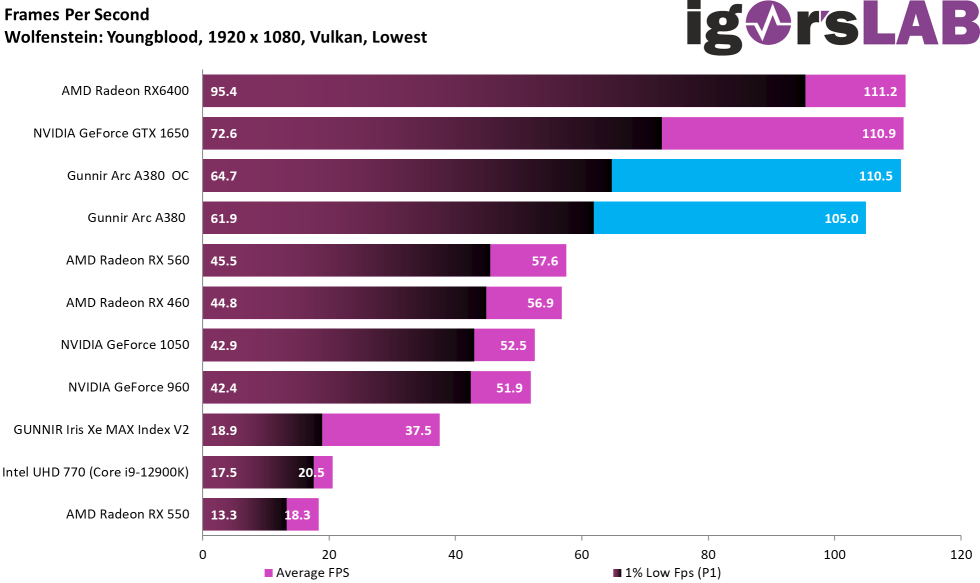

Then, for example, there was a Russian YouTuber who attested the Arc A380 a “huge” overclocking potential, whereby the percentage performance increase in the average FPS was even far above the clock increase in his case. The P1 (the min-FPS as percentile with the 1% low) is also said to have increased. Yes, that’s true (within certain limits), but it’s much too superficial, because the card still has a peculiarity that you can’t capture so easily with the P1. That’s exactly what I’m coming to now. Also compared to the Radeon RX 6400 (thanks to CAPACYTOR for the support!) in the lower left picture and a GTX 1650 Gaming from MSI (not in the picture).

Extremely poor frame times and variances

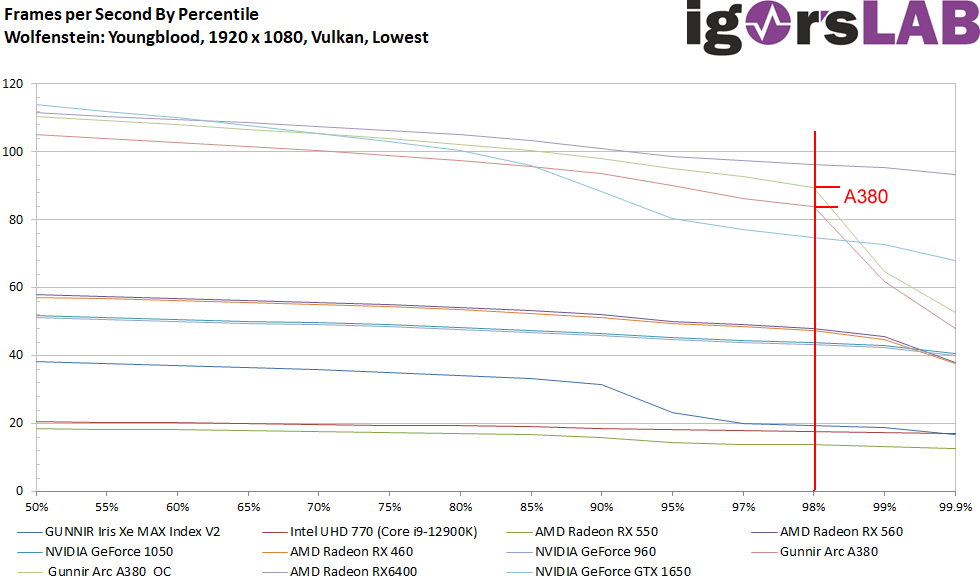

I’m deliberately presenting a game here as an example so that you won’t be blinded by the benchmark bars on the next pages. The P1 already shows that the frame times of Intel’s Arc A380 are significantly worse than those of the other two cards, but this is not obvious so quickly. Furthermore, the Arc A380 also suffers from the driver bottleneck, although not quite as bad as the GeForce GTX 1650. That is the first realization, but it gets much worse.

In general, it doesn’t matter whether the Arc A380 is now running in 720p or 1080p, the frame times, that is, the render time of the frames, and it jumps (more or less depending on the game) like crazy. However, I took the 1080p measurement because I didn’t want to include the bottleneck. Nevertheless, you can still see a considerably less smooth scrolling (micro jerks). You only have to compare the smooth Radeon RX 6400 with the Arc A380 without and with OC. I think the pictures clearly speak for themselves here!

If you still don’t believe that, you just have to take a look at the variances, because this doesn’t get any better and even the iGP of the Core i9-12900K performs more balanced:

If you still don’t believe that, you just have to take a look at the variances, because this doesn’t get any better and even the iGP of the Core i9-12900K performs more balanced:

If we plot the percentiles as a curve, we also see that the min-FPS should actually be plotted as 2% low due to the amount of spikes in order to remain objective and not only as 1% low (“99th percentile”). Which makes it clear, at this point at the latest, why influencers often act far below the required level of due diligence. Either they can’t do better or don’t want to/don’t want to.

- 1 - Introduction, an important foreword, specs und details

- 2 - Unboxing, hi-res pictures and features

- 3 - Teardown: PCB and cooler

- 4 - Telemetry, overclocking, bottleneck and micro stuttering

- 5 - FPS - Frames Per Second

- 6 - FPS - Curves

- 7 - Percentiles - Curves

- 8 - Frame Times - Percentage shares as a bar chart

- 9 - Frame Times - Curves

- 10 - Variances - Percentage shares as a bar chart

- 11 - AutoCAD 2021 and Inventor Pro 2021

- 12 - 3ds Max, Catia, Creo, Energy

- 13 - Maya, Medical, Siemens NC, SW 2017

- 14 - Power consumption as an overall consideration

- 15 - Load peaks and power supply recommendation

- 16 - Power consumption individually for all games

- 17 - Efficiency individually for all games

- 18 - Clock rate, temperatures, fan speed and noise

- 19 - Summary and conclusion

97 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

1

Urgestein

Moderator

Mitglied

Veteran

1

Mitglied

Mitglied

Urgestein

1

Urgestein

Urgestein

Mitglied

Veteran

Urgestein

1

Alle Kommentare lesen unter igor´sLAB Community →