Performance summary

Even though I have already drawn fairly clear conclusions on the previous pages, I would like to briefly summarize what has been shown and described so far. Unfortunately, driver and certainly firmware as well as architecture problems still cause this card a lot of trouble. This also applies to the workstation and CAD applications, where the Arc A380 even performed acceptably in some places, but had to accept bitter performance losses in other applications or ran unstably and even crashed. Such wonky beta drivers are not suitable for productive use and I can only advise against using this card in sensitive areas where stability and accuracy are also important.

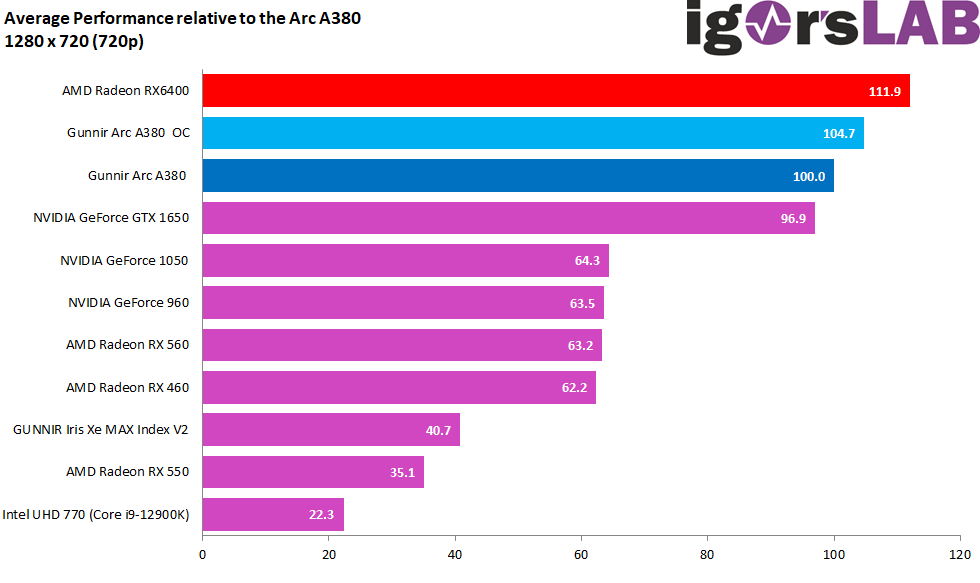

Do we now come to gaming, as it is advertised as a gaming card. Thus, the non-overclocked card is almost 12 percentage points behind the Radeon RX 6400, which cannot be overclocked at all, in 720p gaming. An Arc A380 overclocked to its technical limits is still almost 5 percentage points slower here. The driver overhead is certainly to blame here, which naturally leads to a certain bottleneck.

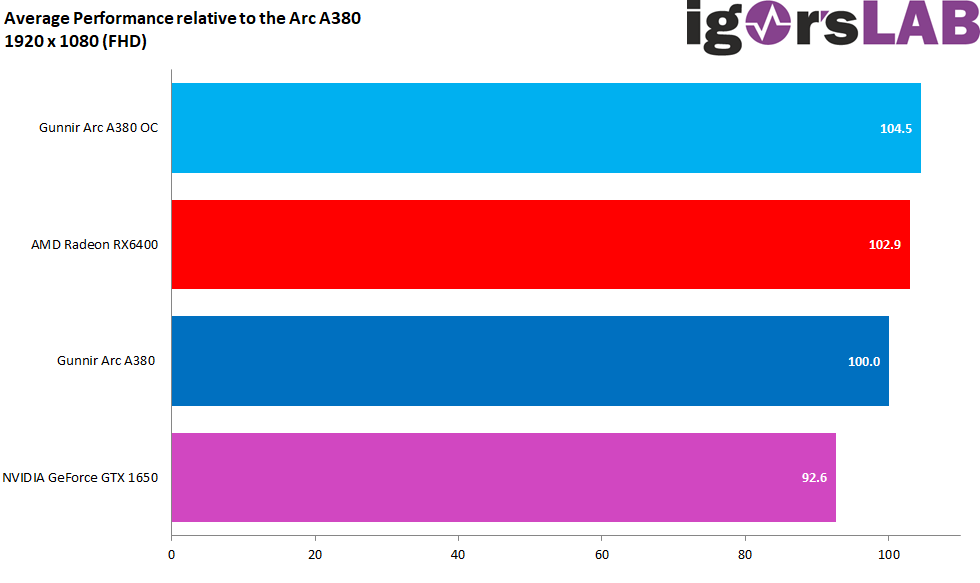

In Full-HD, at least the overclocked Arc A380 can get ahead of the Radeon RX 6400, even though 1.6 percentage points are almost nothing. It’s already 4.5 percentage points to the non-overclocked Arc A380, while the Radeon RX 6400 is almost 3 percentage points ahead of the Arc A380. Without overclocking, the Intel card would also be slower than the small AMD card here, which is really shameful when we look at the P1 in a moment.

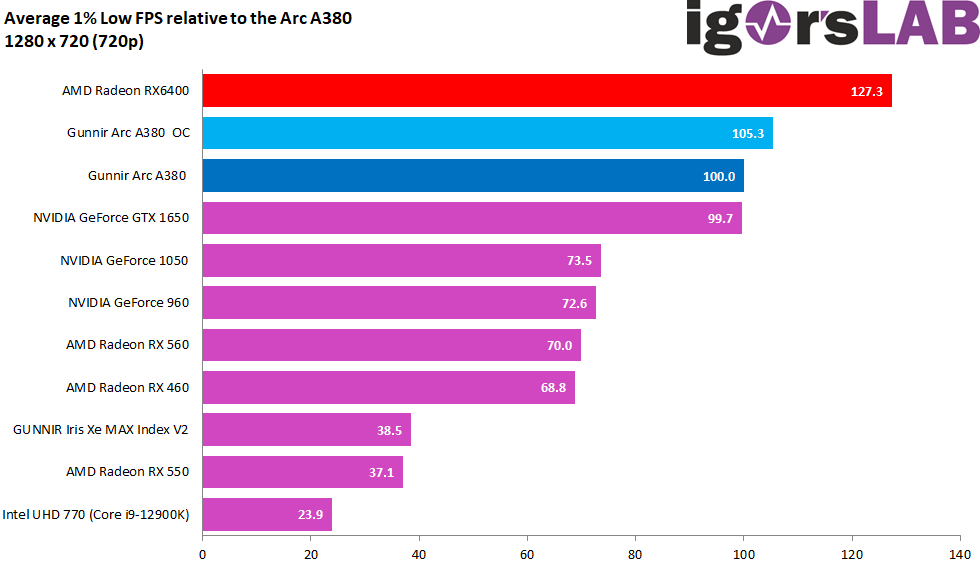

The so-called P1 (1% of the slowest FPS) replaces the Min FPS and here Intel’s Arc A380 in 720p almost gets a humiliation. The Radeon RX 6400 is a full 27.3 (!) percent ahead of the non-overclocked Arc A380 and 22 percentage points ahead of the overclocked variant, which again points to real driver problems. If you use a significantly slower Core i5-12400 instead of the Core i9-12900K, the dilemma even gets drastically worse in the P1, even later in Full HD.

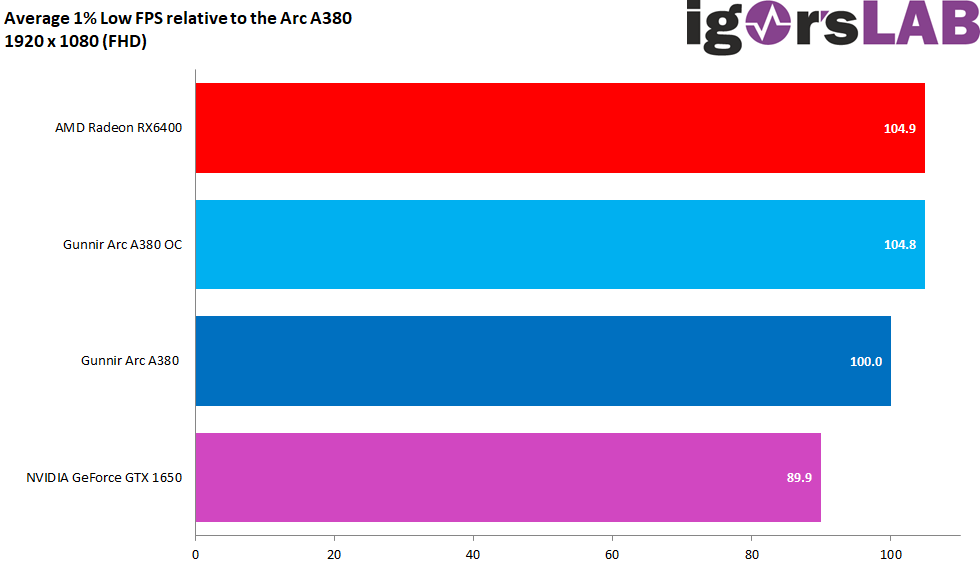

In Full HD, this effect is blown away, at least with the fast Core i9-12900K, and the Radeon RX 6400 is only about 5 percentage points ahead of the Arc A380 and practically on par with its heavily overclocked variant.

Power consumption in gaming

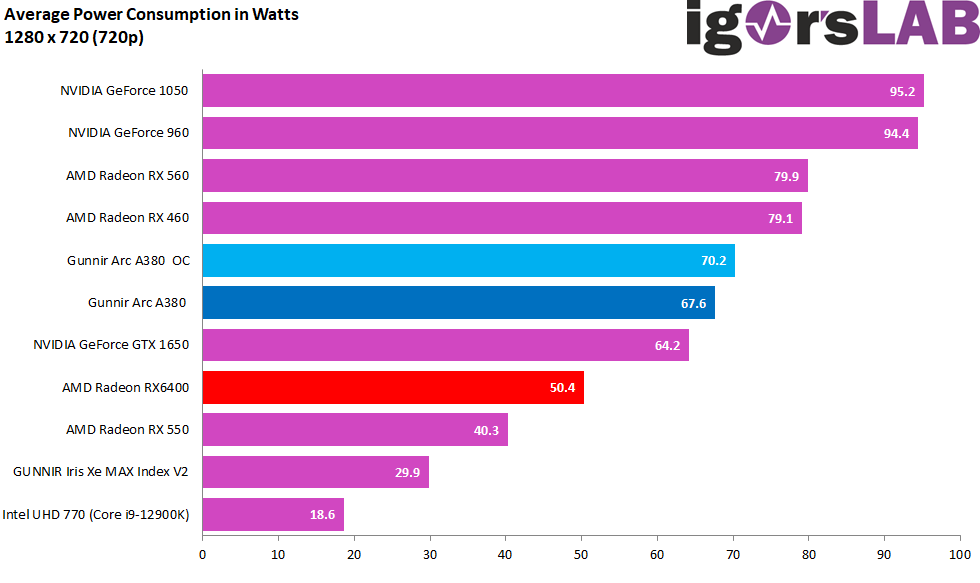

As long as the CPU is limited in 720p, the Arc A380 is plenty 17 watts above the Radeon RX 6400, in overclocked state it is almost 20 watts. Of course, these are average values and in some games it is already 80 watts with the Arc A380 and even 83 watts with OC. By then, the gap is already huge.

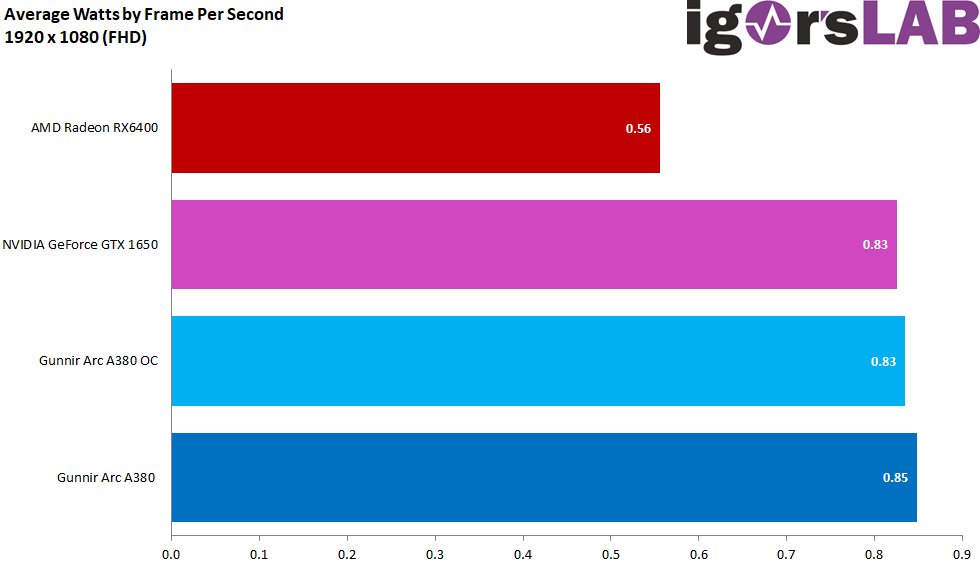

Even in Full-HD, the Arc A380 is almost 25 or even almost 27 watts higher than the Radeon RX 6400 with OC. That is over 52 percentage points more for an only identical overall performance and a worse picture quality in some games.

This is also reflected in the efficiency rate, where it even falls behind the age-old GeForce GTX 1650, which was already inflated by NVIDIA ex-factory. But it is now 2022 and energy is slowly becoming a luxury good.

Conclusion

I had hoped that my conclusion would be a bit more positive, because NVIDIA and also AMD currently act as a profitable duopoly in dedicated GPUs and a change would do the market more than good. Even if Intel still claims the market leadership especially in laptops due to its integrated GPUs, it was actually a logical consequence to finally get back into the mix properly in discrete graphics solutions as well. The Arc A380 tested today is the first available Alchemist model with Xe-HPG architecture, supports ray tracing, features an AV1 decoder and encoder that is unique in this price range, and is manufactured in the competitive 6nm EUV. Our expectations were accordingly quite high (which was of course also due to Intel’s eager PR activity). The fall from the self-imposed height is all the harder because the Arc A380 disappoints in almost all respects.

However, the first thing that stood out was the driver problems that still exist with certain titles and technologies. Especially since the technical implementation by the boardparter also suggests extreme cost-cutting constraints. Equipping a card, which can consume well over 100 watts with a bit of bad will, with only a measly 2 phases for the GPU is quite sporty, especially since not a single voltage converter is cooled. The lousy assembly including incomplete and too thick pads as well as way too much thermal paste are also in the review. Intel can’t do anything about that, and that’s entirely the board partner’s fault.

What is negative for Intel, however, is the (technical restriction) to current Intel platforms with rBAR. Without this feature, nothing really works, even if the affected application does not actively use rBAR at all. I have already written enough about the possible causes in the teardown. Well, and the power consumption is a chapter of its own. To deliver the same performance as the competitors with up to 50 percentage points more is very questionable, especially since the production node should be the slightly better one.

Actually, it lacks everything, not only performance and efficiency, but also many features that should be self-evident by now. DSR/VRS or image sharpening are not available and XeSS is painfully missing as an alternative to NVIDIA’s DLSS or AMD’s FSR. Well, that can be handed in later, but I have to make the conclusion today and here. And that is why the card did not pass in my eyes. Those who are capable of suffering or are curious, have the spare change and want to experiment with the unicorn, can of course grab it. However, those who have to turn over the penny three times are currently much better off with AMD and NVIDIA.

The tested card does not come from Intel, but it is a pure private investment as a self-import. There was also no cooperation with Intel or any influence of the GPU manufacturer on the tests and the conclusion. My personal thanks go to the hardware donors and the BIOS team, as well as to my family, who steadfastly endured my increasingly bad mood.

- 1 - Introduction, an important foreword, specs und details

- 2 - Unboxing, hi-res pictures and features

- 3 - Teardown: PCB and cooler

- 4 - Telemetry, overclocking, bottleneck and micro stuttering

- 5 - FPS - Frames Per Second

- 6 - FPS - Curves

- 7 - Percentiles - Curves

- 8 - Frame Times - Percentage shares as a bar chart

- 9 - Frame Times - Curves

- 10 - Variances - Percentage shares as a bar chart

- 11 - AutoCAD 2021 and Inventor Pro 2021

- 12 - 3ds Max, Catia, Creo, Energy

- 13 - Maya, Medical, Siemens NC, SW 2017

- 14 - Power consumption as an overall consideration

- 15 - Load peaks and power supply recommendation

- 16 - Power consumption individually for all games

- 17 - Efficiency individually for all games

- 18 - Clock rate, temperatures, fan speed and noise

- 19 - Summary and conclusion

97 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

1

Urgestein

Moderator

Mitglied

Veteran

1

Mitglied

Mitglied

Urgestein

1

Urgestein

Urgestein

Mitglied

Veteran

Urgestein

1

Alle Kommentare lesen unter igor´sLAB Community →