Actually, I wanted to digest yesterday’s launch of the GeForce RTX 4070 and the associated additional load first and then dive into the individual reviews of the various cards, but there are really things that make you think in the concentrated power. The normal Reviewer will probably not see it for lack of sensitization for technical carelessness and the customer of course not at all (how also), only I have noticed things in the last days with all “MSRP cards” present here, which one does not have to accept so actually.

The fact that NVIDIA tries to counteract the current price spiral at least a bit by more or less directly advising every manufacturer to also offer products at the RRP is quite commendable. However, the problem is elegantly shifted to the board partner (AIC) and you can sit back and relax because you have a certain price advantage with the Founders Edition by using your own chips. And the AIC then starts searching for the last penny to save, which leads to quite strange restrictions in places.

You can rant about the board partners all you want, but I’ll let you in on a secret about these MSRP cards: they yield almost no margin, and in the aggregate, with all the other costs, up to and including support and RMA, even mean a certain unpredictability. These prices are yes FOB (“Free on Board”), which means nothing else, it is the responsibility of the importer or distributor to find and pay a freight forwarder to handle the shipment first, however, these local costs in the country of origin China, Hong Kong or Taiwan (i.e. all services related to transportation until the shipment is fully loaded) will then be charged directly back to the AIC. And that costs a lot.

I’ll put it this way: I wouldn’t buy such a cheap card privately, because the price almost prevents a solid implementation. A Founders Edition, on the other hand, would be possible, but NVIDIA hasn’t to pay for the bundle of chip and RAM. Self-sufficiency FTW. This is not to say that the cards don’t work, of course they do, but it almost always just seems cheap and uncharitably implemented. At 300 or 400 Euros I certainly wouldn’t have written this article today either, but for around 660 Euros I don’t want a rickety plastic bomber with a license to sizzle, but a solid solution. Why I’m so annoyed is actually listed quickly, except I have to start with the source of my complaints. And one more thing: I’m not naming any manufacturer names and products for now, but am actively clarifying the issues with the respective developers right now. But you can see just as well where the shoe pinches.

Starting point: Voltage transformers and the Founders Edition

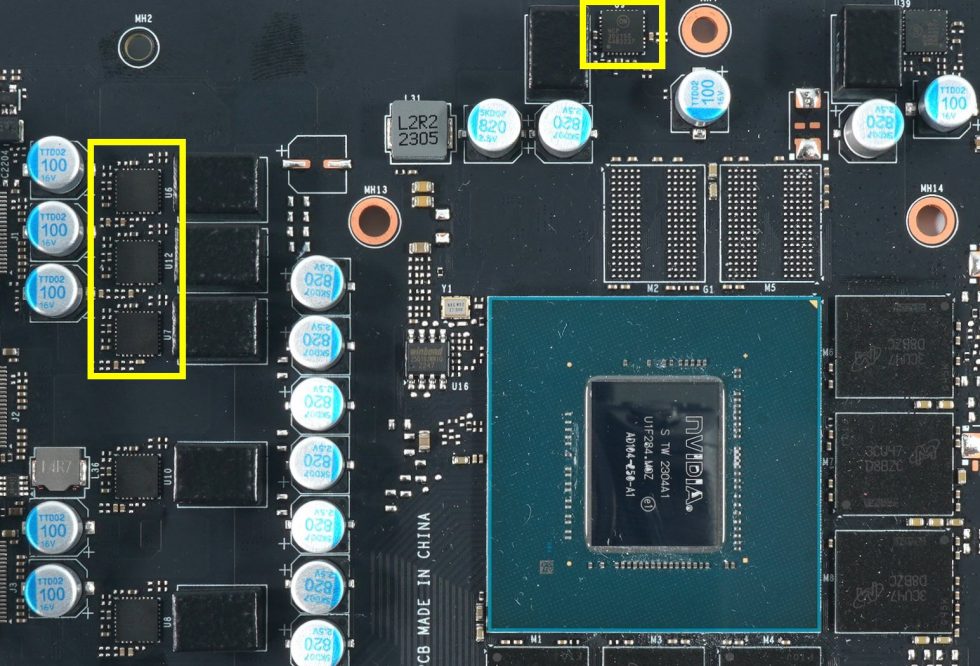

Both the Founders Edition and most board partner cards only use 6 phases, thus also only 6 voltage converters for the GPU voltage (NVVDD). By the way, according to the reference board, up to 10 would be possible. That in turn would require a much more expensive PWM controller, which is why they reduced the number significantly. The 200 watts on just 6 phases can certainly be done, but if we look at both the FE and the exemplary board partner card (pictured below), we see a somewhat ludicrous distribution. Three of the DrMOS (VRM) are individually scattered (giving per se lower hotspots) and three are in a block together. I have highlighted this in yellow as a potential source of cooling problems. Another marker concerns the single transducer at the top of the card. But I will come to that later

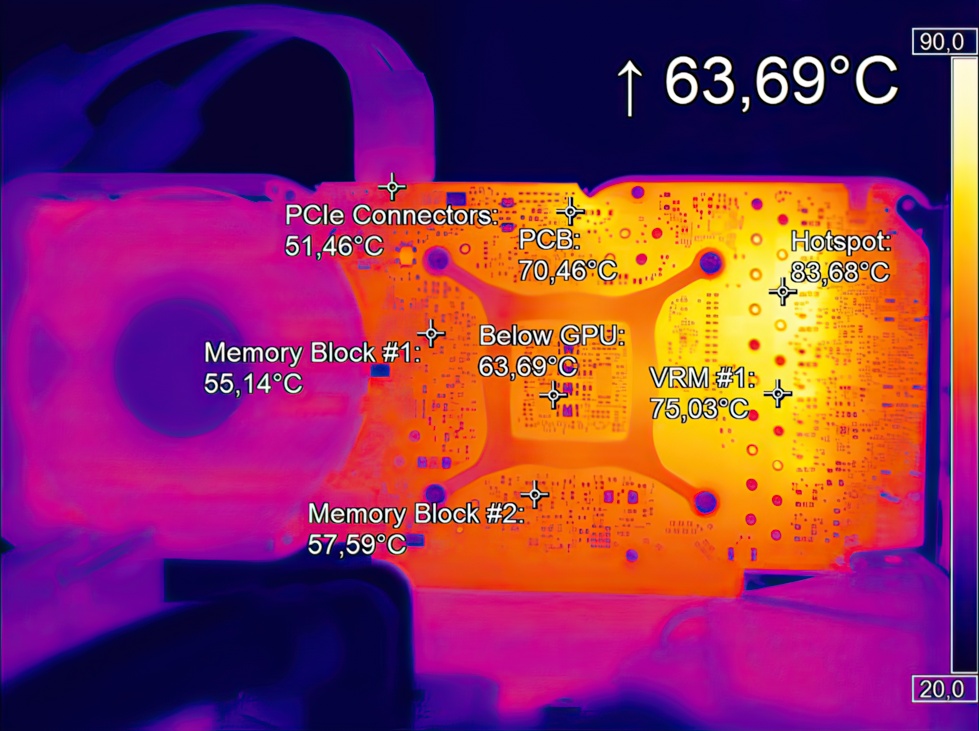

Let’s now take a look at the result of this “shortage” using the Founders Edition in a simple IR recording after 30 minutes of stress test (picture below) and exactly 200 watts TBP. The hotspot is on the block of 3, the single VRM at the top is still labeled “PCB” here.

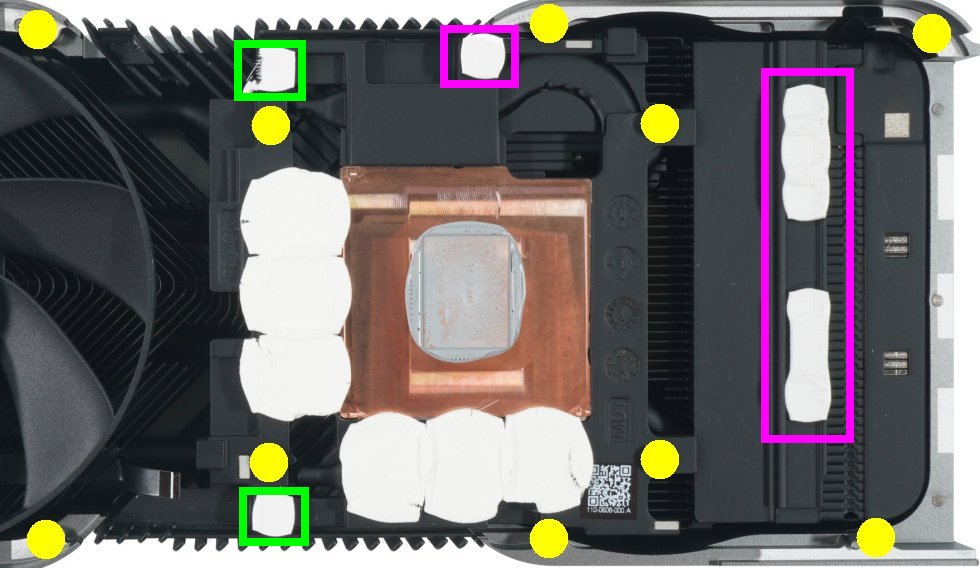

Let’s now take a look at the Founders Edition cooler. We can see that both the vertically arranged voltage converters and the one single one are thermally connected to the cooler frame by means of a pad (purple frame). The two voltage converters for the memory are marked in green and are also actively cooled. But what is actually even more important: A total of 10 screws (including the 4 screws for the GPU heatsink) fix the board rigidly to the cooler. Thus, this board can neither bend nor move and the contact pressure of the pads and thus also the contact to the voltage transformers is guaranteed and consistently high.

This is exactly the point where I wrote: Yes, you can definitely do it with 6 transducers. The only thing is that you have to implement it in the right way mechanically. What exactly can (and almost must) go wrong in the process is shown on the next page.

121 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Mitglied

Urgestein

Moderator

Mitglied

Urgestein

Veteran

Urgestein

Urgestein

Mitglied

Mitglied

Urgestein

Urgestein

Mitglied

Veteran

Urgestein

Urgestein

1

Moderator

Alle Kommentare lesen unter igor´sLAB Community →