A touch of sanity: EVGA GeForce GTX 690 in reference design

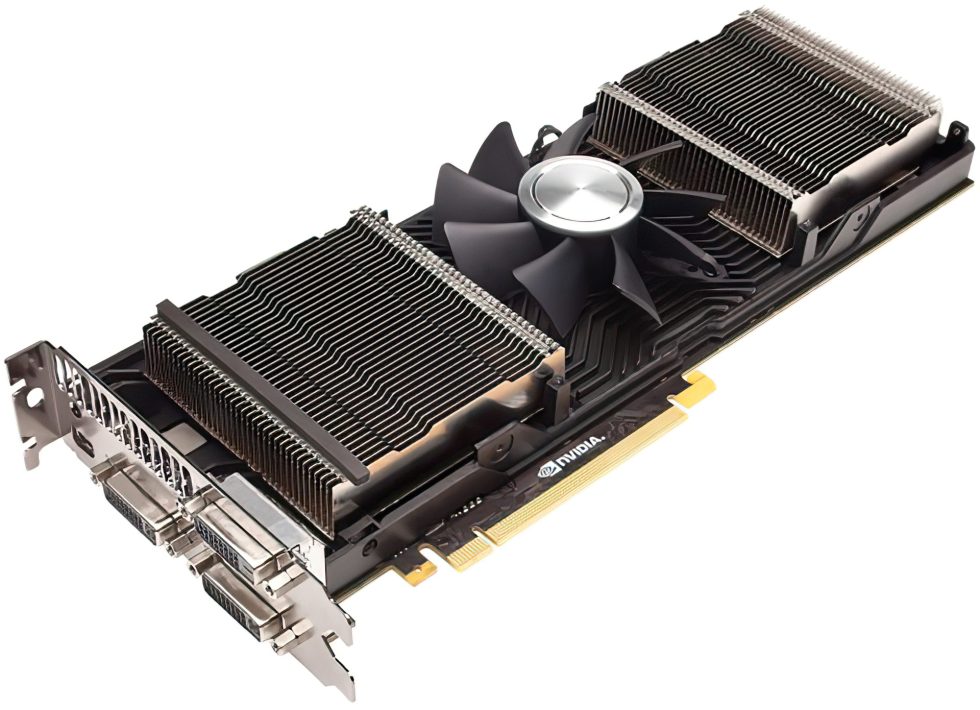

The GeForce GTX 690 is also only available from EVGA in the reference design, which was already solved so optimally by Nvidia in the end that hardly any requests for improvements were made. The fairly flat and, at 1.04 kg, not overly heavy card represents the spearhead in Nvidia’s current portfolio.

The very spartan-looking outer packaging doesn’t yet hint at the racy contents.

However, EVGA doesn’t let itself down when it comes to the package contents and includes glossy posters and stickers besides the obligatory accessories.

The GeForce GTX 690 consists of 2 fully-fledged GK104 chips, as they are also installed on the GeForce GTX 680. This results in a total of 3072 CUDA cores (1536 per card), the number of texture units per GPU also remains the same (128 each), just like the 32 ROPs per card part.

However, the older NF200 bridge chip is now replaced by a PCIe 3.0 solution, which Nvidia buys from PLX in the form of a PEX 8747. The chip replaces the old PCIe 2.0 bottleneck with 48 lanes, 16 from each GPU and 16 to the bus interface. It should be possible to keep the targeted latencies low (>126 ns).

As with the GTX 680, each GPU on this card can access 2 GB of GDDR5 memory, which is connected via the already familiar 256-bit memory interface. The memory throughput should thus remain identical to the GTX 680 for each of the two GPUs (192 GB/s bandwidth).

However, the GPU clock has dropped, which is now only 915 MHz instead of the GTX 680’s 1006 MHz. However, if you take the targeted TDP limit of 300 watts as a guideline, the Turbo should definitely be able to clock the cores up to 1019 MHz. However, that would only be just below the value of a single GTX 680.

The two 8-pin connectors are supposed to fix it, because after all you could burn a proud 375 watts including the 75 watts that the slot itself supplies. The predecessor, the GTX 590, was only slightly below this maximum. Since these dual GPU cards usually consume less than two similar single cards in SLI, the advertised maximum value of 300 watts should not be that far from reality.

Up to 4 monitors can be controlled via three DVI outputs and one DisplayPort port.

EVGA’s very accommodating warranty system should also be highlighted: Read more….

- 1 - Introduction and overview

- 2 - The challenger: HIS 7970 X2

- 3 - The efficient: EVGA GTX 690

- 4 - The beauty: PowerColor 7990 Devil 13

- 5 - Synthetic benchmarks

- 6 - Gaming benchmarks (Catalyst 12.11)

- 7 - Micro stuttering: the current situation

- 8 - Micro stuttering: AFR render methods

- 9 - Micro stuttering: adaptive VSync (Nvidia)

- 10 - Micro stuttering: dynamic VSync (AMD)

- 11 - Power consumption and temperatures

- 12 - Fan speed and noise (with videos)

- 13 - Summary and conclusion

13 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Urgestein

Mitglied

Urgestein

Urgestein

Mitglied

Urgestein

Urgestein

1

Mitglied

Neuling

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →