Memory details

The Radeon RX 6600 (XT) and a possible RX 6600M will rely on PCIe 4, which is of course in the genes of RDNA2 per se, but suits the card immensely. The half memory configuration of 8 GB GDDR6 for the RX 6600 and of only 4 GB for a RX 6500 (M) logically results from the chip and the number of memory controllers. It also hardly makes sense to connect large 2GB modules to a 128-bit bus, that would probably be a waste of resources in the end. As a full-HD card, the RX 6600 (XT) with the 8 GB will certainly get by for a while.

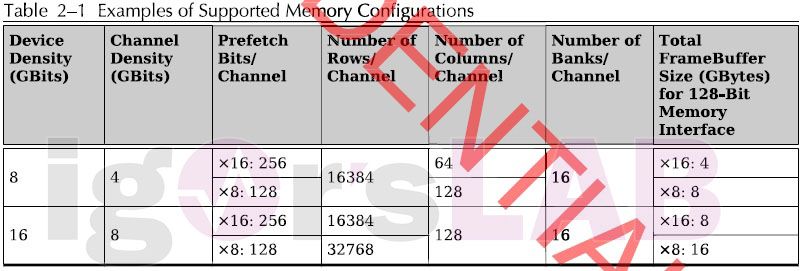

Let’s first look at the table from my slide, which once again confirms the memory expansion. Thus, Navi 23 is said to rely on a 128-bit memory interface with eight independent memory channels, to which up to four identical GDDR6 memory modules can be connected in x16 mode and up to eight in x8 mode.

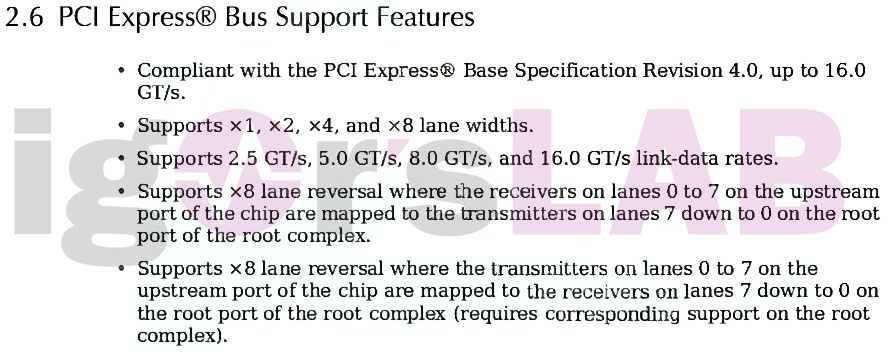

All this is not too dramatic, but a card whose pure computing performance is expected to be at or slightly above a Radeon RX 5700 XT should also have a proper connection at the PCIe slot with enough lanes, which influences the communication with the rest of the system, especially the CPU. And that’s where this cross-platform concept becomes a potential bottleneck, if the desktop GPU follows the same limitations as the notebook variant. We already had this with the RX 5500XT, whose chips were used on both platforms, because a fragmentation in this segment was simply not worthwhile from a commercial point of view.

PCI Express bus

What I’m getting at is the electrical connection with only 8 lanes instead of 16 , which should also be noticeable here. As long as PCIe 4 is used, the concept could of course work out, since lower clock rates are generally used in notebooks. It only gets tight when you put these cards in a 3rd generation PCIe slot, since the data rates are halved. With the RX 5500XT one could observe up to 7% performance loss on an older AMD system (or Intel up to generation 10) at that time.

If you now extrapolate the possible performance of an RX 6600 XT, then this could simply make a sensible use in systems with PCIe 3 pointless or influence it so strongly that the possible performance losses simply become too high. This makes this card completely uninteresting for potential upgraders. Also, this limited connectivity will probably make it impossible for a Radeon RX 6600 XT to even come close to catching up to a rumored RX 6700 (without XT) through OC.

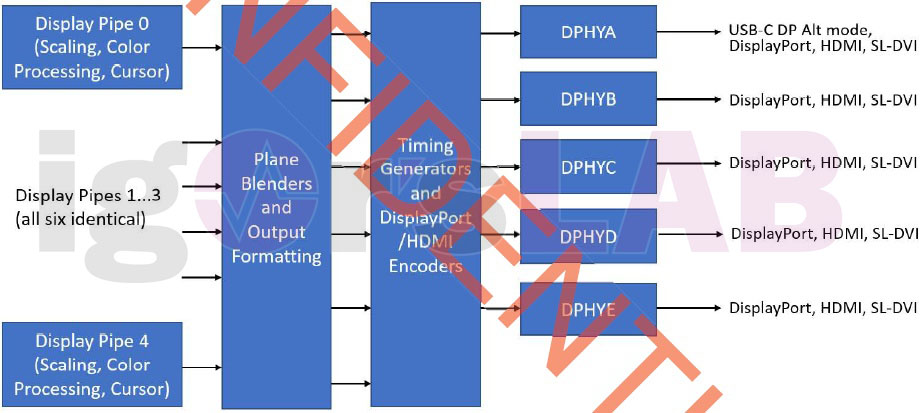

Display outputs

A total of 5 display outputs support DP 1.4a (or 4x DP + 1x USB-C), HDMI 2.1 and SL-DVI. If the information is correct, there will be a VP9 decoder, a HEVC decoder, a H.264 decoder and a VC1 decoder for hardware-based video acceleration. Again, we see in the variety of ports that you want to and can serve both notebook and desktop solutions. Even this chip also supports USB-C as an alternative replacement to DisplayPort, especially in notebooks.

21 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

Urgestein

1

Urgestein

Mitglied

1

Mitglied

Urgestein

Mitglied

1

Mitglied

Mitglied

Mitglied

Mitglied

Mitglied

Veteran

Alle Kommentare lesen unter igor´sLAB Community →