In Spielen zeichnet sich ein stark differenziertes Bild, manche Spiele brechen völlig ein an der Thunderbolt Schnittstelle, andere laufen hervorragend oder bis zu einer gewissen Framerate einwandfrei. Open World Titel machen der Bandbreite naturgemäß am meisten zu schaffen, hier wird viel aus dem Hauptspeicher gestreamt, die CPU-Last ist hoch.

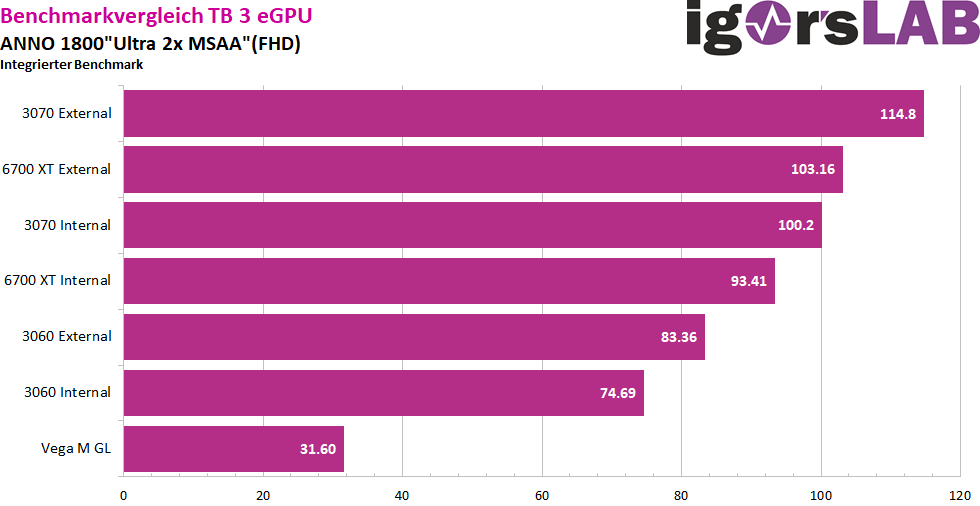

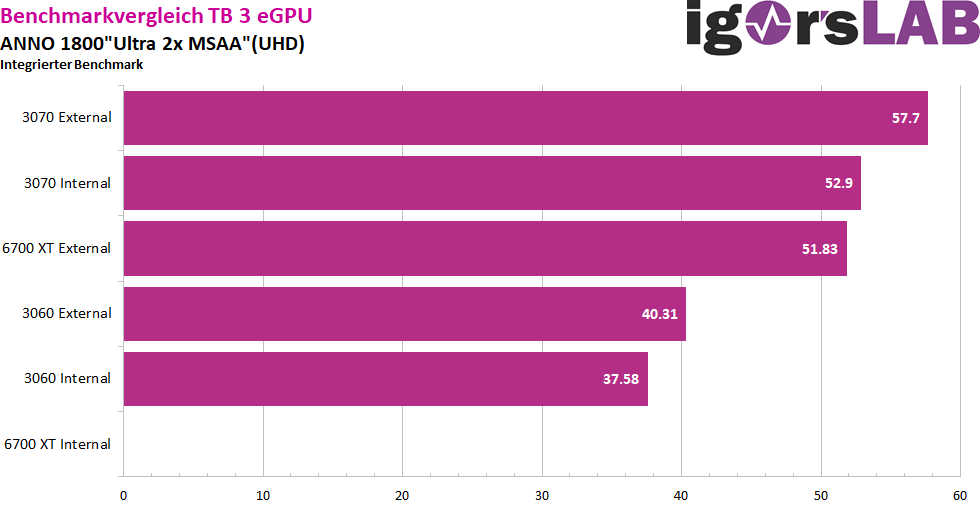

Anno 1800:

Anno läuft überraschend gut auf der eGPU, sowohl in FHD als auch in UHD. Leider waren meine Daten zur 5700XT nicht korrekt, daher fehlt diese leider hier in den Benchmarks. In UHD wollte die 6700XT einfach nicht mit dem internen Panel starten, die Ursache dafür ist mir nicht bekannt.

Die Abschläge sind mit etwas über 10% im Schnitt mehr als verkraftbar, das Spiel läuft auch in UHD noch top, selbst auf dem internen Panel, wobei die Engine von Anno das auch geschickt löst und einige Texturen manchmal recht spät reinladen.

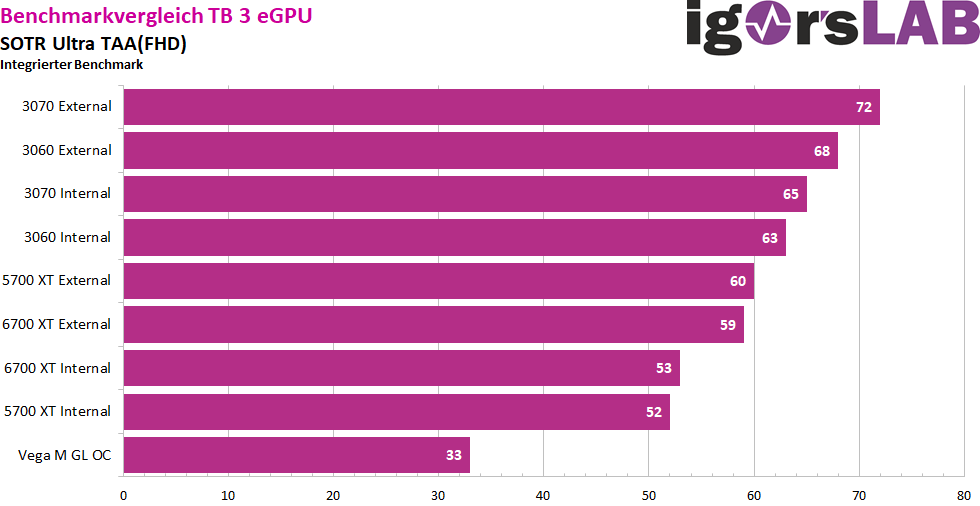

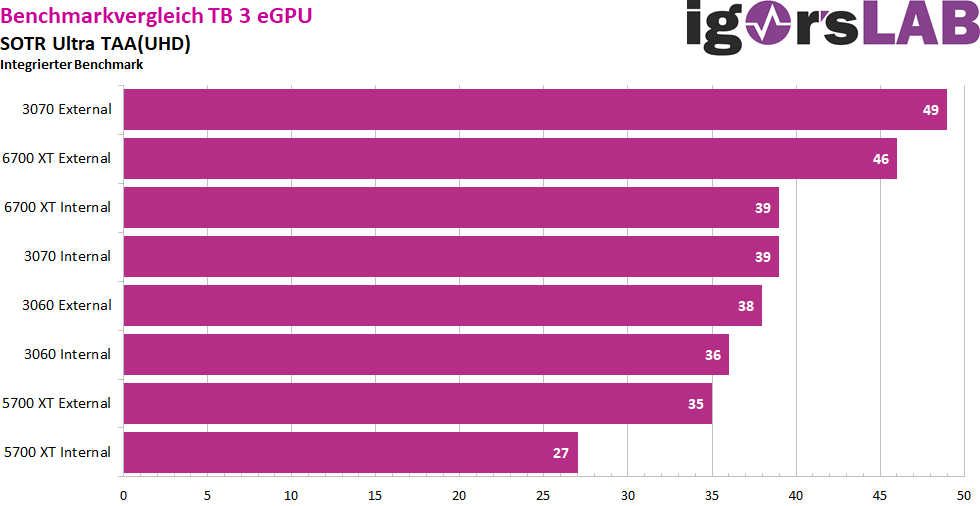

Shadow of the Tomb Raider

SotTR stellt hohe Anforderungen an die CPU, hier wechselt sich in FHD Bandbreitenlimit und CPU Limit sich je nach Szene ab. Auffällig hier, die 5700XT und die 6700XT sind quasi identisch schnell (oder eher langsam…). Auch die RTX 3060 und RTX 3070 sind recht nah beieinander, die Geforce Karten laufen deutlich besser im Allgemeinen. Man sieht hier an dem Beispiel sehr gut die Limitierung durch die Bandbreite in FHD, in UHD grenzen sich die Karten dann wieder stärker voneinander ab und die RX 6700XT und die RTX 3070 sind etwa auf Augenhöhe. Interessant auch hier wieder die 3060 die sich im Sweetspot bewegt und bei Einsatz am internen Panel Prozentual am wenigsten Leistung verliert. Die RX 5700XT macht mal wieder keine gute Figur bei Einsatz des internen Panels, die Vega schlägt sich tapfer.

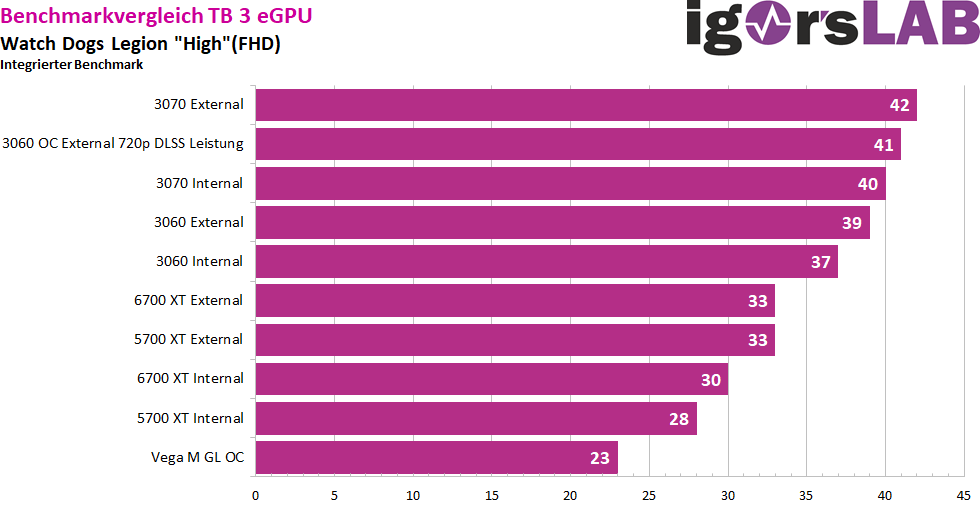

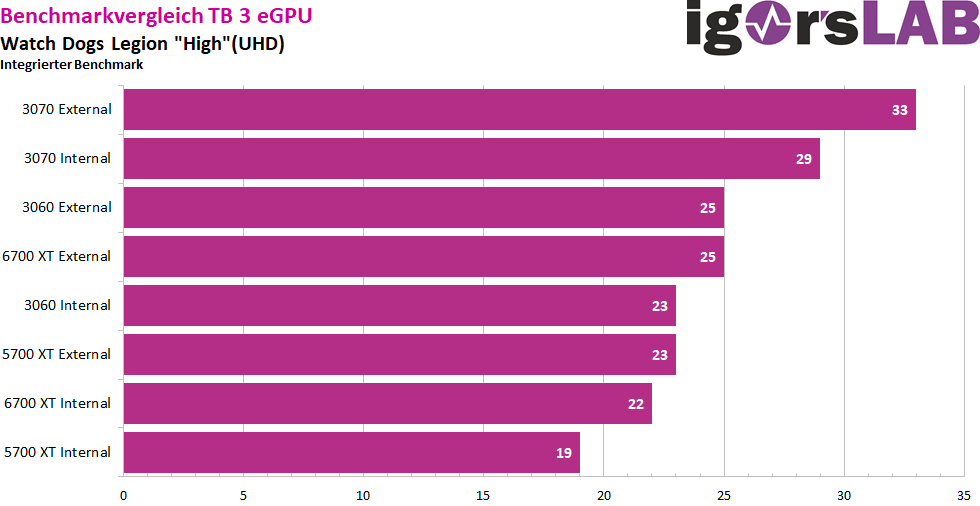

Watch Dogs Legion:

WDL ist der absolute Worstcase für eine eGPU, das Spiel ruckelt bereits im Menü. Die Framerates sind sehr niedrig, die Frametimes eine Katastrophe. Die Radeons laufen beide in dasselbe Limit in etwa, wir sehen hier als sehr deutlich eine Bandbreitenlimitierung. Auch die 3060 und die 3070 sind sehr nah beieinander. Die CPU ist in dem Spiel zwar gefordert, stellt aber nicht den limitierenden Faktor dar. Die Unterschiede zwischen externem und internem Panel sind Vergleichsweise gering. Die 3060 habe ich hier mal als Exempel maximal übertaktet, in 720p + DLSS Leistung um das Bandbreitenlimit zu verdeutlichen.

Die Vega M GL hängt hier kaum zurück gegenüber den Radeons da diese nicht von der Bandbreitenlimitierung betroffen ist, die 4GB HBM reichen in Watch Dogs in dem Preset aber vorne und hinten nicht mehr und der Chip bricht im letzten Drittel deutlich ein.

In UHD ist die 3060 so schnell wie die 6700XT die eigentlich locker knapp 30% schneller sein sollte.

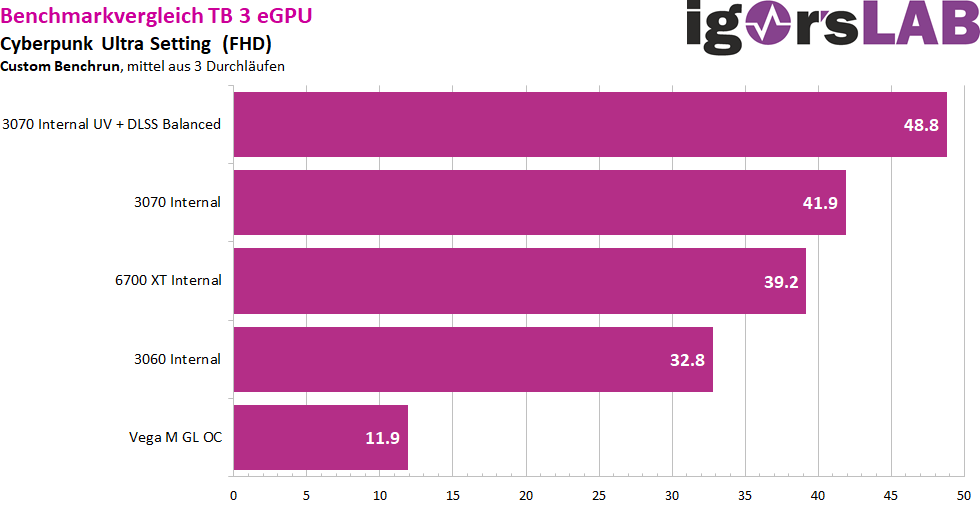

Cyberpunk

Hier habe ich bewusst nur mit dem internen Panel gemessen. Die Leistungsabstände passen hier soweit zwischen den Karten, eine RTX 3070 sollte hier aber in einem Desktopsystem locker die 60 FPS stemmen können, alle Karten bleiben unter den Erwartungen zurück, lassen sich aber auch entsprechend optimieren, dass die 60Fps erreicht werden. Die Frametimes sind stabil, DLSS skaliert zu meiner Überraschung hier doch deutlich besser als in Watch Dogs. Auf einem externen Panel sind etwa 20 % Mehrleistung drin bei allen drei Karten. Die CPU hat in dem Spiel auch gut zu tun, hier ist es schwer zu trennen ob die CPU oder die Bandbreite limitiert. Wahrscheinlich eine Mischung von beidem.

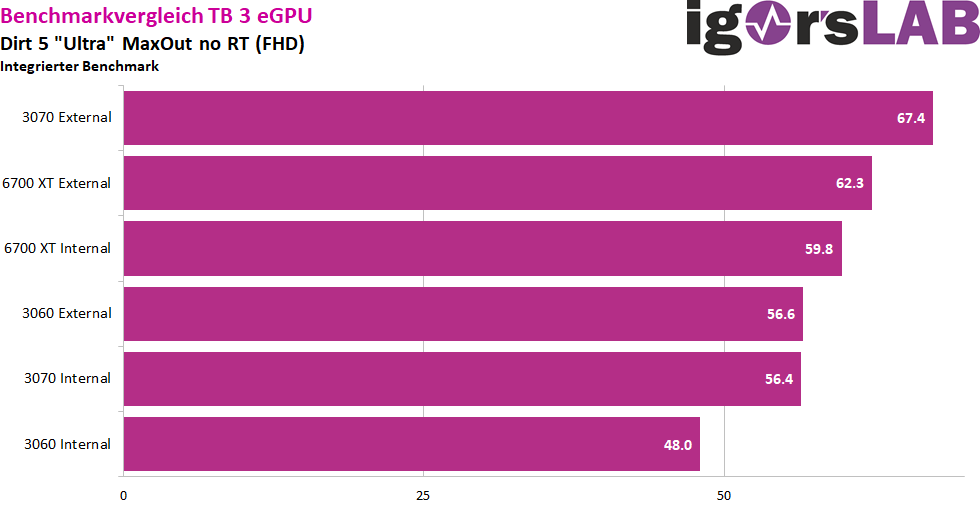

Dirt 5

Die 5700XT habe ich hier aus Zeitgründen nicht mehr getestet. Die CPU spielt in dem Spiel keine Rolle. Die RX 6700XT hat hier das erste Mal die Nase vorne beim Einsatz des internen Panels. Die beiden Geforce fallen stärker ab, sind aber beim Einsatz des externen Panels überlegen. Die RTX 3060 kommt dann an die 6700XT fast ran, es trennen beide Karten nur 10%, die RTX 3070 kann sich sogar recht deutlich absetzen in dem Fall. Die APU kassiert direkt eine Meldung wegen zu geringem VRAM, Endstation Speicher.

74 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Urgestein

Urgestein

Urgestein

Veteran

Urgestein

Urgestein

Urgestein

Urgestein

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →