Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Internetseiten nicht korrekt angezeigt werden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Du solltest ein Update durchführen oder einen alternativen Browser verwenden.

Reviews NVIDIA G-SYNC vs. AMD FreeSync vs. V-Sync? Wir messen die Systemlatenz! | Praxis

- Themenstarter Redaktion

- Beginndatum

- Mitglied seit

- Sep 17, 2019

- Beiträge

- 1.150

- Bewertungspunkte

- 1.567

- Punkte

- 115

- Alter

- 43

Ich empfehle min. 4 FPS unterhalb der Bildwiederholrate zu bleiben! Dann gibt es auch ohne V-Sync keinerlei Tearing...Hallo,

Danke erstamal für den tollen BerichtIch spiele wenn möglich immer mit einem "IGFL" und stelle denn Wert bei einem 144Hz Monitor auf 143. Vsync stelle ich dann immer auf aus.

Eine Frage hätte ich noch: "RegEdit Eintrag – Dword: TCPAckFrequency = 1 setzt, der sollte hier eine recht niedrige Serverlatenz haben."

Davon habe ich persönlich noch nie etwas gehört. Kannst du das evtl. noch ein wenig genauer erläutern? Zudem, ist das eine Einstellung die grundsätzlich jeder ohne Bedenken einstellen kann oder gibt es da Nachteile?

Vielen Dank!

Gruss

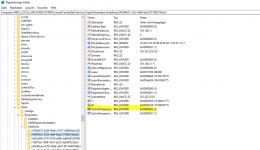

- Drücken die Tastenkombination [Windows] + [R] und geben "regedit" ein, um die Registry zu öffnen.

- Navigieren hier zu dem Pfad "Computer\HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services\Tcpip\Parameters\Interfaces".

- In diesem Ordner befinden sich mehrere Unterordner, suchen den Ordner, der die meisten Dateien enthält.

- Hast du den Ordner ausgemacht, klickt mit der rechten Maustaste im Ordner, um das Kontextmenü zu öffnen. Wähle hier "Neu -> DWORD-Wert (32-Bit).

- Nenne diesen Wert "TcpAckFrequency" und klicken Sie ihn an. In dem sich öffnenden Fenster änderst du den Hex-Wert von 0 auf 1 und bestätigen die Änderung mit "OK".

- Nach dem nächsten Neustart sollte der Ping deutlich verbessert sein.

Das hat in keine Nachtteile... zumindest ist mir nix bekannt... das mach ich seit Windows XP so... oder sogar noch früher... is halt ewig her! Das kann kann bzw. sollte jeder so in seiner Reg erstellen!

- Mitglied seit

- Sep 17, 2019

- Beiträge

- 1.150

- Bewertungspunkte

- 1.567

- Punkte

- 115

- Alter

- 43

Nein, ist bis auf leichtes Tearing nicht tragisch... also ich hab den 240 Hz Monitor im Zuge der Test mit weit über 300 FPS beschossen... tearing war kaum bemerkbar... es war deutlich spürbar, auf dem 75 Hz Monitor der nur FreeSync ohne VRR hat... hier aber unterhalb der 75 Hz... das war echt die HölleAlso ist es garnicht so tragisch bzw. sogar besser (bis auf Tearing) troz Freesync(144Hz Monitor) die FPS bei z.b. 170 zu deckeln

(gute Frametimes vorausgesetzt)?

- Mitglied seit

- Sep 17, 2019

- Beiträge

- 1.150

- Bewertungspunkte

- 1.567

- Punkte

- 115

- Alter

- 43

Also quasi 2 Framelimiter zur gleichen Zeit? z.B. RTSS auf 140 FPS und IGFL auf 130? Hab ich das so richtig verstanden?Jetzt fehlt nur noch der Test ob es Unterschiede gibt zwischen

IGFL

Nvidia FL

RTSS

Spezial K

und ob sich die Latenz erhöht wenn z. B. ein generelles Framelimit auf 142 per externem Tool aktiviert ist und zusätzlich der IGFL auf z. B. 138 genutzt wird

Wenn ja, dann erschleißt sich mir die Logik dahinter nicht? Warum zwei Mal limitieren?

G

Gelöschtes Mitglied 3446

Guest

Ne, zwei Limiter machen definitiv keinen Sinn und verschlechtern das Ergebnis nur.

Der In Game FL ist normalerweise, wenn er nicht kacke implementiert ist, jedem externen überlegen. Und der vom NVidia Treiber ist die zweitbeste Wahl, vor SpecialK und RTSS (die geben sich nicht mehr viel).

Der In Game FL ist normalerweise, wenn er nicht kacke implementiert ist, jedem externen überlegen. Und der vom NVidia Treiber ist die zweitbeste Wahl, vor SpecialK und RTSS (die geben sich nicht mehr viel).

- Mitglied seit

- Sep 17, 2019

- Beiträge

- 1.150

- Bewertungspunkte

- 1.567

- Punkte

- 115

- Alter

- 43

Das werde ich mir noch anschauen... Nvidia, AMD Treiber und SpecialKNe, zwei Limiter machen definitiv keinen Sinn und verschlechtern das Ergebnis nur.

Der In Game FL ist normalerweise, wenn er nicht kacke implementiert ist, jedem externen überlegen. Und der vom NVidia Treiber ist die zweitbeste Wahl, vor SpecialK und RTSS (die geben sich nicht mehr viel).

Eins verstehe ich nicht:

Ich habe eine 3080 und einen Freesync kompatiblen Monitor. Alles entsprechend eingestellt.

Wenn du jetzt im Treiber noch V-Sync einschaltest, dann ist das meines Wissens nach auch nur noch ein Frame Limiter, der ein paar frames unter die native Darstellungsrate geht.

Welches Vsync hat der Ersteller denn da jetzt gemeint? In Game? Dann definitiv aus. Aber im Treiber an weil siehe oben.

Selbst Nvidia erklärt es so im Treiber und es funktioniert auch exakt so. Und somit entsteht auch keine höhere Latenz (im Gegensatz zum ingame V Sync)

Ich habe eine 3080 und einen Freesync kompatiblen Monitor. Alles entsprechend eingestellt.

Wenn du jetzt im Treiber noch V-Sync einschaltest, dann ist das meines Wissens nach auch nur noch ein Frame Limiter, der ein paar frames unter die native Darstellungsrate geht.

Welches Vsync hat der Ersteller denn da jetzt gemeint? In Game? Dann definitiv aus. Aber im Treiber an weil siehe oben.

Selbst Nvidia erklärt es so im Treiber und es funktioniert auch exakt so. Und somit entsteht auch keine höhere Latenz (im Gegensatz zum ingame V Sync)

G

Gelöschtes Mitglied 5011

Guest

Ich hab auch seit Monaten GSync aus...

Teste aber heute gleich mal rum auch mit FPS-Limiter kurz unter meinem Monitor Limit. (144)

danke für den Bericht!

Teste aber heute gleich mal rum auch mit FPS-Limiter kurz unter meinem Monitor Limit. (144)

danke für den Bericht!

>Wer einen G-SYNC Monitor besitzt, der hat einen kleinen Vorteil gegenüber FreeSync bzw. G-SYNC Kompatiblen Geräten. Die variable Bildwiederholrate beginnt bereits ab 1 Hz. Somit 1:0 für Nvidia!

Bitte bitte dieses Gerücht gehört auch in das Reich der Fabeln.

Nvidia nent es statt LFC einfach FrameDoublin, die Technik ist schlicht und einfach 100% identisch.

Desweiteren hat Nvidia keine FreeSync unterstützung, Nvidia unterstützt (neben g-Sync) lediglich Adaptive-Sync.

Nvidias Adaptive-Sync Implementierung unterscheidet sich sicher von AMDs implementierung.

Bitte bitte dieses Gerücht gehört auch in das Reich der Fabeln.

Nvidia nent es statt LFC einfach FrameDoublin, die Technik ist schlicht und einfach 100% identisch.

Desweiteren hat Nvidia keine FreeSync unterstützung, Nvidia unterstützt (neben g-Sync) lediglich Adaptive-Sync.

Nvidias Adaptive-Sync Implementierung unterscheidet sich sicher von AMDs implementierung.

- Mitglied seit

- Sep 17, 2019

- Beiträge

- 1.150

- Bewertungspunkte

- 1.567

- Punkte

- 115

- Alter

- 43

Nein, in dem Fall unterscheidet sich die Implementierung nicht! FreeSync und adaptive Sync is das gleiche... die VRR Unterstützung ist bei AMD GPUs und Nvidia GPUs mit aktiviertem FreeSync oder G-SYNC kompatiblem Modus für Monitore mit FreeSync Premium die Gleiche!>Wer einen G-SYNC Monitor besitzt, der hat einen kleinen Vorteil gegenüber FreeSync bzw. G-SYNC Kompatiblen Geräten. Die variable Bildwiederholrate beginnt bereits ab 1 Hz. Somit 1:0 für Nvidia!

Bitte bitte dieses Gerücht gehört auch in das Reich der Fabeln.

Nvidia nent es statt LFC einfach FrameDoublin, die Technik ist schlicht und einfach 100% identisch.

Desweiteren hat Nvidia keine FreeSync unterstützung, Nvidia unterstützt (neben g-Sync) lediglich Adaptive-Sync.

Nvidias Adaptive-Sync Implementierung unterscheidet sich sicher von AMDs implementierung.

Das Nvidia eine art LFC nutzt, ist mir nicht bekannt... Wer ich aber schnellstmöglich in Erfahrung bringen! Sollte dem So sein, dann muss ich das natürlich anpassen!

Nein sie sind nicht gleich, alleine weil jeder Hersteller eine eigene Implementierung hat, können die Implementierungen nicht gleich sein.Nein, in dem Fall unterscheidet sich die Implementierung nicht! FreeSync und adaptive Sync is das gleiche... die VRR Unterstützung ist bei AMD GPUs und Nvidia GPUs mit aktiviertem FreeSync oder G-SYNC kompatiblem Modus für Monitore mit FreeSync Premium die Gleiche!

Das Nvidia eine art LFC nutzt, ist mir nicht bekannt... Wer ich aber schnellstmöglich in Erfahrung bringen! Sollte dem So sein, dann muss ich das natürlich anpassen!

Ungeachtet dessen bennent zB HDMI Adaptive-Sync einen min-max Bereich, macht aber keine angabe wie schnell ZWISCHEN den Werten umgeschaltet werden kann, zb ob unmittelbar von minHz auf maxHz (oder gar zurück) gewechselt werden kann. Freesync(AMD!) schreibt aber genau dies vor - dies muss du mur nun einfach glauben :O

- Mitglied seit

- Sep 17, 2019

- Beiträge

- 1.150

- Bewertungspunkte

- 1.567

- Punkte

- 115

- Alter

- 43

Nein sie sind nicht gleich, alleine weil jeder Hersteller eine eigene Implementierung hat, können die Implementierungen nicht gleich sein.

Ungeachtet dessen bennent zB HDMI Adaptive-Sync einen min-max Bereich, macht aber keine angabe wie schnell ZWISCHEN den Werten umgeschaltet werden kann, zb ob unmittelbar von minHz auf maxHz (oder gar zurück) gewechselt werden kann. Freesync(AMD!) schreibt aber genau dies vor - dies muss du mur nun einfach glauben :O

Auf der HP von Nvidia ist zum Beispiel mein LG 27GL850 beschrieben als G-Sync kompatibel und unterstützt die gleiche VRR wie unter Freesync... beides sind adaptive Sync Technologien!

Aus meiner Sicht macht das keinen Unterschied...

Ich würde gerne wissen, welches Vsync der Verfasser in seinen Tests eingeschaltet hat. Es ist halt wichtig für das Ergebnis.

Edit: hab es überlesen. Sorry. Ich Frage mich bloß ernsthaft: wieso nicht Vsync über den Treiber an? Das ist dann das einzige, was keine Latenz erzeugt. Natürlich ist Vsync ingame unbrauchbar wegen Latenz etc.

Also in dem Punkt finde ich den Test echt merkwürdig.

Edit: hab es überlesen. Sorry. Ich Frage mich bloß ernsthaft: wieso nicht Vsync über den Treiber an? Das ist dann das einzige, was keine Latenz erzeugt. Natürlich ist Vsync ingame unbrauchbar wegen Latenz etc.

Also in dem Punkt finde ich den Test echt merkwürdig.

Zuletzt bearbeitet

:

- Mitglied seit

- Sep 17, 2019

- Beiträge

- 1.150

- Bewertungspunkte

- 1.567

- Punkte

- 115

- Alter

- 43

Im Spiel... warum?Ich würde gerne wissen, welches Vsync der Verfasser in seinen Tests eingeschaltet hat. Es ist halt wichtig für das Ergebnis.

hab es überlesen. Sorry. Ich Frage mich bloß ernsthaft: wieso nicht Vsync über den Treiber an? Das ist dann das einzige, was keine Latenz erzeugt. Natürlich ist Vsync ingame unbrauchbar wegen Latenz etc.Im Spiel... warum?

Also in dem Punkt finde ich den Test echt merkwürdig, weil es hier eben um die Latenzproblematik geht.

Deine Sicht ist schlicht falsch.Auf der HP von Nvidia ist zum Beispiel mein LG 27GL850 beschrieben als G-Sync kompatibel und unterstützt die gleiche VRR wie unter Freesync... beides sind adaptive Sync Technologien!

Aus meiner Sicht macht das keinen Unterschied...

Nvidia unterstützt kein FreeSync.

- Mitglied seit

- Sep 17, 2019

- Beiträge

- 1.150

- Bewertungspunkte

- 1.567

- Punkte

- 115

- Alter

- 43

FreeSync und adaptive Sync ist das gleiche... wo soll der Unterschied sein?Deine Sicht ist schlicht falsch.

Nvidia unterstützt kein FreeSync.

- Mitglied seit

- Sep 17, 2019

- Beiträge

- 1.150

- Bewertungspunkte

- 1.567

- Punkte

- 115

- Alter

- 43

Wie im Artikel erklärt, war V-Sync früher standardmäßig mit G-Sync aktiv. Daher kommt die Behauptung, das G-Sync die Latenz verschlechtert. Es spielt schlicht keine Rolle, wo du V-Sync einschaltest. V-Sync ist eine Latenzbremse... 300 FPS werden künstlich auf zb 144 Hz gebracht... ergo: Latenz steigthab es überlesen. Sorry. Ich Frage mich bloß ernsthaft: wieso nicht Vsync über den Treiber an? Das ist dann das einzige, was keine Latenz erzeugt. Natürlich ist Vsync ingame unbrauchbar wegen Latenz etc.

Also in dem Punkt finde ich den Test echt merkwürdig, weil es hier eben um die Latenzproblematik geht.