Jakob Ginzburg

Urgestein

- Mitglied seit

- Jun 17, 2018

- Beiträge

- 843

- Bewertungspunkte

- 290

- Punkte

- 63

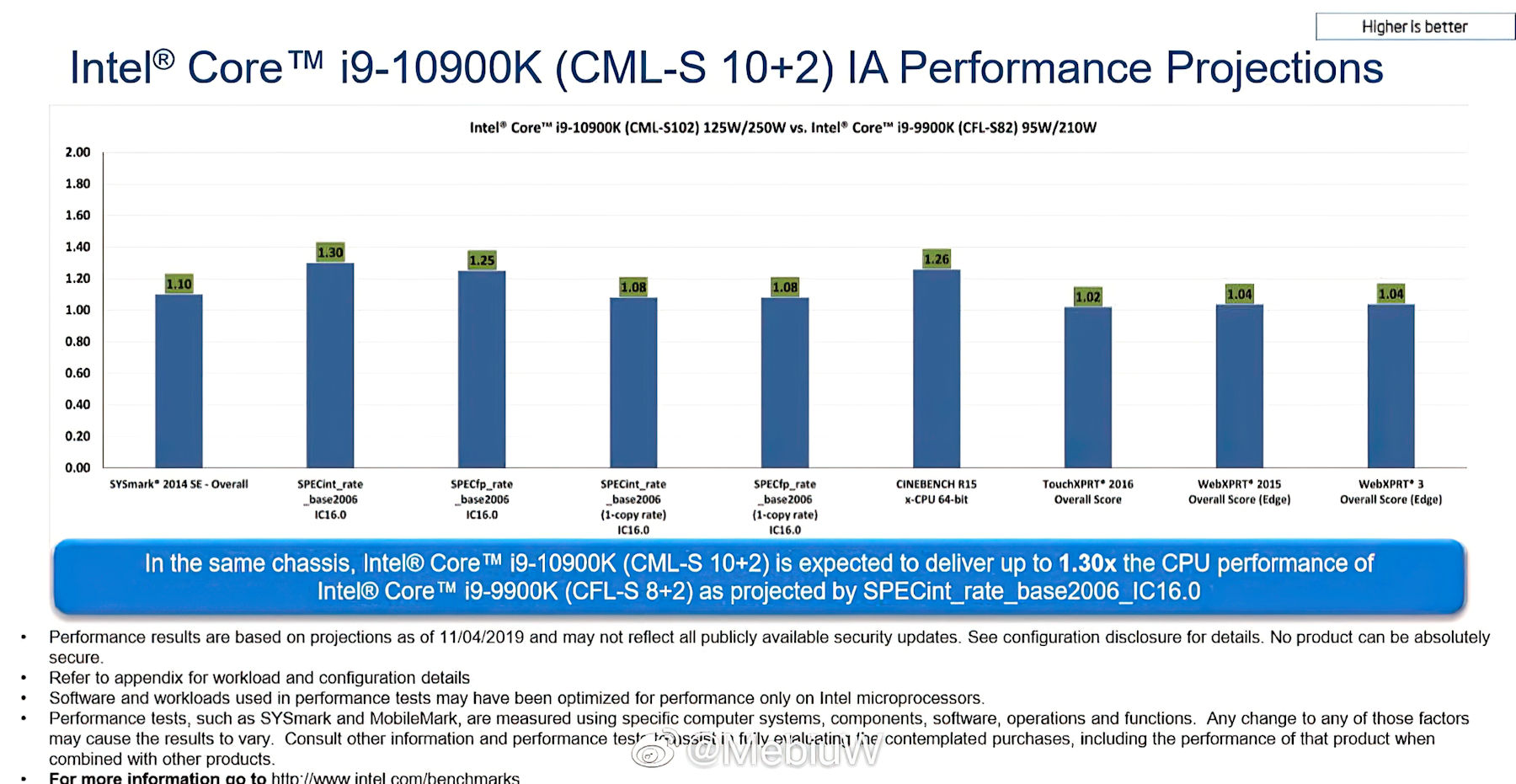

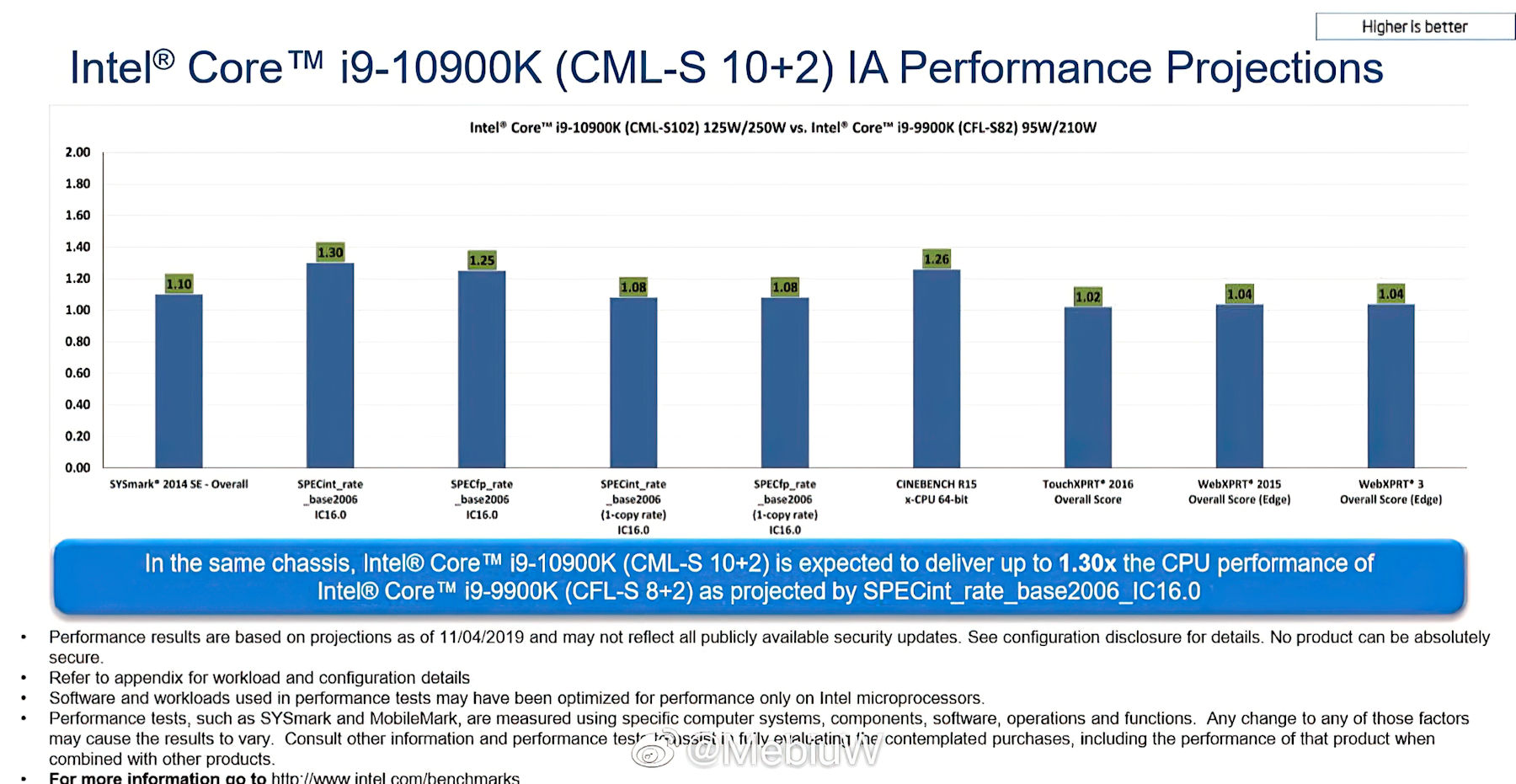

Die Kollegen von Tom‘s Hardware haben vorzeitig offizielle Leistungsdaten zum kommenden Flagship-Prozessor von Intel, dem Core i9-10900K, veröffentlicht. Die Speerspitze der 10. Gen „Comet Lake“-Produktlinie soll in den kommenden Monaten offiziell auf den Markt kommen und die gleiche 14nm-Architektur aufweisen, wie zuvor „Skylake“.

Erst letzte Woche gab es dank ungeplanter Veröffentlichungen in einigen asiatischen Medien weitreichende Informationen zu der 10. Core-Generation mit den Namen „Comet Lake“ aufgetaucht, darunter detaillierte Spezifikationen zu der Anzahl der Kerne sowie Leistungsaufnahme. Insgesamt sind 11 SKUs sind für die Markteinführung geplant. Die Core i9-10900K CPU wird dabei das Flagship von Intels sechster 14nm-Familie sein.

Zum Beitrag: https://www.igorslab.de/lediglich-e...t-bis-zu-30-bessere-multi-threading-leistung/

Erst letzte Woche gab es dank ungeplanter Veröffentlichungen in einigen asiatischen Medien weitreichende Informationen zu der 10. Core-Generation mit den Namen „Comet Lake“ aufgetaucht, darunter detaillierte Spezifikationen zu der Anzahl der Kerne sowie Leistungsaufnahme. Insgesamt sind 11 SKUs sind für die Markteinführung geplant. Die Core i9-10900K CPU wird dabei das Flagship von Intels sechster 14nm-Familie sein.

Zum Beitrag: https://www.igorslab.de/lediglich-e...t-bis-zu-30-bessere-multi-threading-leistung/