Poste doch deine Ergebnisse hier gerne.

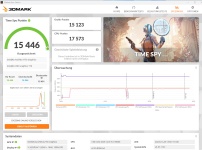

Ich habe einen 5900X verwendet mit 32GB Ram auf einer X570 Platine.

Eine IGP ist nicht vorhanden.

Wie anhand der Screenshots zu sehen ist , hab ich deutlich bessere Ergebnisse bis zu 7% und das ist nicht wenig.

(konnte leider nur 5 Bilder anhängen)

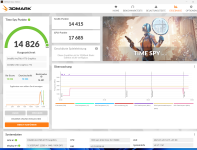

Hab das ganze nochmal in einem anderem System getestet das keine Intel IGPU mit XE Cores hat.

Hab die Tests wiederholt mit einem Intel I9 10900F auf einem Z490 Mainboard, dort kam ich ziemlich auf die selben Ergebnisse (+/-) wie bei deinem Testbericht.

Da bei diesen Tests sowohl dein System wie auch das I9 10900F System sicher nicht der Flaschenhals wahren für die Grafikleistung, währe ein weiterer Test mit einem Intel System der 12th oder der 13th Generation mit einem F oder KF CPU Intressant ( Ohne Intel IGPU mit XE Cores) und ein weiteres System mit einem Zen4.

Nur zum Schauen was passiert.

Vielleicht gibt es hier ja ein paar, die das machen könnten

währe sehr cool.

Für mich Persöndlich ist die ARC keine Gamerkarte, mein Intresse liegt vorallem bei Video Bearbeitung und hier muss man klar sagen, was die ARC in dieser Beziehung leistet ist aussergewöhnlich im vergleich zu Nvidia und AMD. Alle Sprechen von AV1 (AMD/Nvidia 8Bit , Intel 8Bit und 10Bit) aber es sagt niemand das die RTX 40XX oder Radeon 7XXX im Jahr 2023 immernoch nicht in der Lage sind HVEC (H265) bei 12Bit zu Encodieren und zu Decodieren. ( 8 und 10Bit können Sie bei annehmbarer Qualität)

Auf dem CPU zu Decodieren und Encodieren, macht wirklich keinen Spass.

Was für mich auch Sprach ist der Deep Link und Hyper Encoding, in der Verbindung einer Intel IGPU und der ARC. Was die Decoder und Encoder Leistung der ARC gegenüber einer RTX4090 deutlich übertrifft.

Zudem ist die ARC 770 nicht beschnitten und liefert bei 64Bit Berechnungen die 2.5 Fache Leistung einer RTX4090. ( Nicht das die GPU der RTX das nicht könnte, sondern NVIDIA möchte lieber eine Tesla Karte verkaufen und die hohle Hand machen)

Währe ich jetzt ein Gamer hätte ich ganz klar eine RTX4080 oder eine RTX4090 gekauft.