@Gurdi

Danke dir für den Test

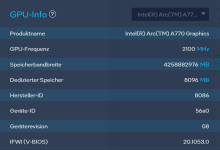

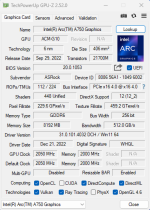

Für mich ist es unverständlich warum INTEL vor der Veröffentlichung der Arc GPU's so viel Werbung gemacht hat und jetzt wo die Grafikkarten im Handel und die Treiber weiter verbessert worden sind, von INTEL selbst nichts mehr kommt.

Dabei sichert sich die INTEL Arc GPU @16 GB VRAM jetzt schon den P/L Sieg ( incl. RT ) in Spielen.

Die Zeit muss INTEL jetzt intensiv nutzen und die Erfolge der Programmierer deutlich in die Welt kommunizieren.

Mehr Muster an bereitwillige Tester verteilen damit sie der Gemeinschaft die erreichten Fortschritte in der Praxis präsentieren können.

Danke dir für den Test

Für mich ist es unverständlich warum INTEL vor der Veröffentlichung der Arc GPU's so viel Werbung gemacht hat und jetzt wo die Grafikkarten im Handel und die Treiber weiter verbessert worden sind, von INTEL selbst nichts mehr kommt.

Dabei sichert sich die INTEL Arc GPU @16 GB VRAM jetzt schon den P/L Sieg ( incl. RT ) in Spielen.

Die Zeit muss INTEL jetzt intensiv nutzen und die Erfolge der Programmierer deutlich in die Welt kommunizieren.

Mehr Muster an bereitwillige Tester verteilen damit sie der Gemeinschaft die erreichten Fortschritte in der Praxis präsentieren können.