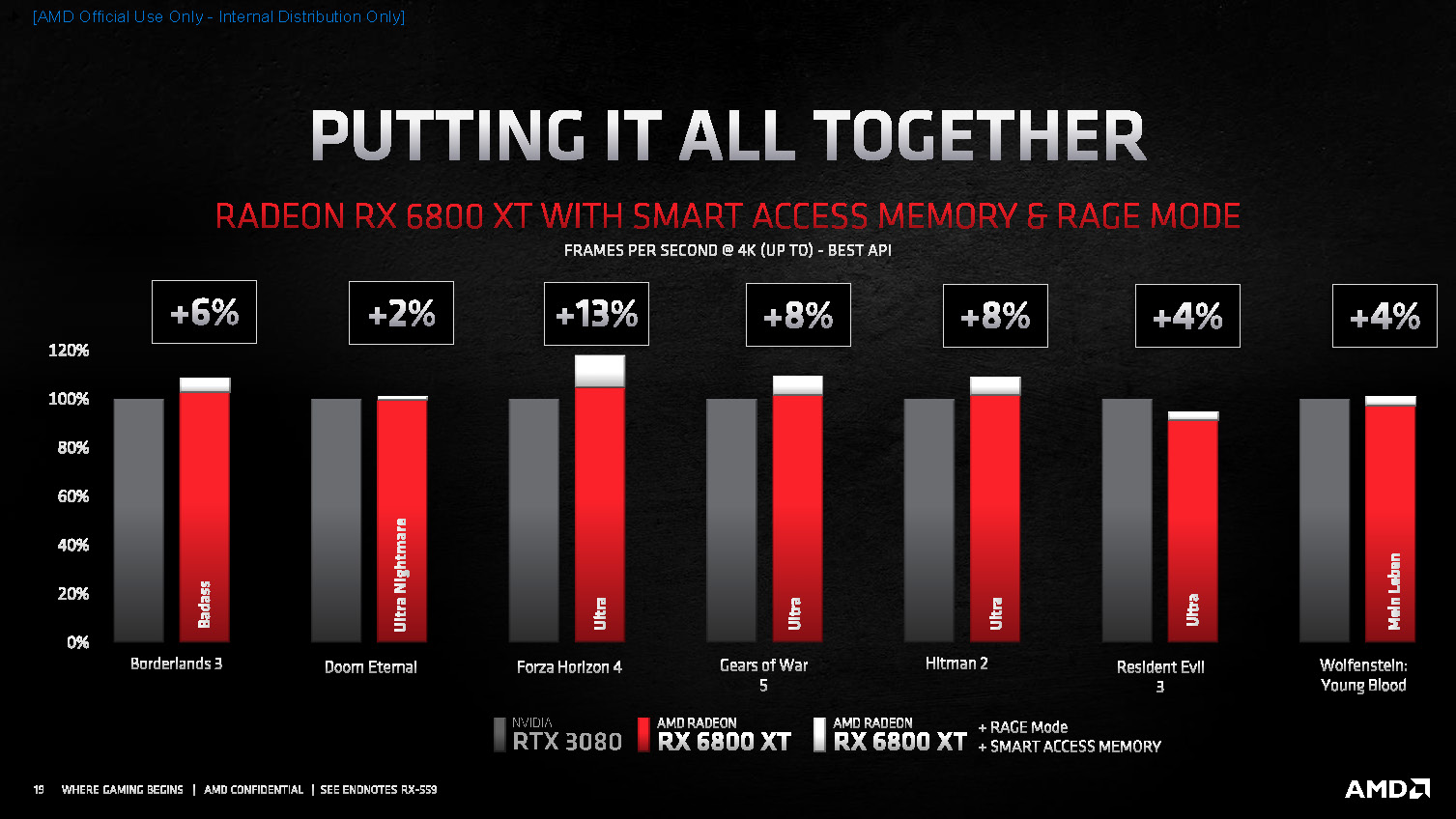

- RAGE Mode scheint nichts weiter als eine Fusion von dem heutigen "Overclock GPU" und "Overclock VRAM" - O.K.

- Beim Smart Access Memory schließe ich mich der Frage von

der8auer (bei der Folie zu AMD SAM) mal an, ob der VRAM auch als schnellen Arbeitsspeicher verwendet werden kann. Ansonsten von mir die Frage, ob das mit der Ladeverschnellerung der PS5 zutun hat. Juckt mich nicht weiter.

- 6800XT ist mal richtig nice!

- 6900XT vs. 3090 mit RAGE Mode und Smart Access Memory! Die 6900XT dürfte nochmals selektierter sein (pro OC/Güte). Aber da sehe ich die Kotzgrenze schon näher als bei der 6800XT. Prozentual also etwas geringeres OC als die 6800XT? 2-10% mehr als Stock dafür beim Verbrauch am Anschlag?

- FidelityFX wirkt auf mich "aufgewertet". Juckt mich aber genauso wenig wie DLSS (auch dank der Kreuzzüge der nvidiaischen Ultras

)

- RT wurde dezent angedeutet. Das was ich an RT sah, schien ebenso dezent im Einsatz (das mag ich lieber, als wenn jeder Pixel, ganz nach Internetmanier, die Marktschreierkunst veranstaltet).

- Laut Abspann liefen die Tests mit dem 5900X und im Zeitraum 18-21.10.2020. Wenn ich nichts übersah, dann war es immer die Version 20.45-201013N.

Der Performance-Treiber (+10%) kam doch erst am 22.10 oder? Das kann doch bestimmt jemand aufklären

...

Edit: Ooookay, nun hats bei mir Klick gemacht. AMD ist kein Boardpartner. Das wird der Performance-Treiber gewesen sein. Schade

Also ich glaube, ich werde mir dieses Jahr ein alten Traum erfüllen \o/