Jakob Ginzburg

Urgestein

- Mitglied seit

- Jun 17, 2018

- Beiträge

- 843

- Bewertungspunkte

- 290

- Punkte

- 63

Adaptive Sync - bei AMD als FreeSync und von Nvidia als G-Sync bekannt - ist eine Technik mit der die Ausgabequalität zum Teil erheblich verbessert werden kann. Das stellen die Hersteller durch die Darstellung eines jeden Datenframes sicher, das an den Monitor weitergeleitet wird, sobald ein solcher Datenframe vollständig berechnet wurde.

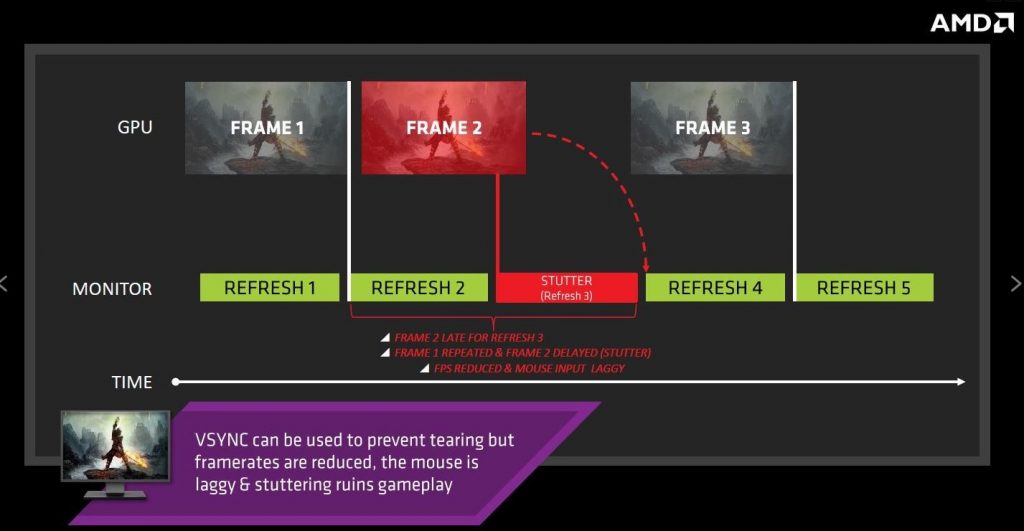

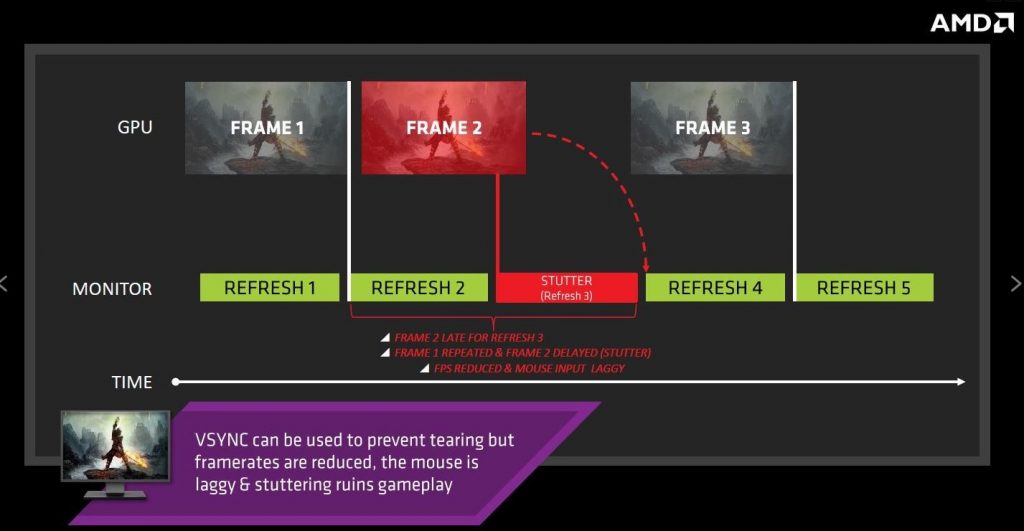

Ohne diesen Ansatz wird die Darstellung von Spielen entweder „zerreißen“ (wenn V-Sync deaktiviert ist) oder eine deutlich sichtbare Linie, die längs über dem Bildschirm verläuft, ist zu sehen. Auch Animationen stocken durch fehlende Frames oder schlicht duplizierte (weil nicht berechnet) Frames. Die mehrfache Darstellung bzw. der sich wiederholende Animationsverlaufen erzeugt einen sichtbaren Lags (Stottereffekte), da der Monitor auf das fertige Bild wartet, dieses aber nicht von der Grafikkarte bekommt. Unternehmen wie AMD und Nvidia haben, basierend auf offenen VESA-Standards, Lösungen entwickelt, die dieses Problem vermeiden...

>>> Den Originalbeitrag lesen <<<

Ohne diesen Ansatz wird die Darstellung von Spielen entweder „zerreißen“ (wenn V-Sync deaktiviert ist) oder eine deutlich sichtbare Linie, die längs über dem Bildschirm verläuft, ist zu sehen. Auch Animationen stocken durch fehlende Frames oder schlicht duplizierte (weil nicht berechnet) Frames. Die mehrfache Darstellung bzw. der sich wiederholende Animationsverlaufen erzeugt einen sichtbaren Lags (Stottereffekte), da der Monitor auf das fertige Bild wartet, dieses aber nicht von der Grafikkarte bekommt. Unternehmen wie AMD und Nvidia haben, basierend auf offenen VESA-Standards, Lösungen entwickelt, die dieses Problem vermeiden...

>>> Den Originalbeitrag lesen <<<